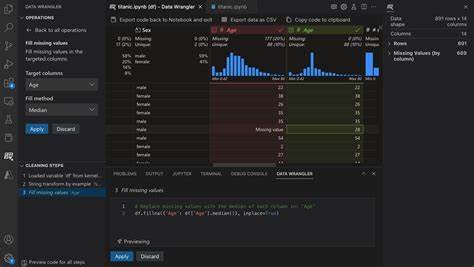

In der heutigen datengetriebenen Welt sind effiziente Werkzeuge für die Verarbeitung und Transformation von Daten unerlässlich. Besonders beim Aufbau und Debuggen von Datenpipelines gewinnen praktische und leicht handhabbare Tools zunehmend an Bedeutung, um die agile Entwicklung und schnelle Prototypen zu ermöglichen. Das Data Wrangler Plugin für VSCode hat sich in der Vergangenheit als eine hilfreiche Lösung erwiesen, die eine einfache und schnelle Inspektion sowie Prototypenentwicklung für Formate wie Parquet und CSV bietet. Dennoch suchen viele Nutzer nach Alternativen, die andere Bedürfnisse besser erfüllen oder bestimmte Herausforderungen leichter bewältigen. Die Herausforderung bei der Auswahl eines Werkzeuges zur Datenmanipulation liegt häufig in der Balance zwischen Benutzerfreundlichkeit, Leistungsfähigkeit und Integrationsfähigkeit.

Data Wrangler punktet durch seine intuitive Oberfläche und die tiefe Integration in Visual Studio Code, doch das Ökosystem ist breit und es gibt durchaus Werkzeuge, die in anderem Kontext oder bei speziellen Anforderungen besser funktionieren können. Ein oft genannter Kandidat in diesem Bereich ist Visidata. Dieses Tool ist als Open-Source-Anwendung bekannt und kann eine große Bandbreite an Datenformaten verarbeiten. Es besticht durch seine Geschwindigkeit und den Fokus auf Tastaturkürzel, was besonders Experten anzieht, die eine effiziente und schnelle Navigation in großen Datenbeständen benötigen. Dennoch bringt Visidata eine gewisse Lernkurve mit sich.

Insbesondere für Teams ohne terminalbasierte Arbeitsweise oder Programmierhintergrund ist der Einstieg manchmal schwierig. Darüber hinaus gestaltet sich die Übertragung der interaktiven Transformationen in den Python-Code oft als herausfordernd, sodass eine Automation von Datenprozessen nicht unmittelbar möglich ist. Neben Visidata existieren weiter zahlreiche weitere Tools, die sich als Alternativen anbieten und unterschiedliche Stärken mitbringen. Pandas, eine in der Python-Welt weit verbreitete Bibliothek zur Datenmanipulation, wird häufig als Basis für Datenpipelines verwendet. Sie bietet eine große Anzahl an Funktionen für Datenaufbereitung, Filterung, Aggregation und Transformation.

Durch ihre umfangreiche API lässt sich nahezu jede Datenmanipulation automatisieren. Allerdings erfordert der Einsatz von Pandas fundierte Programmierkenntnisse und oft auch eine gewisse Einarbeitungszeit, um effektive und performante Pipelines zu implementieren. Auch grafische Tools wie Trifacta gehören zu den ernstzunehmenden Konkurrenten im Bereich der Datenaufbereitung. Trifacta bietet eine visuelle Oberfläche, mit der Anwender Daten schnell und ohne tiefgehende Codekenntnisse explorieren und transformieren können. Die Verbindung von intuitiver Bedienung und leistungsstarken Funktionen macht es besonders für Nutzer attraktiv, die Wert auf Anwenderfreundlichkeit und Collaboration legen.

Jedoch ist Trifacta kostenpflichtig und häufig eher in größeren Unternehmen mit entsprechendem Budget etabliert. Ein weiteres Segment der Alternativen bilden spezialisierte ETL-Tools und Plattformen wie Apache NiFi, Talend oder Airbyte. Diese Lösungen sind darauf ausgelegt, Datenströme zwischen verschiedensten Systemen zu orchestrieren und Transformationsschritte effizient durchzuführen. Sie sind jedoch oft komplexer ausgerichtet und weniger als ad-hoc Transformationswerkzeuge geeignet. Für Entwickler, die hauptsächlich schnelle Inspektionen und Prototypen benötigen, sind diese Systeme meist zu umfangreich.

In der Open-Source-Szene tauchen immer wieder Tools auf, die besondere Ansätze verfolgen. Beispielsweise bietet DataPrep eine einfache API zur Vorverarbeitung von Daten mit Fokus auf Automatisierung und Sauberkeit. Es lässt sich gut in Python-Projekte einbinden und erleichtert den Umgang mit unstrukturierten oder fehlerhaften Eingabedaten. Für schnelle Tests und Ansichten großer Datensätze hingegen könnte DataPrep an seine Grenzen stoßen, wenn interaktive Exploration gewünscht wird. Die Auswahl des richtigen Werkzeugs ist stark von den individuellen Anforderungen und den Rahmenbedingungen des jeweiligen Projekts abhängig.

Wer einen niedrigschwelligen Einstieg sucht, praktische Transformationen schnell testen und unmittelbar in den Workflow integrieren möchte, findet in Data Wrangler und Visidata sinnvolle Optionen. Dabei ist auch der Kontext des Arbeitsumfelds zu beachten: Während Data Wrangler stark an die VSCode-Umgebung geknüpft ist, fungiert Visidata als eigenständige Anwendung, die auch unabhängig vom Editor genutzt werden kann. Darüber hinaus lohnt es sich, die eigene Arbeitsweise und Teamstruktur zu reflektieren. Ist die Zusammenarbeit eng verbunden mit datenwissenschaftlichen Experten, die Python-Code schreiben und anpassen? Dann wird man überall dort punkten, wo Transformationen klar als Programmlogik definiert und versioniert werden können. Sind jedoch die Dateningenieure oder Datenanalysten ohne Programmierkenntnisse Teil des Teams, ist eine visuelle Lösung mit Drag-and-Drop oder zumindest intuitiver GUI essenziell, wie etwa bei Trifacta oder teils auch mit Data Wrangler.

Nicht zu vernachlässigen ist zudem die Frage nach der Skalierbarkeit. Werkzeuge wie Data Wrangler und Visidata sind hervorragend für kleinere bis mittlere Datenmengen geeignet und optimal für Debugging-Sitzungen oder Prototypen. Bei Big-Data-Szenarien hingegen, wie sie etwa im Umfeld von großen Data Lakes oder Streaming-Daten vorkommen, rücken eher spezialisierte, oft cloudbasierte Plattformen in den Vordergrund, die neben der Datenmanipulation auch Architekturaspekte berücksichtigen. Ein weiterer Trend zeigt die Integration von KI-gestützten Tools, die bei der Datenaufbereitung unterstützen, indem sie etwa automatisch Datenbereinigungs- oder Transformationsvorschläge generieren. Der Markt für solche Lösungen wächst, und einige Plattformen integrieren bereits smarte Assistenzsysteme, um die Produktivität zu steigern und Fehlerquellen zu minimieren.

Für Anwender, die den Wechsel von einem Tool wie Data Wrangler erwägen, ist es ratsam, zunächst ihre typischen Arbeitsabläufe klar zu definieren. Welche Datenformate werden vorrangig genutzt? Wie stark sollen die Transformationen automatisiert werden? Wie wichtig ist die Integration in bestehende Entwicklungsumgebungen? Zudem sollte man mögliche Unterstützung für Teamzusammenarbeit, Versionierung und Nachvollziehbarkeit der Datenänderungen in den Entscheidungsprozess mit einbeziehen. Hinsichtlich der technologischen Entwicklung ist davon auszugehen, dass die Grenzen zwischen interaktiven Datenexplorationswerkzeugen und vollautomatischen ETL-Plattformen immer mehr verschwimmen werden. Anwender profitieren davon, wenn sie sich frühzeitig mit verschiedenen Tools befassen und diese nach ihren Anforderungen kombinieren können. Zusammenfassend können Data Wrangler und Visidata als Vertreter einer neuen Generation von Datenaufbereitungswerkzeugen betrachtet werden, die den Fokus auf Einfachheit, Geschwindigkeit und Integration in Entwickler-Tools legen.

Daneben existiert ein umfangreiches Ökosystem von Lösungen, das von reinen Programmierbibliotheken über visuelle Transformationsplattformen bis hin zu umfassenden Datenintegrationssystemen reicht. Die ideale Wahl hängt von individuellen Prioritäten ab und kann durch das Erkunden und Testen mehrerer Systeme am besten herausgefunden werden. So bleibt man flexibel und kann aktuelle Herausforderungen bei der Entwicklung von Datenpipelines effizient meistern.