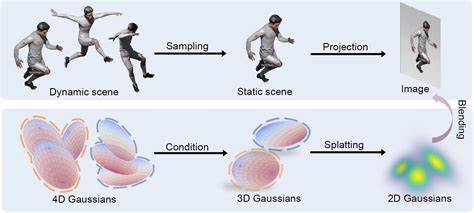

Twitter, jetzt offiziell bekannt als X, hat kürzlich eine neue Sicherheitsmaßnahme eingeführt, die vor allem darauf abzielt, Bots zu erkennen und deren Zugriff zu erschweren. Im Mittelpunkt steht dabei ein neuer HTTP-Header namens X-XP-Forwarded-For, dessen Werte mittels eines eigens entwickelten WebAssembly (WASM)-basierten Systems generiert und verschlüsselt werden. Dieses neuartige Sicherheitsfeature hat in der Technik-Community einiges an Interesse geweckt, insbesondere wegen seines innovativen technischen Ansatzes und der Frage, wie effektiv es wirklich gegen böswillige automatisierte Zugriffe ist. Der X-XP-Forwarded-For Header repräsentiert ein fortgeschrittenes Fingerprinting-System, das versucht, Nutzer auf Basis verschiedenster Datenpunkte im Browser und der Nutzerumgebung zu identifizieren. Die Werte werden im Browser mittels WebAssembly generiert, was eine performante und schwieriger manipulierbare Ausführung von Code erlaubt.

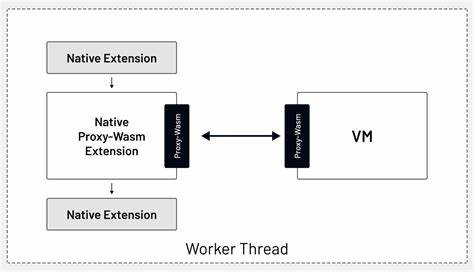

Dabei werden Informationen gesammelt, die über das übliche User-Agent-Fingerprinting hinausgehen. Twitter nutzt diesen Ansatz, um automatisierte Zugriffe, die klassische Bot-Detektionsmethoden umgehen wollen, zu erschweren. WebAssembly ist eine moderne Technologie, die es ermöglicht, Code in einer nativen Geschwindigkeit innerhalb des Browsers auszuführen. Im Gegensatz zu reinem JavaScript ist der WASM-Code kompiliert und bietet eine höhere Ausführungsgeschwindigkeit und eine komplexere Struktur, was Reverse Engineering deutlich erschwert. Twitter wählt diesen Weg offenbar bewusst, um das Generieren des Headers sicherer und manipulationsresistenter zu machen.

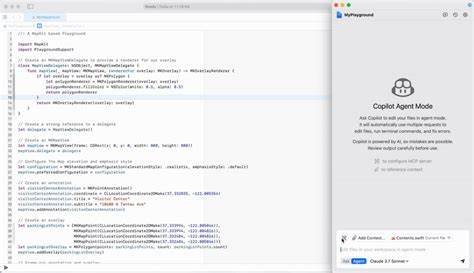

Während traditionelle Bot-Detektionsmethoden oft auf JavaScript basieren und vergleichsweise leicht zu analysieren und zu umgehen sind, bietet die Verwendung von WASM eine neue Schutzschicht. Zumal der Code nicht nur die Fingerabdruckdaten erzeugt, sondern diese auch verschlüsselt und in einem eigens entworfenen Format im Header mitsendet. Diese Maßnahmen sollen verhindern, dass automatisierte Systeme ohne diese spezifische Datenvalidierung auf Twitter zugreifen können. Interessanterweise hat die Community den Header bereits genau unter die Lupe genommen und erste Reverse Engineering Versuche gestartet. Die Analyse der Implementierung zeigt, dass die derzeitige Verschlüsselung und Generierung des Headers eher als eine Form von Obfuskation zu sehen ist.

Das bedeutet, dass die Sicherheitsmaßnahmen aktuell noch nicht so stark sind, wie man annehmen könnte – technisch versierte Nutzer können durch das Verständnis des Gast-IDs und ihrer Rolle im Prozess relativ leicht den Header nachvollziehen. Dies wirft Fragen zur langfristigen Effektivität des Systems auf. Einerseits macht Twitter es durch die komplexe Struktur des WASM-Codes und die Verschlüsselung schwieriger, automatisierte Tools zu entwickeln, die das System imitieren. Andererseits ist die derzeitige Ausführung offenbar noch nicht komplex genug, um fähige Angreifer dauerhaft fernzuhalten oder eine zuverlässige Bot-Erkennung zu gewährleisten. Ein weiterer Aspekt, der für eine mögliche Weiterentwicklung spricht, ist die Integration von Backend-basierten Analysen.

Der aktuell generierte Header könnte zwar noch recht simpel sein, aber zusammen mit einer KI-gestützten Verarbeitung der Fingerprints im Backend lässt sich das Verhalten von Nutzern und deren Geräteprofilen besser auswerten. Ein solches System könnte dann Muster erkennen, die auf automatisierte Angriffe hinweisen, und so gezielter reagieren. Die Idee, einen solchen Header mit WebAssembly zu implementieren, ist in der Branche bisher einzigartig und verdeutlicht, wie groß Twitters Interesse daran ist, das Bot-Problem auf neuartige Weise anzugehen. Die Herausforderung besteht darin, die Balance zwischen Sicherheit und Leistungsfähigkeit zu finden, ohne legitime Nutzer unnötig zu behindern. Aus Sicht der Entwickler und Sicherheitsforscher bietet der X-XP-Forwarded-For Header eine spannende Möglichkeit, neue Schutzmechanismen zu erforschen und künftig noch ausgefeiltere Methoden zu entwickeln.

Das, was bisher als einfache Obfuskation begonnen hat, könnte mit zusätzlichen Mechanismen und KI-Analysetechniken zu einem robusten Werkzeug im Anti-Bot-Arsenal werden. Doch der Erfolg hängt stark von der Bereitschaft ab, den Header und die zugrunde liegenden Technologien kontinuierlich zu verbessern. Bot-Entwickler passen sich schnell an neue Schutzmechanismen an, und daher ist ein rein statischer Mechanismus kaum ausreichend. Flexible und adaptive Systeme, die auf Datenanalyse und maschinelles Lernen setzen, werden in Kombination mit dem WASM-basierten Fingerprinting zukünftig entscheidend sein. Gleichzeitig zeigt die aktive Auseinandersetzung der Online-Community mit der Implementierung auch die Wichtigkeit der Transparenz.