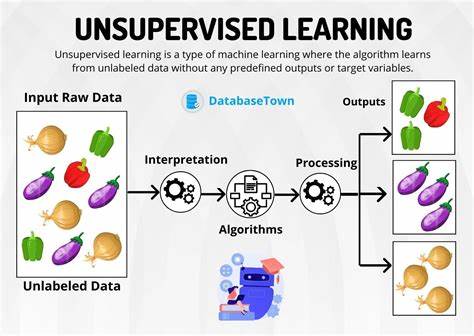

Initialwertprobleme spielen in der Physik eine zentrale Rolle, da sie das Verhalten von Systemen beschreiben, die durch Differentialgleichungen und Anfangsbedingungen definiert werden. Vom freien Teilchen bis hin zu komplexen Mehrkörpersystemen sind diese Probleme oft schwierig analytisch zu lösen, insbesondere wenn sie nichtlineare, gekoppelte oder chaotische Dynamiken beinhalten. Klassische numerische Verfahren stoßen dabei schnell an ihre Grenzen, wenn es darum geht, Effizienz, Genauigkeit und physikalische Konsistenz zu gewährleisten. Hier setzt eine innovative Methode an: die Nutzung von unüberwachtem maschinellem Lernen zur Lösung solcher Anfangswertprobleme, insbesondere durch den Einsatz tiefer neuronaler Netzwerke. Diese Methode verspricht nicht nur eine hohe Flexibilität im Modellieren verschiedenster mechanischer Systeme, sondern bringt auch erhebliche Fortschritte in der Beibehaltung physikalischer Erhaltungssätze wie der Energieerhaltung oder der stationären Wirkung mit sich.

Durch diese Eigenschaften eröffnet das unüberwachte maschinelle Lernen neue Türen in der numerischen Physik und im Engineering, besonders bei der Simulation komplexer dynamischer Systeme, wie beispielsweise dem klassischen Pendel oder dem Hénon-Heiles-System, das aus der Himmelsmechanik stammt und als Modell für gekoppelte harmonische Oszillatoren mit nichtlinearen Störungen dient. Das Potenzial dieser Methode besteht darin, die Grenzen traditioneller Lösungsansätze bei Anfangswertproblemen zu überwinden und den Forscherinnen und Forschern ein leistungsfähiges Werkzeug an die Hand zu geben, das sowohl durch seine Adaptivität als auch durch seine Fähigkeit überzeugt, physikalische Gesetzmäßigkeiten intrinsisch zu respektieren. Die entwickelten tiefen neuronalen Netzwerke sind in der Lage, das zeitliche Verhalten von Systemen durch das Lernen ihrer Dynamik präzise nachzubilden, ohne auf explizite Überwachungsdaten zurückgreifen zu müssen. Stattdessen erfolgt das Training auf Basis der zugrunde liegenden physikalischen Gesetze und Differentialgleichungen, was als unüberwachtes Lernen verstanden wird. Die Integration probabilistischer Aktivierungsfunktionen stellt in diesem Zusammenhang einen entscheidenden Fortschritt dar.

Sie sind notwendig, um exakte Lösungen der Anfangswertprobleme im strengsten Sinne zu erlernen und erhöhen die Modellierungsfähigkeit der Netzwerke erheblich. Ebenso wurde die Einführung gekoppelte neuronaler Netzwerke für gekoppelte Systeme präsentiert, die die Komplexität solcher Systeme naturgetreu abbilden können. Diese technische Innovation ermöglicht es, auch stark vernetzte und interagierende Systemkomponenten konsistent zu erfassen und deren gemeinsame zeitliche Entwicklung präzise vorherzusagen. Die Anwendungen des Ansatzes demonstrieren eindrucksvoll dessen Vielseitigkeit. Angefangen beim einfachsten Beispiel eines freien Teilchens und der Bewegung in einem Gravitationsfeld werden zunehmend komplexere Systeme behandelt.

Das klassische Pendel offenbart nichtlineare Dynamiken, während das Hénon-Heiles-System die Herausforderungen gekoppelte und chaotische Systeme illustriert. In allen Fällen erzeugen die tiefen neuronalen Netzwerke Trajektorien, die nicht nur numerisch stabil und physikalisch sinnvoll sind, sondern auch physikalische Größen wie die Gesamtenergie über lange Zeiträume konservieren. Dies ist eine bedeutende Leistung, da klassische numerische Solver oft Energieverluste oder -gewinne über die Simulation hinweg zeigen, was zu unphysikalischen Ergebnissen führt. Die Verbindung von maschinellem Lernen und Physik stellt auch eine neue Sicht auf die Art und Weise dar, wie Modelle trainiert und eingesetzt werden. Anders als herkömmliche überwachte Lernansätze, die häufig umfangreiche Datensätze voraussetzen, wird hier auf die Kenntnis der Differentialgleichungen selbst gesetzt, was den Weg für Anwendungen eröffnet, bei denen Messdaten knapp oder schwer zugänglich sind.

Dieses Vorgehen entspricht dem Konzept der physik-informierten neuronalen Netze, die physikalisches Wissen in den Lernprozess einfließen lassen und dadurch robustere sowie interpretierbare Modelle erzeugen. Darüber hinaus spiegelt diese Entwicklung den Fortschritt in der künstlichen Intelligenz wider, die immer stärker in naturwissenschaftliche Disziplinen integriert wird. Die Kombination aus mathematischem Fachwissen, numerischer Simulation und modernen Lernalgorithmen schafft interdisziplinäre Forschungsfelder, die innovative Technologien für Simulation, Vorhersage und Steuerung von dynamischen Systemen hervorbringen. Praktisch betrachtet könnten die Erkenntnisse und Methoden zur Bewältigung von Anfangswertproblemen mit unüberwachtem maschinellen Lernen weitreichende Auswirkungen in Bereichen wie der Raumfahrt, Robotik, Materialforschung oder sogar Biomechanik haben, wo präzise zeitabhängige Simulationen von physikalischen Prozessen essenziell sind. Ebenfalls wird der Ansatz die Entwicklung von Algorithmen beeinflussen, die künftig effizienter, genauer und physikalisch konsistenter arbeiten.

Die theoretischen Grundlagen, die diesen Fortschritt stützen, basieren auf bewährten mathematischen Prinzipien wie der Universal Approximation Theorem für neuronale Netze, die bestätigt, dass tiefe Netzwerke prinzipiell jede Funktion annähern können. Allerdings ist die besondere Herausforderung, optimale Gewichte und Architekturen zu finden, meisterte das vorgestellte Framework durch den Einsatz moderner Optimierungsmethoden und die Berücksichtigung physikalischer Restriktionen direkt im Lernprozess. Automatische Differenzierungstechniken wurden verwendet, um Gradienten effizient zu berechnen und das Training zu beschleunigen. Ebenso tragen Ensemble-Methoden und regulierende Aktivierungsfunktionen dazu bei, Überanpassung zu vermeiden und die Generalisierungsfähigkeit der Modelle zu erhöhen. Insgesamt stellt die Lösung physikbasierter Anfangswertprobleme mit unüberwachtem maschinellen Lernen einen bedeutenden Fortschritt dar, der tiefgreifende Veränderungen im Umgang mit komplexen dynamischen Systemen bewirken kann.

Die Fähigkeit, physikalische Gesetze direkt in tiefe Lernmodelle zu integrieren, eröffnet nicht nur neue Forschungsmöglichkeiten, sondern bietet auch praktische Werkzeuge für Wissenschaft und Technik, die hochpräzise und robuste Vorhersagen erfordern. Die Kombination aus Flexibilität, Genauigkeit und physikalischer Konsistenz macht diese Methode zu einem vielversprechenden Standardansatz in der numerischen Physik der Zukunft.