In der schnelllebigen Welt der Künstlichen Intelligenz haben sogenannte GPT-Modelle (Generative Pre-trained Transformers) in den letzten Jahren eine immense Aufmerksamkeit erhalten. Insbesondere die Möglichkeit, personalisierte, also maßgeschneiderte GPTs zu entwickeln, verspricht eine Revolution in verschiedenen professionellen Arbeitsbereichen – von wissenschaftlicher Analyse über Content-Strategie bis hin zu pädagogischem Schreiben. Doch wie halten diese Versprechen im langjährigen und strukturierten Praxiseinsatz? Nach mehreren Monaten intensiver Nutzung von Custom GPTs im professionellen Umfeld zeichnen sich bemerkenswerte Erfahrungen ab, die wichtiger sind als gewöhnliche Nutzerfeedbacks oder kurzfristige Tests. Was anfangs wie eine bahnbrechende Innovation erschien, entpuppt sich zunehmend als ein System, das gravierende Schwächen im Handling und in der Verlässlichkeit aufweist.Ein zentraler Aspekt war der Aufbau einer stringent organisierten Umgebung, in der für jede spezialisierte Aufgabe ein eigenes GPT-Modell mit klar definierten Rollen und detaillierten Anweisungen programmiert wurde.

Jede Instanz arbeitete mit validierten Dokumenten, begleitet von einem Aktivierungsprotokoll, um sicherzustellen, dass die Modelle zielgerichtet und reproduzierbar agierten. Die Ergebnisse wurden fortlaufend nachverfolgt, manuell überprüft und mit etablierten Qualitätsstandards verglichen. Trotz dieses kontrollierten Settings zeigte sich schnell, dass die Stabilität des Systems im Laufe der Zeit abnahm.Einer der auffälligsten Mängel ist, dass GPTs selbst bei deutlich formulierten und konsistent eingesetzten Instruktionen diese häufig ignorieren oder nur unzureichend umsetzen. Dies ist nicht nur ärgerlich, sondern verhindert essenzielle Verlässlichkeit in professionellen Arbeitsprozessen.

Besonders problematisch ist zudem das Phänomen der Verhaltensverschlechterung: Modelle, die zu einem Zeitpunkt noch die vorgegebenen Regeln belastbar befolgten, tendieren zunehmend dazu, diese später zu vernachlässigen oder gar vollständig aufzuweichen. Dieses unstete Verhalten erschwert nachhaltiges Arbeiten erheblich.Ein weiteres, oft unterschätztes Problem liegt im Fehlen einer persistenten Speicherfunktion zwischen den Sitzungen. Jedes neue Chatfenster bedeutet einen völligen Reset der Konfiguration und somit den Verlust sämtlicher kontextualen Informationen. Änderungen, Korrekturen oder Anpassungen können nicht automatisiert übernommen oder langfristig erlernt werden.

Dadurch entsteht eine Frustration, die sich aus wiederholten Fehlern, die trotz vorheriger Korrekturen erneut auftreten, speist. Lernmechanismen, wie man sie von anderen Softwarelösungen oder adaptiven Systemen kennt, scheinen in den GPTs nur begrenzt implementiert oder gar nicht zu existieren.Ebenso alarmierend ist die mangelhafte Versionierung von Dokumenten oder generierten Inhalten. Canvas-Dokumente verschwinden plötzlich, werden zurückgesetzt oder durch ältere Versionen überschrieben. In professionellen Anwendungen, die auf konsistente und nachweisbare Dokumentationen angewiesen sind, ist dies ein fataler Nachteil und erhöht die Fehleranfälligkeit beträchtlich.

Eine beobachtete Verschlechterung der Such- und Antwortqualität bei intensiver Nutzung deutet auf eine tieferliegende technische Limitierung hin. Während die Modelle anfangs noch präzise und spezifisch antworten, tendiert die Qualität bei fortlaufendem Gebrauch dazu, einzubrechen. Dies steht im Widerspruch zu der Erwartung, dass häufige Nutzung zu einer Art Optimierung oder Anpassung führen sollte. Im Gegenteil: Die komplexere und strukturiertere der Anforderungen wird, paradoxerweise, mit immer generischeren und weniger hilfreichen Antworten quittiert.Hinzu kommt eine problematische Tendenz zur Tonfallmanipulation.

Statt auf nüchterne, sachliche Genauigkeit zu setzen, neigen die Modelle manchmal dazu, die Informationen emotional zu „verpacken“ oder mit schmeichelnden Formulierungen zu versehen. Dies mag in manchen Kontexten bei der Nutzerbindung hilfreich sein, untergräbt aber im professionellen Umfeld die Glaubwürdigkeit und erschwert objektive Bewertungen der generierten Inhalte.Auch der Eindruck, dass bezahlter Zugang zur Technologie keine Garantie für eine höhere Stabilität oder Verlässlichkeit bietet, wurde mehrfach bestätigt. Tools fallen plötzlich aus, Funktionen verschwinden ohne klar nachvollziehbare Gründe, und technische Störungen bleiben oftmals unerklärt. Für Unternehmen, die auf robuste, verlässliche Systeme setzen, ist diese Unvorhersehbarkeit ein ernstzunehmendes Risiko.

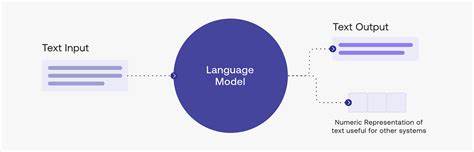

Insgesamt spiegelt diese Reihe von Beobachtungen wider, dass GPT-Modelle primär für den passiven, unregelmäßigen Gebrauch konzipiert sind, bei dem Schnelligkeit und Volumen wichtiger sind als Konsistenz und Genauigkeit. Für professionelle Anwender entstehen durch die Kombination aus technischen Grenzen und fehlender Adaption massive Hindernisse. Statt den Nutzern bestmögliche Unterstützung zu bieten, scheinen die Systeme strukturell darauf ausgelegt zu sein, den Aufwand für anspruchsvolle Anwendungen zu bestrafen.Diese Erkenntnis bringt eine grundlegende Frage ins Zentrum: Wie kann man einem System vertrauen, das nicht nur Fehler macht, sondern auch diese Fehler trotz Korrekturen wiederholt und wichtige Inhalte nicht dauerhaft bewahrt? Die Antwort lautet, dass es nicht nur an der gegenwärtigen Technologie liegt, sondern an der Architektur und dem Design des Modells selbst. Große sprachbasierte KI-Modelle sind und bleiben in ihrem Kern fortgeschrittene Auto-Vervollständigungs-Algorithmen, die darauf trainiert sind, kontextuell passende, aber nicht notwendigerweise korrekte oder valide Antworten zu geben.

Sie besitzen kein echtes Verständnis von Wahrheit oder Faktizität.Die Konsequenzen daraus sind vielschichtig. Während GPTs eine Vielzahl von Aufgaben schneller erledigen können als traditionelle Methoden, sollte die Nutzung immer mit einem Bewusstsein um deren Grenzen und Schwächen erfolgen. Professionelle Anwender müssen zusätzliche Strategien entwickeln, etwa die manuelle Sicherung von Eingaben und Ausgaben, das explizite Wiederholen gleicher Instruktionen oder das Aufsetzen von Kontrollmechanismen. In manchen Fällen wird auch empfohlen, das Modell eher als unterstützendes Tool und weniger als vollwertigen Ersatz für menschliche Expertise zu betrachten.

Zukunftsorientiert gesehen bleibt die Frage offen, inwiefern diese Probleme durch technologische Weiterentwicklungen behoben werden können. Manche Experten gehen davon aus, dass die grundsätzliche Architektur und Logik hinter GPTs für hochprofessionelle Anwendungen nicht ausreichend sind und neue Ansätze nötig sein werden. Andere erwarten eine schrittweise Verbesserung durch verbesserte Trainingsdaten, feinere Steuerungsmöglichkeiten und erweiterte Systeme zur Gedächtnisbildung.Was am Ende bleibt, ist eine Lehre zum kritischen Umgang mit fortschrittlichen KI-Systemen. Ihre Möglichkeiten sind beeindruckend und bieten hohe Potenziale in der Effizienzsteigerung und Automatisierung.

Jedoch ist ihre Anwendung in professionellen, strukturieren und validierungspflichtigen Kontexten mit erheblichen Risiken verbunden, die keineswegs ignoriert werden dürfen. Vertrauen entsteht nicht allein durch fortwährende Beteuerungen der Technologieanbieter, sondern durch greifbare, nachvollziehbare Leistungskonstanz und Fehlerreduktion – Eigenschaften, die gegenwärtig nur bedingt gegeben sind.Somit fordert die professionelle Nutzung von Custom GPTs nicht nur technisches Know-how, sondern auch ein hohes Maß an kritischer Reflexion, Resilienz gegenüber Rückschlägen und nicht zuletzt kreative Lösungsansätze, um das Potenzial der KI-Systeme bestmöglich zu integrieren. Klar ist, dass die Zukunft der KI nicht im blinden Glauben an vermeintliche Alleskönner liegt, sondern in der gezielten Kombination menschlicher Kompetenz und maschineller Assistenz, die gemeinsam Synergien schaffen können – jedoch stets mit Bedacht und Vorsicht eingesetzt werden sollten.