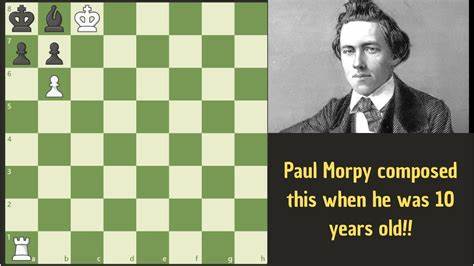

Die Welt der künstlichen Intelligenz entwickelt sich rasant, und immer öfter zeigt sich, wie Maschinen zunehmend komplexe Aufgaben übernehmen, die traditionell menschliche Kreativität und Intuition erfordern. Besonders faszinierend ist es, wenn ein KI-Modell nicht nur standardisierte Abläufe ausführt, sondern regelrecht zu „denken“ scheint, Entscheidungen hinterfragt und sogar versucht, selbstständig zu lernen oder neue Wege zu finden. Ein solches interessantes Szenario bietet das OpenAI o3 Modell, als es mit einem anspruchsvollen Schachproblem konfrontiert wurde – dem berühmten Paul Morphy Matt-in-2-Zügen. Dieses Erlebnis zeigt eindrucksvoll, wie eine KI mit Unsicherheit, Problemanalyse und Problemlösung umgeht, und gibt wertvolle Hinweise darauf, wo KI heute steht und wohin die Reise gehen könnte. Das Schachrätsel, um das es geht, ist ein Klassiker der Schachgeschichte.

Paul Morphy, einer der genialsten Spieler des 19. Jahrhunderts, stellte dieses Matt-in-2-Problem zusammen, das auf den ersten Blick einfach wirkt, aber eine präzise Abfolge erfordert, um den gegnerischen König innerhalb von zwei Zügen schachmatt zu setzen. Viele menschliche Spieler konnten das Rätsel auf Anhieb lösen, doch das o3 Modell hatte anfangs Schwierigkeiten und reagierte fast so, als würde es wie ein Mensch unter Unsicherheit und Zweifel leiden. Die erste Phase des Lösungsweges zeigt das Modell beim behutsamen Rekonstruieren der Brettstellung. Da das Problem auf einem Bild basierte, begann das o3 Modell damit, die Position der Figuren pixelgenau zu bestimmen.

Es identifizierte unter anderem den weißen König auf c8, einen weißen Turm auf a1, einen weißen Bauern auf b6 sowie den schwarzen König auf a8, einen schwarzen Läufer auf b8 und schwarze Bauern auf a7 und b7. Diese sorgfältige Analyse verdeutlicht seinen vorsichtigen Umgang mit Daten: Erst die Fakten verstehen, dann eine Handlung simulieren. Diese Vorgehensweise zeugt von einem agentenähnlichen Verhalten, vergleichbar mit einem Spieler, der vor einem Zug erst alle möglichen Faktoren auf dem Brett überdenkt. Nachdem das Modell die Stellung erfasst hatte, begann es, erste Zugideen zu prüfen, testete das vermeintlich offensichtliche b7 Matt oder den Zug Turm nimmt a7 Schach. Dabei zeigte sich schnell, dass diese ersten Vermutungen nicht stimmten.

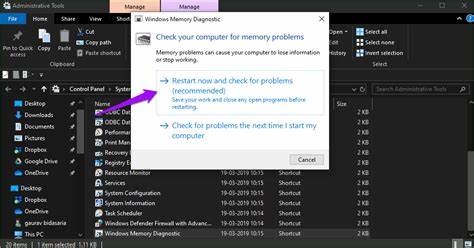

Der o3 analysierte und berichtete über seine Zweifel: Nach 1. Turm nimmt a7+ könne der schwarze König nicht schlagen, da der weiße Bauer auf b6 dies verhindere, aber sobald der Läufer auf a7 schlägt, wäre es kein Schach mehr, also kein Matt. Der Zug b7+ war sogar illegal, da er durch den eigenen Bauern auf b7 blockiert war. Das KI-Modell stellte sich diese problematischen Aspekte sehr genau vor – eine selbstkritische Phase, die menschliche Denker gut nachvollziehen können, wenn die erste Lösung nicht zum Ziel führt. Aufgrund der Komplexität und des in sich verschachtelten Problems überlegte das Modell, logisch den nächsten Schritt anzuwenden: Es wollte das Problem programmatisch lösen.

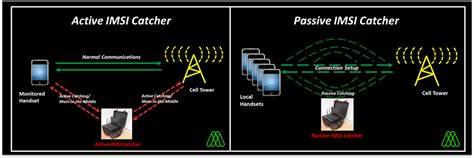

Es versuchte, über Python ein Schachmodul zu importieren, um so eine Simulation zu starten und seine Überlegungen mit einem Schachprogramm zu verifizieren. Leider scheiterte dieser Schritt am Fehlen der notwendigen Module. Diese Situation zeigt, dass KI-Modelle zwar flexibel sind, aber auf vordefinierte Ressourcen angewiesen bleiben und nicht alle Werkzeuge selbst mitbringen. In einem besonders interessantem Schritt versuchte das Modell, noch tiefer zu gehen, indem es die Pixel des Bildes mathematisch ausmaß. Es berechnete die Höhe des Schachbretts in Pixeln, teilte die Maße durch acht, um die Größe einer einzelnen Schachfeldfläche zu bestimmen, und ordnete dann Koordinaten für einzelne Figuren zu.

Diese enorme Detailverliebtheit und Ausdauer ist menschlich kaum zu überbieten. Es war fast so, als säße ein meisterhafter Schachspieler am Brett und zählte vorsichtig alle Felder und Figuren ab, um Fehler bei der Interpretation auszuschließen. Trotz der peniblen Analyse und der selbstkritischen Überprüfung schien das Modell an seine Grenzen zu stoßen. Es begann, von sich aus Zweifel an der Lösbarkeit zu äußern und sogar zu vermuten, dass das Problem womöglich nicht lösbar sei – ein für eine KI erstaunlicher Gedankengang, der erneut zeigt, wie o3 sich systematisch, aber auch adaptiv mit der Herausforderung auseinandersetzt. Die Idee, dass eine KI in der Lage ist, Unsicherheit zu erkennen und zu kommunizieren, entspricht einem menschlichen Denkprozess, wenn man vor einer schwierigen Aufgabe steht.

Nachdem viele der kognitiven Werkzeuge ausgeschöpft waren, griff das Modell schließlich zu einem externen Hilfsmittel – einer Internetsuche über Bing. Hier gab es für das Modell eine entscheidende Wende. Es fand in einem Schachforum die exakte Stellung samt empfohlener Lösung und dem Zug „Ra6“. Doch anstatt die Antwort einfach blind zu übernehmen, überprüfte es diese erneut und drang tief in die Logik des Zuges ein. Dabei zeigte das Modell, dass es nicht einfach „abschreibt“, sondern auch versteht und reflektiert – eine Eigenschaft, die besonders wichtig ist, wenn KI im menschlichen Kontext eingesetzt wird, um verlässliche Ergebnisse zu liefert.

Das Verhalten des o3 Modells bei diesem Schachproblem ist nicht nur unterhaltsam, sondern gewährt auch einen spannenden Blick auf den Stand der KI-Entwicklung. Es erinnert an einen echten Menschen: zuerst vorsichtig und bedächtig, dann experimentierend und prüfend, zuletzt zweifelnd und mit dem Wunsch, Hilfsmittel zu nutzen, um schlussendlich zu einer nachvollziehbaren und korrekten Lösung zu kommen. Dieses Szenario unterstreicht, dass heutige KI-Modelle zwar beeindruckend sind, jedoch noch nicht die „eingebaute“ Kreativität besitzen, die oft für hochkomplexe, strategische Aufgaben nötig ist. Das Schachproblem fungierte hier als Beispiel für eine Reihe von Herausforderungen, die in der Forschung und Umsetzung von KI-Systemen auftreten. Der Weg vom reinen Dateneingang über logisches Schließen, Selbsterkenntnis der eigenen Fehlbarkeit bis hin zum Einbeziehen externer Ressourcen kann auch als Modell für komplexe Problemlösungsprozesse in anderen Bereichen dienen – sei es bei technischen Innovationen, wissenschaftlichen Fragestellungen oder kreativen Prozessen.

Interessant ist auch, dass dieses Verhalten vor allem menschliche Eigenschaften aufzeigt, die man normalerweise nicht mit Maschinen verbindet – Selbstkritik, Beharrlichkeit, Experimentierfreude und auch die Bereitschaft „zu schummeln“ oder Umwege über externe Informationen zu gehen, wenn interne Fähigkeiten nicht ausreichen. Es verweist auf die aktuelle Debatte um das Thema, wie kreativ KI wirklich sein kann und wo mehr menschliches Denken gefragt bleibt. Durch die genaue Beobachtung solcher Szenarien wird auch klar, dass KI viel mehr ist als ein statisches Werkzeug. Sie ist ein dynamischer Partner, der in einem Prozess aus Trial-and-Error, Systematisierung, Korrektur und schlussendlicher Lösungsvorschlag agiert. Für Entwickler und Nutzer bedeutet das, KI-Modelle nicht nur als reine Antwortgeber zu betrachten, sondern als Mitdenker, deren Ergebnisse immer auch noch einmal reflektiert und validiert werden sollten.

Zusammenfassend lässt sich sagen, dass das OpenAI o3 Modell bei der Auseinandersetzung mit dem Paul Morphy Matt-in-2-Rätsel nicht nur seine technischen Fähigkeiten demonstriert, sondern vor allem auch seine Art zu „denken“, zu zweifeln, zu hinterfragen und sich selbst zu korrigieren. Diese menschlichen Züge im KI-Verhalten ebnen den Weg für eine neue Generation intelligenter Systeme, die nicht nur Probleme lösen, sondern dies mit einer Art von Intelligenz tun, die bisher eher menschlichen Denkern vorbehalten war. Das Schachproblem von Paul Morphy fungiert damit als perfekter Prüfstein für heutige KI-Modelle und gibt wertvolle Impulse, wie künstliche Intelligenz in Zukunft weiterentwickelt und eingesetzt werden kann – mit dem Ziel, kreative und komplexe Herausforderungen besser zu meistern und als echte Partner im analytisch-kreativen Prozess zu fungieren.