Die rasante Entwicklung großer Sprachmodelle (Large Language Models – LLMs) hat in den letzten Jahren einen tiefgreifenden Einfluss auf zahlreiche Wissenschaftsdisziplinen, darunter auch die Chemie, genommen. Ursprünglich wurden diese Modelle primär für Aufgaben wie Textvervollständigung und maschinelle Übersetzung entwickelt. Doch die Integration von LLMs in Fachgebiete zeigt immer deutlicher, dass sie weit über einfache Textverarbeitung hinaus Fähigkeiten besitzen, welche sie selbst für komplexe Problemszenarien befähigen. Im Bereich der Chemie stellt sich nun die spannende Frage, wie diese Modelle im Vergleich zur Expertise von Fachleuten abschneiden, ob sie menschliche Chemiker ergänzen oder gar übertreffen können, und welche Grenzen sie mit sich bringen. Große Sprachmodelle sind maschinelle Lernsysteme, die mit enormen Mengen an Textdaten trainiert werden, um Sprache nicht nur zu verstehen, sondern auch sinnvoll und kontextbezogen zu generieren.

Dabei lernen sie häufig komplexe Zusammenhänge, indem sie wahrscheinliche Folgewörter vorhersagen. Dieses Training ermöglicht ihnen, auch Fragen zu beantworten, die nicht explizit in ihrem Trainingsdatensatz enthalten sind. Das Potenzial, chemisches Wissen abzurufen und sogar zu kombinieren, ist beeindruckend. SO zeigen aktuelle Studien und systematische Benchmarking-Frameworks, wie ChemBench, dass führende LLMs in der Lage sind, zahlreiche chemische Fragestellungen korrekt zu beantworten und dabei teilweise sogar bessere Ergebnisse erzielen als erfahrene Chemiker. ChemBench ist ein automatisiertes Evaluierungswerkzeug, das eigens dazu entwickelt wurde, die chemischen Fähigkeiten der fortgeschrittensten LLMs objektiv zu messen.

Die Plattform stellt über 2700 Frage-Antwort-Paare bereit, die eine breite Palette chemischer Themen, von Allgemein- und Organischer Chemie bis hin zu Technischer und Anorganischer Chemie, abdecken. Dabei ist nicht nur die reine Wissensabfrage relevant, sondern auch das Beherrschen von chemischer Logik, kritischem Denken und Intuition. Dieses Benchmarking-System bietet somit eine fundierte Basis, um die Stärken und Schwächen der Modelle mit denen menschlicher Experten zu vergleichen. Die Ergebnisse solcher Studien sind überraschend: In einigen Bereichen zeigen die besten LLMs eine Leistung, die über dem Durchschnitt erfahrener Chemiker liegt. Besonders bei Aufgaben, die auf reines Faktenwissen basieren oder standardisierte Problemlösungsstrategien erfordern, sind LLMs häufig sehr präzise.

Beispiele hierfür sind Fragen zu chemischen Formeln, Reaktionsmechanismen oder der Klassifizierung von Verbindungen. Auch auf Lehrbuchebene, wie bei typischen Hochschulprüfungen, übertreffen die Modelle häufig einzelne menschliche Probanden, selbst unter realitätsnahen Bedingungen, in denen diese Zugang zu externen Hilfsmitteln wie Webrecherchen haben. Allerdings zeigen die Modelle auch deutliche Schwächen: Insbesondere bei komplexeren Aufgaben, die tiefgehende chemische Vernetzung, abstrakte Schlussfolgerungen oder visuelle Analysen erfordern, fällt es LLMs oft schwer, überzeugende oder gar korrekte Antworten zu liefern. So ist zum Beispiel die Vorhersage der Anzahl von Signalen in einem Kernspinresonanzspektrum (NMR) für viele Modelle immer noch eine große Herausforderung, weil hierfür geometrische und elektronische Strukturinformationen verarbeitet werden müssen, die schwer über rein textuelle Repräsentationen wie SMILES-Codes abzubilden sind. Auch Aufgaben, die menschliche Intuition und präferenzen widerspiegeln, etwa die Auswahl bevorzugter Moleküle in Medikamentenentwicklungsszenarien, werden von den Modellen meist nur zufällig beantwortet und zeigen keine nennenswerte Übereinstimmung mit Expertenmeinungen.

Ein weiterer spannender Aspekt betrifft die Vertrauenswürdigkeit der von LLMs erzeugten Antworten. Während Chemiker in der Regel wissen, wann sie sich unsicher sind oder weitere Informationen einholen müssen, tendieren viele Modelle dazu, ihre Antworten mit einer hohen Sicherheit zu präsentieren, auch wenn sie falsch liegen. Untersuchungen zur Kalibrierung von Vertrauensschätzungen ergaben, dass verbal artikulierte „Selbstsicherheit“ der Modelle häufig nicht mit der tatsächlichen Korrektheit der Antwort korreliert. Dies birgt Risiken insbesondere in Bezug auf sicherheitsrelevante Fragestellungen, wo Fehlinformationen schwerwiegende Folgen haben können. Beispielsweise berichten führende LLMs in Fragen zur chemischen Sicherheit oder Toxizität oft übertrieben hohe Zuversicht, auch bei inkorrekten Antworten.

Die Erkenntnisse aus solch detaillierten Benchmarking-Studien leiten wichtige Implikationen sowohl für die Entwicklung von KI-Systemen als auch für die Chemieausbildung ab. Zum einen sollte die Weiterentwicklung von LLMs stärker auf eine bessere Integration spezialisierter Datenquellen, etwa fachspezifischer Datenbanken wie PubChem oder Gestis, zielen. Die reine Textbasis ist zwar umfassend, jedoch für manche chemischen Fragestellungen unzureichend. Durch eine Kombination von Texttraining und gezieltem Zugriff auf strukturierte Fachdaten könnten Modelle fundiertere und präzisere Auskünfte geben. Zum anderen sollte die Chemieausbildung sich der Tatsache stellen, dass Modelle Fakten häufig besser speichern und abrufen können als Menschen.

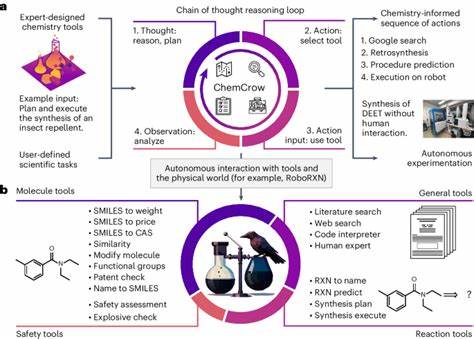

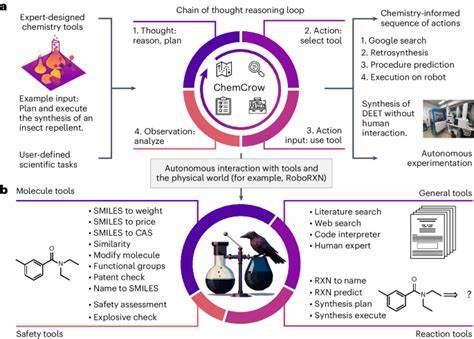

Rote Wissensabfrage verliert durch die Nutzung von LLMs an Bedeutung. Stattdessen muss die Ausbildung mehr auf kritisches Denken, tiefgehende Interpretationen und komplexe Problemlösungen ausgerichtet werden – Fähigkeiten, bei denen menschliche Chemiker weiterhin hervorragend sind und auch in Zukunft eine entscheidende Rolle spielen werden. Ein Umdenken in Lehrmethoden und Prüfungsformaten ist daher sinnvoll, um die Synergie zwischen menschlichem Expertenwissen und künstlicher Intelligenz zu fördern. Ferner eröffnet die beeindruckende Leistungsfähigkeit der LLMs Chancen für die Forschung und industrielle Anwendung. Systeme, die Chemiker bei der Recherche unterstützen, die Interpretation großer Datenmengen beschleunigen oder sogar experimentelle Designs vorschlagen, könnten den wissenschaftlichen Fortschritt erheblich beschleunigen.

Insbesondere als „Copilot“-Werkzeuge im Labor bieten sie die Möglichkeit, schneller Hypothesen zu generieren und Fehlerquellen zu reduzieren. Gleichwohl ist immer eine kritische Überprüfung der Vorschläge notwendig, um Fehlentwicklungen zu vermeiden. Das Zusammenspiel von LLMs und chemischer Expertise wirft auch ethische und sicherheitsrelevante Fragen auf. Die umfassende Verfügbarkeit dieser Technologien birgt die Gefahr eines Missbrauchs, beispielsweise bei der Entwicklung toxischer oder gefährlicher Substanzen. Die Chemiecommunity ist deshalb aufgerufen, verantwortungsvolle Umgangs- und Nutzungskonzepte zu etablieren, inklusive der Etablierung von Schutzmechanismen in den Modellen selbst.

Transparenz, Sensibilisierung und Schulung sind dabei wichtige Bausteine. „ChemBench“ als Benchmark-Framework leistet einen entscheidenden Beitrag zur objektiven Bewertung und Weiterentwicklung chemischer LLMs. Anders als bisherige Standards berücksichtigt es nicht nur einfache Wissensabfragen, sondern misst die Modelle anhand von vielfältigen Fähigkeiten wie Rechnen, Schlussfolgern, Verknüpfen von Fakten und der Anwendung von chemischer Intuition. Es ist dynamisch erweiterbar, unterstützt sowohl Multiple-Choice- als auch offene Fragestellungen und erlaubt auch die Einbindung von Tool-unterstützten Systemen, die etwa über Echtzeitsuche oder Code-Ausführung verfügen. Die Veröffentlichung der Benchmarkdatensätze und Evaluationstools fördert zudem eine offene Wissenschaftskultur und die Zusammenarbeit über Institutionen hinweg.

Trotz ihrer Grenzen sind LLMs heute schon mehr als „stochastische Papageien“, die nur gelernten Text reproduzieren. Sie zeigen erste Anzeichen von allgemeiner Problemlösekompetenz und können chemisches Wissen effektiv verknüpfen. Dennoch bleiben sie Werkzeuge, die die fachliche Einordnung und Kontrolle durch menschliche Experten erfordern, besonders in einem komplexen und sicherheitskritischen Feld wie der Chemie. Abschließend steht fest, dass große Sprachmodelle das Potenzial besitzen, die Chemie grundlegend zu transformieren. Ihre Fähigkeit, enormes Fachwissen zu verarbeiten und für unterschiedlichste Fragestellungen anzuwenden, stellt eine außergewöhnliche Ressource dar.

Gleichzeitig werden bewusste Maßnahmen benötigt, um ihre Schwächen und Risiken zu adressieren. Die Balance zwischen KI-gestützter Automatisierung und menschlicher Expertise wird dabei der Schlüssel sein, um neue wissenschaftliche Horizonte zu eröffnen und sicherzustellen, dass Fortschritt verantwortungsbewusst gestaltet wird. Die Zukunft der Chemie wird daher geprägt sein vom Zusammenspiel von menschlicher Kreativität und der Leistungsfähigkeit künstlicher Intelligenz – ein faszinierendes Zusammenspiel, das weit über das heute Vorstellbare hinausreicht.