Künstliche Intelligenz (KI) hat sich als eine der bedeutendsten technologischen Entwicklungen des 21. Jahrhunderts etabliert. Im Zentrum dieser Entwicklung stehen KI-Algorithmen – komplexe Rechenmodelle, die Aufgaben übernehmen, welche traditionell menschliche Intelligenz erforderten. Von medizinischen Diagnosen über autonome Fahrzeuge bis hin zu automatisierten Einstellungsgesprächen transformieren diese Algorithmen praktisch alle Lebensbereiche. Angesichts der immer engeren Verflechtung von KI-Systemen mit unserem Alltag stellt sich die Frage, wie wir ihre wachsende Macht und Autorität verantwortungsvoll gestalten können.

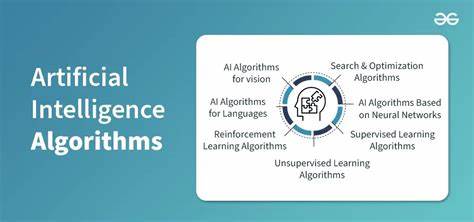

KI-Algorithmen unterscheiden sich grundlegend von klassischen, regelbasierten Programmen. Während frühere Software strikt nach vorgegebenen Regeln funktionierte, besitzen moderne KI-Modelle die Fähigkeit zur Selbstmodifikation und zum Lernen aus großen Datenmengen. Diese Technik, die vor allem auf neuronalen Netzwerken basiert, erlaubt es der KI, Muster zu erkennen und eigenständig neue Verhaltensweisen zu entwickeln. Dadurch entsteht eine Form „automatisierter Autorität“: Algorithmen entscheiden in immer größeren Bereichen – von der Vergabe von Krediten bis hin zu Inhalten, die wir online sehen. Diese Autonomie wirft zentrale Fragen zu Verantwortung und Haftung auf.

Kann Software als eigenständiger Akteur gelten? Wer haftet, wenn ein KI-System Fehler macht oder Schaden anrichtet? Rechtliche und ethische Diskussionen hierzu sind keine Neuheit, doch die Dynamik der aktuellen KI-Entwicklung verstärkt die Dringlichkeit. Ein prägnantes Beispiel liefert der Fall Thaler gegen Perlmutter, bei dem ein US-Gericht entschied, dass durch KI erzeugte Kunstwerke keine Urheberrechte erhalten können, da nur menschliche Autoren berücksichtigt werden. Die Risiken von KI-Systemen manifestieren sich in vielfacher Weise. Algorithmische Verzerrungen führen zu Diskriminierung etwa bei Bewerbungsprozessen oder Zugang zu sozialen Dienstleistungen. Frühere Beispiele wie der Microsoft-Chatbot Tay, der rassistische Äußerungen tätigte, verdeutlichen die Gefahr solcher Fehlentwicklungen.

Selbst staatliche Programme blieben davon nicht verschont, wie der niederländische SyRI-Fall zeigt, bei dem auf Basis von „nicht-westlichem Aussehen“ Betrugsverdacht generiert wurde, was zu schwerwiegenden sozialen Folgen führte. Neben ethischen Fragen sorgt die fehlende Transparenz – die sogenannte Algorithmische Opazität – für erhebliche Probleme. KI-Systeme arbeiten oft wie „Black Boxes“, deren Entscheidungen für Außenstehende kaum nachvollziehbar sind. Diese Undurchsichtigkeit kann zu systematischer Diskriminierung und gesellschaftlicher Spaltung beitragen. Der Begriff der „Filterblase“ beschreibt, wie Algorithmen in sozialen Medien Inhalte personalisieren und so zur Polarisierung der Gesellschaft beitragen können.

Die Enthüllungen von Whistleblowern verdeutlichen zudem, wie diese Systeme negative Auswirkungen auf psychische Gesundheit und ethnische Beziehungen haben. Angesichts der potenziellen Schäden und Desinformationen fordert die Wissenschaft immer lautstärker eine robuste Regulierung von KI. Prominente Experten warnen vor einem sogenannten Kontrollverlust, wenn neue, immer mächtigere KI-Modelle auf den Markt kommen, ohne dass entsprechende Sicherheitsmechanismen etabliert sind. Bemühungen wie der Algorithmic Accountability Act in den USA sind jedoch bislang ins Stocken geraten. Die politische Landschaft spiegelt eine zögerliche Haltung wider, vor allem in Bezug auf gesetzliche Eingriffe, die die Innovationskraft der Industrie nicht behindern sollen.

In den Vereinigten Staaten genießen KI-Unternehmen weitreichende rechtliche Schutzmechanismen wie Section 230 des Communications Decency Act, die bisher eine starke Haftungsbefreiung gewähren. Diese Regelungen erlauben es, KI-generierte Inhalte als Meinungsäußerungen zu interpretieren, wodurch rechtliche Konsequenzen erschwert werden. Diese Liberalisierung steht jedoch im Spannungsfeld mit den gesellschaftlichen Risiken und der Notwendigkeit, Missbrauch zu verhindern und Betroffene zu schützen. Auf internationaler Ebene sind verschiedene Regulierungsansätze zu beobachten. Die Europäische Union verfolgt mit ihrem Emblem, dem AI Act, einen risikobasierten Gesetzgebungsansatz, der bestimmte Anwendungen von KI als besonders gefährlich einstuft.

Mit der Klassifikation von Verboten, Hochrisiko-, eingeschränkten und minimalen Risiken wird versucht, geeignete Schutzmechanismen einzuführen. Die EU betont dabei „digitale Souveränität“ und will sich gegen den Einfluss von US-amerikanischen und chinesischen Tech-Konzernen behaupten. Durch die extraterritoriale Wirkung der Gesetze und empfindliche Bußgelder für Verstöße hat die EU eine Vorreiterrolle in der KI-Governance übernommen. China verfolgt hingegen einen strategisch eigenständigen Weg. Trotz US-Sanktionen hat sich das Land technologisch zunehmend unabhängig gemacht und eigene leistungsfähige KI-Modelle entwickelt.

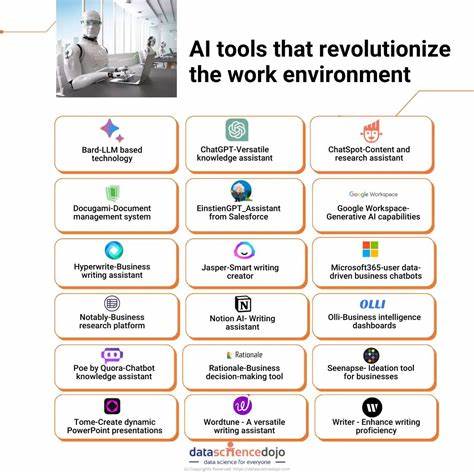

Das chinesische Regime strebt nicht nur nach technologischer, sondern auch regulatorischer Kontrolle – eine doppelte Souveränität. Die Kombination aus strengen Datenschutzvorschriften und Maßnahmen zur Kennzeichnung von KI-generierten Inhalten verdeutlicht den Fokus auf die Kontrolle und Steuerung sowohl von Technologie als auch Informationen. Technologische Machtkonzentrationen stellen eine weitere Schlüsselfrage dar. Nur wenige Unternehmen wie Microsoft, Google und Amazon dominieren den Markt für Cloud-Computing-Infrastrukturen, die für die Entwicklung und den Betrieb von KI essentiell sind. Diese Konzentration schafft de facto digitale Herrschaftsbereiche, die weitreichenden Einfluss auf Gesellschaft und Wirtschaft besitzen.

Deshalb wächst die Forderung nach öffentlichen Plattformen und offenen Infrastrukturen, um der Monopolisierung entgegenzuwirken und eine demokratischere Gestaltung von KI zu fördern. Die zukünftige Gestaltung von KI und deren Integration in unsere Gesellschaft verlangt nach einem Gleichgewicht zwischen Innovation, Schutz der individuellen Freiheit und der Sicherstellung sozialer Gerechtigkeit. Transparenz, Rechenschaftspflicht und Demokratie müssen zentral in der Governance verankert sein, um die Vorteile der KI zu maximieren und Risiken zu minimieren. Dies erfordert nicht nur staatliche Maßnahmen, sondern auch die Einbindung von Zivilgesellschaft, Wissenschaft und internationalen Institutionen. Technologien verändern unsere Welt in einem beispiellosen Tempo.

Künstliche Intelligenz hat das Potenzial, gesellschaftliche Fortschritte zu ermöglichen, stellt uns zugleich aber vor nie dagewesene Herausforderungen. Die Abwägung zwischen Automatisierung und menschlicher Autonomie, zwischen Effizienz und Ethik, wird bestimmen, wie wir als Gesellschaft mit „automatisierter Autorität“ umgehen. Es liegt an uns, eine KI-Zukunft zu gestalten, in der Technologien den Menschen dienen und demokratische Werte wahren, anstatt sie zu untergraben.