Die rasante Entwicklung von Cloud-Technologien und die zunehmende Komplexität datenintensiver Anwendungen stellen Entwickler vor immer größere Herausforderungen in Bezug auf Skalierbarkeit, Geschwindigkeit und Benutzerfreundlichkeit. Gerade für Python-Entwickler, die häufig in Bereichen wie Data Science, Machine Learning, Automatisierung oder wissenschaftlicher Forschung aktiv sind, sind leistungsfähige Lösungen zur parallelen Verarbeitung von Aufgaben essenziell. Genau hier setzt Burla an – eine aufstrebende Open-Source-Plattform, die Batch-Processing für Python revolutioniert. Burla ermöglicht es, eine einfache Python-Funktion nahezu nahtlos und extrem schnell auf Tausenden von virtuellen Maschinen parallel auszuführen. So kann jeder Python-Entwickler von den Vorteilen verteilten Computing profitieren, ohne komplexe Infrastrukturkonfigurationen oder umfangreiche Framework-Kenntnisse zu benötigen.

Die Plattform verfolgt einen innovativen Ansatz: Entwickler können ihre Funktionen lokal schreiben und mit minimalem Aufwand in der Cloud verteilen. Diese dezidierte Ausrichtung auf Usability und Geschwindigkeit macht Burla besonders interessant für Unternehmen und Einzelpersonen, die skalierbare Verarbeitung benötigen, ohne tief in DevOps oder Cloud-Engineering einzutauchen. Einer der größten Vorteile von Burla ist die Fähigkeit, Python-Code innerhalb von Docker-Containern laufen zu lassen. Diese Standardisierung schafft eine flexible Umgebung, die unabhängig von der zugrundeliegenden Hardware ist. Ob lokale Server, Cloud-Instanzen oder verschiedene Maschinentypen – Burla sorgt dafür, dass der Code konsistent funktioniert und jederzeit einsatzbereit ist.

Die Ausführung einzelner Funktionen in separaten Containern auf unterschiedlichen CPUs optimiert die Ressourcennutzung und erhöht damit die Gesamtperformance der Anwendung. Burla zeichnet sich durch eine extrem schnelle Bereitstellung aus. So können Entwickler eine einfache Python-Funktion innerhalb von zwei Sekunden auf bis zu 10.000 virtuellen Maschinen gleichzeitig starten. Diese Geschwindigkeit ist gerade im Vergleich zu herkömmlichen Batch-Processing-Frameworks außergewöhnlich und ermöglicht auch die Bearbeitung enorm großer Datenmengen oder vieler paralleler Tasks in Echtzeit.

Ein weiterer Pluspunkt ist das integrierte Monitoring-Dashboard. Gerade bei langlaufenden Jobs ist es unabdingbar, stets den Überblick zu behalten und Logs einsehen zu können. Burla bietet hierfür eine intuitive Oberfläche zum Verfolgen des Fortschritts, zur Fehlerdiagnose und zur Überwachung sämtlicher laufender Prozesse. Entwickler erhalten so wertvolle Erkenntnisse, die direkt in die Optimierung der Arbeitsabläufe einfließen können. Das Besondere an Burla ist seine Einfachheit.

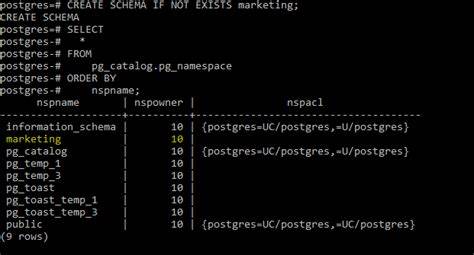

Die gesamte Plattform kann mit nur einem einzigen Installationsbefehl eingerichtet werden, was die Einstiegshürde für Entwickler drastisch reduziert. Im Fokus steht eine minimale API, die sich auf eine zentrale Funktion beschränkt: remote_parallel_map. Diese ist denkbar leicht zu nutzen. Entwickler importieren die Funktion aus dem Burla-Paket, definieren ihre Ziel-Funktion mit den gewünschten Parametern und übergeben sie an remote_parallel_map. Anschließend übernimmt Burla das verteile Ausführen der Aufgaben in separaten Containern.

Dabei wirken sich lokal ausgegebene Prints oder Exceptions direkt auf die lokale Entwicklungsumgebung aus, was Debugging und Kontrolle deutlich erleichtert. Darüber hinaus bietet Burla eine hohe Flexibilität in der Laufzeit der Anwendungen. Anders als viele Batch- oder Serverless-Lösungen, bei denen Begrenzungen für Ausführungszeit bestehen, akzeptiert Burla Code, der so lange läuft wie benötigt. Dies eröffnet neue Möglichkeiten für komplexe Berechnungen oder längerfristige Prozesse, die traditionell nur schwer in einer verteilten Umgebung realisierbar sind. Die Open-Source-Natur von Burla trägt ebenfalls zu seiner Attraktivität bei.

Entwickler profitieren von einer aktiven Community, Transparenz im Entwicklungsprozess und der Möglichkeit, den Quellcode flexibel an ihre eigenen Anforderungen anzupassen. Zudem fördert eine offene Plattform Innovationen, da neue Features und Verbesserungen rasch implementiert und geteilt werden können. Sicherheit und Datenschutz sind wichtige Aspekte jedes Cloud-basierten Dienstes. Burla adressiert diese Themen durch den Einsatz isolierter Container und einer selbst gehosteten Installationsoption. Unternehmen behalten so die volle Kontrolle über ihre Daten und die zugrundeliegende Infrastruktur und können Burla sowohl in privaten Rechenzentren als auch in öffentlichen Clouds einsetzen.

Die Einsatzmöglichkeiten von Burla sind vielfältig. Es eignet sich hervorragend für batchorientierte Datenverarbeitung, simulationsbasierte Berechnungen, automatisierte Testläufe, Verarbeitung von Streaming-Daten oder auch das Training mehrerer Machine-Learning-Modelle parallel. Insbesondere in Bereichen, in denen viele isolierte Tasks parallel abgearbeitet werden müssen, entfaltet Burla seine volle Stärke. Durch die Integration von Docker und die optimierte parallele Ausführung bietet Burla einen zeitgemäßen Ersatz für klassische HPC-Cluster oder aufwendige Cloud-Jobmanager. Dies spart nicht nur Kosten, sondern erleichtert auch die Entwicklung und Wartung signifikanter Batch-Workloads.

Wer als Python-Entwickler mit Burla experimentieren möchte, der kann die Plattform mit nur einem einfachen Installationsbefehl schnell aufsetzen und anhand eines einfachen Codeschnipsels die leistungsstarke Parallelverarbeitung testen. Die Dokumentation ist umfangreich und verständlich, sodass sowohl Anfänger als auch erfahrene Entwickler schnell produktiv werden. Für weiterführende Fragen steht der Burla-Support bereit, der per E-Mail oder über einen Demo-Termin erreicht werden kann. Zusammenfassend lässt sich sagen, dass Burla mit seinem klaren Fokus auf Benutzerfreundlichkeit, Geschwindigkeit und Skalierbarkeit eine überzeugende Lösung für Batch-Processing-Prozesse in Python bietet. Die Plattform schafft es, „Cloud Computing“ tatsächlich so zugänglich zu machen, dass sich die oft lästigen technischen Herausforderungen der verteilten Verarbeitung stark vereinfachen.

Mit Burla fühlt sich das Ausführen tausender paralleler Aufgaben fast genauso einfach an wie das lokale Programmieren auf dem eigenen Rechner. Für Unternehmen, Forschungseinrichtungen und Entwickler, die nach einer modernen, offenen und leistungsstarken Batch-Processing-Plattform suchen, ist Burla eine spannende Alternative, die durchaus Aufmerksamkeit verdient. Die Kombination aus Open-Source-Mitgestaltung, Docker-Unterstützung und blitzschneller Skalierung positioniert Burla als innovatives Werkzeug für die nächsten Schritte im verteilten Rechnen.