Das Voynich-Manuskript gehört zu den bekanntesten und rätselhaftesten Schriftstücken der Weltgeschichte. Seit seiner Entdeckung im frühen 20. Jahrhundert hat es Wissenschaftler, Kryptographen und Historiker gleichermaßen fasziniert und herausgefordert. Trotz zahlreicher Versuche ist es bis heute nicht gelungen, den geheimen Code oder die Sprache, in der das Manuskript verfasst wurde, vollständig zu entziffern. Angesichts des enormen Fortschritts in der künstlichen Intelligenz und insbesondere bei großen Sprachmodellen (Large Language Models, LLMs) stellt sich die Frage, ob diese Technologien dabei helfen können, das jahrhundertealte Rätsel zu lösen.

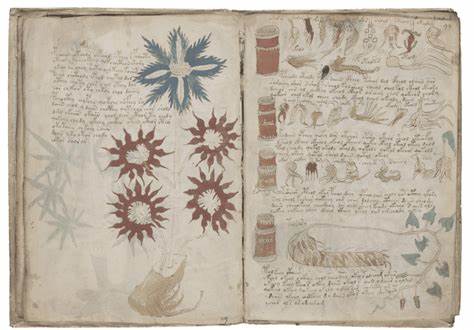

Das Voynich-Manuskript ist ein illustrierter Codex, der auf etwa das 15. Jahrhundert datiert wird und eine unbekannte Schrift sowie viele seltsame botanische, astronomische und biologische Zeichnungen enthält. Die Schriftzeichen des Manuskripts sind bislang keinem bekannten Alphabet oder Schriftsystem zuzuordnen, was die Interpretation erschwert. Viele Theorien über den Ursprung und Zweck des Manuskripts wurden im Laufe der Jahre vorgeschlagen: Einige vermuten eine verschlüsselte Sprache, andere halten es für eine besonders raffinierte Fälschung. Was jedoch alle Ansätze verbindet, ist die Herausforderung, einen echten Bezug zwischen den Symbolen und einer realen Sprache oder Bedeutung herzustellen.

Mit dem Aufkommen großer Sprachmodelle, die auf Milliarden von Textdaten trainiert wurden, eröffnen sich neue Perspektiven für die Analyse solcher komplexen kryptischen Texte. Modelle wie GPT (Generative Pre-trained Transformer) können Zusammenhänge in Texten erkennen, Muster identifizieren und sogar einfache Übersetzungen oder Interpretationen generieren. Besonders interessant ist, dass diese Modelle auch bei unbekannten oder pseudo-sprachlichen Texten semantische Strukturen zu erkennen versuchen, ohne auf eine vorgegebene Grammatik angewiesen zu sein.Die Anwendung von LLMs auf das Voynich-Manuskript erfolgt meist in Verbindung mit Methoden aus der Statistik, Korpuslinguistik und Kryptanalyse. Dabei werden die einzelnen Zeichen und Wörter des Manuskripts als Datenpunkte betrachtet, deren Vorkommen, Häufigkeiten und Positionen analysiert werden.

Durch sogenanntes „Training“ kann das Modell versuchen, Muster zu finden, die auf eine lexikalische oder syntaktische Struktur hinweisen. Einige Forscher haben versucht, mithilfe von LLMs Übersetzungsvorschläge zu generieren oder Thesen zur sprachlichen Klassifikation des Manuskripts zu erstellen, etwa ob es sich um eine abgewandelte Form von Latein, Italienisch oder einer anderen mittelalterlichen Sprache handelt.Die größten Herausforderungen bei der Umsetzung dieses Ansatzes sind jedoch vielfältig. Zum einen fehlt eine ausreichend große Referenz, da das Voynich-Manuskript in einer bisher unbekannten Schrift verfasst ist und keine „Rohübersetzung“ existiert, anhand derer das Modell lernen könnte. Zum anderen besteht die Unsicherheit, ob das Manuskript überhaupt eine verschlüsselte Nachricht in einer natürlichen Sprache enthält oder ob es sich um eine künstlerische oder absichtlich irreführende Anordnung handelt.

Diese Zweifel erschweren nicht nur die Modellierung, sondern auch die Überprüfung der Ergebnisse.Darüber hinaus können LLMs derzeit nur bedingt mit multimodalen Daten umgehen. Das Voynich-Manuskript umfasst neben dem Text auch zahlreiche Illustrationen, deren Bedeutung und Zusammenhang für das Verständnis potenziell entscheidend sind. Die Verknüpfung von Bildinformationen mit dem verschlüsselten Text stellt eine weitere Herausforderung dar, an der derzeit intensive Forschungsarbeiten laufen. Fortschritte im Bereich multimodaler KI-Systeme könnten in Zukunft neue Ansätze ermöglichen, bei denen Text und Bild gemeinsam analysiert werden, um verborgene Bedeutungen besser zu erfassen.

Ein weiterer wichtiger Aspekt ist die menschliche Expertise: Auch wenn LLMs in der Lage sind, große Datenmengen zu analysieren, benötigt es die Interpretation wissenschaftlicher Experten, um die Ergebnisse sinnvoll einzuordnen und plausible Hypothesen zu formulieren. Künstliche Intelligenz kann als Werkzeug dienen, das überraschende Verbindungen oder statistische Auffälligkeiten aufzeigt, doch die endgültige Bewertung und Einordnung bleibt eine menschliche Aufgabe. Die Synergie aus modernster KI-Technologie und fundierter historisch-kryptographischer Forschung verspricht, neue Impulse zu liefern.In der jüngeren Vergangenheit gab es mehrere Projekte, die experimentell LLMs auf das Voynich-Manuskript angewandt haben. Einige dieser Ansätze erreichten interessante Resultate durch die Identifikation von wiederkehrenden Begriffen und die teilweise Rekonstruktion möglicher grammatischer Regeln.

Dennoch blieb eine abschließende, allgemein akzeptierte Entschlüsselung bislang aus. Die Kombination aus hochentwickelten Algorithmen, verbesserten Computerressourcen und ständig wachsenden Datensätzen könnte jedoch in den kommenden Jahren die Bedingungen schaffen, um das Voynich-Manuskript endlich besser zu verstehen.Zusammenfassend lässt sich sagen, dass große Sprachmodelle ein enorm vielversprechendes Werkzeug zur Analyse des Voynich-Manuskripts darstellen. Sie bieten die Möglichkeit, versteckte Muster und Regelmäßigkeiten zu erkennen, die für das menschliche Auge schwer zugänglich sind. Gleichzeitig sind sie jedoch kein Allheilmittel und stoßen an Grenzen, wenn kein Vergleichsmaterial existiert oder wenn der Text eine rein absurde oder künstlerische Struktur aufweist.

Die Entzifferung des Manuskripts bleibt eine komplexe Aufgabe, die interdisziplinäre Zusammenarbeit und kontinuierliche technologische Weiterentwicklung erfordert.Die Zukunft könnte zeigen, dass mit noch leistungsfähigeren KI-Methoden und einer verbesserten Integration von multimodalen Daten die jahrhundertealte Geheimschrift des Voynich-Manuskripts eines Tages entschlüsselt wird. Dabei könnte sich erweisen, dass die Kombination aus maschineller Intelligenz und menschlicher Expertise der Schlüssel ist, um eines der größten Rätsel der Wissenschaftsgeschichte zu lösen.