Die moderne Softwareentwicklung steht an einem Wendepunkt, an dem Künstliche Intelligenz (KI) zunehmend eine zentrale Rolle einnimmt. Entwickler setzen verstärkt auf Tools, die nicht nur Code generieren, sondern den gesamten Entwicklungszyklus verbessern sollen. Eines der spannendsten Konzepte dabei ist die Automatisierung eines durchgängigen Workflows, bei dem aus Anforderungen direkt Tests generiert, darauf aufbauend Code geschrieben und schließlich die Tests ausgeführt werden. Dieses Vorgehen steht im deutlichen Kontrast zu bisherigen Praktiken, die häufig reaktiv sind: Der Entwickler schreibt Code, testet manuell oder automatisiert nach und korrigiert Fehler erst, wenn sie auftreten. Die neue Methodik verspricht eine proaktive Herangehensweise, die vor allem durch KI-Unterstützung realisiert werden könnte.

Ein solcher Ansatz wird oft als AI-gestütztes Test-Driven Development (TDD) bezeichnet und könnte die Entwicklungspraxis grundlegend verändern. Im Kern besteht die Vision darin, dass Entwickler ihre Anforderungen in natürlicher Sprache eingeben. Auf Basis dieser Anforderungen generiert das Tool automatisch entsprechende Unit- und Integrationstests. Erst wenn diese Tests vorliegen, wird der Code produziert, der die Tests bestehen soll. Die Tests werden unmittelbar ausgeführt, und es gibt stets Feedback zum Entwicklungsfortschritt.

Somit wird das Fehlerfinden früh in den Prozess integriert, was potenziell Zeit spart und die Softwarequalität erhöht. Diese Idee ist nicht nur technisch faszinierend, sondern löst ein bekanntes Problem in der Softwareentwicklung: die Kluft zwischen Anforderungen und tatsächlichem Code. Entwickler und Stakeholder kommunizieren oft über Anforderungen in natürlicher Sprache oder in Dokumenten, die Software entwickelt dann daraus. Die Herausforderung liegt in der Übersetzung dieser Anforderungen in exakte, maschinenlesbare Formen wie Tests und danach in zuverlässigen Code. KI kann hier als Dolmetscher agieren und sicherstellen, dass das Produkt tatsächlich das leistet, was gewünscht ist.

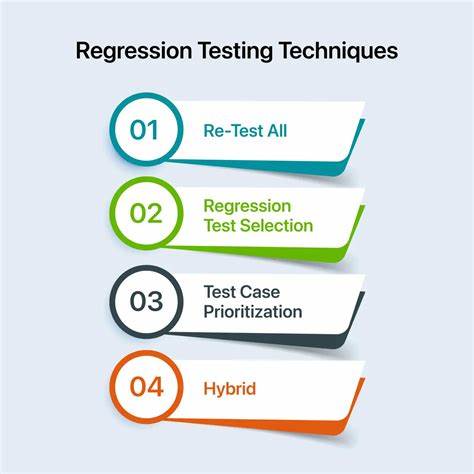

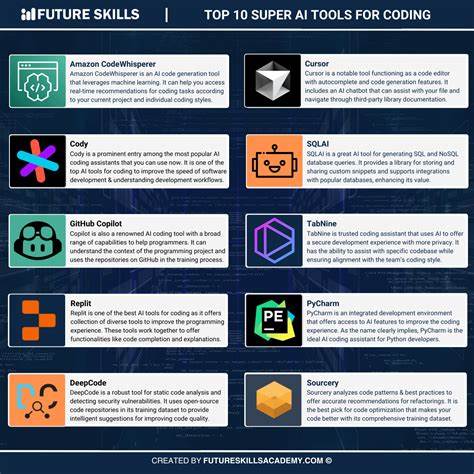

Aktuelle KI-basierte Tools wie Cursor oder GitHub Copilot generieren Code direkt aus Anforderungen, jedoch meist im Stil „Anforderungen → Code → Fehlerbehebung“. Dieses Vorgehen ist zwar schon gewinnbringend, bleibt aber reaktiv. Wenn der Code nicht wie erwartet funktioniert, muss der Entwickler erneut eingreifen und Korrekturen vornehmen. Das vorgeschlagene Konzept ändert dies fundamental. Durch das Einfügen der Testgenerierungsschicht zwischen Anforderungen und Code wird die Reaktivität reduziert und der Entwicklungsprozess strukturiert.

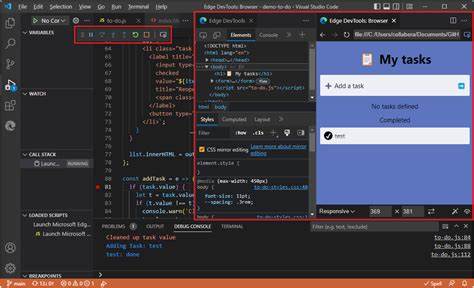

Fehler können schon vor der Codierung erkannt und behoben werden. Die Integration eines solchen Tools als Erweiterung für weit verbreitete Entwicklungsumgebungen wie Visual Studio Code erscheint sinnvoll. Dabei könnte ein Backend-System orchestrieren, welche Schritte in welcher Reihenfolge ablaufen: Anforderungen erfassen, Tests automatisch anlegen, Code generieren und Tests ausführen. Ein solches System profitiert nicht nur von modernsten KI-Lösungen, die bereits heute beeindruckende Ergebnisse in der Codegenerierung liefern, sondern optimiert auch den gesamten Workflow, indem es Automatisierung und Qualitätssicherung kombiniert. Trotz der vielversprechenden Perspektiven gibt es auch kritische Stimmen und Herausforderungen.

Einige Entwickler sind skeptisch, ob ein solches Tool die individuelle Arbeitsweise nicht zu stark einschränkt oder bestehende Prozesse verkompliziert. Die Flexibilität und Kreativität im Coding könnten leiden, wenn zu starr auf Tests bestanden wird, die maschinell generiert wurden und eventuell nicht alle Randfälle oder speziellen Szenarien abdecken. Zudem bleibt offen, wie gut KI-basierte Systeme komplexe oder unklare Anforderungen in präzise Tests übersetzen können. Sprachliche Mehrdeutigkeiten oder unvollständige Informationen sind nach wie vor Stolpersteine. Auch wirtschaftliche Faktoren spielen eine Rolle: Würden Entwickler bereit sein, für ein solches Produkt eine monatliche Gebühr zu zahlen, etwa in der Größenordnung von 20 US-Dollar, so wie es derzeit bei Cursor der Fall ist? Die Antwort hierauf hängt vermutlich von der tatsächlichen Zeitersparnis, der Qualität des generierten Codes und der nahtlosen Integration in bestehende Workflows ab.

Tool-Anbieter stehen vor der Aufgabe, neben der rein technischen Lösung auch den Wert für den Benutzer zu kommunizieren und zu garantieren. Ein weiterer Aspekt ist die zunehmende Komplexität von Softwareprojekten in Unternehmen. Gerade in großen, verteilten Teams könnte ein standardisierter Entwicklungsprozess, der auf KI und automatisierte Tests setzt, die Abstimmung verbessern und Fehler reduzieren. Für kleinere Teams oder individuelle Entwickler hingegen könnten die Hürden höher sein, vor allem wenn das Tool noch in der Anfangsphase ist und Reife sowie Anpassungsfähigkeit erst wachsen müssen. Der Blick in die Zukunft zeigt, dass KI-gestützte Entwicklerwerkzeuge zunehmend mehr können: Projekte vollumfänglich aus Anforderungen generieren, automatisierte Tests inklusive kontinuierlicher Qualitätskontrolle liefern und sogar selbständig Anpassungen vornehmen.

Schon heute gibt es Experimente mit sogenannten autonomen Agenten, die in unterschiedlichen Phasen des Softwareentwicklungszyklus agieren. Unternehmen wie Microsoft mit GitHub Copilot und OpenAI mit Codex stehen hier an vorderster Front. Auch Projekte wie AutoGPT oder LangChain versuchen, AI-Agenten vielseitiger einzusetzen. Das Potential, dabei der Übergang nicht nur vom Schreiben von Code, sondern von der generellen Steuerung komplexer Entwicklungsprozesse zu sein, ist riesig. Letztlich geht es um mehr als nur um technische Innovation: Die Veränderung des Softwareentwicklungsprozesses könnte grundlegende Auswirkungen auf die Art haben, wie Teams zusammenarbeiten, wie Fehler vermieden oder behoben werden und wie Innovationen schneller umgesetzt werden.

![iPadOS 26 Window Management On Small Screens: iPad mini and 11in Pro [video]](/images/FF508E6E-29E5-44A4-AD1A-4C05C07ECA9E)