Die Welt der Tabletop-Rollenspiele (TTRPGs) erfreut sich seit Jahren zunehmender Beliebtheit und wird durch innovative Technologien wie große Sprachmodelle (Large Language Models, LLMs) zunehmend unterstützt. Ein besonders spannendes Experiment entstand aus dem Bestreben, Qwen3-0.6B, ein eher kleines Sprachmodell, gezielt auf die Regeln und Mechaniken des Shadowdark RPG zu trainieren. Shadowdark RPG ist ein relativ neues, heroisch-fantastisches Rollenspiel mit einem düsteren Ton, geschaffen von Kelsey Dionne und veröffentlicht unter „The Arcane Library“. Doch trotz seiner Nische besitzt es eine engagierte Spielerschaft und komplexe Regelwerke, die auch von automatisierten Systemen fachgerecht verstanden und angewandt werden wollen.

Im Folgenden wird erläutert, wie durch synthetische Wissensaugmentation die Lernleistung des Modells optimiert wurde und welche Erkenntnisse aus diesem Prozess gewonnen wurden. Der Ausgangspunkt des Projekts war die Erkenntnis, dass das Basismodell Qwen3-0.6B nahezu keine spezifischen Kenntnisse über Shadowdark RPG besaß. Das Modell hatte zwar grundlegende Vorannahmen, die aus anderen Rollenspiel-Quellen stammten, beispielsweise Dungeons & Dragons (DND), jedoch waren wichtige Details und die korrekten Mechaniken von Shadowdark komplett unbekannt. Das war eigentlich ein Vorteil für den Lernprozess, hatte man doch die Möglichkeit, das Modell wirklich gezielt zu schulen, ohne dass voreingenommene Informationen aus anderen, unterschiedlichen Regelwerken das Ergebnis verfälschen.

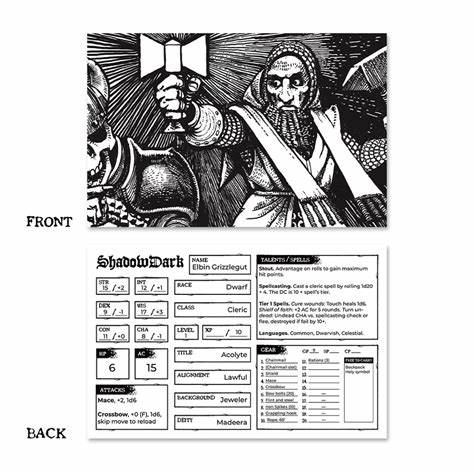

Die Herausforderung bestand zuerst darin, an ausreichend und qualitativ hochwertige Trainingsdaten zu gelangen. Hier zeigte sich moderne Technik als großer Verbündeter: Durch den Einsatz von Optical Character Recognition (OCR) konnte das umfangreiche PDF-Dokument der Shadowdark RPG Basisregeln in klar strukturierten Markdown-Text umgesetzt werden. Die Qualität der OCR-Ergebnisse war überraschend hoch, sodass sogar komplex formatierte Tabellen korrekt digitalisiert wurden. Obwohl das regelwerk eine überschaubare Größe von etwa 122.000 Tokens aufwies, war dies eine solide Grundgesamtheit, um den Weiterbildungsprozess des Modells anzustoßen.

Parallel zur Datenerhebung wurde ein eigenes Evaluierungssystem entwickelt, das die Fähigkeit des Modells überprüft, konkrete Fragen zu den Spielregeln präzise zu beantworten. Dieser sogenannte Shadowdark QA Bench ordnet die Fragen bestimmten Wissensdomänen wie Zaubermechaniken, Spielercharaktere, Monster, Kampftechniken, Ausrüstungsregeln und dem Setting bzw. der Spielwelt zu. Die Vorbereitung eines solchen Benchmarks war wichtig, um Fortschritte transparent und nachvollziehbar messen zu können. Eine besondere Herausforderung lag in der Bewertung der Antworten.

Klassische Metriken wie exakte Übereinstimmung oder einfache semantische Ähnlichkeit erwiesen sich als ungeeignet, da sie entweder zu streng oder zu nachsichtig gegenüber kleinen numerischen oder fachlichen Fehlern waren. Beispielsweise wäre „4d6 Schaden“ versus „1d6 Schaden“ semantisch ähnlich, aber spielmechanisch ein gravierender Unterschied. Daraus entstand ein innovativer, schlüsselwortbasierter Bewertungsansatz. Antworten werden in „Konzepte“ zerlegt, wobei jedes Konzept eine Gruppe von Synonymen umfasst. Der Grad der Korrektheit wird anhand der Anzahl der erkannten Konzepte im Vergleich zur Gesamtmenge bewertet.

Dieses flexible System beurteilt sowohl teilweise korrekte Antworten als auch konsequente Fehler angemessen. Trotz aller dieser Vorbereitungen zeigte sich nach dem ersten Training des Modells an den Shadowdark-Regeln, dass die reine Weiterführung des Trainingsprozesses mit der begrenzten Datenmenge nicht ausreichte, um das Modell wirklich zum Spezialisten zu machen. Zwar stiegen die Leistungswerte leicht von etwa neun auf ein wenig über zwanzig Prozent in den Tests, wichtige Detailfragen wurden jedoch konstant falsch beantwortet. Interessanterweise zeigte das Modell die Tendenz, Begriffe aus DND wie „Kleriker“ und „Zauberer“ einzusetzen, obwohl es im Shadowdark-System keine Kleriker-Klasse gibt. Das weist auf effektive aber auch hinderliche Vorannahmen in der Grundmodellierung hin.

Statt auf Ressourcen-intensives Reinforcement Learning zu setzen, wurde der Ansatz der synthetischen Wissensaugmentation gewählt. Die Methode basiert auf der Tatsache, dass Modelle Wissen besser verinnerlichen und verlässlich reproduzieren, wenn sie Informationen mehrfach und in verschiedenartigen Kontexten präsentiert bekommen. Um 10-fache Vervielfältigung der Datensätze zu erzeugen, wurden KI-gesteuerte Umschreibungen erstellt, die das gleiche Wissen in unterschiedlichen Stilen und Formaten vermitteln – etwa als einfache Erklärungen, technische Regeltextformate, konkrete Anwendungsbeispiele, häufige Fragen und Antworten oder erzählerische Darstellungen. Somit wuchs der Trainingsdatensatz auf über 1,5 Millionen Tokens an, ein bedeutender Sprung für ein kleines Modell. Nach einem zusätzlichen Training an diesen erweiterten und vielfältigen synthetischen Daten stiegen die Leistungswerte enorm auf über 66 Prozent.

Das Modell erwarb nun ein besseres Verständnis der Klassenstruktur, erkannte richtig die Priester-Klasse und zeigte eine verbesserte Fähigkeit, präzise Antworten auf Detailfragen zu geben. Wichtig ist hier, dass trotz der begrenzten Kapazität des kleinen Modells der gezielte Einsatz von qualitativ hochwertiger, synthetischer Datenvielfalt die Wissensspeicherung deutlich verbessern kann. Doch selbst bei dieser verbesserten Leistung bleiben einige Schwierigkeiten. Besonders komplexe Regelmechaniken, die mehrere Schritte oder Effekte kombinieren, stellen das Modell vor Probleme. Ein Beispiel sind Monsterfähigkeiten, bei denen mehrere Schadenseffekte oder Kontrollmechanismen gleichzeitig auftreten.

Hier fehlt es noch an der nötigen Feinabstimmung, was auch auf die Seltenheit solcher komplexen Datenpunkte im Trainingssatz zurückzuführen ist. Ausblick und nächste Schritte richten sich auf die sogenannte Assistant Tuning-Phase. Dort soll das Modell nicht nur statisch Regeln abrufen, sondern interaktiv mit Spielleitern und Spielern agieren können. Zudem werden Werkzeuge entwickelt, die strukturierte Spielinformationen wie Charakterbögen in standardisierten Datenformaten verwalten und automatisiert überprüfen können. Dies eröffnet eine breite Palette an Anwendungsmöglichkeiten, etwa für digitale Spielhilfen, modulare Regelabfragen oder intelligentes Spielmanagement.

Das Projekt zeigt eindrücklich, wie durch ausgewogenes Zusammenspiel von modellseitigen Anpassungen, sorgfältiger Datengenerierung und innovativen Evaluationsmethoden auch kleinste Sprachmodelle für hochspezialisierte Fachgebiete fit gemacht werden können. Insbesondere kleine Modelle sind hier im Vorteil, da sie mit verhältnismäßig wenig Rechenleistung trainierbar bleiben und somit einem breiteren Nutzerkreis zur Verfügung stehen. Neben den rein technischen Aspekten bietet dieser Ansatz auch Perspektiven für die Community der Shadowdark-Spieler und Entwickler. Eine klar strukturierte und durchsuchbare digitale Wissensbasis erleichtert Anfängern wie Veteranen das Verständnis der Regeln und vermeidet die häufige Zerrüttung durch persönliche Interpretationen oder Unklarheiten. Auch das Design neuer Regeln oder Module könnte von einer einfachen synthetisch augmentierten Datenbasis profitieren, da so schon bei der Entwicklung die Konsistenz geprüft und optimiert werden kann.

Zusammenfassend lässt sich sagen, dass das experimentelle Training von Qwen3-0.6B mittels synthetischer Wissensaugmentation exemplarisch aufzeigt, wie Transformation und gezielte Domänenadaption von Sprachmodellen effektiv gelingen kann. Obwohl die Datenmenge im Vergleich zu großen allgemeinen Pretraining-Korpora klein ist, erlaubt der gezielte Fokus auf Wiederholung und Varianten die tiefere Verankerung von Spezialwissen. Das verspricht nicht nur Fortschritte bei der Automatisierung von Tabletop-Rollenspielassistenten, sondern öffnet auch Türen für viele weitere Fachgebiete, in denen präzises Regel- und Faktenwissen gefragt ist. Die Zukunft der LLM-gestützten Rollenspielunterstützung wird durch solche Forschungen nachhaltig geprägt.

Mit einer Kombination aus sorgfältiger Datenaufbereitung, geduldigem Training und innovativer Evaluation können auch kleine Modelle erstaunliche Leistungen erzielen. Für Entwickler, Spieler und Forscher gleichermaßen bleibt es spannend, die nächsten Schritte zu beobachten und die neuen Möglichkeiten zu nutzen, die sich durch solche hybriden Ansätze ergeben.