In der Welt der Hochleistungsrechner hat die parallele Programmierung schon immer eine herausfordernde Rolle gespielt. Entwickler stehen regelmäßig vor der Frage, ob Sprachen, die auf Produktivität ausgelegt sind, zwangsläufig Leistungseinbußen in Kauf nehmen müssen. Dieser Mythos, dass Produktivität und Performance sich grundsätzlich widersprechen, hält sich hartnäckig. Doch ein genauerer Blick auf moderne parallele Programmiersprachen zeigt, dass diese Annahme überdacht werden muss. Parallelprogrammierung ist komplex und erfordert von Programmierern, nicht nur algorithmische Logik zu verstehen, sondern auch die zugrundeliegende Hardware, Prozesse und Speicherlayouts optimal zu nutzen.

Traditionelle Programmiersprachen wie C, C++ oder Fortran bieten zwar eine hohe Leistung, belasten Entwickler jedoch mit detaillierten, fehleranfälligen Parallelisierungsmechanismen. Die Folge sind lange Entwicklungszeiten und beim Versuch, sämtliche Performanceaspekte manuell zu optimieren, häufig unübersichtlicher und schwer wartbarer Code. Genau an dieser Stelle setzen skalierbare parallele Programmiersprachen wie Chapel an. Sie verfolgen das Ziel, die Produktivität der Entwickler zu steigern, indem sie höhere Abstraktionen bereitstellen, die komplexe Hardware- und Parallelitätsaspekte intelligent kapseln. Oft besteht die Befürchtung, dass diese Abstraktionen mit einem Leistungseinbruch einhergehen.

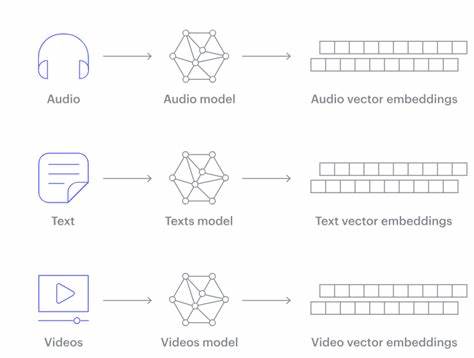

Doch die Realität ist differenzierter: Wenn Programmiersprachen gezielt gestaltet werden, um sowohl semantisch reichhaltige Informationen zu vermitteln als auch die Hardware effizient anzusprechen, können Produktivität und Performance harmonisch zusammenwirken. Ein zentrales Argument dafür liegt in der Art, wie Programmiersprachen Informationen an den Compiler übermitteln. Der Compiler kann nur dann beste Optimierungen vornehmen, wenn er die Absichten des Entwicklers klar versteht. Niedrige Abstraktionen, wie sie bei der Verwendung von Low-Level-Datenstrukturen mit indirektem Indexieren üblich sind, verbergen diese Intentionen oftmals. Zum Beispiel behindert indirektes Indexieren in der Implementierung einer komprimierten Matrix die Optimierbarkeit des Codes, da der Compiler den Zusammenhang zwischen Daten kaum erkennen kann.

Diese Einschränkungen führen dazu, dass Performance-Verbesserungen manuell von erfahrenen Entwicklern eingepflegt werden müssen, was zusätzlich die Produktivität schmälert. Moderne parallele Sprachen wie Chapel bieten speziell für solche Domänen zugeschnittene Abstraktionen an. Sparse-Matrizen werden beispielsweise als eigenständige Typen mit klar definierten Eigenschaften behandelt. Dadurch kann der Compiler gezielte Optimierungen durchführen, die bei der Nutzung herkömmlicher Werkzeugen nicht möglich wären. Die verbesserte Semantik ermöglicht raffinierte Strategien wie das Teilen von Schleifen oder die gezielte Behandlung von sogenannten implizit replizierten Werten.

Programmierer profitieren in diesem Szenario von einer leichter verständlichen und wartbaren Codebasis, während gleichzeitig der Compiler die Möglichkeit erhält, hochperformanten Maschinencode zu generieren. Darüber hinaus gibt es viele Produktivitätsfeatures in modernen parallelen Sprachen, die gar keinen Einfluss auf die Laufzeitperformance haben, dafür aber die Entwicklererfahrung deutlich verbessern. Ein Beispiel ist die statische Typinferenz. Anstatt von Anfang an alle Datentypen explizit angeben zu müssen, können Programmierer sich zunächst auf die Logik konzentrieren und dem Compiler vertrauen, die Typen automatisch abzuleiten. Das reduziert die Menge des geschriebenen Codes und erhöht die Lesbarkeit, ohne zur Laufzeit Mehrkosten zu verursachen.

Diese Art der Typinferenz ist kein dynamisches Typing, sondern eine reine Kompilierzeitoperation, die die Performance unverändert lässt. Auch das Konzept von Iteratoren in Chapel illustriert, wie moderne Sprachfeatures die Produktivität heben können. Iteratoren erlauben es, komplexe Schleifen- und Datenzugriffsstrukturen elegant zu beschreiben und gleichzeitig performant zu bleiben, dank Compiler-Inlining und Optimierungen, die den Overhead minimieren. Solche Konstrukte erleichtern das Schreiben paralleler Codes und fördern eine klare, verständliche Struktur. Der Wegfall von Zielkonflikten zwischen Performance und Produktivität zeigt sich exemplarisch in den Benchmarks von Chapel.

Mittlerweile kann die Sprache mit traditionellen Hochleistungswerkzeugen wie C, C++ oder Fortran konkurrieren und skaliert auf tausenden Rechnerknoten und Millionen von Prozessorkernen, inklusive GPUs. Die Fortschritte belegen, dass moderne parallele Programmiersprachen auf den ersten Blick abstrakt wirken mögen, aber hinter den Kulissen hocheffiziente Maschinencodes produzieren. Dieser Fortschritt ist allerdings kein Selbstläufer. Die Entwicklung solcher Sprachen erfordert eine sorgfältige Auswahl und Ausgestaltung von Sprachfeatures, die sowohl Programmierern helfen als auch die Kompilierung effizient unterstützen. Es ist wichtig, dass nichts die Optimierbarkeit wesentlich erschwert oder verschleiert.

So darf beispielsweise die Einführung von Objektorientierung nicht zu häufigen dynamischen Dispatch-Verfahren führen, weil diese die Performance beeinträchtigen könnten. Die Abkehr von übermäßiger Mikrooptimierung durch Entwickler hin zu semantisch reichhaltigen Programmen verbessert nicht nur die Qualität des Codes, sondern auch dessen Wartbarkeit, Portabilität und Robustheit. Programme, die klarer strukturierte parallele Algorithmen darstellen, öffnen Türen für fortgeschrittene Compilertechniken, die letztlich zu besserer Skalierbarkeit und Performance führen. Neben der Sparsamkeit bei der Auswahl der Sprachfeatures spielt auch die Modernisierung der Compiler eine zentrale Rolle. Neben der Optimierung traditioneller synchroner und asynchroner Operationen werden auch Techniken zur Reduktion von Kommunikationsoverheads in verteilten Array-Operationen weiterentwickelt.

Dadurch lassen sich in großem Maßstab Ausführungen verbessern, ohne Entwickler mit zusätzlichen Details zu belasten. Die Fortschritte bei Chapel zeigen, dass sich Produktivität und Performance nicht ausschließen. Dies bedeutet für die Hochleistungs-Computing-Community, dass zukünftige parallele Programmiersprachen viel stärker darauf achten sollten, wie Sprache und Compiler zusammenarbeiten. Es empfiehlt sich, Sprachfeatures nicht als reine Komfortverbesserungen zu sehen, sondern als Chancen, Optimierungen direkt am abstrakten Computermodell zu ermöglichen. Für Entwickler heißt dies, dass sich die Investition, neue parallele Sprachen zu erlernen, auszahlt.