Die Sprachsynthese hat in den letzten Jahren enorme Fortschritte gemacht und ist aus unserem digitalen Alltag nicht mehr wegzudenken. Insbesondere die Kombination aus großen vortrainierten Sprachmodellen und fortschrittlichen Audiotechnologien eröffnet völlig neue Perspektiven, die weit über einfache Text-zu-Sprache-Anwendungen hinausgehen. Ein prominentes Beispiel dieser Entwicklung ist Llasa, eine innovative Methode zur Sprachsynthese, die auf der LLaMA-Architektur basiert und sowohl beim Training als auch bei der Inferenz neue Wege beschreitet. Llasa ist ein System, das speziell darauf ausgelegt ist, die natürlichen Klangcharakteristiken der menschlichen Sprache zu reproduzieren und dabei eine besonders komplexe und genaue Prosodie zu generieren. Dabei werden Schwierigkeiten der bisherigen mehrstufigen Systeme überwunden, die oft mehrere unterschiedliche Modelle benötigen, etwa ein Sprachmodell gefolgt von einem Diffusionsmodell.

Mit Llasa wird dank eines einheitlichen Transformatormodells und einem einfachen Vektorquantisierer-Codec (VQ-Codec) ein nahtloses und effizientes Sprachgenerierungsverfahren realisiert, das mit Standard-Modellen wie LLaMA kompatibel ist. Die Innovation liegt vor allem in der konsequenten Skalierung der beim Training und bei der Laufzeit verwendeten Rechenkapazitäten. Durch die Erhöhung des Trainingsaufwands lässt sich die Natürlichkeit der generierten Sprache deutlich verbessern. Hervorzuheben ist, dass die Skalierung des Trainings zeitgleich mit einer Steigerung komplexer Prosodie-Muster einhergeht, was für die Authentizität und Ausdrucksstärke der Stimme von großer Bedeutung ist. Die dynamische Prosodie – also die rhythmische, melodische und emotionale Gestaltung des Sprachflusses – trägt wesentlich zur Verständlichkeit und zum Hörerlebnis bei.

Neben dem Training fokussiert Llasa auch auf die Skalierung der Inferenz, also der Echtzeit-Sprachgenerierung. Hier kommt eine kreative Methode zum Einsatz: Während der Synthese werden spezialisierte Sprachverständnismodelle als Verifizierer verwendet, um die Ausgabe im Suchprozess zu lenken. Dieser Ansatz führt dazu, dass verschiedene Klangmerkmale, wie emotionale Ausdruckskraft, Stimmkonsistenz oder Inhaltsgenauigkeit zielgerichtet optimiert werden können. Je mehr Rechenkapazitäten für die Inferenz zur Verfügung stehen, desto feiner lässt sich die Sprachqualität an individuelle Anforderungen oder Präferenzen anpassen. Die Kombination aus einem einfachen Codec-System und einem einzigem Transformer-Modell schafft eine stark vereinfachte Architektur, die zugleich mit den leistungsfähigsten Sprachmodellen konkurrieren kann.

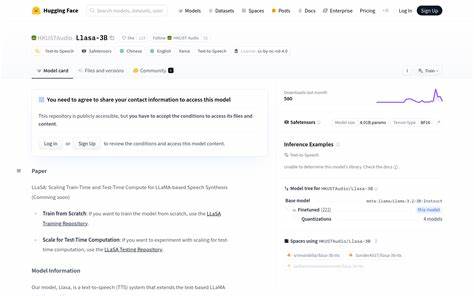

Llasa steht dabei nicht nur theoretisch für Fortschritt, sondern wurde in verschiedenen Modellgrößen von 1 bis 8 Milliarden Parametern entwickelt und trainiert. Die Veröffentlichung der Trainingscodes und Checkpoints unterstreicht zudem die Absicht, die Forschungsgemeinschaft und industrielle Entwickler eng in die Weiterentwicklung einzubinden. Interessant ist auch die Qualität der zugrunde liegenden Audio-Codecs. Im Vergleich zu etablierten Codecs wie Encodec oder StableCodec zeigt Llasa in ersten Tests eine vielversprechende Rekonstruktionsqualität, die die Basis für hochwertige Sprachsynthese bildet. Dies zeigt sich unter anderem in der natürlichen und detaillierten Sprachwiedergabe von Beispielsätzen in englischer und chinesischer Sprache, die sowohl leichte Nuancen als auch komplexe tonale Veränderungen wiedergeben können.

Das langfristige Potenzial von Llasa liegt damit gleich in mehreren Bereichen: Zum einen könnte die einfachere und skalierbare Architektur mit der verbesserten Sprachqualität die Entwicklung sprachbasierter Anwendungen beschleunigen. Zum anderen eröffnet die Möglichkeit, die Inferenz vielfältig zu steuern, neue Wege für personalisierte und emotional kohärente Sprachagenten, Hörbücher, Games und virtuelle Assistenten. Vor allem die Fähigkeit, emotionale Nuancen und stimmliche Konsistenz bei der Live-Erzeugung zu wählen, ist für viele interaktive Anwendungen von essenzieller Bedeutung. Die Arbeit an Llasa zeigt exemplarisch, wie moderne KI-Forschung durch die konsequente Nutzung von Skalierungseffekten und modularen Architekturen neue Standards setzt. Dabei zeichnet sich ab, dass die enge Verzahnung von Training und inference computations – also den Rechenressourcen während Modelltraining und Echtzeitspracherzeugung – entscheidend ist, um die Sprachqualität einerseits zu maximieren und andererseits flexibel auf Nutzungsanforderungen reagieren zu können.

Im Vergleich zu früheren TTS-Systemen, die häufig komplexe mehrstufige Pipelines bestanden, schafft Llasa mit seinem simplifizierten Ansatz eine zugängliche und leistungsfähige Alternative, die speziell auch für den Einsatz mit großen Sprachmodellen wie LLaMA optimiert ist. Die Zukunft der Sprachsynthese dürfte von solch integrativen und skalierbaren Lösungen geprägt sein, die sowohl in Forschung als auch Industrie die Barrieren für natürlich klingende, vielfältige und adaptive synthetische Stimmen signifikant reduzieren. Zusammenfassend ermöglicht Llasa eine neue Qualität bei der Text-zu-Sprache-Umsetzung, die sich durch konsistente, emotional ausdrucksstarke, prosodisch komplexe und inhaltlich präzise Sprachresultate auszeichnet. Die Kombination aus fortschrittlicher Modellarchitektur, einfachen Codec-Technologien und innovativen Verifizierungsstrategien macht den Ansatz zu einem Meilenstein, der die zukünftige Entwicklung und Anwendung von Sprachsynthese maßgeblich beeinflussen wird.