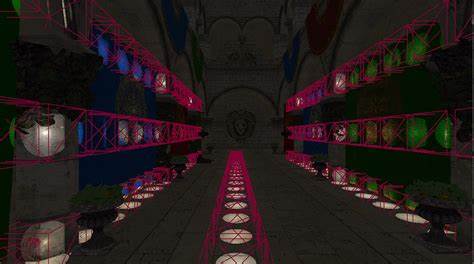

Die Welt der Computergrafik hat sich in den letzten Jahren rasant weiterentwickelt, doch die Herausforderung bleibt dieselbe: Wie lassen sich immer komplexere Szenen in Echtzeit rendern, ohne dabei Kompromisse bei der Bildqualität oder der Performance einzugehen? Ein besonders beeindruckendes Beispiel hierfür ist die Fähigkeit, 27.000 Stanford-Drachen gleichzeitig in einer Szene darzustellen und dabei 10.000 Lichtquellen zu berechnen – und das alles in über 60 Frames pro Sekunde auf einer vergleichsweise älteren GPU wie der GTX 1070. Doch wie gelingt ein solcher Quantensprung in der GPU-gestützten Rendering-Technologie? Im Kern steht eine GPU-gesteuerte, clustered forward Renderer-Architektur, die auf der intelligenten Nutzung von parallelen Berechnungstechniken und einer durchdachten Licht- und Objektverwaltung basiert. Dieses Zusammenspiel optimiert sowohl die Nutzung der GPU als auch die Effizienz der Renderpipeline und minimiert Engpässe, die bei traditionellen CPU-gesteuerten Systemen auftreten.

In konventionellen Rendering-Setups trennen sich die Verantwortlichkeiten von GPU und CPU recht strikt: Während der Grafikprozessor häufig die Texturen, Meshes und andere GPU-residente Assets verwaltet, übernimmt die CPU die Verwaltung der Entitätsdaten wie Positionen oder Bewegungsvektoren. Diese Trennung sorgt für eine gewisse Flexibilität, führt aber auch zu Performanceeinbußen, da regelmäßig Daten von der CPU zur GPU übertragen und Draw-Calls sequentiell ausgeführt werden müssen. Besonders Draw-Calls, die für jeden einzelnen Objektaufruf einen separaten Befehl benötigen, bremsen die Pipeline spürbar aus und limitieren die Effizienz auf modernen Grafikhardware. Der GPU-driven Ansatz bricht mit dieser Tradition: Statt jeden Draw-Call von der CPU zu initiieren, werden Objekt- und Renderdaten direkt auf der GPU verwaltet. Dies wird unter anderem durch den Einsatz indirekter Multi-Draw-Calls ermöglicht, bei denen die GPU Draw-Befehle aus einem vorab gefüllten Puffer direkt ausführt.

Der Vorteil ist enorm: Eine einzelne API-Anweisung kann so hunderte oder tausende Draw-Calls ersetzen, was die CPU entlastet und gleichzeitig eine bessere Parallelisierung schafft. Draw calls können so zusammengefasst werden, sodass ein einzelner Befehl der Grafikschnittstelle viele Objekte rendert, ohne dass die CPU selbst jede Einzelheit anstoßen muss. Zur effizienten Verwaltung der tausenden Objekte wie den 27.000 Stanford-Drachen werden alle relevanten Daten in großen, zusammenhängenden GPU-Puffern gehalten. Dazu gehören Vertex- und Index-Daten, aber auch spezielle Object- und Draw-Puffer, die Objektdaten und Informationen für den Zeichenaufruf enthalten.

Besonders clever ist dabei der Umgang mit statischen und dynamischen Objekten: Stationäre Elemente wie Terrain können einmal hochgeladen werden, während bewegte Objekte laufend aktualisiert werden. Dieses System minimiert Speicherzugriffe und lässt die GPU die Anzahl der aktiven Objekte basierend auf Sichtbarkeit dynamisch bestimmen. Ein zentraler Bestandteil des Renderprozesses ist das sogenannte Frustum-Culling, das bedeutet, dass nur jene Objekte gerendert werden, die sich im Sichtfeld der Kamera befinden. Hierfür läuft ein Compute-Shader auf der GPU, der anhand der in der Object Buffer gespeicherten Bounding-Boxen jedes Objekts entscheidet, ob dieses sichtbar ist oder nicht. Unsichtbare Objekte werden aus dem Draw-Puffer ausgeschlossen, wodurch die GPU nicht unnötig Arbeit für Objekte verrichtet, die außerhalb des Bildschirmbereichs liegen.

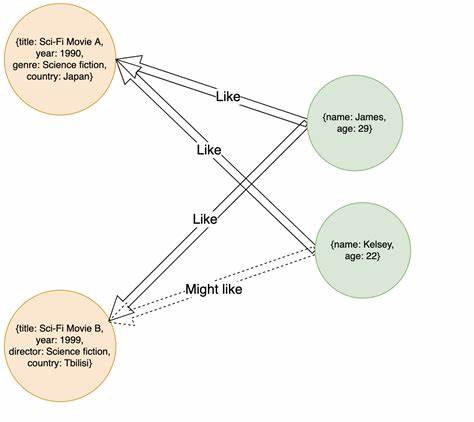

Das Clustern beziehungsweise die Clustered Shading-Methode ist eine Schlüsselinnovation zur Bewältigung der hohen Anzahl von Lichtquellen. Die herkömmliche Forward-Rendering-Technik hat den Nachteil, dass Lichtberechnungen auf Fragmentebene oft unnötigerweise für viele Lichter durchgeführt werden, selbst wenn deren Einfluss auf das errechnete Fragment vernachlässigbar ist. Dies führt zu Overdraw und unnötiger Rechenlast. Clustered Shading adressiert dieses Problem, indem der Sichtkegel (View Frustum) in mehrere kleinere Volumina, sogenannte Cluster oder Froxels, unterteilt wird. Jeder Lichtquelle wird dann zugewiesen, welche Cluster sie beeinflusst und somit die Fragment-Shading-Berechnungen innerhalb der betreffenden Cluster auf nur diese Lichter beschränkt werden.

Technisch werden für diese Cluster drei wesentliche GPU-Puffer eingesetzt: Der Cluster Puffer, der die einzelnen Volumina definiert; der Cluster Items Puffer als Indirektionsdaten, der für jeden Cluster auf die relevanten Lichtindices zeigt; und der Licht-Puffer, der die tatsächlichen Lichtdaten enthält. Die Verwaltung dieser Daten auf der GPU ermöglicht eine äußerst effiziente Suche nach den Lichtern, die für einen bestimmten Fragment relevant sind. Ein besonders anspruchsvoller Schritt ist die Zuweisung der Lichtquellen zu den Clustern. Während eine naive Herangehensweise darin bestünde, dass jeder Cluster alle Lichter einzeln auf Überschneidung überprüft, würde dies schnell sehr ineffizient und speicherintensiv werden – gerade bei Zehntausenden von Lichtern. Hier setzt eine optimierte, kooperative Methode auf Subgruppenoperationen und Shared Memory, bei der jeweils Batches von Lichtinformationen gemeinsam geladen und über die Subgruppe bewertet werden.

Diese Zusammenarbeit der Shader-Threads führt zu deutlich beschleunigten Berechnungen und einer dramatischen Reduzierung des Speicherbedarfs, da nur tatsächlich relevante Lichtindices abgespeichert werden. Ein intelligentes Hashing-System sorgt zudem dafür, dass identische Lichtsets der Cluster erkannt und nur einmal gespeichert werden, was weiteren Speicher spart. Im Shading selbst wird dann für jeden Fragment anhand der Position im View Space der zugehörige Cluster ermittelt und nur die Lichter in diesem Cluster für die Beleuchtungsberechnung berücksichtigt. Dabei sorgt eine zusätzliche Optimierung durch Subgroup-Ballots dafür, dass wenn alle Fragmente einer Subgruppe im gleichen Cluster liegen, die Lichtdaten nur einmal aus dem Speicher gelesen werden, was die GPU-Register schont und die Speicherbandbreite reduziert. Das Endergebnis dieser komplexen Pipeline ermöglicht die beeindruckende Darstellung tausender detailgetreuer Modelle wie der Stanford-Drachen bei gleichzeitig mehreren tausend dynamischen Lichtquellen in Echtzeit.

Diese Leistung entsteht allerdings nicht ohne Kompromisse: Um die Rechenlast handhabbar zu halten, wird etwa die Reichweite der Lichtquellen deutlich reduziert, was zu sichtbaren Schattierungsartefakten führen kann. Die Szene ist daher eher eine Demonstration der Leistungsfähigkeit moderner GPU-Architekturen und intelligenter parallelisierter Shader-Programme, als ein direkt in einem kommerziellen Spiel sofort einsetzbarer Standard. Dennoch verdeutlicht diese Technologie, welche Potentiale mit einer vollständigen Verlagerung der Rendersteuerung auf die GPU verbunden sind. Der Verzicht auf die konventionelle CPU-kontrollierte Draw-Call-Erzeugung erlaubt eine fein granulare Steuerung und dynamische Sichtbarkeitsberechnung, die mit traditionellen Methoden so nicht möglich wäre. Zudem eröffnet Clustered Shading Perspektiven für noch weitere Optimierungen, wie etwa die Integration von Occlusion Culling, Meshlet Rendering oder hybriden Renderpipelines.

Abschließend lässt sich festhalten, dass die Kombination aus indirektem Multi-Draw auf der GPU, effizientem Frustum-Culling mittels Compute Shadern und dem innovativen Clustered Shading zu einer neuen Generation von Echtzeit-Renderern führt. Diese Renderer sind in der Lage, komplexe Szenen mit einer enormen Menge an Details und Lichtquellen auf Geräten der Mittelklasse darzustellen. Die vorgestellten Techniken bieten somit eine vielversprechende Basis für zukünftige Anwendungen in Spielen, Simulationen und Virtual Reality. Die Erforschung solcher paralleler Berechnungstechniken wird auch weiterhin rasante Fortschritte ermöglichen, vor allem unter Einbeziehung moderner GPU-Features wie Subgroup Operations, Shared Memory und ausgefeilter Speichermanagement-Strategien. Entwickler und Forscher stehen damit vor spannenden Herausforderungen und zugleich großen Chancen, die Grenzen der Echtzeitgrafik weiter zu verschieben.

Wer sich für tiefergehende technische Details interessiert, findet umfangreiche Quellen und Quellcodes, die solche Systeme exemplarisch demonstrieren und als Grundlage für eigene Experimente und Erweiterungen dienen können. In einer Zeit, in der visuelle Qualität und Immersion immer höhere Erwartungen erfüllen müssen, ist das Verständnis und die Anwendung dieser GPU-zentrierten Rendering-Technologien essenziell. Die Fähigkeit, riesige Mengen an Objekten und Lichtquellen in Echtzeit effizient zu verarbeiten, wird zu einem der entscheidenden Faktoren für die nächste Generation von grafikintensiven Anwendungen und Spielen.