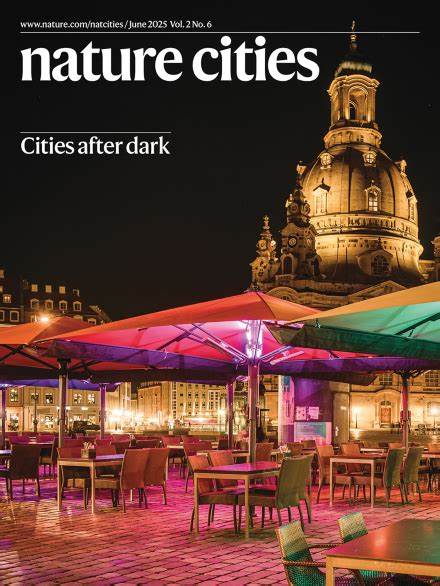

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, kurz LLMs) hat in den letzten Jahren auch die Chemiebranche revolutioniert. Ursprünglich entwickelt, um natürliche Sprache zu verstehen und zu generieren, zeigen diese Modelle zunehmend beeindruckende Fähigkeiten im Verarbeiten und Interpretieren fachspezifischer Inhalte – dazu gehört auch die komplexe Welt der Chemie. Die entscheidende Frage lautet: Können diese Künstliche-Intelligenz-Systeme das Wissen und die Intuition erfahrener Chemiker wirklich ersetzen oder gar übertreffen? Die jüngste Studie, veröffentlicht im renommierten Fachmagazin Nature Chemistry im Jahr 2025, liefert einen tiefgehenden Vergleich zwischen den Fähigkeiten moderner LLMs und menschlicher Chemikerexperten. Die Ergebnisse werfen nicht nur Licht auf das Potenzial und die Grenzen der KI in diesem Bereich, sondern fordern auch eine Neubewertung von Aus- und Weiterbildung im chemischen Kontext. Die Grundlagen großer Sprachmodelle beruhen auf maschinellem Lernen mit riesigen Mengen an Textdaten.

Während sie ursprünglich darauf trainiert wurden, menschliche Sprache sinnvoll zu ergänzen und zu erzeugen, haben sie durch das sogenannte Transferlernen die Fähigkeit erworben, auch Aufgaben zu bewältigen, für die sie nicht explizit programmiert wurden. In der Medizin beispielsweise bestehen sie bereits Prüfungen, die sonst nur Fachärzten vorbehalten sind. Dass nun auch die Chemie davon profitiert, ist wenig überraschend und dennoch revolutionär. Die Studie führt als Werkzeug ein Evaluierungsframework namens ChemBench ein, das über 2.700 Frage-Antwort-Paare im Bereich Chemie umfasst.

Diese Fragen sind vielfältig und beziehen sich auf Unterdisziplinen wie anorganische, organische, analytische oder technische Chemie. Dabei legen die Forscher besonderen Wert auf unterschiedliche Kompetenzbereiche, etwa reines Faktenwissen, komplexe Schlussfolgerungen, Berechnungen und auch chemische Intuition, die oft menschenähnliches Urteilsvermögen und Erfahrungswerte widerspiegelt. ChemBench berücksichtigt zudem verschiedene Schwierigkeitsgrade und erlaubt so eine differenzierte Bewertung der Modelle. Im direkten Vergleich mit 19 menschlichen Chemikern verschiedener Spezialisierungen zeigte sich, dass einige der modernen LLMs, wie das Modell o1-preview, bei vielen Aufgaben eine überdurchschnittliche Leistung erzielen. Tatsächlich können sie in einigen Fällen das beste menschliche Niveau fast verdoppeln, wenn es um das reine Beantworten der Fragen geht.

Das klingt zunächst nach einer Sensation – eine KI, die einen erfahrenen Wissenschaftler hinter sich lässt. Doch diese beeindruckenden Zahlen sollten nicht zu voreiligen Schlüssen verleiten. Die Detailanalyse offenbart nämlich Schwächen, die gerade in sicherheitsrelevanten oder komplexen Bereichen der Chemie existenziell sind. So fällt es den Modellen teilweise schwer, grundlegende Wissensfragen korrekt zu beantworten, etwa zur Toxizität von Substanzen oder zur Anzahl der in einem Kernspinresonanzspektrum sichtbaren Signale bei bestimmten Molekülen. Dies deutet darauf hin, dass die Modelle oft nicht wirklich über tiefes Wissen verfügen oder molekulare Strukturen im erwarteten Sinn nicht vollständig verstehen, sondern eher Muster aus Trainingsdaten reproduzieren.

Ein weiteres Problem ist die oftmals fehlende Fähigkeit der Modelle zur Ehrlichkeit in Bezug auf ihr eigenes Wissen. In der Studie wurden die KI-Systeme gebeten, ihr Vertrauen in die jeweilige Antwort zu beurteilen. Leider waren diese Selbsteinschätzungen wenig verlässlich und manchmal sogar irreführend. So gaben die Modelle in manchen Fällen sehr hohe Sicherheit bei doch falschen Antworten an, was in praktischen Anwendungen gefährlich sein kann. Dies macht deutlich, dass das Vertrauen in KI-gestützte Systeme in der Chemie nur mit großer Vorsicht erfolgen sollte – gerade wenn es um sicherheitsrelevante Entscheidungen geht.

Interessant ist auch die Beobachtung, dass LLMs bei Aufgaben mit stark struktureller Komplexität, etwa der Vorhersage von Isomeren oder der Interpretation von Spektraldaten, oft nicht überzeugend abschneiden. Hier sind traditionelle menschliche Kompetenzen, welche auf räumlichem Vorstellungsvermögen und multidimensionalem Denken basieren, weiterhin unerlässlich. Die Modelle scheinen stattdessen auf Ähnlichkeiten zu bereits gelernten Beispielen zurückzugreifen, was ihre Flexibilität und Kreativität einschränkt. Neben der reinen Wissensvermittlung gewinnt auch die Bewertung chemischer Präferenzen an Bedeutung. Im Bereich der Wirkstoffforschung und Materialentwicklung ist das Urteil erfahrener Chemiker, welche Moleküle aufgrund bestimmter Eigenschaften bevorzugt werden, entscheidend für den Erfolg.

Die Studie überprüfte, ob LLMs die Präferenzen von Experten nachvollziehen können, und fand heraus, dass selbst die besten Modelle oft lediglich zufällige Entscheidungen treffen. Dies signalisiert, dass die Ausprägung von intuitivem Verständnis und subjektiven Erfahrungswerten weiterhin eine menschliche Domäne ist. Die Implikationen der Untersuchung sind weitreichend. Zum einen zeigen sie, wie nützlich KI und insbesondere LLMs für die Chemie sein können, etwa als Assistenzwerkzeuge oder „Co-Piloten“ für Forscher. Sie können effizient große Mengen an Literatur verarbeiten, Vorschläge generieren oder Routineaufgaben übernehmen.

Zum anderen verdeutlichen sie, dass der Mensch nicht obsolet wird, sondern vielmehr eine stärkere Rolle bei der kritischen Bewertung und Kontrolle der KI übernimmt. Die automatisierte Erzeugung von chemischem Wissen verlangt weiterhin fundiertes Expertenwissen, um Fehlinterpretationen oder falsche Ergebnisse zu vermeiden. Ein weiterer Diskussionspunkt betrifft die Aus- und Weiterbildung in der Chemie. Da LLMs bereits viele Grundlagenfragen besser beantworten können als durchschnittliche Studierende oder selbst erfahrene Chemiker, verändert sich das pädagogische Umfeld. Ein Fokus auf reines Faktenlernen und Standardübungen könnte zukünftig weniger relevant sein, während die Förderung von kreativem Denken, kritischer Reflexion und praktischem Experimentieren wichtiger wird.

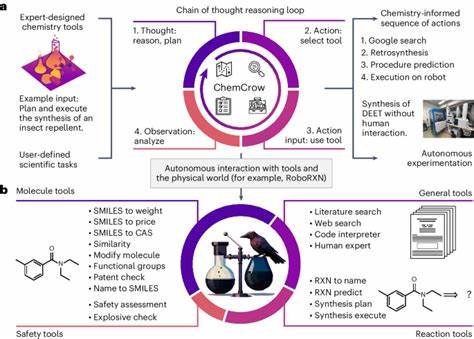

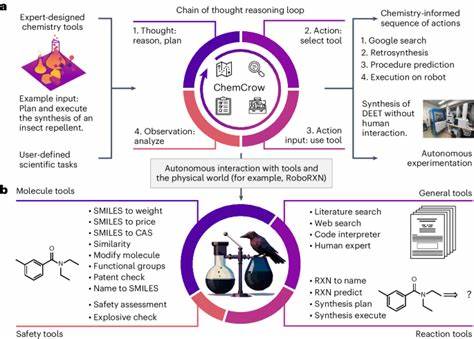

Zudem eröffnet die Integration von KI-Tools Chancen, den Lernprozess individuell anzupassen und komplexere Sachverhalte anschaulicher zu vermitteln. Neben der akademischen Welt sind auch Industrie und Forschungseinrichtungen betroffen. Die Automatisierung von Arbeitsprozessen durch KI kann die Effizienz von Laboren steigern, etwa durch automatische Reaktionsplanung oder eigenständige Durchführung von Experimenten, die von LLM-gestützten Systemen gesteuert werden. Allerdings muss dabei der verantwortungsvolle Umgang mit Risiken und die Einhaltung ethischer Standards gewährleistet sein – sowohl durch geeignete technische Maßnahmen als auch durch gezielte Schulungen der Nutzer. Zukünftige Entwicklungen werden vermutlich auf der Verknüpfung von LLMs mit spezialisierten Datenbanken basieren.

Momentan scheitern die Modelle häufig daran, präzises, aktuelles Wissen etwa zu toxikologischen Datenbanken oder industriellen Normen abzurufen. Indem man sie mit solchen Ressourcen kombiniert und zugleich deren Unsicherheiten transparent macht, können LLMs zuverlässiger und nützlicher für den chemischen Alltag werden. Auch die Erweiterung des Trainingsmaterials um qualitativ hochwertige und vielfältige chemische Informationen wird die Leistungsfähigkeit verbessern. Die vorliegende Studie leistet mit ChemBench einen wichtigen Beitrag, indem sie eine umfassende, differenzierte und öffentlich zugängliche Benchmark-Plattform bereitstellt. Diese ermöglicht es, Fortschritte bei der Entwicklung chemiespezifischer Sprachmodelle vergleichbar zu machen und auch langfristig einen Maßstab für das Zusammenspiel von menschlicher und künstlicher Intelligenz zu setzen.