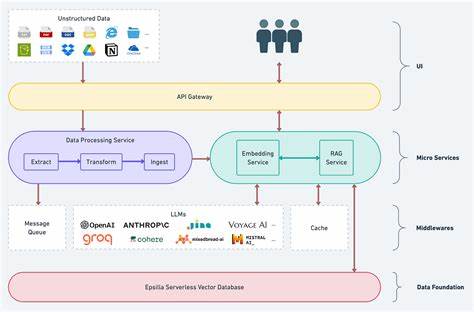

Retrieval-Augmented Generation (RAG) zählt zu den vielversprechendsten Ansätzen in der Weiterentwicklung von Sprachmodellen. Durch das Hinzuziehen externer Wissensdatenbanken ermöglicht RAG-modellierten Systemen, relevanteres und präziseres Wissen abzurufen und in die Generierung von Texten einzubinden. Dabei spielen hochdimensionale Vektor-Embeddings eine zentrale Rolle, da sie die semantische Repräsentation von Dokumenten und Anfragen ermöglichen. Doch die Speicherung und Verwaltung dieser Embeddings in herkömmlicher 32-Bit-Fließkommadarstellung (float32) verursachen enorme Speicher- und Kostenherausforderungen, insbesondere bei groß angelegten Anwendungen. Vor diesem Hintergrund gewinnt die Optimierung der Embeddings sowohl hinsichtlich Speicherbedarf als auch Effizienz zunehmend an Bedeutung.

Eine vielversprechende Strategie zur Optimierung der Speichereffizienz ist die Quantisierung. Hierbei werden die ursprünglich in high-precision float32 gespeicherten Embeddings auf niedrigere Präzisionsformate komprimiert. Die Studie von Naamán Huerga-Pérez und Kollegen auf der Basis des MTEB-Benchmarks untersucht systematisch verschiedene Quantisierungsformate, darunter float16, int8, float8 sowie binäre Formate. Interessanterweise zeigt sich, dass float8-Quantisierung eine außergewöhnliche Kompression von bis zu vierfacher Reduktion des Speicherplatzes ohne nennenswerte Einbußen der Modellleistung verursacht. Die Leistungsverschlechterung liegt dabei bei unter 0,3 Prozent, was für viele Echtzeit- und produktive Anwendungen vernachlässigbar ist.

Dabei weist float8 nicht nur einfachere Implementierungsvorteile gegenüber int8 auf, sondern übertrifft int8 auch hinsichtlich Verständnis und Einhaltung der Modellgenauigkeit. Neben der Quantisierung stellt die Dimensionsreduktion eine weitere Schlüsseltechnik zur Optimierung dar. Viele hochdimensionale Embeddings enthalten redundante oder wenig aussagekräftige Informationen, die sich durch geeignete Transformationen abmildern lassen. In der erwähnten Untersuchung werden vielseitige Methoden wie die klassische Hauptkomponentenanalyse (PCA), Kernel PCA, UMAP, Zufallsprojektionen sowie Autoencoder eingesetzt, um den idealen Kompromiss zwischen komprimierten Repräsentationen und Erhalt der Embeddings-Qualität zu finden. Insbesondere PCA erweist sich als herausragend und bietet klare Vorteile bei der Reduktion ohne wesentlichen Leistungsverlust.

Durch das Beibehalten zirka 50 Prozent der ursprünglichen Dimensionalität können die Systeme weiterhin mit hoher semantischer Präzision arbeiten. Besonders überzeugend ist die Kombination beider Techniken. Wenn moderate PCA-Anpassungen mit float8-Quantisierung zusammenwirken, ergibt sich ein beeindruckendes Speicherschrumpfungspotential von etwa dem Achtfachen bei gleichzeitig geringeren Performanceeinbußen als herkömmliche int8-Methoden. Dies unterstreicht, dass durch die parallele Nutzung von Dimensionsreduktion und Quantisierung eine Synergie entsteht, die signifikante Vorteile für den praktischen Einsatz von RAG-Systemen bietet. Die Optimierung der Embeddings-Speicherung schafft weitreichende Vorteile über rein technische Parameter hinaus.

Einerseits werden die notwendigen Hardwareanforderungen deutlich reduziert, was Kosten für Infrastruktur senkt und zudem die Umweltlast durch geringeren Energieverbrauch minimiert. Andererseits erlaubt die Verminderung der Latenzzeiten durch kompaktere Daten, dass RAG-Systeme ihre Ergebnisse schneller liefern – ein essenzieller Faktor gerade in zeitkritischen Anwendungen wie Kundenservice, Echtzeit-Übersetzung und intelligenten Assistenten. Zusätzlich tragen optimierte Embeddings dazu bei, die Skalierbarkeit der Systeme zu verbessern. RAG-Modelle profitieren davon, mehr Dokumente oder Wissensdatenbanken effizienter verwalten zu können, was wiederum die Qualität der abgerufenen Informationen und das generierte Ergebnis verbessert. Die Wettbewerbsfähigkeit moderner KI-Applikationen wird dadurch erheblich gesteigert.

In der Praxis empfiehlt sich eine Methodik, die auf der Visualisierung des Zusammenspiels von Speicherbedarf und Performance basiert. Hierbei werden unterschiedliche Kombinationen von Dimensionsreduktion und Quantisierung evaluiert, um den optimalen Punkt zu identifizieren, der bei vorgegebenen Speicherbeschränkungen die bestmögliche Modellqualität gewährleistet. Diese systematische Evaluierung erlaubt es Entwicklern, objektiv und datenbasiert Entscheidungen zu treffen, ohne sich auf bloße Faustregeln zu verlassen. Zukünftige Entwicklungen dürften sich auf noch effizientere Quantisierungsverfahren sowie auf weiterentwickelte Dimensionsreduktionstechniken konzentrieren, die speziell die Eigenschaften von Sprachmodellen berücksichtigen. Zum Beispiel können hybride Ansätze oder lernbasierte Kompressionen Flexibilität und Präzision weiter steigern.

Auch die Berücksichtigung von Anwendungsdomänen und spezifischen Wissensanforderungen wird eine wichtige Rolle spielen, um maßgeschneiderte Kompressionslösungen zu schaffen. Insgesamt zeigt die eingesetzte Kombination von Float8-Quantisierung und PCA-basierter Dimensionsreduktion, wie innovative Forschungsansätze die praktischen Herausforderungen von RAG-Systemen adressieren. Sie bieten eine reale Möglichkeit, Speicher-Engpässe zu umgehen und performante KI-gestützte Systeme für zahlreiche Anwendungsfälle zugänglicher und effizienter zu gestalten. Für Unternehmen und Entwickler öffnet sich dadurch ein breiteres Einsatzspektrum, während gleichzeitig die technischen Grenzen moderner Informationsretrieval-Modelle flexibler und nachhaltiger definiert werden. Mit steigender Popularität von Retrieval-Augmented Generation in der KI-Landschaft ist die Optimierung der Embeddings-Speicherung ein entscheidender Hebel für den Fortschritt.

Die vorgestellten Techniken bieten kosteneffektive und skalierbare Lösungen, um die Leistungsfähigkeit moderner Modelle bei reduziertem Ressourcenverbrauch zu erhalten oder gar zu verbessern. Entwickler, die diese Erkenntnisse in Ihre Projekte integrieren, sichern sich einen technologischen Vorsprung und schaffen die Grundlage für zukunftsfähige Anwendungen im Bereich der natürlichen Sprachverarbeitung und künstlichen Intelligenz.