Die Wahl der richtigen Datenbanklösung stellt für viele Unternehmen eine entscheidende Grundlage für den Geschäftserfolg dar. Mit wachsendem Datenvolumen und sich ändernden Anforderungen müssen Firmen regelmäßig überprüfen, ob ihre bestehende Datenbank den aktuellen und zukünftigen Bedürfnissen gerecht wird. Ein besonders spannendes Thema ist momentan die Migration von verteilten Datenbanklösungen wie CockroachDB hin zu klassischen, aber leistungsfähigen Systemen wie PostgreSQL. Die Erfahrungen eines Technologieunternehmens, das genau diesen Weg gegangen ist, liefern wertvolle Erkenntnisse für IT-Entscheider und Entwickler. Seit Beginn des Jahres 2022 nutzte das Unternehmen CockroachDB als primäre Datenbank.

Diese verteilte SQL-Datenbank überzeugte damals durch einfache horizontale Skalierbarkeit in Multi-Region-Setups, hohe Verfügbarkeit und eine SQL-kompatible Schnittstelle. Die Bedenken bezüglich Datenschutzanforderungen, wie der DSGVO, sowie die Skalierbarkeit mit Postgres spielten bei der Entscheidung zunächst eine große Rolle. Die Vorstellung, Daten multinational auszulegen und lokale Anforderungen zu erfüllen, sprach klar für eine verteilte Architektur. Mit dem Wachstum der Firma und einer Zunahme der Nutzungsintensität stiegen jedoch auch die Kosten und Herausforderungen. Bis 2024 hatte sich die Rechnung für CockroachDB auf fünfmal so viel gesteigert und lag im sechsstelligen Bereich.

Dabei kam hinzu, dass trotz der ursprünglichen Gründe für eine verteilte Datenbank bisher keine Kunden eine obligatorische Datenlokalisierung forderten und die Hauptlast aus einfachen transaktionalen Abfragen in einer einzigen Region bestand. In dieser Situation stellte sich die Frage, ob der hohe Preis für eine komplexe verteilte Datenbank überhaupt gerechtfertigt war. Eine wichtige technische Grundlage für die Trennung und den Vergleich der beiden Datenbanklösungen war der Einsatz eines Object-Relational-Mappers (ORM) namens Prisma. Dieser ermöglichte es, Datenbankmigrationen relativ einfach sowohl auf Cockroach als auch auf PostgreSQL parallel zu testen, wodurch die Unterschiede in Performance und Verhalten direkt sichtbar wurden. Ein zentrales Problem bei CockroachDB waren zunehmend auftretende Timeout-Fehler während der Migrationen, vor allem wenn Prisma versuchte, schemaändernde Befehle auszuführen.

Solche Zeitüberschreitungen führten oft dazu, dass Entwickler manuell und mühsam direkt im CockroachDB-Interface Migrationen blockweise ausführen mussten. Dies verursachte lange Deploy-Zeiten von bis zu zwei Stunden und große Unsicherheiten im Entwicklungsteam. Zeitweise herrschte eine solche Angst vor, dass Entwickler häufig auf Datenbankoperationen außerhalb des eigentlichen Systems ausweichten, um einen kompletten Stillstand zu vermeiden. Die Problematik ging so weit, dass das Unternehmen auf einem veralteten CockroachDB-Release 22 steckenblieb, da Migrationen durch Updates wegen der Risiken nicht durchführbar waren. Das Fehlen von Support und die lange Reaktionszeit seitens Cockroach verstärkten diese Blockade zusätzlich.

Aus diesem Grund entschied man sich letztlich, die Migration zu PostgreSQL konsequent umzusetzen und die alte Version bis zum Ende zu betreiben. Auch im Bereich ETL (Extract, Transform, Load) zeigte sich CockroachDB schwach, was besonders durch Timeouts bei Integrationsjobs deutlich wurde. Die einzige zu diesem Zeitpunkt verfügbare Lösung für eine Datenreplikation von CockroachDB war ein Airbyte-Connector in Alphastatus, welcher zusätzlich durch Speicherlecks auffiel. Selbst wenn ETL-Jobs erfolgreich waren, war die Leistungsfähigkeit oft unbefriedigend und führte zu Unterbrechungen. Die unzureichende Unterstützung für externe ETL-Tools erschwerte es zusätzlich, Daten sauber und zuverlässig zu verarbeiten.

Beim Vergleich der Abfragegeschwindigkeiten zeigten sich hingegen gemischte Resultate. Manche komplexen Anfragen wurden von CockroachDB dank ihres Optimierers deutlich schneller ausgeführt. Hier lag der Vorteil vor allem darin, dass CockroachDB bei bestimmten Aggregationen optimierte Pläne erzeugte, während PostgreSQL naive vollständige Tabellenscans durchführte, was zeitintensiv sein konnte. Allerdings trat der Vorteil oft nur unter sehr spezifischen Bedingungen auf und verschwand bei der Verwendung alternativer Query-Generatoren. Zudem gab es im täglichen Betrieb viele Fälle, in denen PostgreSQL den Performance-Vorsprung erringen konnte.

In der Praxis erzeugte der eingesetzte ORM oft sehr komplexe SQL-Abfragen, die mit zahlreichen Joins und überflüssigen Filtern versehen waren. Dies führte dazu, dass CockroachDB in vielen Fällen ineffiziente Volltabellenscans durchführte, während PostgreSQL in der Lage war, gezieltere Index- und Join-Strategien einzusetzen. Ein Beispiel zeigt eine Abfrage, die auf einem Tabelle mit Teams und verbundenen Tasks mehr als zwanzig Mal schneller auf PostgreSQL lief. Solche realen Geschwindigkeitsunterschiede machten deutlich, wie bedeutend die Wahl eines geeigneten Datenbanksystems für Anwendungen mit hohem Transaktionsvolumen ist. Neben technischen und Performance-Aspekten spielte die Nutzererfahrung auf Seiten der Entwickler eine wichtige Rolle.

Die CockroachDB-Oberfläche zeigte zum Beispiel eine verwirrende Anzeige für ungenutzte Indizes, was zeitweise bei den Entwicklern zu Fehleinschätzungen führte. Auch die Möglichkeit, lang laufende Abfragen zu canceln, war bei CockroachDB deutlich komplizierter als bei PostgreSQL. Während letztere eine einfache Abbruchfunktion in den gängigen SQL-Clients bietet, musste bei CockroachDB das Management mühselig im Konsolen-Interface erfolgen, was teilweise Systeme instabil machte. Der Kunden-Support bei CockroachDB erwies sich ebenfalls als eine Schwachstelle. Getrennte Portale, fehlende Single Sign-On Mechanismen und lange Wartezeiten belasteten die Organisation in kritischen Situationen, insbesondere bei schweren Bugs, die Produktionsumgebungen direkt beeinträchtigten.

Darüber hinaus kam es während des Betriebs immer wieder zu Netzwerkproblemen im Zusammenhang mit VPN-Verbindungen. Diese Ausfälle traten sporadisch und ohne klare Ursache auf, sowohl in der Entwicklungsumgebung als auch in produktiven Instanzen. Vergleichbare Schwierigkeiten waren bei PostgreSQL, das auf Cloud-VMs lief, nicht vorhanden, was zu einer höheren Stabilität führte. Der eigentliche Migrationsprozess von CockroachDB zu PostgreSQL erforderte ein hohes Maß an Anpassungen. Die Größe der Datenbank, insbesondere mit Tabellen, die über 100 Millionen Zeilen beinhalteten, stellte eine große Herausforderung dar.

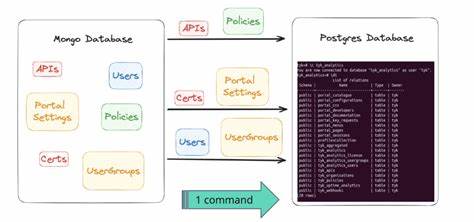

Aufgrund der fehlenden stabilen ETL-Tools wurde schließlich ein eigenes Migrationsskript in der neu aufkommenden Programmiersprache Bun entwickelt. Dieses Script extrahierte kontinuierlich die Daten tabellenweise, wandelte sie – auch aufgrund unterschiedlicher JSON- und Array-Kodierungen zwischen den Systemen – um und schrieb sie dann auf PostgreSQL ein. Der Aufwand verlangte einige Wochen an Testläufen und Feinjustierungen, aber die eigentliche Migration erfolgte schließlich innerhalb von 15 Minuten mit nur minimaler Ausfallzeit, während der das System in den Wartungsmodus versetzt wurde. Die Entscheidung, vorsichtig und kontrolliert Traffic wieder hochzufahren, sicherte einen reibungslosen Betrieb und keinerlei Datenverluste. Nach Abschluss der Migration machte sich sofort der Effekt einer schnelleren Datenbankumgebung bemerkbar.

Die aggregierten Latenzen der Anfragen sanken um rund ein Drittel und ein schnelleres und effizienteres Monitoring dank Tools der PostgreSQL-Community erlaubte die Optimierung weiterer Abfragen in kurzer Zeit. Zudem ergaben sich durch die geringeren Betriebskosten beachtliche Einsparungen, die über 110.000 US-Dollar jährlich lagen – ein beträchtlicher Gewinn für das Unternehmen. Die gesamte Umstellung wurde ein Beispiel dafür, wie auch komplexe, unternehmenskritische Datenbanksysteme durch kluge Planung, den Einsatz moderner Werkzeuge und individuellem Engagement erfolgreich transformiert werden können. Dabei bleiben gewisse Learnings für andere Firmen erhalten, die vor ähnlichen Entscheidungen stehen.

Die Wahl zwischen verteilten Datenbanklösungen wie CockroachDB und klassischen Systemen wie PostgreSQL muss situativ getroffen werden. Verteilte Systeme bieten Vorteile bei Multi-Region-Anforderungen und hoher Verfügbarkeit, der Preis und die Komplexität sollten jedoch immer mit dem tatsächlichen Anwendungsfall abgeglichen werden. Gerade wenn Daten hauptsächlich regional gehalten und einfache Transaktionen durchgeführt werden, kann PostgreSQL trotz fehlender automatischer horizontale Skalierung profitieren. Zudem sollte der gesamte Tooling-Stack berücksichtigt werden. Die ORM-Generierung von SQL-Code, die Stabilität der ETL-Tools, die Systemadministration und Nutzerfreundlichkeit wirken sich deutlich auf die Betriebseffizienz aus.

Nicht zuletzt spielen Support und Community eine Rolle, wenn es um schnelle Problemlösung und Weiterentwicklung geht. Die Erfahrungen dieser Migration zeigen, dass Unternehmen den langfristigen Nutzen durch Kostenersparnis, bessere Performance und stabile Systeme aktiv in den Fokus rücken sollten. Die Migration mag aufwendig erscheinen, bietet aber enorme Chancen, technische Schulden abzubauen und ein nachhaltig leistungsfähiges Fundament für zukünftiges Wachstum zu legen. Wer sich mit dem Gedanken trägt, seine Datenbankstrategie zu überdenken, kann von solchen Praxisberichten profitieren und sollte den Schritt wohlüberlegt planen. Eine sorgfältige Analyse der Datenbanklasten, ein iterativer Testprozess und der Einsatz bewährter Tools sorgen für eine erfolgreiche und effiziente Umstellung.

So kann PostgreSQL auch für große und komplexe Projekte eine sehr attraktive Option sein, um leistungsfähige und kluge Dateninfrastrukturen zu realisieren.