Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren viele wissenschaftliche Disziplinen beeinflusst, nicht zuletzt die Chemie. Durch die Fähigkeit, natürliche Sprache zu verarbeiten und komplexe Textinhalte zu verstehen, bieten diese KI-Systeme neue Möglichkeiten, um chemisches Wissen zugänglicher zu machen und die Forschung zu unterstützen. Doch wie gut sind diese Modelle wirklich in der Lage, chemisches Wissen zu verstehen, chemische Probleme zu lösen und wie stehen sie im direkten Vergleich zu menschlichen Chemikern? Dieser Frage widmet sich eine aktuelle, umfassende Untersuchung, die tiefgreifende Einblicke in die Leistungsfähigkeit und Grenzen moderner Sprachmodelle gibt und wichtige Erkenntnisse für Forschung, Ausbildung und Praxis liefert. Große Sprachmodelle: Ein Überblick über ihre Rolle in der Chemie LLMs sind künstliche Intelligenz-Systeme, die auf gigantischen Textdatensätzen trainiert werden und damit lernen, sinnvolle sprachliche Antworten zu generieren. Ihre Ausbildung erfolgt ohne explizite Programmierung bestimmter Fachinhalte, was sie zu universellen Problemlösern macht.

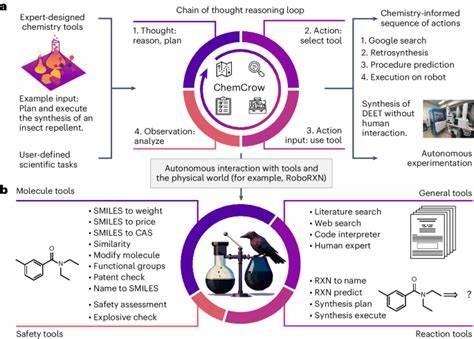

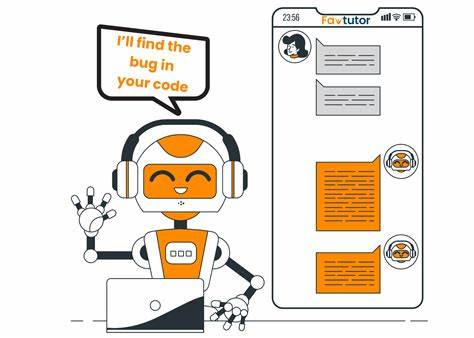

In der Chemie werden solche Modelle beispielsweise dafür verwendet, Fragen zu chemischen Eigenschaften von Molekülen zu beantworten, Reaktionsmechanismen zu erklären oder sogar neue Substanzen vorzuschlagen. Die wachsende Begeisterung fußt auf Erfolgen, die bereits in verschiedenen naturwissenschaftlichen Prüfungen, wie etwa medizinischen Lizenzprüfungen, erzielt wurden. In der Chemie sind zudem Modelle im Einsatz, die eigenständig chemische Synthesen planen oder virtuelle Experimente durchführen können. Manche Experten sprechen sogar von ersten Anzeichen künstlicher allgemeiner Intelligenz (Artificial General Intelligence, AGI), während andere auf die grundlegenden Limitierungen dieser Modelle hinweisen und sie als komplexe Muster-Erkennungssysteme sehen, die Wissen lediglich reproduzieren. ChemBench: Ein innovatives Framework zur Bewertung chemischer Fähigkeiten von LLMs Um das wahre Potential und die Schwächen von LLMs im chemischen Kontext systematisch zu erfassen, wurde ein neues Evaluierungswerkzeug namens ChemBench entwickelt.

Dieses Framework basiert auf einer umfangreichen Sammlung von fast 2.800 Frage-Antwort-Paaren, die ein breites Spektrum chemischer Themen und Schwierigkeitsgrade abdecken. Sowohl Multiple-Choice-Fragen als auch offene Aufgaben sind Teil dieser Sammlung, was ein realitätsnahes Benchmarking ermöglicht. ChemBench unterscheidet zwischen unterschiedlichen Fähigkeiten wie Wissensabruf, logischem Schlussfolgern, mathematischen Berechnungen und chemischer Intuition. Die Fragen stammen aus vielfältigen Quellen – von Lehrbüchern und Universitätsprüfungen bis hin zu selbst generierten Aufgaben.

So gewährleistet das Framework eine ausgewogene und fundierte Bewertung der Modelle im Vergleich zur menschlichen Chemikerleistung. Leistungsfähigkeit der besten Modelle im Vergleich zu menschlichen Experten Überraschend ergaben die Untersuchungen, dass die besten aktuellen LLMs in der Gesamtwertung häufig sogar besser abschnitten als die befragten Chemiker. Dies gilt insbesondere für Fragen, die auf Faktenwissen und Routineprobleme abzielen. Dabei wurde die Leistung sowohl der Modelle als auch der Menschen anhand der gleichen Fragen ermittelt, wobei menschliche Experten teilweise Zugang zu Hilfsmitteln wie Webrecherche und chemischer Software hatten. Dennoch zeigten sich deutliche Unterschiede in speziellen Bereichen.

Bei Aufgaben, die tiefgehendes Verständnis erfordern, etwa das Vorhersagen von Signalen in Kernspinresonanzspektroskopie oder die Einschätzung von Molekülkomplexitäten, liegen menschliche Chemiker oft noch vorne. Diese Erkenntnis deutet darauf hin, dass LLMs zwar viel Wissen speichern und agil abrufen können, ihnen aber die Fähigkeit zum fundierten chemischen Urteilen und zur komplexen Strukturinterpretation meist noch fehlt. Herausforderungen und Risiken im Umgang mit LLMs in der Chemie Trotz der beeindruckenden Fähigkeiten werfen die Ergebnisse auch kritische Fragen auf. So liefern manche Modelle falsche oder übermäßig selbstsichere Antworten, insbesondere bei sicherheitsrelevanten oder toxikologischen Themen. Die unzuverlässige Einschätzung eigener Grenzen erschwert die sichere Anwendung erheblich, besonders wenn Laien die KI-Systeme nutzen und nicht genügend Fachexpertise besitzen, um Aussagen zu hinterfragen.

Ein weiterer Aspekt ist die Gefahr des Missbrauchs. Technologien, die zur Konstruktion ungefährlicher Moleküle dienen, können prinzipiell auch zur Entwicklung schädlicher Stoffe genutzt werden. Dies erfordert verantwortungsvolle Regulierung, Schulung und klare technische Schutzmechanismen, um Risiken zu minimieren. Auswirkungen auf Chemieausbildung und zukünftige Forschung Die Tatsache, dass LLMs Routinewissen oft besser abrufen als Menschen, aber bei komplexen Denkprozessen schwächeln, eröffnet Perspektiven für die Gestaltung der chemischen Ausbildung. Lehrmethoden sollten verstärkt kritisches Denken und eigene Schlussfolgerungen fördern, anstatt nur Faktenwissen zu vermitteln.

Zudem sind Prüfungsformate zu überdenken, damit sie die integrativen Fähigkeiten der Studierenden besser abbilden und weniger durch Auswendiglernen geprägt sind. Für die Forschung bieten Sprachmodelle eine spannende Unterstützung. Sie können als virtuelle Assistenten wissenschaftliche Literatur durchsuchen, Hypothesen generieren oder bei der Interpretierung von Daten helfen. Die Integration von LLMs mit spezialisierten Datenbanken und Werkzeugen wird dabei eine wichtige Rolle spielen, um die Wissensbasis zu erweitern und präzisere Ergebnisse zu erzielen. Spezifische Stärken und Schwächen der Modelle in Chemie-Subdisziplinen Die Analyse des ChemBench-Frameworks zeigt, dass die Leistungsfähigkeit stark von der jeweiligen chemischen Subdisziplin abhängt.

Allgemeine und technische Chemie werden von vielen Modellen besser verstanden. In speziellen Bereichen wie der analytischen Chemie besteht großer Nachholbedarf, insbesondere bei der Struktur- und Spektreninterpretation. Chemische Intuition, also die Fähigkeit, Vorlieben oder interessante Merkmale bei Molekülen zu erkennen, stellt für LLMs eine erhebliche Herausforderung dar. Während menschliche Chemiker bei Auswahlentscheidungen eine konsistente Präferenz zeigen, sind die KI-Modelle hier oft kaum besser als zufällige Entscheidungen. Dies eröffnet Forschungsfelder zur Entwicklung von Modellen mit besserer Präferenzanpassung und Lernfähigkeit aus menschlichem Feedback.

Verlässlichkeit der Modell-Aussagen und Vertrauen in KI-Systeme Ein Kernproblem in der Nutzung von LLMs ist die mangelnde Zuverlässigkeit von Vertrauenserklärungen und Unsicherheitsabschätzungen. Selbst wenn ein Modell eine falsche Antwort gibt, kann es diese mit hoher Sicherheit ausweisen, was für den Anwender irreführend ist. Zwar gibt es Ansätze, die Modelle zur Abgabe von Konfidenzwerten zu bewegen, doch korrelieren diese Werte nicht immer mit der tatsächlichen Genauigkeit. Dieses fehlende Bewusstsein für die eigenen Grenzen erfordert eine vorsichtige Interpretation von KI-Ergebnissen und fördert die Entwicklung von Systemen, die ihre Unsicherheiten besser kommunizieren können. Hierzu gehören hybride Modelle, die klassisches maschinelles Lernen mit symbolischem und regelbasiertem Wissen kombinieren.

Die Zukunft der Chemie und KI: Chancen und Verantwortlichkeiten Die Fortschritte der LLMs im chemischen Bereich markieren einen Wendepunkt, der neue Forschungsperspektiven und Anwendungen ermöglicht. KI-unterstützte Copilot-Systeme könnten zukünftig die Arbeit von Chemikern ergänzen und beschleunigen, indem sie große Wissensmengen erfassen, Trends erkennen und innovative Vorschläge liefern. Dabei ist es essentiell, die Grenzen der Technik zu akzeptieren und die Rolle des menschlichen Experten nicht zu unterschätzen. Der kritische Denkprozess, ethische Überlegungen und die Erfahrung bleiben unverzichtbar, um Forschung verantwortungsvoll voranzutreiben. Zudem sollte die öffentliche Wahrnehmung differenziert gestaltet werden.

Die breite Verfügbarkeit von KI-basierten Werkzeugen verlangt Schulungen und klare Richtlinien, insbesondere um Fehlinformationen in sicherheitsrelevanten Fragestellungen zu verhindern. Zusammenfassend bietet die Kombination von menschlicher Chemikerexpertise und den Fähigkeiten großer Sprachmodelle ein großes Potenzial für die Chemie. Die Weiterentwicklung von Evaluierungsframeworks wie ChemBench schafft die Grundlage, diese Entwicklung transparent, sicher und effektiv zu gestalten. Die nächsten Jahre werden zeigen, wie diese Synergie das Wissen in der Chemie erweitern und neue innovative Lösungen ermöglichen kann.