In der heutigen Welt der Optimierung und Entscheidungsfindung stellen Constraint Satisfaction Problems (CSPs) eine zentrale Herausforderung dar. Diese Probleme treten in zahlreichen Bereichen auf, darunter in der Logistik, im Supply Chain Management, in der Produktionsplanung sowie in der Entwicklung von Software und Hardware. CSPs bestehen darin, eine Kombination von Variablen zu finden, die unter Beachtung bestimmter Beschränkungen (Constraints) gültig ist. Doch was passiert, wenn diese Einschränkungen widersprüchlich sind und das Problem dadurch unzulässig (infeasible) wird? Die Analyse und die Reparatur solcher Fälle stellen eine große Schwierigkeit für klassische Operations Research Methoden dar. Ein jüngst abgeschlossenes Projekt verbindet tiefgreifende Ansätze aus der Künstlichen Intelligenz – konkret Graph Neural Networks (GNNs) und Deep Reinforcement Learning (DRL) – mit Operations Research, um genau dieses Problem anzugehen.

Unzulässige Instanzen von CSPs entstehen häufig durch widersprüchliche oder inkonsistente Constraints, die verhindern, dass überhaupt eine zulässige Lösung gefunden werden kann. Das Ziel ist es dann, minimale Änderungen vorzunehmen, etwa einzelne Constraint-Bedingungen zu entfernen, um das Problem wieder lösbar zu machen. Diese Aufgabe ist anspruchsvoll, da sie systematisch nach der kleinsten Veränderung suchen muss, die zur Machbarkeit führt. Klassische heuristische Methoden liefern hier zwar Lösungsansätze, sind jedoch häufig ineffizient oder zu spezifisch für bestimmte Problemtypen. Der neuartige Ansatz formuliert die Reparatur eines unzulässigen CSPs als ein kürzester-Pfad-Problem, eingebettet in einen Markov Decision Process (MDP).

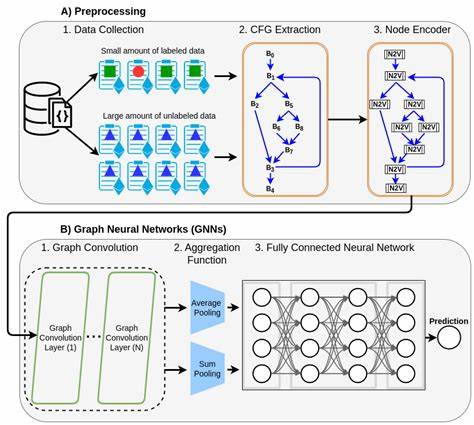

Dabei wird das Constraint-Netzwerk als bipartiter Graph dargestellt, der sowohl Variablen als auch Constraints als Knoten enthält. Diese Repräsentation erlaubt es, die komplexen Abhängigkeiten und Wechselwirkungen innerhalb des Problems anschaulich abzubilden. Aufgrund der graphbasierten Struktur eignen sich Graph Neural Networks ideal, um diese Daten sinnvoll zu transformieren und eine aussagekräftige Repräsentation der Constraints zu erstellen. GNNs können durch iterativen Nachrichtenaustausch (Message Passing) Muster in den Zusammenhängen erkennen und somit eine Grundlage für intelligente Entscheidungsfindung schaffen. In diesem Setting übernimmt ein durch Proximal Policy Optimization (PPO) trainierter Reinforcement Learning-Agent die Aufgabe, Schritt für Schritt Constraints zu entfernen.

Das Ziel ist, die kleinste Menge an Constraints zu finden, deren Entfernung das Problem wieder lösbar macht, also die Infeasibilität beseitigt. Während das Entfernen von Constraints klassisch als heuristischer Eingriff interpretiert wird, ermöglicht es der RL-gestützte Agent, automatisiert zu lernen, welche Constraints am besten entfernt werden sollten, um effizient und zielgerichtet vorzugehen. Das Training des Agenten erfolgt in simulierten Problemumgebungen, in denen er anhand von Belohnungen lernt, schnelle und möglichst kurze Pfade zur Lösbarkeit zu finden. Das Projekt zeigte, dass sich GNNs und RL hervorragend ergänzen: Graph Neural Networks erstellen kompakte, informative Zustandsrepräsentationen auf Basis der Problemstruktur, während Reinforcement Learning aus Erfahrung effektive Reparaturstrategien entwickelt. Insbesondere zwei Architekturen von GNNs wurden untersucht, die sogenannte DKA- und GCNN-Architektur, welche unterschiedliche Methoden zur Aggregation und Weitergabe von Informationen auf den Graphenknoten verwenden.

Beide Architekturen wurden in Kombination mit verschiedenen Gewichtungsstrategien der Constraints getestet, um die Flexibilität und Robustheit des Ansatzes zu gewährleisten. Die praktischen Experimente des Projekts fokussierten sowohl auf lineare Constraints in linearen Zulässigkeitsproblemen (maximal lineare Machbarkeitsprobleme, MAXFS) als auch auf die bekannte MAXSAT-Problematik, bei der boolesche Formeln in Konjunktiver Normalform auf maximale Erfüllbarkeit geprüft werden. In beiden Domänen gelang es, dass der RL-Agent lernte, problematische Constraints zielsicher zu entfernen und dabei effizientere Reparaturpfade fand als herkömmliche Baseline-Methoden. Dieses vielversprechende Ergebnis untermauert die Generalisierbarkeit der Methode auf verschiedene Problemtypen. Technisch bedeutend ist auch die Integration von Gym-ähnlichen Umgebungen für graphbasierte Zustände, die es erlauben, die Trainings- und Evaluierungszyklen der Agenten modular und reproduzierbar zu gestalten.

Darüber hinaus wurde die Trainingspipeline so gestaltet, dass sie mit Weights & Biases (wandb) zur experimentellen Nachverfolgung gekoppelt ist, was eine historische Analyse und Leistungsoptimierung ermöglicht. Neben den wissenschaftlichen Innovationen hat dieses Projekt das Potenzial, auch einen starken Einfluss auf die industrielle Praxis zu haben. In vielen realen Optimierungsproblemen führen Inkonsistenzen und Fehler in Constraint-Modellen zu erheblichen Kosten und Verspätungen. Die automatisierte und adaptive Reparatur solcher Probleme mittels KI kann sowohl die Zuverlässigkeit als auch die Effizienz von Planungs- und Steuerungssystemen signifikant verbessern. Beispielsweise in der Produktion können durch das automatische Korrigieren von unzulässigen Planungsinstanzen teure Stillstandszeiten vermieden werden.

In der Softwareentwicklung eröffnet die systematische Fehlerdiagnose bei widersprüchlichen Anforderungen neue Möglichkeiten für automatisierte Qualitätssicherung. Zukünftig lassen sich verschiedene vielversprechende Erweiterungen dieses Ansatzes denkbar. Zum Beispiel könnte die Integration von weiteren graphbasierten Lernmethoden und fortschrittlichen RL-Algorithmen weitere Verbesserungen in der Qualität der Reparaturlösungen ermöglichen. Auch die Erweiterung auf komplexere, dynamische Constraint-Systeme, bei denen sich Restriktionen im Zeitverlauf ändern, wäre eine spannende Herausforderung. Zudem könnten Transferlernverfahren implementiert werden, damit erzielte Lernerfolge auf verschiedene Problemklassen oder Anwendungsdomänen übertragbar sind.

Zusammenfassend demonstriert dieses Projekt eindrucksvoll, wie die Synergie von Graph Neural Networks und Deep Reinforcement Learning neue Perspektiven für ein traditionell schwieriges Problem im Bereich der Operations Research eröffnet. Die automatisierte Reparatur von unzulässigen Constraint-Problemen ist ein bedeutender Schritt hinsichtlich intelligenter, adaptiver Optimierungssysteme. Die Verbindung dieser modernen KI-Technologien liefert nicht nur theoretisch interessante Erkenntnisse, sondern auch praxisrelevante Werkzeuge zur Verbesserung von Entscheidungsprozessen in vielfältigen Anwendungsgebieten. Die Zukunft von Optimierung und Constraint-Handling wird durch solche interdisziplinären Innovationen nachhaltig geprägt sein.