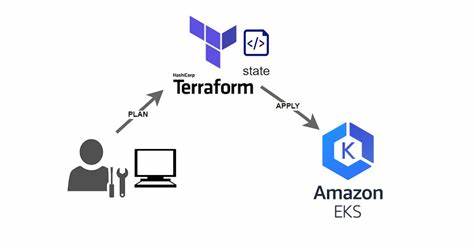

Die Einrichtung eines Kubernetes-Clusters auf Amazon Web Services (AWS) Elastic Kubernetes Service (EKS) war lange Zeit eine komplexe und zeitintensive Aufgabe, die tiefgreifendes Wissen über Cloud-Infrastruktur und Container-Orchestrierung erforderte. In der heutigen schnelllebigen IT-Welt ist jedoch der Bedarf an schnellen, sicheren und einfach zu wartenden Deployments so groß wie nie zuvor. Dank moderner Technologien und insbesondere Künstlicher Intelligenz (KI) sowie Automatisierungstools wie Terraform kann ein voll funktionsfähiges und gut konfiguriertes EKS-Cluster mittlerweile in nur etwa 10 Minuten eingerichtet werden – und das mit einem hohen Maß an Wiederverwendbarkeit und Skalierbarkeit. Die Kombination von KI-Unterstützung und Infrastructure-as-Code eröffnet ganz neue Möglichkeiten für Entwickler, DevOps-Teams und Unternehmen, die ihre Cloud-Strategie optimieren wollen. Ein entscheidender Vorteil ist dabei die Möglichkeit, den durch Terraform definierten Infrastrukturcode über verschiedene Umgebungen hinweg zu nutzen und individuell anzupassen.

Dies ermöglicht nicht nur Zeitersparnis bei der setup-Phase, sondern auch eine konsistente, nachvollziehbare und wiederholbare Infrastrukturverwaltung – ganz im Sinne von Best Practices moderner Cloud-Architekturen. Ein weiteres Plus ist die Integration von Helm Charts direkt nach dem Cluster-Setup, um typische Softwarekomponenten wie Monitoring-Lösungen, Ingress-Controller oder Sicherheitswerkzeuge problemlos auf Kubernetes zu installieren. KI-gesteuerte Tools, wie beispielsweise große Sprachmodelle (LLMs) oder spezialisierte Entwicklungsumgebungen, bieten maßgeblichen Support bei der Generierung und Validierung des Terraform-Codes, sodass Anwender ihre Projekte schneller starten und gleichzeitig Fehler minimieren können. Es gibt mehrere Wege, Kubernetes auf AWS mithilfe von AI-gestütztem Terraform zu deployen. Die Entscheidung für den richtigen Ansatz hängt maßgeblich von den individuellen Anforderungen, der vorhandenen Expertise und den langfristigen Infrastrukturzielen ab.

Wer gerade erst mit Kubernetes und AWS startet oder erste Prototypen erstellen möchte, profitiert stark von der Nutzung von KI-Sprachmodellen wie ChatGPT. Hier reicht ein intelligenter Prompt aus, um automatisch modularen Terraform-Code zu generieren, der ein EKS-Cluster in einer neuen VPC bereitstellt, Worker Nodes einbindet und die nötigen Outputs für den Zugriff auf die Kubernetes-Konfiguration bereitstellt. Dieser Einstieg fördert das Verständnis der Infrastruktur und erleichtert erste Experimente mit Cloud-nativen Technologien, ersetzt aber nicht die Notwendigkeit einer gründlichen Überprüfung und gegebenenfalls manuellen Anpassung des Codes. Fortgeschrittene Entwickler und Plattformingenieure, die ihren Infrastrukturcode kontrollieren und optimieren möchten, können von AI-basierten IDEs wie Cursor profitieren. Diese Werkzeuge ermöglichen nicht nur die automatische Codegenerierung, sondern bieten vor allem interaktive Funktionen zum Erklären, Modifizieren und Optimieren der Terraform-Definitionen direkt im Entwicklungskontext.

Dadurch lassen sich Best Practices leichter integrieren, die Sicherheit der Ressourcenzuweisungen überprüfen und gezielt Anpassungen an Cluster-Konfigurationen oder Node-Gruppen vornehmen. Der Entwicklungszyklus wird dadurch verkürzt und zugleich die Qualität der Infrastruktur gesteigert. Für Unternehmen und Teams, die keine Lust auf die komplexe Verwaltung der Infrastruktur als Code haben und stattdessen eine hochautomatisierte, production-grade Kubernetes-Plattform suchen, ist ein agentengestütztes Managementsystem wie StarOps ideal. Dieses bietet eine End-to-End-Lösung, die sämtliche Infrastrukturaufgaben übernimmt – von der Konto-Integration mit automatisierter IAM-Rollenvergabe bis hin zu wartungsfähigen Cluster-Best Practices mit eingebauten Sicherheitskontrollen. StarOps ermöglicht es, die Bereitstellung innerhalb von wenigen Minuten zu starten, ohne sich intensiv mit Terraform, CloudFormation oder Kubernetes-Interna auseinandersetzen zu müssen.

Dadurch können Teams den Fokus auf eigentliche Anwendungen legen und profitieren zugleich von 24/7-Support und regelmäßigen automatischen Updates. Bevor man sich für eine der genannten Methoden entscheidet, stehen jedoch einige Voraussetzungen, die den Erfolg des Setups sicherstellen. Grundlegend ist die Installation und Konfiguration essentieller Werkzeuge wie AWS CLI zur Kommunikation mit den AWS Diensten, Terraform als Infrastructure-as-Code-Werkzeug und kubectl als Kommandozeilen-Tool zur Verwaltung des Kubernetes-Clusters. Diese Tools bilden das Fundament zur Interaktion, Konfiguration und Überwachung der Cloud-Umgebung und müssen sorgfältig eingerichtet sein. Das Validieren der Installationen durch Versionsabfragen sorgt für Transparenz und Kompatibilität der eingesetzten Versionen.

Im ChatGPT-gestützten Ansatz wird mit einem sorgfältig formulierten Prompt gestartet, der Terraform-Konfigurationsdateien für ein EKS-Cluster erzeugt. Diese enthalten beispielsweise das übergeordnete Hauptskript main.tf, welches die Module orchestriert, variables.tf für flexible Parametrisierung, outputs.tf zur Ergebnisausgabe der Cluster-Informationen sowie spezialisierte Dateien für VPC- und EKS-Definitionen.

Im Anschluss werden die generierten Module geprüft, gespeichert und ggf. an individuelle Anforderungen angepasst. Besonders hilfreich ist das Anlegen verschiedener Variablendateien, um Entwicklungs-, Staging- und Produktionsumgebungen sauber voneinander zu trennen und spezifisch zu konfigurieren. Mit den typischen Terraform-Kommandos init, validate und apply erfolgt anschliessend die Infrastrukturprovisionierung. Die Prozedur dauert je nach Komplexität etwa 15 bis 20 Minuten, es empfiehlt sich dabei, die Ausgaben im Terminal zu verfolgen und parallel das AWS Management Console Dashboard zu nutzen.

Das Aufräumen erfolgt mit terraform destroy, um Kosten für ungenutzte Ressourcen zu vermeiden. Im Gegensatz dazu unterstützt die Cursor-Entwicklungsumgebung eine noch interaktivere Herangehensweise. Hier profitieren Anwender von Echtzeit-Codevorschlägen, integrierter Syntaxüberprüfung und direkter Validierung, die eine iterative Verbesserung der Infrastrukturdefinition begünstigen. Die KI verarbeitet Änderungswünsche, erklärt Codebestandteile und gibt Sicherheitsempfehlungen, was sowohl die Entwicklungszeit reduziert als auch die Codequalität erhöht. Die einfache Integration von Terraform-Befehlen im integrierten Terminal rundet die Toolchain ab und macht den gesamten Workflow flüssiger.

Für Endanwender, die eine möglichst unkomplizierte Lösung wünschen, bietet StarOps einen klaren Mehrwert. Durch die automatisierte AWS-Kontoanbindung wird aufwendiges Rollen- und Berechtigungsmanagement eliminiert, da die Plattform gängige Sicherheitsstandards automatisch berücksichtigt. Die Auswahl und Konfiguration der gewünschten Komponenten erfolgt über eine intuitive Benutzeroberfläche, die Empfehlungen für Monitoring, Sicherheitslösungen und wichtige Kubernetes-Add-ons enthält. Nach der Freigabe übernimmt StarOps alle weiteren Schritte, liefert einen Cluster-Überblick und garantiert kontinuierliche Wartung und Support. Anwender sparen sich somit administrative Aufwände und profitieren von einer stabilen, sicheren und produktionstauglichen Umgebung.

Der Einsatz von wiederverwendbarem Terraform-Code in Kombination mit KI-Technologien revolutioniert die Art und Weise, wie Kubernetes-Installationen auf AWS realisiert werden. Neben der deutlichen Beschleunigung des Setups bieten diese Methoden auch Vorteile hinsichtlich Flexibilität, Anpassbarkeit und langfristiger Wartbarkeit. Durch modulare Strukturen lassen sich Infrastrukturkomponenten schnell an neue Anforderungen anpassen, und die Standardisierung verringert Fehlerpotenziale. Zudem ermöglicht die Integration von Helm nach dem Cluster-Deployment die automatisierte Bereitstellung wichtiger Zusatzsoftware, was den Betrieb weiter vereinfacht. Unternehmen, die schneller auf sich ändernde Marktanforderungen reagieren wollen, profitieren besonders von diesen Innovationen.

Die Implementierung einer solchen modernen Infrastruktur erfordert zwar initiale Lernbereitschaft, zahlt sich jedoch durch höhere Effizienz, bessere Sicherheit und Skalierbarkeit aus. Letztendlich steht das Ziel im Vordergrund, die Anwendungsentwicklung zu beschleunigen, Kosten zu optimieren und gleichzeitig eine zuverlässige Plattform mit allen notwendigen Sicherheits- und Compliancefunktionen zur Verfügung zu stellen. Zusammenfassend lässt sich sagen, dass die Kombination von Terraform, Kubernetes EKS und KI-basierter Unterstützung das Deployment von Cloud-Infrastruktur grundlegend vereinfacht und professionalisiert. Ob man als Anfänger Schritt für Schritt mit ChatGPT startet, als erfahrener Entwickler mit Cursor interaktiv konfiguriert oder als Unternehmen auf eine vollautomatisierte Plattform wie StarOps setzt – für jedes Bedürfnis und Know-how-Niveau gibt es passende Lösungen. Der Schlüssel zum Erfolg liegt dabei in der effizienten Nutzung von Automatisierung und künstlicher Intelligenz, welche das unverzichtbare Fundament der modernen Cloud-Infrastruktur bilden.

Ein schneller Einstieg ermöglicht neue Freiräume, sich auf Geschäftslogik und Innovationen zu konzentrieren, anstatt wertvolle Zeit mit manueller Setup-Arbeit zu verbringen. Wer diese Entwicklung frühzeitig nutzt, kann seinen Wettbewerbsvorteil erheblich steigern und zukunftsfähige Kubernetes-Umgebungen auf AWS nachhaltig realisieren.