In einer Welt, in der Daten und Kommunikation immer stärker digitalisiert werden, ist IT-Sicherheit zum zentralen Thema geworden. Ob es um Passwörter, Verschlüsselungsschlüssel oder die Authentifizierung von Benutzern geht – der Schutz digitaler Geheimnisse ist nur so stark wie die Zufallszahlen, auf denen kryptografische Verfahren beruhen. Eine zentrale Herausforderung dabei ist, wirklich unvorhersehbare und nicht reproduzierbare Zufallszahlen zu generieren. Diese sogenannte Entropie bildet die Grundlage, um Angreifern das Erraten oder Berechnen von Schlüsseln nahezu unmöglich zu machen. Die Anforderungen an Zufälligkeit für Sicherheitszwecke sind weitreichend und beinhalten eine Vielzahl von technischen und konzeptionellen Herausforderungen.

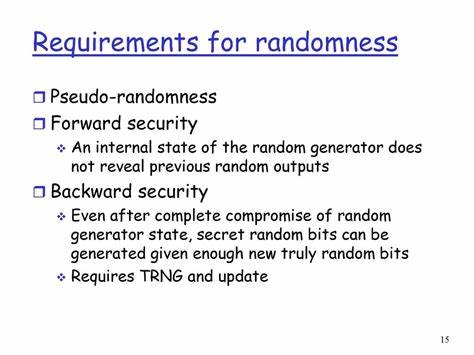

Moderne Sicherheitsverfahren basieren auf ausgefeilten mathematischen Algorithmen, die theoretisch Angriffe wie Mustererkennung oder Analyse unmöglich machen. Allerdings können sie nur so sicher sein, wie die geheimen Werte, die sie verwenden, beispielsweise Passwörter oder kryptografische Schlüssel. Diese Werte müssen aus einer Quelle stammen, die genug Zufälligkeit – Entropie – enthält, um für gut ausgestattete und motivierte Angreifer nicht vorhersehbar zu sein. Heutige Probleme entstehen dadurch, dass viele Systeme auf pseudozufällige Methoden zurückgreifen, die zwar statistisch Zufälligkeit vortäuschen, aber im Kern deterministisch arbeiten. Angreifer mit Einblick in den Aufbau oder die Startwerte solcher Systeme können deutlich einfacher sämtliche „zufälligen“ Werte vorhersagen als angenommen.

Damit Sicherheitssysteme effektiv sind, sind authentische Zufallsquellen nötig, die echte Unvorhersagbarkeit garantieren. Idealerweise stammen diese aus Hardware-Komponenten, die physikalische Prozesse ausnutzen, etwa thermisches Rauschen oder mechanische Zufälligkeiten. Dabei sind die Anforderungen an die Menge an Entropie vergleichsweise gering, moderne Algorithmen wie AES kommen mit Schlüssellängen von 128 oder 256 Bit aus. Übersetzt auf Entropie bedeutet dies, dass einige hundert Bits vollkommen ausreichend sind, wenn sie wirklich zufällig sind. Zur Veranschaulichung: Eine hochsichere Verschlüsselung erfordert rund 200 Bits an Entropie, was im Alltag durch geeignete Hardware quasi problemlos zu erzeugen ist.

Viele Systeme verfügen bereits über Hardware, die als Entropiequelle dienlich sein kann. Beispielsweise erzeugen Mikrofoneingänge ohne angeschlossenes Gerät oder Video-Eingaben mit verdecktem Objektiv echtes Rauschen, das als Zufallsquelle genutzt werden kann. Ebenso ist die unregelmäßige Drehgeschwindigkeit von Festplatten durch luftbedingte Turbulenzen ein interessanter Ansatzpunkt für Zufallsdaten. Selbst die Geräusche und Verzögerungen beim Lesen und Schreiben auf Festplatten bieten eine überraschend gute Basis für Entropiesammlung, wenn sie entsprechend verarbeitet werden. Darüber hinaus können spezielle Schaltungen, sogenannte Ringoszillatoren, die aus verketteten logischen Gattern bestehen, zur Schaffung von Zufälligkeit genutzt werden.

Diese Oszillatoren laufen frei und erzeugen Taktunterschiede, die bei Abtastung echten Zufallswerten entsprechen – vorausgesetzt, sie werden korrekt entkoppelt, um unerwünschte Synchronisation zu vermeiden. Ihre Verarbeitung verlangt eine sorgfältige digitale Nachbearbeitung, die sogenannte Entskewung, um systematische oder verzerrte Muster aus dem Rohsignal zu entfernen und einen möglichst gleichmäßigen Zufallsstrom zu erhalten. Neben der Hardware sind auch „Softwarequellen“ für Zufälligkeit denkbar, wenn auch eher als Ergänzung. Beispiele sind Systemuhren, Tastatureingaben oder Mausklicks. Diese liefern jedoch meist inhomogene und potenziell vorhersagbare Werte, weshalb hier besondere Vorsicht und geeignete Mischverfahren nötig sind.

Netzwerkanfragen oder ähnliches bieten prinzipiell ebenfalls Zufallsinput, können allerdings durch gezielte Manipulation von Außenstehenden beeinflusst werden, weshalb auch hier kein ungeteiltes Vertrauen bestehen sollte. Entskewung ist einer der wichtigen Schritte zur Qualitätssicherung des Zufallsstroms. Rohdaten enthalten oft schiefe Verteilungen mit zu vielen Einsen oder Nullen oder korrelierte Bitmuster. Verfahren wie das Berechnen der Parität über mehrere Bits, Übergangsabbildungen nach von Neumann oder komplexere mathematische Transformationen stellen sicher, dass diese Verzerrungen beseitigt werden. Auch reversible Kompressionsverfahren können helfen, die Daten zu „konzentrieren“ und so die tatsächlich enthaltene Entropie sichtbarer und nutzbarer zu machen.

Um die aus den verschiedenen Quellen gesammelten Daten zu einer wirklich robusten Zufallsquelle zu verarbeiten, ist die Verwendung starker Misch- bzw. Hashfunktionen unumgänglich. Moderne Kryptosysteme wie AES oder Hashalgorithmen der SHA-Familie liefern exakt die nötige Komplexität und nichtlineare Vermischung, die einzelne Quellen mit niedrigem oder inkonsistentem Entropiegehalt gemeinsam stark machen. Auf diese Weise kann selbst dann noch eine sichere Zufallszahl entstehen, wenn einzelne Quellen anfällig oder teilweise vorhersagbar sind. Für Systeme ohne dedizierte Hardwarezufallsgeneratoren gibt es bewährte und weit verbreitete Lösungen, wie das Linux-Gerät /dev/random, das verschiedene Quellen zusammenführt und nur Zufallsdaten liefert, wenn genügend Entropie vorhanden ist.

Es blockiert oder wartet also, bis verlässlich starkes Material gesammelt wurde. Eine alternative Schnittstelle, /dev/urandom, liefert auch bei reduzierter Entropie kontinuierlich Daten und eignet sich eher für weniger sicherheitskritische Anwendungen oder temporäre Schlüssel. In der Windows-Welt bietet der CryptGenRandom-Aufruf eine vergleichbare Funktionalität, bei der ebenfalls mehrere Systemquellen zur Entropiegewinnung genutzt und per Hashing gemischt werden. Moderne .NET-Implementierungen integrieren diese Funktionalitäten in die Klassenbibliothek und machen den Vorgang für Entwickler komfortabel verfügbar.

Neben der reinen Erzeugung von Zufallsdaten ist auch der sichere Umgang mit diesen Werten ein wichtiges Thema. Pseudozufallszahlen müssen so berechnet werden, dass selbst bei Kenntnis einiger Werte im Nachhinein nicht auf vorherige oder zukünftige Werte geschlossen werden kann. Das bedeutet, dass der interne Zustand eines Pseudozufallszahlengenerators geheim gehalten werden muss und nur mit kryptografisch geprüften Methoden (beispielsweise HMAC-SHA) verarbeitet werden sollte. Solche Konstrukte gewährleisten, dass der Startwert (Seed) die gesamte Sicherheit liefert, während der Generator in der Folge effiziente und sichere Ausgaben erstellt. Erkenntnisse über schlechte Praxis sind ebenso wichtig: Komplexe, aber ungesicherte Pseudozufallszahlengeneratoren, die auf einfachen Seeds oder festen Startzuständen basieren, bieten keinerlei Sicherheit.

Ein Angreifer mit Wissen über den Algorithmus und eine eingrenzbare Auswahl möglicher Seeds kann so genannte Schlüsselräume auf wenige hundert Möglichkeiten reduzieren – ein echtes Sicherheitsrisiko. Ebenso problematisch ist die Auswahl von Zufallszahlen aus großen öffentlich zugänglichen Datenbanken, bei der die Entropie allein in der Auswahl des Startpunktes liegt, während der eigentliche Inhalt oft gut bekannt oder vorhersehbar ist. Die reine statistische Zufälligkeit garantiert keine Sicherheit. Ein Bitstrom kann aufgrund korrekter Verteilung für Zufall gehalten werden, dabei aber vollständig vorhersagbar sein. Nur Unvorhersagbarkeit im Sinne der Informations- und Min-Entropie sichert wirklichen Schutz gegen erratbare Werte.

In puncto Schlüsselgröße ist das Maß der anvisierten Sicherheit entscheidend. Für mittlere Sicherheitsanforderungen genügen Passwörter oder Schlüssel mit rund 30 bis 40 Bits an Entropie. Wird maximale Sicherheit angestrebt, so empfehlen Experten derzeit Schlüssel mit mindestens 80 bis 128 Bits. Die genaue Länge hängt von Faktoren wie der erwarteten Rechenleistung eines Angreifers, möglichen Angriffsmethoden und erwarteter Nutzungsdauer ab. Zudem gibt es „Meet-in-the-middle“ Angriffe und mögliche parallele Brute-Force-Versuche, die den effektiven Sicherheitslevel mindern und längere Schlüssel erfordern.

Dies verdeutlicht, dass die an die Zufälligkeit gestellten Anforderungen nicht nur auf die Quellen und Algorithmen, sondern auch auf den Auftraggeber und dessen Sicherheitsbedürfnisse zugeschnitten sein müssen. Wer hochsichere Verschlüsselung will, kommt an guten Hardwarerandomquellen und kryptographisch geprüften Pseudozufallszahlengeneratoren nicht vorbei. Wer nur kurzfristig datenverarbeitende Prozesse absichert, hat oft mehr Spielraum. Zusammenfassend zeigt sich, dass Zufälligkeit das Herzstück sämtlicher Sicherheitssysteme ist. Von der Erzeugung der Schlüssel bis zur Auswahl der Passwörter muss gewährleistet sein, dass die verwendeten Zahlengerüste nicht reproduzierbar oder schätzbar sind.

Moderne IT-Systeme verfügen häufig über geeignete Hardwarequellen, etwa Mikrofonrauschen oder Datenträger-Timings, deren Entropie sich mit effizienten Algorithmen zu qualitativ hochwertigen Zufallszahlen veredeln lässt. Wo Hardware fehlt, bieten Softwaretechniken in Kombination mit benutzergenerierter Entropie moderate Sicherheit, sollten aber immer durch starke Misch- und Hashfunktionen ergänzt werden. Nur durch eine konsequente Berücksichtigung der Zufalls-Anforderungen kann IT-Sicherheit auf Dauer gewährleisten, dass Angreifer keine Schwachstellen durch vorhersagbare Schlüssel oder Passwörter ausnutzen können und unsere digitalen Informationen bestmöglich geschützt bleiben.

![The Design Change That Took 114 Lives [video]](/images/6BF69691-634B-40CE-B3D4-306C104EDCB3)