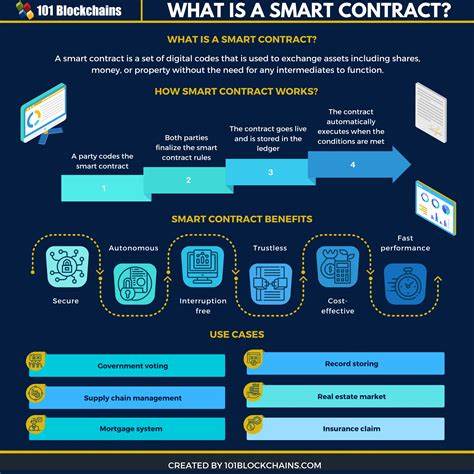

In der heutigen datengetriebenen Welt sind effiziente und zuverlässige Prozesse zur Datenextraktion, -transformation und -ladung (ETL) von zentraler Bedeutung. Unternehmen stehen vor der Herausforderung, Daten aus diversen Quellen in unterschiedlichen Formaten zusammenzuführen und für Analyse- und Reportingzwecke aufzubereiten. Genau hier setzt onETL an – ein modernes Python-basiertes ETL-Tool, das viele Lücken in herkömmlichen Lösungen füllt und sich flexibel an verschiedene Anwendungsfälle anpassen lässt. Dabei verbindet onETL die Stärken von Apache Spark mit spezialisierten Konnektoren und plug-in Mechanismen und ermöglicht so eine zentrale Steuerung heterogener Datenflüsse.Die Entwicklung von onETL verfolgt den Anspruch, ein universelles Werkzeug zu schaffen, das unterschiedlichste Datenquellen und Ziele unterstützt – vom relationalen Datenbankmanagementsystem über Cloud-Speicher bis hin zu klassischen Datei- und verteilten Dateisystemen.

Das Ergebnis ist eine umfassende Bibliothek, die mit wenigen Zeilen Code den komplexen Prozess des Datenhandlings dramatisch vereinfacht und zugleich maximale Flexibilität bietet. Anders als umfassende Frameworks macht onETL keine Vorgaben bezüglich Projektstruktur oder Ausführungsmodellen, weshalb es sich nahtlos in verschiedenste Umgebungen und Systeme integrieren lässt.Ein wesentlicher Vorteil von onETL ist die Einbindung von Apache Spark als engine für Transformationen. Dadurch können Daten auf Basis des leistungsfähigen Spark DataFrame API effizient verarbeitet, skaliert und in unterschiedlichen Formaten gelesen und geschrieben werden. Der Einsatz von Spark erlaubt eine flexible Handhabung großer Datenmengen sowie die Nutzung verteilter Rechenkapazitäten.

Gleichzeitig ergänzt onETL Spark um Funktionen, die in der Basisversion fehlen, wie beispielsweise ausgefeilte Strategien für inkrementelles Lesen oder spezifische Schnittstellen zu verschiedenen Datenbanken und Dateisystemen.Die unterstützten Datenquellen und -ziele erstrecken sich über eine breite Palette renommierter Technologien. Dazu zählen unter anderem relationale Datenbanken wie MSSQL, Postgres, Oracle und Teradata. Für Big Data und verteilte Systeme werden Hive, Greenplum und HDFS unterstützt sowie der Zugriff auf Kafka Streams ermöglicht. Auch Cloud-Speicher wie Amazon S3 und Minio sowie Protokolle wie SFTP, FTP, FTPS, WebDAV und Samba gehören zum Portfolio.

Zudem gibt es spezialisierte Konnektoren für NoSQL-Datenbanken wie MongoDB. Dieses breite Ökosystem macht onETL zu einem universell einsetzbaren Werkzeug für Unternehmen mit heterogenen Datenlandschaften.onETL legt großen Wert auf den kontrollierten und sicheren Zugriff auf Datenquellen. Dazu stellt das Tool Methoden bereit, mit denen nicht nur Daten gelesen und geschrieben, sondern auch Datenbank-spezifische Operationen ausgeführt werden können – wie SQL-Queries, DDL- und DML-Operationen sowie das Aufrufen von Funktionen und Prozeduren. Dieser erweitere Zugriff erlaubt den Anwendern, ELT-Pipelines aufzubauen, bei denen die Transformation direkt innerhalb der Datenbank erfolgt und nur die finalen Resultate weiterverarbeitet werden.

Ein weiteres Highlight ist das flexible Strategie-System für Datenimporte, das inkrementelles Laden, Batch-Verarbeitung und verschiedene Grenzwerte abdecken kann.Neben der reinen Funktionalität überzeugt onETL durch ein ausgefeiltes Plugin- und Hook-System, mit dem Entwickler das Verhalten interner Klassen an eigene Anforderungen anpassen können. Dieses Design fördert die Erweiterbarkeit und ermöglicht individuelle Anpassungen ohne Modifikation des Kerncodes. So können beispielsweise bei besonderen Transformationsschritten oder speziellen Anforderungen an das Fehler-Handling eigene Klassen und Funktionen nahtlos integriert werden.Die Installation und Einrichtung von onETL sind vergleichsweise unkompliziert gestaltet.

Für die Basisinstallation genügt der Python-Package-Manager pip, wobei mindestens Python 3.7 erforderlich ist. Ebenso muss Java ab Version 8 installiert sein, da Spark auf der Java Virtual Machine aufbaut. Wer die Spark-Integration nutzt, installiert onETL mit den entsprechenden Extras, die die PySpark-Abhängigkeiten mitliefern. Für die Anbindung an unterschiedliche Speicher- und Datei-Systeme werden bei Bedarf zusätzliche Python-Clients eingebunden, etwa Paramiko für SFTP oder pysmb für Samba.

Wer höchste Ansprüche an Sicherheit stellt, findet im Paket auch Unterstützung für Kerberos-Authentifizierung, die in vielen Hadoop-Umgebungen Standard ist.Besonders hervorzuheben ist die Unterstützung verschiedener Betriebssysteme und die Kompatibilität der Komponenten. Die Spark-Versionen, Python-Versionen und Java-Versionen sind in einer klar definierten Kompatibilitätsmatrix festgehalten, wodurch Anwender mühelos die passende Kombination für ihre Infrastruktur wählen können. Dies minimiert Implementierungsprobleme und sorgt für stabiles Setup. Die Aktivität in der Community sowie kontinuierliche Updates mit zahlreichen Releases zeugen von einer aktiven Weiterentwicklung, was gerade in so dynamischen Bereichen wie Big Data und ETL ein wichtiger Faktor ist.

In der Praxis bietet onETL vielfältige Anwendungsmöglichkeiten, die von einfachen Datenmigrationsprozessen bis hin zu komplexen ETL-Prozessen für analytische Data-Warehouses reichen. Häufige Use Cases zeigen, wie Daten aus klassischen relationalen Datenbanken wie MSSQL extrahiert, mit Spark transformiert und schließlich in Hive oder Postgres geladen werden. Darüber hinaus lassen sich Dateien von entfernten Servern via SFTP herunterladen, lokal verarbeiten und dann in Hadoop Distributed File System (HDFS) laden. Auch der direkte Zugriff auf Cloud-Speicher wie Amazon S3 zur Verarbeitung großer Datenmengen ist realisierbar. Diese Flexibilität macht onETL zum unverzichtbaren Werkzeug für Data Engineers, die robuste und skalierbare Pipelines realisieren wollen.

Ein Beispiel aus der Praxis verdeutlicht den Workflow: Ein Unternehmen möchte regelmäßig Kundendaten aus einer MSSQL-Datenbank auslesen, ohen großen Aufwand bestimmte Transformationen durchführen und die Daten anschließend für komplexe Analysen in Hive ablegen. Mit onETL lässt sich eine solche Pipeline schnell implementieren. Die Anbindung an MSSQL erfolgt über den bereitgestellten Connector, dann werden die abgerufenen Daten mittels Spark DataFrame API verarbeitet, etwa für Filter, Berechnungen oder Datentypanpassungen. Abschließend werden die transformierten Daten mit der Hive-Verbindung in das Data-Warehouse überführt – alles gesteuert in Python und gut nachvollziehbar.Ein weiteres Praxisbeispiel betrifft den Umgang mit Remote-Dateisystemen.

onETL ermöglicht unkomplizierten Download von Dateien beispielsweise aus einem SFTP-Server, mit Filterfunktionen wie Glob-Mustern oder Ausschluss bestimmter Verzeichnisse. Die lokalen Dateien können dann, wenn gewünscht, vor dem erneuten Upload ins verteilte Dateisystem bearbeitet werden. Das Fehlerhandling unterstützt dabei, sowohl fehlgeschlagene als auch bereits vorhandene Dateien korrekt zu behandeln. Die Möglichkeit, Dateien nach erfolgter Verarbeitung lokal zu löschen oder umzubenennen, erhöht die Automatisierung und sorgt für sauberen Workflow.Im Bereich Cloud lassen sich mit onETL große Mengen von CSV-Dateien, Parquet oder anderen Formaten direkt aus S3 lesen und in Spark DataFrames überführen.

Unterstützt werden dabei umfangreiche Schema-Definitionen und Datei-Parsing-Optionen wie Delimiter, Encoding oder Header-Management. Nach der Transformation können die Daten zielgerichtet in Datenbanken wie Postgres geschrieben werden. Durch diesen Workflow wird ein schneller und nahtloser ETL-Prozess gewährleistet, der besonders in Cloud-first-Architekturen an Bedeutung gewinnt.Wer sich für onETL als Tool entscheidet, erhält nicht nur ein mächtiges ETL-Werkzeug, sondern auch eine Basis für nachhaltige und flexible Datenarchitekturen. Die offene Architektur erlaubt es Teams, onETL modular in bestehende Systeme zu integrieren und gezielt an eigene Bedürfnisse anzupassen.

Auch die Trennung von ETL-Logik und Orchestrierung bleibt erhalten, da onETL bewusst nicht an Scheduling- oder Workflow-Manager gebunden ist. Dadurch bleibt maximale Freiheit in der Wahl von Technologien wie Apache Airflow oder Prefect zur Steuerung der Jobausführung.Abschließend lässt sich festhalten, dass onETL eine überzeugende Antwort auf die Herausforderungen moderner Datenintegration ist. Mit einem umfassenden Set an Konnektoren, der Integration von Spark für Transformationen und einem Fokus auf Flexibilität, Erweiterbarkeit und Plattformunabhängigkeit schließt onETL eine bedeutende Marktlücke. Für Data Engineers, die eine robuste, wartbare und skalierbare Lösung suchen, stellt onETL eine äußerst attraktive Option dar, die sich in vielfältigen Branchen und Anwendungsfällen bewährt.

Wer effiziente ETL-Prozesse mit modernen Technologien realisieren möchte, findet in onETL ein Werkzeug, das sowohl pragmatisch als auch zukunftssicher ist – eben das eine Tool to rule them all.