In den letzten Jahren haben viele Unternehmen die Notwendigkeit erkannt, ihre Datenbanklandschaften zu überdenken, um mit wachsendem Geschäft und steigenden Anforderungen Schritt halten zu können. Die Wahl der richtigen Datenbank-Funktionalität und Architektur ist dabei entscheidend für Performance, Skalierbarkeit und Gesamtkosten. Ein besonders interessantes Beispiel ist die Migration von CockroachDB zu PostgreSQL, wie sie Motion, ein innovatives Softwareunternehmen, erfolgreich gemeistert hat. Dabei zeigt sich, dass kostenintensive verteilte Datenbanken nicht immer die beste Lösung sind und klassische relationale Systeme wie PostgreSQL durch ihre Reife und Flexibilität oft ein überzeugendes Gesamtpaket bieten. Die Ausgangssituation bei Motion war geprägt von der Nutzung von CockroachDB seit Anfang 2022.

Diese verteilte Datenbank überzeugte zunächst durch entlanggehende Skalierbarkeit, ideal für Multi-Region-Setups, und ein hohes Maß an Verfügbarkeit. Besonders regulatorische Vorgaben wie die Datenschutzgrundverordnung (GDPR) machten ein solches Setup zunächst sehr attraktiv. Doch mit dem Unternehmenswachstum stiegen auch der Datenverbrauch und die Kosten rapide an. Bis 2024 hatte sich die Rechnung für CockroachDB auf einen mittleren sechsstelligen Bereich verfünffacht, obwohl die tatsächliche Nutzung und Komplexität der Datenbankabfragen überwiegend einfach und regional begrenzt war. Dies warf die Frage auf, ob eine stark verteilte Datenbankarchitektur in einer einzigen Region mit simplen Transaktionsanfragen wirklich von Vorteil ist oder ob eine traditionelle, lokal ausgelegte Lösung kosteneffizienter sein kann.

Die Hürden bei CockroachDB begannen sich dabei nicht nur bei den Kosten zu zeigen. Technische Schwierigkeiten traten vor allem bei der Migration und der Änderungsverwaltung auf. Das Entwicklertool Prisma, das als Object-Relational Mapping (ORM) verwendet wird, geriet immer wieder an seine Grenzen und reagierte mit Zeitüberschreitungen bei der Anwendung von Migrationsskripten. Die manuelle Durchführung dieser Änderungen war zwar möglich, bedeutete aber erhebliche zusätzliche Betriebskosten und verzögerte Deployments. In einem Vergleich mit PostgreSQL zeigte sich deutlich die Überlegenheit des klassischen Datenbanksystems.

Eine identische Migration, ausgeführt auf einer kopierten Datenbank, dauerte hier nur einige Sekunden im Vergleich zu den langen Wartezeiten bei CockroachDB. Die daraus resultierenden Verzögerungen und Unsicherheiten führten sogar zu operativen Workarounds, bei denen Entwickler aus Angst vor Systemausfällen Datenbankänderungen außerhalb des üblichen Weges durchführte. Dies wurde insbesondere bei CockroachDB-Updates zum Problem. Das Unternehmen blieb auf einer veralteten Version 22 hängen, was den erhofften Support erschwerte und die Stabilität beeinträchtigte. Neben dem direkten Betrieb hatten auch Integration und Datenverarbeitung im Hintergrund mit Problemen zu kämpfen.

ETL-Prozesse (Extract, Transform, Load), die für das kontinuierliche Einspielen und Aufbereiten von Daten nötig sind, litten unter regelmäßigen Timeouts und Fehlern. Die Nutzung einer Alpha-Version eines Airbyte-Connectors für CockroachDB war anfällig für Speicherlecks und instabile Verbindungen, was die Hoffnung auf reibungslose und skalierbare Datenintegration deutlich einschränkte. Hinsichtlich der Abfragegeschwindigkeiten zeigte sich ein differenziertes Bild. Zwar gab es einzelne Abfragen, bei denen der CockroachDB-Optimizer durch spezielle Aggregationsstrategien schneller war. Doch im Alltag überwogen Szenarien, in denen PostgreSQL deutlich performanter auftrat.

Komplexe SQL-Generierung durch Prisma führte bei CockroachDB zu vollen Tabellen-Scans, die die Antwortzeiten massiv verlängerten. Ein reales Beispiel veranschaulichte diesen Unterschied eindrucksvoll: Bestimmte zusammengesetzte Abfragen liefen in PostgreSQL teils bis zu zwanzigmal schneller als in der verteilten Datenbank. Solche Geschwindigkeitsvorteile auf Seiten von PostgreSQL resultierten häufig aus einer effizienteren Nutzung von Indizes und Optimierungen durch die sehr ausgereifte Postgres-Abfrageplanung. Zusätzlich ergaben sich mit CockroachDB auch zahlreiche Herausforderungen in der täglichen Nutzungserfahrung. Die Bedienoberfläche zeigte zum Beispiel Unstimmigkeiten bei der Bewertung von Indizes, was Entwickler verwirrte und zu Fehlentscheidungen bei der Datenbankstruktur führte.

Aufwändige Queries ließen sich in CockroachDB nur schwer abbrechen, während dies in PostgreSQL normalerweise mit wenigen Klicks erledigt werden kann. Ein weiterer Kritikpunkt war der Support. Die Abläufe waren kompliziert und verzögerten die Reaktion besonders in kritischen Situationen. Nicht zuletzt gab es technische Verbindungsprobleme, insbesondere bei der Nutzung von Tailscale innerhalb von CockroachDB-Setups, die zeitweise zu nicht erklärbaren Ausfällen führten und das Entwicklerteam stark belasteten. Der eigentliche Migrationsprozess hin zu PostgreSQL war eine umfangreiche technische Herausforderung.

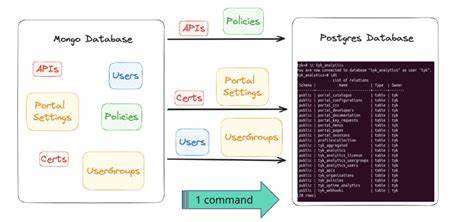

Zunächst galt es, ein Medium zu schaffen, das den Transfer von Hunderten Millionen Zeilen reibungslos und performant bewältigen konnte. Da die verfügbaren ETL-Tools für CockroachDB noch in einem frühen Entwicklungsstadium waren und nicht zuverlässig funktionierten, entschied sich Motion zur Entwicklung einer eigenen Lösung auf Basis des noch jungen JavaScript-Runtimes Bun. Diese Lösung arbeitete mit Datenstreams im CSV-Format, die schrittweise aus CockroachDB exportiert und direkt in PostgreSQL eingespielt wurden. Eine besondere Hürde stellte die unterschiedliche Codierung von Datentypen, insbesondere JSON- und Array-Daten dar. Es mussten spezielle Anpassungen und Parsingschritte implementiert werden, um die Daten ohne Informationsverlust und Kompatibilitätsprobleme zu transformieren.

Die eigentliche Migration wurde mit größtmöglicher Sicherheit durchgeführt: Ein extra großer virtueller Server wurde angemietet, eine Wartungszeit mit deaktiviertem Nutzerzugriff angesetzt, und die Übertragung lief in einer einzigen Sitzung ab. Die Dauer von etwa 15 Minuten überraschte angesichts des Datenvolumens positiv und zeigte den Nutzen der guten Vorbereitung. Die anschließende Wiederinbetriebnahme erfolgte schrittweise, um etwaige Risiken weiter zu minimieren. Direkt nach der Migration ließen sich erste signifikante Verbesserungen messen. Die Anfragenzeiten aller Endpunkte verbesserten sich um etwa ein Drittel.

Dank der leistungsfähigen Werkzeuge im Postgres-Ökosystem wie PGAnalyze konnten weitere Abfragen schnell optimiert werden, was zu weiteren Performancegewinnen führte. Ein zusätzlicher positiver Effekt entstand durch gesparte Lizenz- und Betriebskosten in Höhe von über 110.000 US-Dollar jährlich, was die Entscheidung zugunsten von PostgreSQL wirtschaftlich untermauerte. Die Erfahrungen von Motion verdeutlichen exemplarisch, dass eine Migration hin zu einem bewährten relationalen Datenbanksystem wie PostgreSQL auch bei zuvor vertikal ausgerichteten oder verteilteren Systemen beste Chancen auf Erfolg, Performance und Kosteneffizienz bietet. Allerdings benötigt eine solche Migration sorgfältige Planung, Werkzeugentwicklung und angepasstes Datenhandling, vor allem bei großen Datenmengen und spezifischen Datentypen.

Für Unternehmen, die angesichts wachsender Datenmengen vor der Entscheidung stehen, welche Datenbanktechnologie langfristig und wirtschaftlich optimal ist, kann die Motion-Story wertvolle Impulse liefern. Die Wahl eines Systems sollte immer entlang der tatsächlichen Geschäftsbedürfnisse und technischen Voraussetzungen erfolgen, anstatt sich allein von Hype oder Trends leiten zu lassen. PostgreSQL hat sich dabei als imposantes Beispiel für Zuverlässigkeit, Flexibilität und Performance in der modernen Datenverarbeitung erwiesen. Gerade durch die starke Community, das umfangreiche Ökosystem und stetige Weiterentwicklung ermöglicht es Lösungen, die bei steigenden Anforderungen nicht nur bestehen, sondern aktiv Wettbewerbsvorteile schaffen. Wer sich also mit dem Gedanken einer Migration beschäftigt, sollte neben technischen Tests besonders auch die Kostenstrukturen, Supportmöglichkeiten und langfristigen Perspektiven im Auge behalten.

Zusammenfassend zeigt das Beispiel Motion, dass der mutige Schritt zu PostgreSQL in vielen Fällen der Schlüssel zu einer nachhaltig erfolgreichen Datenbankstrategie sein kann. Die Kombination aus stabiler Grundarchitektur, vielseitigen Tools, verbesserter Entwicklererfahrung und deutlichen Kosteneinsparungen macht diesen Weg zu einer überzeugenden Option für moderne Unternehmen jeder Größe. Angesichts der zunehmenden Komplexität von Datenlandschaften und der Bedeutung von performantem Datenzugriff wird die Relevanz solcher Migrationsprojekte weiter steigen. Wer gut vorbereitet ist und die richtigen Werkzeuge einsetzt, findet nicht nur eine effiziente technische Lösung, sondern sichert auch die Wettbewerbsfähigkeit in einer datengetriebenen Zukunft.

![Christie's – 21st Century Evening Sale – Wed May 14 25 [video]](/images/CF0D4379-5B8B-4361-8337-AF360B137A9C)