In der Welt verteilter Systeme, in der Hunderttausende von Nachrichten und Prozesse parallel ablaufen, ist die Gewährleistung der Korrektheit von Protokollen eine fundamentale Herausforderung. Fehlerhafte Protokolle können nicht nur zu Systemausfällen führen, sondern auch erhebliche wirtschaftliche Schäden und Sicherheitsrisiken verursachen. Vor diesem Hintergrund gewinnt die Modellprüfung als eine der formalen Verifikationstechniken immer größer an Bedeutung. Sie bietet nicht nur die Möglichkeit, Defekte systematisch zu entdecken, sondern auch, die Einhaltung wichtiger Korrektheitseigenschaften nachzuweisen – ein entscheidender Schritt bei der Entwicklung und Optimierung verteilter Protokolle. Verteilte Protokolle steuern die Kommunikation und das Zusammenspiel zwischen unabhängigen Komponenten in einem Netzwerk.

Diese Systeme müssen dabei unter einer Vielzahl von Randbedingungen und in Anwesenheit von Fehlern funktionieren können. Gerade die hohe Komplexität und der enorme Zustandsspeicher, der bei solchen Protokollen entsteht, erschweren traditionelle Testansätze erheblich. Herkömmliche Softwaretests, so wichtig sie auch sind, können nur einzelne Ausführungspfade oder typische Szenarien prüfen und garantieren somit niemals die Fehlerfreiheit. Dieses bekannte Problem beschreibt der berühmte Ausspruch von Edsger W. Dijkstra: "Tests können nur das Vorhandensein von Fehlern nachweisen, nicht aber deren Abwesenheit.

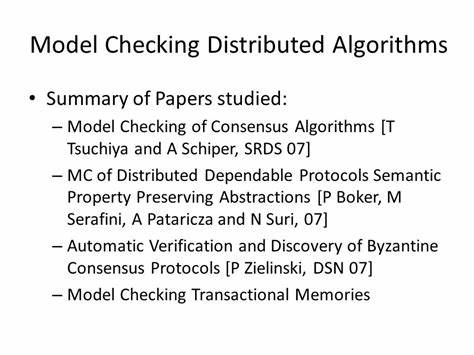

" Doch genau hier setzt die Modellprüfung an – als Methode, die durch vollständige oder gezielt eingeschränkte Zustandsraumdurchsuchung formale Korrektheitsgarantien bietet. Modellprüfung arbeitet auf Basis einer mathematischen Spezifikation eines Systems und seiner erwarteten Eigenschaften, etwa Sicherheits- oder Erreichbarkeitsbedingungen. Durch eine algorithmische Untersuchung des Zustandsraums eines Modells kann das Verfahren alle möglichen Systemzustände analysieren und so Fehler entdecken, die bei der Entwicklung leicht übersehen werden. Besonders SMT-basierte Modellprüfer (Satisfiability Modulo Theories) nutzen symbolische Repräsentationen, um den Zustandsraum kompakt und effizient zu durchsuchen. Solche Werkzeuge sind somit in der Lage, Fehler aufzuspüren, die sehr spezifische, seltene oder eng definierte Eingabeklassen betreffen – Szenarien, die zufallsbasierte Simulationen oder Fuzzing oft nicht vollständig abdecken können.

Die tatsächliche Stärke der Modellprüfung liegt jedoch weniger in der bloßen Fehlersuche, sondern vielmehr in ihrem Potential zum Nachweis der Protokollkorrektheit innerhalb bestimmter, wohldefinierter Grenzen. Während einfache Beispiele wie Verkehrsampelsteuerungen noch vollständig mit modellprüfenden Methoden untersucht werden können, wird bei realen, komplexen Protokollen der enorme Zustandsraum schnell zur Herausforderung. Daher ist es üblich, die Prüfung auf beschränkte Szenarien und Parameter wie die Anzahl der Prozesse, Fehlerknoten oder die Länge von Ausführungen zu begrenzen. Diese sogenannten "bounded scopes" ermöglichen eine durchführbare und dennoch aussagekräftige Analyse, da innerhalb dieser Bereiche garantiert keine Inkonsistenzen oder Fehler existieren – sofern die Modellprüfung erfolgreich terminiert. Dieser Ansatz erlaubt Entwicklern, mit vergleichsweise geringem Ressourcenaufwand präzise Sicherheitsgarantien zu erhalten.

Im Vergleich zu herkömmlichem Fuzzing oder Simulationen bietet die Modellprüfung den Vorteil, dass Klarheit darüber herrscht, welche Zustände und Fälle abgedeckt wurden und welche nicht. Die Vollständigkeit im gewählten Bereich stellt sicher, dass kein kritischer Fehler in den überprüften Szenarien unentdeckt bleibt. Das ist besonders wertvoll bei verteilten Algorithmen, wo einzelne Testläufe meist nur Teilaspekte der Gesamtsystemdynamik abbilden können. Natürlich erfordert die Nutzung der Modellprüfung Expertise, um die korrekten Spezifikationen und Prüfbereiche zu definieren. Der Aufwand lohnt sich aber, denn gerade bei wichtigen industriellen Anwendungen bedeutet jeder vermeidbare Fehler potenziell Millionenverluste oder den Bruch des Kundenvertrauens.

Indem man frühzeitig automatisiert über potenzielle Schwachstellen informiert wird, können Entwicklungsteams gezielt Optimierungen vornehmen und das Sicherheitsniveau nachhaltig erhöhen. Die jüngsten Entwicklungen im Bereich der modelchecking-basierten Werkzeuge wie Apalache oder Quint zeigen zudem, dass sich die Methoden zunehmend professionalisieren und spezialisieren. Moderne Tools erlauben nicht nur die Definition komplexer Prüfbereiche und die Verarbeitung großer Zustandsräume, sondern unterstützen auch bei der Identifikation von induktiven Invarianten, die für Proofs von essenzieller Bedeutung sind. Daraus resultiert ein tiefes Verständnis der Protokollmechanismen und deren korrektem Zusammenspiel unter Fehlerbedingungen. Trotz aller Fortschritte existieren weiterhin Herausforderungen.

Die Performance von SMT-Solvern ist oft schwer vorherzusagen und von der Problemformulierung abhängig. Die Modellprüfung großer und komplexer Systeme erfordert teilweise enorme Rechenressourcen und intelligente Heuristiken, um den Suchraum sinnvoll zu begrenzen. Dennoch lohnt sich die Investition in bessere und flexiblere Modellprüfer: sie ermöglichen präzisere und schnellere Analysen, erhöhen die Sicherheit verteilter Protokolle und verringern die Abhängigkeit von langwierigen manuellen Beweisen. Ein weiterer Vorteil der Modellprüfung ist ihre Automatisierung. Sobald das Modell und die Spezifikation erstellt sind, übernimmt das Tool die aufwendige Analyse eigenständig.

Entwickler können so effizienter arbeiten, potenzielle Schwachstellen noch vor der Implementierung identifizieren und durch schnelle Iterationen die Protokolle verbessern. Diese Automatisierung und Wiederholbarkeit machen die Modellprüfung zu einem unverzichtbaren Werkzeug im Werkzeugkasten moderner Softwareentwicklung, besonders wenn es um sicherheitskritische Systeme geht. Trotz der immensen Bedeutung formaler Verifikation im Allgemeinen hat die Modellprüfung gerade im Bereich verteilter Protokolle einen besonderen Stellenwert. Herkömmliche formale Proofs mit Beweisassistenten sind zwar äußerst mächtig, erfordern aber häufig einen erheblichen Zeit- und Personalaufwand sowie tiefe theoretische Kenntnisse. Modellprüfer bieten hier einen pragmatischen Kompromiss zwischen Aufwand und Ergebnisqualität.

Sie liefern oft schneller wertvolle Erkenntnisse, die für die Praxis unmittelbar relevant sind, ohne auf vollständige Beweise verzichten zu müssen. Gerade in industriellen Kontexten mit hohen Anforderungen an Korrektheit und zeitlichen Zwängen ist das ein großer Gewinn. Die Kombination verschiedener Methoden – von Tests über Simulationen bis hin zur Modellprüfung und manuellen Beweisen – stellt die beste Vorgehensweise dar, um die Qualität von verteilten Protokollen zu gewährleisten. Dabei fungiert die Modellprüfung als Bindeglied zwischen praktikablen Tests und formalen Beweisen. Während Tests die Grundfunktionalität sicherstellen und Simulationen typische Abläufe näher beleuchten, erlaubt die Modellprüfung das Auffinden subtiler Fehler und das Erlangen „formaler“ Sicherheit unter realistischer Begrenzung des Zustandsraums.

Langfristig wird die Weiterentwicklung von Modellprüfungswerkzeugen entscheidend die Zukunft der Protokollentwicklung beeinflussen. Verbesserte Algorithmen, bessere Integration mit anderen Analysewerkzeugen und mehr Anpassbarkeit an unterschiedliche Protokolle werden diese Technologien noch zugänglicher und leistungsfähiger machen. Dennoch wird es auch in Zukunft wichtig sein, kluge Beschränkungen der Analysemengen vorzunehmen und hochqualifizierte Mitarbeitende für Spezifikation und Interpretation einzusetzen. Zusammengefasst lässt sich sagen, dass die Modellprüfung einen unverzichtbaren Beitrag zur Entwicklung sicherer und robuster verteilter Protokolle leistet. Sie ermöglicht eine systematische und dennoch pragmatische Analyse komplexer Systeme, entlarvt verborgene Fehlerquellen und verkürzt den Entwicklungszyklus durch schnelle, automatisierte Prüfungen.

In Kombination mit anderen Verifikationsmethoden sorgt sie dafür, dass moderne verteilte Systeme verlässlich funktionieren – auch unter schwierigen Bedingungen und in sicherheitskritischen Umgebungen. Entwickler, Forscher und Unternehmen, die den Wert der Modellprüfung frühzeitig anerkennen und gezielt in diese Methoden investieren, schaffen sich damit einen entscheidenden Wettbewerbsvorteil und stärken die Verlässlichkeit digitaler Infrastrukturen im Zeitalter der Vernetzung.

![Gemini Credit Card ® Review [2025]: Are Crypto Rewards Worth It?](/images/E40DD5E2-BD57-43F1-988E-0C337D0AE394)