Seit Alan Turing im Jahr 1950 seine legendäre Schrift „Computing Machinery and Intelligence“ veröffentlichte, hat sich das Thema der Künstlichen Intelligenz (KI) als eine der bedeutendsten technologischen und gesellschaftlichen Herausforderungen unserer Zeit etabliert. Dabei stach eine seiner bemerkenswertesten Vorhersagen und Beobachtungen hervor: die so genannte „Heads in the Sand“-Einwendung, frei übersetzt die Haltung, den Kopf in den Sand zu stecken angesichts der potentiellen Gefahren und Folgen von denkenden Maschinen. Dieses Phänomen – die menschliche Angst und Abwehr gegenüber Fortschritt und Intelligenz außerhalb des Menschen – ist heute, über siebzig Jahre später, aktueller denn je. Turing erkannte früh, dass die Ablehnung von KI keine rein rationale Ablehnung ist, sondern tief in emotionalen Ängsten verwurzelt. „Die Konsequenzen von Maschinen, die denken, wären zu schrecklich.

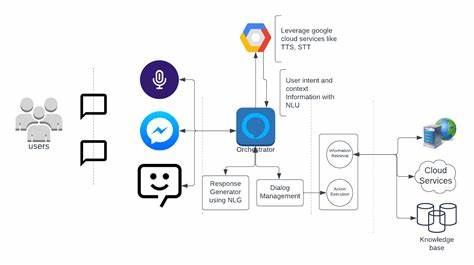

Hoffen wir und glauben wir, dass sie nicht dazu in der Lage sind“, schrieb er damals. Diese Aussage zeugt von einem Verständnis, dass Menschen oft lieber in Unwissenheit verharren möchten, als sich den Herausforderungen zu stellen, die solche Technologien mit sich bringen. Es geht weniger um solide Gegenargumente als um eine psychologische Schutzfunktion, die verhindern soll, dass wir mit unbequemen Wahrheiten oder Bedrohungen konfrontiert werden. Das Phänomen des „Kopf in den Sand Steckens“ zeigt sich bis heute in vielen Bereichen, vor allem aber im Umgang mit KI, die unser Leben direkt beeinflusst und unser Verständnis von Intelligenz herausfordert. Besonders interessant ist der Bereich der psychischen Gesundheit, in dem KI-basierte Therapielösungen wie Aitherapy eine immer wichtigere Rolle spielen.

Trotz der wachsenden Belege für die Wirksamkeit dieser Systeme stoßen sie weiterhin auf Vorbehalte und Misstrauen. Warum? Weil es für viele schwer vorstellbar ist, sich einer nicht-menschlichen Instanz anzuvertrauen – auch wenn diese durchgängige Verfügbarkeit und Anonymität bietet, was traditionelle Therapieformen oft nicht ermöglichen. Psychologen und Forscher wie Fitzpatrick et al. konnten jedoch bereits zeigen, dass automatisierte Gesprächsagenten wie Woebot messbare Erfolge bei der Unterstützung von Menschen mit Depressionen und Angststörungen erzielen können. Diese Erfolge treffen jedoch oft auf innere Barrieren, die weniger mit der Leistung der Technik zu tun haben, sondern mit den emotionalen Reaktionen der Nutzer.

Turing hatte diese Zwickmühle vorausgesehen: Die Furcht vor denkenden Maschinen führt dazu, dass potenziell hilfreiche Technologien abgelehnt oder zumindest zögerlich angenommen werden. Doch was passiert, wenn wir diese Haltung ablegen? Nutzer berichten, dass die Erfahrung mit KI-Therapie oft überraschend menschlich wirkt. KI ist nicht nur ein kalter Algorithmus, sondern ein Tool, das zuhört, empathisch reagiert und jederzeit erreichbar ist. Sie ergänzt den menschlichen Therapeuten, indem sie Barrieren wie Scham, Stigma und Verfügbarkeit deutlich verringert. Die Angst, die ursprünglich mit der Idee von Maschinen, die denken oder fühlen könnten, verbunden war, tritt hinter die Chancen und Möglichkeiten zurück, die KI eröffnet.

Ein Zitat aus dem Blog von Aitherapy bringt es auf den Punkt: „Anstatt Angst vor denkenden Maschinen zu haben, sollten wir vielleicht eher Angst davor haben, was geschieht, wenn wir ihnen helfen verweigern.“ Es stellt sich daher die Frage, welche Folgen es hat, wenn wir weiterhin den Kopf in den Sand stecken. In vielen Fällen bedeutet es verpasste Chancen auf Heilung und Unterstützung, insbesondere für Menschen, die sonst keinen Zugang zu psychotherapeutischer Hilfe haben. Die Technik entwickelt sich fortlaufend, und wir sollten uns als Gesellschaft darauf einstellen, sie nicht aus Angst abzulehnen, sondern kritisch, aber offen zu integrieren. Historisch gesehen ist die Angst vor neuen Technologien keine neue Erscheinung.

Jedes bedeutende technologische Fortschrittsschub wurde von skeptischen und beängstigten Stimmen begleitet. Vom Telefon über das Internet bis hin zu den ersten Computern wurden vielfach Katastrophenszenarien entworfen, die sich oft als unbegründet erwiesen haben. Genauso verhält es sich mit KI. Turings Warnung ist also auch eine Aufforderung, sich den Ängsten zu stellen, anstatt sie zu verdrängen. Der menschliche Widerstand gegen KI speist sich auch aus Fragen nach Kontrolle und Identität.

Was bedeutet es, wenn Maschinen denken? Wird der Mensch überflüssig? Können Maschinen mit Gefühlen umgehen? Diese Fragen sind berechtigt, können aber nur angegangen werden, wenn wir bereit sind, die Möglichkeiten der KI zu erforschen und zugleich ethische und soziale Rahmenbedingungen zu entwickeln, die einen verantwortungsvollen Einsatz garantieren. In der Mental-Health-Branche ist die Integration von KI deshalb auch eine soziale und kulturelle Herausforderung. Es gilt, Vertrauen aufzubauen und die Menschen in einem Prozess mitzunehmen. Transparenz, Datenschutz und ein klares Bewusstsein darüber, welche Funktionen KI erfüllen kann und welche nicht, sind unabdingbar. Nur so kann aus „Kopf in den Sand“ ein „aufgeschlossen und neugierig“ werden.

Neben der Angst vor Unbekanntem steht oft auch der Wunsch nach Sicherheit und Vertrautheit. Menschliche Beziehungen leben von Emotionen, Empathie und direkter Interaktion. KI-Systeme müssen also nicht nur technisch überzeugend sein, sondern auch diese menschlichen Werte respektieren und ergänzen, nicht ersetzen. Gerade in sensiblen Bereichen wie der psychischen Gesundheit ist das entscheidend. Zusammenfassend lässt sich sagen, dass die heutige Reaktion auf KI in vielen Bereichen von denselben emotionalen Mustern geprägt ist, die Alan Turing bereits 1950 beschrieben hat.