Das Design moderner Datenbankschemata stellt eine der wichtigsten Herausforderungen beim Aufbau leistungsfähiger Anwendungen dar. Mit dem Anstieg an Datenvolumen und der steigenden Komplexität von Softwareprojekten gewinnt eine gut durchdachte Struktur der Datenbank an Bedeutung. Das sogenannte CORE-Datenbankdesign bietet eine praktische Grundlage, um PostgreSQL-Datenbanken so zu gestalten, dass sie sowohl stabile als auch flexible Grundlagen für Anwendungen gewährleisten. CORE steht für Constraint-Driven, Optimized, Responsive und Efficient – vier zentrale Prinzipien, die beim Schemaentwurf berücksichtigt werden sollten, um Datenqualität, Performance und Anpassungsfähigkeit zu optimieren. Der erste Bestandteil, Constraint-Driven, fokussiert sich auf die Nutzung von Einschränkungen und Regeln innerhalb des Datenbankschemas.

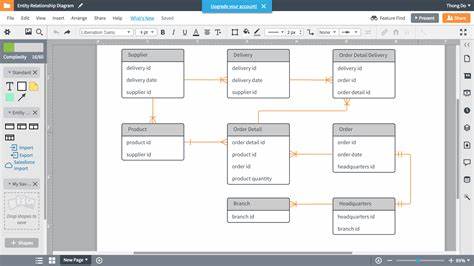

Relationale Datenbanken wie PostgreSQL bieten eine breite Palette an Constraint-Mechanismen, die gewährleisten, dass nur valide und konsistente Daten gespeichert werden. Durch die Verwendung von passenden Datentypen, das Setzen von NOT NULL-Constraints sowie das Anlegen von Foreign Keys wird sichergestellt, dass die Datenqualität gewahrt bleibt. Diese Herangehensweise fördert nicht nur die Korrektheit der Daten, sondern erleichtert auch Wartung und Erweiterbarkeit. Ein häufiges Missverständnis beim Datenbankdesign ist, schon zu Beginn umfangreiche Strukturen für hypothetische zukünftige Anforderungen zu modellieren. Stattdessen empfiehlt das CORE-Konzept, zunächst für den aktuellen Bedarf zu planen und die Möglichkeit zu nutzen, die Datenbankschemata flexibel durch DDL-Anweisungen im laufenden Betrieb anzupassen.

Optimized als zweites Prinzip zeigt die Bedeutung von Performance-Optimierungen im Datenbankdesign auf. Zu Beginn werden Daten typischerweise in normalisierter Form abgelegt, um Redundanzen zu vermeiden und die Integrität sicherzustellen. Mit fortschreitendem Projektverlauf kann jedoch eine gezielte Denormalisierung sinnvoll sein, wenn der Fokus auf schnellen Lesezugriff liegt. Die Optimierung hört aber nicht bei der Struktur der Tabellen auf: Indizes sind essenziell, um schnelle Suchoperationen zu ermöglichen, insbesondere wenn sie auf Spalten mit hoher Kardinalität angewandt werden. Durch iterative Anpassungen werden sowohl Abfragepläne als auch das Setzen von Parametern wie work_mem an die vorherrschenden Nutzungsmuster angepasst.

Auch die regelmäßige Wartung der Datenbank, beispielsweise durch VACUUM in PostgreSQL, zählt hier zu den wichtigen Optimierungsmaßnahmen, um veraltete Daten zu bereinigen und die Performance zu erhalten. Das CORE-Prinzip fordert darum ein stetiges Verbessern, welches auf realen Nutzungsszenarien basiert und nicht auf vagen Annahmen. Responsive beschreibt im Kontext von Datenbanken die Fähigkeit, schnell auf Probleme und Veränderungen zu reagieren, ohne den Betrieb zu unterbrechen. Bei auftretenden Inkonsistenzen oder Performanceproblemen ist es entscheidend, dass Datenbankadministratoren detaillierte Logs und Statistiken heranziehen können, um Ursachen zu identifizieren und gezielte Änderungen vorzunehmen. Heutige Datenbanken und Tools erlauben es, DDL-Änderungen online und in mehreren Schritten durchzuführen, sodass der Datenbankbetrieb weitestgehend ungestört bleibt.

Besonders in produktiven Umgebungen ist es unabdingbar, Schema-Änderungen in Versionierungssysteme einzubinden, um Nachvollziehbarkeit und Kollaboration zu gewährleisten. Auch Parametertuning spielt hier eine Rolle: Anpassungen sollten möglichst online und in einem klar abgegrenzten Scope geschehen, damit nur die relevantesten Abfragen optimiert werden und unbeabsichtigte Nebeneffekte vermieden werden. Reaktionsfähigkeit ist somit ein Kernaspekt professionellen Datenbankmanagements. Das abschließende Prinzip Efficient hebt die Ressourceneffizienz bei Speicherung und Zugriff auf Daten hervor. Kostbare Speicherressourcen und Zeit sind oft unterschätzte Faktoren in großen Systemen.

Das Eliminieren unnötiger Tabellen, redundanter Spalten oder nicht mehr benötigter Indizes trägt maßgeblich dazu bei, Speicherplatz zu sparen und die Komplexität des Systems gering zu halten. Regelmäßige Software-Updates sichern zudem die Nutzung neuer Funktionen und Performance-Verbesserungen, die mit aktuellen Versionen von PostgreSQL einhergehen. Bei besonders umfangreichen Tabellen empfiehlt sich die Partitionierung, um Verwaltung und Abfragen effizienter zu gestalten. Effizienz bedeutet somit, Ressourcen bewusst einzusetzen, Verschwendung zu vermeiden und Skalierbarkeit zu gewährleisten. In der Summe bilden die CORE-Prinzipien ein kraftvolles Instrumentarium, um Datenbankschemata mit Blick auf aktuelle Anforderungen und zukünftige Erweiterungen zu entwerfen.

Das Design richtet sich nicht nur an Anfänger, sondern ebenso an erfahrene Entwickler und Datenbankadministratoren, die Wert auf robuste, performante und wartbare Dateninfrastrukturen legen. Trotz der Praxisnähe ist es ratsam, diese Regeln stets im Kontext der jeweiligen Anwendungen und Geschäftsprozesse anzupassen, denn Datenbanken sind so individuell wie die Unternehmen, die sie nutzen. PostgreSQL bietet herausragende Werkzeuge, um die CORE-Prinzipien umzusetzen. Constraints in Form von Check- und Foreign-Key-Constraints sichern Datenkonsistenz ab. Die Vielzahl an Indexarten, von B-Tree bis zu GIN- oder GiST-Indizes, ermöglicht optimale Suchperformance für unterschiedliche Datenarten und Anfragen.

Mit Erweiterungen und umfassendem Monitoring werden Verfügbarkeit und Reaktionsfähigkeit gesteigert. Features wie Table Partitioning erlauben eine feinkörnige Verteilung von großen Datenmengen, was dem Effizienzprinzip zugutekommt. Für Entwickler empfiehlt es sich, die Evolution des Datenbankschemas eng im Entwicklungsprozess zu begleiten. Die Nutzung von Versionierungstools für Migrationen und das Einbinden von Datenbankspezialisten in die Architekturplanung bringt nachhaltige Vorteile. Gerade bei komplexen Anwendungen ist es ein Investment, frühzeitig Constraints systematisch zu definieren und Abfrageoptimierung laufend zu betreiben.