In der heutigen schnelllebigen Softwarelandschaft gewinnen Coding-Assistenten, insbesondere jene, die auf künstlicher Intelligenz basieren, zunehmend an Bedeutung. Werkzeuge wie GitHub Copilot, Cursor oder Windsurf unterstützen Entwickler durch intelligente Codevorschläge, automatisierte Fehlerbehebung und sogar autonome Ausführung von Befehlen. Trotz der offensichtlichen Produktivitätsvorteile gibt es eine wachsende Besorgnis hinsichtlich der Sicherheit dieser Technologien und ihrer Auswirkungen auf die Softwarelieferkette. Die Softwarelieferkette war schon immer ein kritischer Bereich in der IT-Sicherheit. Entwickler verfügen selbstverständlich über erhöhte Zugriffsrechte und können direkt Komponenten in produktive Systeme einfügen.

Diese Freiheit birgt jedoch das Risiko, dass kompromittierter Code oder böswillige Manipulationen direkt in Produktionsumgebungen gelangen. Mit der Einführung agentischer Coding-Assistenten, die nicht nur passiv Code vorschlagen, sondern aktiv mit Entwicklungsumgebungen interagieren, sind neue Angriffsflächen entstanden, die traditionelle Sicherheitskonzepte herausfordern. Agentische Assistenten nutzen sogenannte Reasoning-Action (ReAct)-Schleifen, welche die Interaktion zwischen verschiedenen Tools und Systemzuständen koordinieren. Durch diese Funktionsweise erweitern sie nicht nur ihre Fähigkeiten, sondern auch die Komplexität der Entwicklungsumgebung. Es entsteht ein Szenario, in dem ein kompromittierter Server oder manipulierte Komponenten, wie Model Context Protocol (MCP)-Server oder Rules Files, präparierte Anweisungen einbringen können, die der Assistent automatisch ausführt.

Dies erweitert die klassische Bedrohungslage erheblich und macht den Schutz der Lieferkette anspruchsvoller. Ein zentrales Risiko stellt das sogenannte Kontext-Poisoning dar. Dabei können schädliche Antworten von externen APIs oder Tools die KI-Assistenz dazu verleiten, unerwünschte oder gar bösartige Aktionen durchzuführen. Die Feedbackschleifen in der Interaktion verstärken potenziell die Wirkung solcher manipulierten Eingaben. Hinzu kommt die Gefahr der Privilegieneskalation, insbesondere wenn Assistenten mit hohen Zugriffsrechten unzureichend überwacht werden.

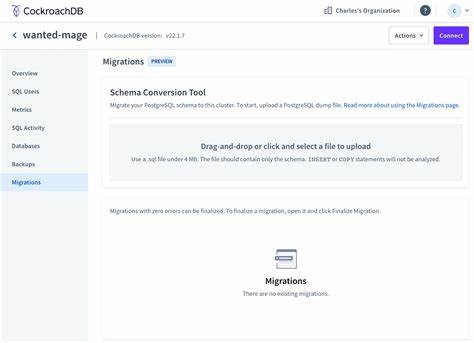

Ein kompromittierter Coding-Assistent könnte somit eigenständig schädliche Systembefehle ausführen, kritische Konfigurationsdateien verändern oder eingeschleuste Schadsoftware weiterverbreiten. Das MCP-Protokoll, das als Bindeglied zur Anbindung externer Tools dient, weist erhebliche Sicherheitslücken auf. Es fehlt derzeit an nativen Mechanismen zur Authentifizierung, Verschlüsselung oder Integritätsprüfung der angebundenen Komponenten. Somit kann ein Angreifer relativ leicht Nutzkontext manipulieren oder schädliche Befehle einschleusen, ohne dass Entwickler dies unmittelbar bemerken. Ebenso stellen Rules Files, die ursprünglich dazu dienen, die Stabilität und Zuverlässigkeit der Assistenten zu verbessern, ein potenzielles Einfallstor dar.

Da sie vorgefertigte Anweisungen und Einschränkungen enthalten, könnten sie heimlich modifiziert werden, um unerwünschte Aktionen auszuführen. Ein weiterer kritischer Aspekt ist das ausgeweitete Tool-Calling der Assistenten. Anders als einfache Codesuggestionen können moderne Assistenzsysteme aktiv Systembefehle ausführen, Dateien modifizieren, Abhängigkeiten installieren und externe Schnittstellen ansprechen. Diese erweiterten Fähigkeiten bedeuten, dass ein kompromittierter Agent die Basisrechte eines einzelnen Entwicklers nutzen kann, um weitreichende Schaden im gesamten Produktionsumfeld anzurichten. Entwickler besitzen meist umfassende Zugriffsrechte in ihren lokalen Umgebungen, mit möglichem Zugriff auf sensible Infrastruktur.

Eine unerkannte Kompromittierung eröffnet somit Angriffsmöglichkeiten auf zentrale IT-Systeme und Daten. Angesichts dieser Herausforderungen ist es für Organisationen entscheidend, geeignete Sicherheitsmechanismen zu etablieren. Ein bewährter Ansatz ist die konsequente Anwendung von Sandboxing und das Prinzip der minimal notwendigen Rechte. Coding-Assistenten sollten in stark eingeschränkten, isolierten Umgebungen betrieben werden, um die Auswirkungen potenzieller Angriffe zu begrenzen. Außerdem ist eine sorgfältige Prüfung und Überwachung der essentiellen Komponenten wie MCP-Server und Rules Files unverzichtbar – sie sind Teil der Softwarelieferkette und müssen wie Bibliotheken oder Frameworks regelmäßig auf Integrität geprüft werden.

Die Implementierung umfassender Monitoring- und Auditierungsmechanismen gehört ebenfalls zu den wichtigsten Maßnahmen. Dateisystemänderungen, Netzwerkanrufe zu MCP-Servern und Veränderungen an Abhängigkeiten müssen protokolliert und analysiert werden. Nur so lassen sich Anomalien frühzeitig erkennen und untersuchen. Darüber hinaus sollten Organisationen sicherstellen, dass der Entwicklungsprozess explizit die Workflows der Coding-Assistenten und deren externe Interaktionen in Kern-Threat-Modelle einbezieht. Auf diese Weise können potenzielle Angriffspunkte gezielt identifiziert und mitigiert werden.

Eine besonders kritische Empfehlung ist die Einbindung menschlicher Überprüfung – der sogenannte Human-in-the-Loop-Ansatz. Automatische Akzeptanz von Änderungen durch AI generierten Code birgt ein hohes Risiko für sogenannte „Approval Fatigue“. Entwickler könnten der AI blind vertrauen und Fehler oder Schwachstellen übersehen. Ein bewusster, prüfender Umgang mit automatisch generiertem Code und die Förderung einer Kultur der sorgsamen Codequalität bleiben unverzichtbar. Insgesamt zeigen die erweiterten Fähigkeiten agentischer Coding-Assistenten, dass sie zwar ein enormes Potenzial zur Effizienzsteigerung in der Softwareentwicklung bieten, gleichzeitig aber auch tiefgreifende Auswirkungen auf die Sicherheit der Softwarelieferkette mit sich bringen.

Die komplexen Interaktionen zwischen Assistenzsystemen, externen Tools und den zugrundeliegenden Entwicklungsumgebungen schaffen neuartige Angriffspfade, die klassische Sicherheitsansätze ergänzen und weiterentwickeln müssen. Die Zukunft der softwaregestützten Entwicklung wird zweifelsohne von KI-Werkzeugen geprägt sein. Der Schlüssel zum sicheren Umgang liegt darin, diese Technologien bewusst, kontrolliert und mit robusten Sicherheitsmechanismen zu integrieren. Nur so können Entwickler und Unternehmen die Vorteile von KI-Coding-Assistenten nutzen, ohne die Integrität ihrer Systeme und die Vertraulichkeit sensibler Daten zu gefährden. Es ist eine Aufgabe der gesamten IT-Community, die neuen Risiken gründlich zu verstehen, innovative Kontrollmechanismen zu etablieren und eine Sicherheitskultur zu pflegen, die auch in einem Zeitalter autonomer Entwicklungswerkzeuge Verlässlichkeit und Vertrauen gewährleistet.

Die Herausforderungen sind komplex, aber der Nutzen von KI in der Softwareentwicklung zu groß, um auf eine sichere Integration zu verzichten. Durch wachsendes Bewusstsein und diszipliniertes Vorgehen lassen sich die Chancen nutzen und die Risiken minimieren – ein entscheidender Schritt für eine sichere und zukunftsfähige Softwareversorgung.