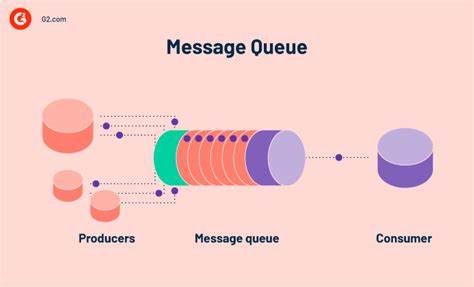

In der modernen Softwareentwicklung und bei verteilten Systemen sind Message Queues zu einem unverzichtbaren Bestandteil geworden. Sie ermöglichen asynchrone Kommunikation, Lastverteilung und entkoppelte Systemarchitekturen. Im Jahr 2025 stehen Entwickler und Unternehmen vor einer Vielzahl von Optionen – von klassischen bewährten Systemen bis zu innovativen Lösungen, die neue Paradigmen in der Datenverarbeitung ermöglichen. Eine Frage, die viele beschäftigt, lautet: Welche Message Queue ist im Jahr 2025 die beste Wahl? Um darauf eine fundierte Antwort zu geben, lohnt es sich, einen umfassenden Blick auf den aktuellen Stand der Technik, die unterschiedlichen Bedürfnisse und die daraus entstehenden Trade-offs zu werfen. Message Queues sind Kernkomponenten in verteilten Architekturen und stehen für verschiedenste Anforderungen.

Ob sie als einfache FIFO-Warteschlangen, als Publish-Subscribe-Systeme, oder für komplexe Event-Streaming-Szenarien eingesetzt werden, hängt stark vom Anwendungsfall ab. Die Bandbreite an verfügbaren Technologien ist breit gefächert: Zu den bekanntesten zählen Kafka, RabbitMQ, NATS, Redis Streams, Amazon SQS und ZeroMQ, aber auch weniger verbreitete oder speziellere Systeme finden Verwendung. Zudem hat sich in manchen Situationen auch der Einsatz von relationalen Datenbanken, etwa PostgreSQL, als einfache und pragmatische Lösung für Message Queueing bewährt. Ein zentrales Unterscheidungskriterium, das die Wahl maßgeblich beeinflusst, ist die Art der Kommunikation: Soll es sich um eine asynchrone, feuer-und-vergiss Pub/Sub-Architektur handeln, oder wird eine synchrone, punkt-zu-punkt RPC-ähnliche Kommunikation benötigt? Feuer-und-vergiss-Systeme bieten häufig mehr Skalierbarkeit und Entkopplung, während RPC-Modelle oft eine klare Anfrage-Antwort-Logik abbilden, die in manchen Szenarien richtiger ist. Ein weiteres Augenmerk liegt auf den Funktionalitäten der jeweiligen Message Queue.

Neben der Frage, ob eine einfache FIFO-Verarbeitung benötigt wird, sind Filtermöglichkeiten, Prioritätswarteschlangen oder zeitverzögerte Nachrichtenfunktionalität für verschiedene Use Cases entscheidend. Manche Broker wie RabbitMQ oder NATS bieten intelligente Funktionen wie Message-Filterung oder Topic-Routing, während andere, beispielsweise Kafka, auf ein minimalistischeres, clientgesteuertes Modell setzen, das dafür extrem skalierbar und performant ist. Die emotionalen und ideologischen Präferenzen einzelner Entwicklerteams spielen ebenfalls eine Rolle. Manche Nutzer favorisieren Lösungen, die in ihrer bevorzugten Programmiersprache geschrieben wurden oder die offen und einfach zu verstehen sind. Andere wiederum setzen konsequent auf „Enterprise-Grade“-Systeme, die sich durch Stabilität, Skalierbarkeit und umfangreichen Support auszeichnen.

Nicht zu unterschätzen sind außerdem die Interessen von Anbietern und Cloud-Diensten, die ihre eigenen Lösungen bevorzugt propagieren und vermarkten. Wer in den letzten Jahren Produktionssysteme aufgebaut hat, hat oft die Erfahrung gemacht, dass sich je nach Anforderung unterschiedliche Lösungen als erfolgversprechend erwiesen haben. RabbitMQ etwa gilt oft als bewährte und zuverlässige Wahl, die auch ohne viel Babysitting jahrelang stabil läuft. Seine Weiterentwicklung in Richtung Streams macht es zunehmend zu einer echten Alternative für Szenarien, für die früher Kafka favorisiert wurde – vor allem, wenn keine extremen Skalierungsanforderungen bestehen. Der Charme des Rabbit-Mascots mag ebenfalls zum positiven Markenimage beitragen.

Für Entwickler, die in Go programmieren, ist NATS eine beliebte Option. Mit der Möglichkeit, den Broker als eingebettete Komponente in einem einzigen Server zu betreiben, eignet sich NATS hervorragend für MVPs und kleinere Systeme, die später einfach skalierbar sind. NATS ist vor allem für seine Schnelligkeit, Robustheit und die Unterstützung von leichtgewichtiger Kommunikation bekannt. Jetstream, das Streaming-Modul von NATS, bietet darüber hinaus langlebige Nachrichtenabwicklung mit Kafka-ähnlichen Eigenschaften, bleibt aber operativ deutlich schlanker. Kafka selbst bleibt – trotz seiner Komplexität – die Top-Wahl für Anwendungen, die hohe Durchsatzraten, Persistenz, und vor allem Reproduzierbarkeit von Nachrichten benötigen.

Kafka ist im Kern ein persistent strukturierter Log, der das Abspielen von Nachrichten erlaubt und damit ein mächtiges Werkzeug für Event-Sourcing, CQRS und History-basierte Architekturen ist. Allerdings sind Betrieb und Einstieg mit Kafka weniger komfortabel und erfordern eine gewisse operative Expertise. Für kleine Projekte oder Jobs, die einfache verlässliche Verarbeitung brauchen, ist Kafka oft Overkill. In der Cloud dominieren Managed-Services wie Amazon SQS, Google PubSub oder Azure Service Bus. Sie bieten einfache Integration, Skalierbarkeit ohne Verwaltungsaufwand und sind besonders für Unternehmen attraktiv, die Full-Cloud-Strategien verfolgen.

SQS ist vielfach beliebt wegen seiner Zuverlässigkeit und Skalierbarkeit, allerdings ist es eher ein klassisches Message-Queue-System ohne native Unterstützung für Streams oder Replay-Fähigkeiten. Haltung und Wartung fallen hier komplett weg, dafür zahlt man mit Vendor-Lock-in und limitierten individuellen Anpassungen. Redis Streams hat sich wegen einfacher Integration, hoher Performance und unkomplizierter Bedienbarkeit zu einer beliebten Lösung in der Entwickler-Community entwickelt. Es ist besonders dann attraktiv, wenn eine einfache Lösung mit „Kafka-artiger“ Streaming-Funktionalität gesucht wird und eine geringe Latenz sowie gute Sprachunterstützung gewünscht ist. Allerdings sind reine Redis-Systeme weniger geeignet für hochverfügbare, dauerhafte Speicherung, da Redis primär im Arbeitsspeicher arbeitet.

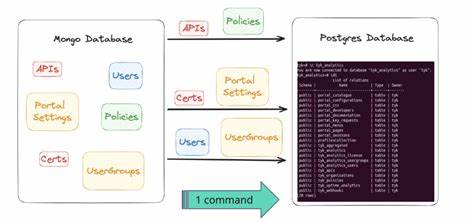

Der Einsatz von relationalen Datenbanken wie PostgreSQL als Message Queue klingt auf den ersten Blick ungewöhnlich, hat sich jedoch in manchen Szenarien bewährt. Datenbanken bieten Standardisierung, Transaktionssicherheit und gute Skalierbarkeit bis zu einer gewissen Grenze. Mit Techniken wie SELECT FOR UPDATE SKIP LOCKED, NOTIFY/LISTEN-Mechanismen und spezialisierten Bibliotheken wie pg_boss oder pgmq können einfache bis moderate Queue-Anforderungen durchaus abgedeckt werden. Diese Lösung vermeidet eine zusätzliche Infrastruktur, braucht jedoch sorgfältiges Design, um Locking und Worker-Management stabil zu gestalten. Neben den klassischen Message-Queues gibt es zunehmend starke Alternativen in Form von Workflow-Engines wie Temporal oder Zeebe/Camunda.

Diese sind besonders für lang andauernde, komplexe Geschäftsprozesse oder Workflows geeignet, die auch menschliche Interaktionen und Verzögerungen beinhalten. Sie sind über die reine Nachrichtenschlange hinaus mit umfangreichen Funktionen für Fehlerbehandlung, Retry-Logik und Überwachung ausgestattet. Allerdings bringen sie zusätzliche Komplexität mit sich und sind weniger für einfache Nachrichtenverarbeitung prädestiniert. Interessant ist auch der Trend, das Messaging-Konzept zum Teil in bestehende Systeme zu integrieren oder sogar selber zu entwickeln, um maßgeschneiderte Anforderungen zu erfüllen. Beispiele finden sich in Lösungen, die S3 als langlebigen Store nutzen und auf darüber legte Event-Broker setzen, oder Spezialfälle, bei denen SQLite oder sogar SQLite-basierte Queues für lokale, kleine Anwendungsfälle eingesetzt werden.

Für sehr simple, geringe Durchsatzraten ist das oft die pragmatischste Lösung. Neben der Technologie stellt sich immer die Frage der richtigen Systemarchitektur und geeigneten Softwareprinzipien. Die Unterscheidung zwischen Streams und Queues ist fundamental. Streams erlauben das mehrfache Lesen derselben Daten durch unterschiedliche Konsumenten („fan out“) und unterstützen so lose gekoppelte Architekturen und Event-Driven-Design. Klassische Queues hingegen bieten exklusive Nachrichtenzustellung und sind oft die richtige Wahl für Jobs und Task-Verarbeitung.

Entscheidend ist, das passende Paradigma an die Anforderung anzupassen, um spätere Probleme von engen Kopplungen und unflexiblen Systemen zu vermeiden. Letztlich hängt die Wahl der Message-Queue-Lösung stark von individuellen Bedürfnissen, Ressourcen, vorhandener Expertise und Infrastruktur ab. Komplexe Systeme mit hohen Durchsatz- und Verfügbarkeitsanforderungen profitieren oft von robusten Event-Streaming-Lösungen wie Kafka oder Pulsar. Mittelgroße bis kleinere Produktionen können mit RabbitMQ, NATS oder Redis Streams sehr gut fahren. Cloud-Plattformen bieten inzwischen komfortable, skalierbare Optionen mit minimalem Betrieb.

Für einfache Anwendungsfälle oder wenn Infrastrukturkosten eine große Rolle spielen, können auch Datenbankbasierte Queues brauchbar sein. Die „beste“ Message Queue im Jahr 2025 gibt es also nicht in absoluter Form. Vielmehr lohnt sich ein klares Verständnis der eigenen Anforderungen, um das passende Tool zu wählen. Moderne Architekturen setzen auf Kombinationen und Hybridansätze, die Messaging mit persistenter Speicherung und Workflows verknüpfen. Die Auswahl wird durch eine angestrebte mentale Modellierung und zukünftige Skalierungspläne begleitet.