Das Internet ist ein riesiges, dynamisches Medium, das sich ständig verändert. Webseiten verschwinden, Inhalte werden verändert und wichtige Informationen können plötzlich nicht mehr zugänglich sein. Für viele Menschen, die das Web intensiv nutzen, ergibt sich daraus die Notwendigkeit, wichtige Seiten dauerhaft zu sichern und lokal verfügbar zu machen. Der Aufbau eines persönlichen Webarchivs ist die Antwort darauf – und zwar nicht hektisch und automatisiert, sondern bewusst und mit viel Sorgfalt. Dabei geht es nicht nur darum, Inhalte zu speichern, sondern sie so vorzubereiten, dass sie auch Jahre später noch zugänglich, verständlich und authentisch wirken.

Wer sich auf den Weg macht, ein eigenes Archiv des Webs zu schaffen, trifft auf verschiedene Möglichkeiten. Institutionen und Bibliotheken verwenden oft spezialisierte Formate wie WARC oder WACZ, die Webinhalte inklusive Metadaten und Protokollinformationen professionell sichern. Doch für den privaten Gebrauch sind solche Formate oft zu komplex. Sie sind schwer zu bearbeiten, benötigen spezielle Software und erlauben kaum individuelle Anpassungen. Wer lieber maximale Kontrolle über das eigene Archiv haben möchte, kann die bewährte Methode wählen: jede Webseite als statische Kopie abzuspeichern.

Das heißt, für jede gespeicherte Seite wird ein Ordner mit allen notwendigen Dateien erstellt – HTML-Dokumente, Bilder, Stylesheets und Medien. Ortsunabhängig von komplexen Formaten oder professionellen Tools lässt sich diese Struktur jederzeit öffnen und editieren. Es ist ein Archivierprozess, der viel mehr Zeit und Geduld erfordert, aber dafür einen hohen Qualitätsanspruch erfüllt. Die manuelle Archivierung von Webseiten ist eine Arbeit der Präzision. Dies beginnt oft mit der simplen Funktion „Speichern unter“ im Browser, mit der das HTML-Dokument lokal abgelegt wird.

Doch der eigentliche Aufwand beginnt erst danach. Viele Seiten beziehen externe Ressourcen, laden Bilder von anderen Servern oder binden Videos und Schriftarten ein. Diese müssen ebenfalls heruntergeladen und im Archiv integriert werden. Die Links im HTML-Code werden so angepasst, dass sie auf lokale Dateien zeigen. Das ist entscheidend, denn es entkoppelt das Archiv komplett vom Originalserver.

So kann das gespeicherte Dokument jederzeit ohne Internetanschluss angezeigt werden. Während des Prozesses geht es nicht nur um Kopieren, sondern auch um Selektieren. Zahlreiche Webseiten sind heutzutage überladen mit Werbung, Tracking-Skripten, Pop-ups oder temporären Bannern, die weder zum Inhalt gehören noch für die spätere Nutzung relevant sind. Gerade im persönlichen Archiv sorgt das Entfernen dieser Komponenten für eine deutlich schlankere und lesefreundlichere Darstellung. Es ist daher sinnvoll, störende Scripte, Iframes oder Werbeeinblendungen im Quelltext zu entfernen.

Wer sich für diese Herangehensweise entscheidet, verbessert nicht nur die Ladezeiten der gespeicherten Seiten, sondern bewahrt auch die inhaltliche Integrität des eigentlichen Texts oder der relevanten Medien. Ein Vorteil der manuellen Methode ist die Flexibilität beim Umgang mit vertraulichen oder bezahlpflichtigen Inhalten. Viele Webarchivierungsdienste konzentrieren sich ausschließlich auf öffentlich zugängliche Seiten, was bedeutet, dass private Accounts, Mitgliedsseiten oder Paywalls oft nicht erfasst werden können. Beim persönlichen Archiv, das lokal gespeichert wird, stellt dies kein Hindernis dar. Nutzer können auch geschützte Seiten sichern und somit sicherstellen, dass beispielsweise eingekaufte Fachartikel, Mitglieder-Newsletter oder andere nicht-öffentliche Inhalte weiterhin zugänglich bleiben.

Da der Prozess relativ aufwendig ist, bietet es sich für Seiten mit ähnlichem Aufbau oder immer wiederkehrendem Design an, eigene Vorlagen zu erstellen. Besonders bei bekannten Nachrichtenportalen, Blogs oder atypischen Webformaten kann ein Template die Archivierung erheblich erleichtern. Dabei werden die relevanten Bereiche der Zielseite manuell extrahiert und in ein einfaches HTML-Gerüst übertragen. Das spart Zeit, da nicht er jedes Mal die Quellseite aufwändig zerlegt werden muss – der Fokus liegt auf dem Inhalt und den dafür notwendigen Medien. Ein bestehendes Webarchiv zu überführen oder zu ergänzen, erfordert ebenfalls viel Geduld.

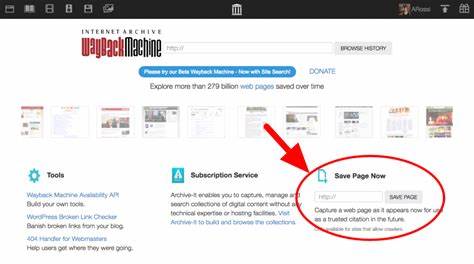

Dabei hilft es, Backups von anderen Archiven – seien es frühere eigene Sammlungen, archivierte Bookmarks oder etwa Snapshots vom Internet Archiv – zusammenzuführen und fehlende Dateien gezielt zu ergänzen. Im Laufe der Zeit kann daraus eine umfassende, sorgfältig gepflegte Sammlung entstehen, die individuell geprüft und kontrolliert wurde. Dabei können auch intelligente Skripte unterstützen, die Routineaufgaben wie das Formatieren von HTML oder das Entfernen von unerwünschtem Markup automatisieren. Die Sicherung der eigenen Webarchive ist ebenso wichtig wie deren Erstellung. Lokale Kopien sollten regelmäßig auf externen Geräten, etwa SSD-Festplatten, gesichert werden.

Zusätzlich empfiehlt sich eine Cloud-basierte Absicherung, um Daten vor physischen Schäden oder Diebstahl zu schützen. Nur so kann gewährleistet werden, dass das Archiv auch wirklich langfristig erhalten bleibt und jederzeit zugänglich ist. Automatisierte Archivierungstools sind unbestritten mächtig und für großes Volumen und schnelle Erfassung unverzichtbar. Sie haben auf institutioneller Ebene den Wandel der digitalen Langzeitarchivierung maßgeblich vorangetrieben. Doch wer die höchste Qualität und Kontrolle anstrebt, stößt bei automatischen Programmen auf Limitierungen.

Sie können häufig JavaScript-basierten Inhalt nicht vollständig erfassen, übersehen bei langsamen Internetverbindungen eingebettete Medien und erzeugen gelegentlich unvollständige oder fehlerhafte Speicherstände. Durch die manuelle Einzelbewertung wird gewährleistet, dass jeder gespeicherte Webseitenschnappschuss tatsächlich vollständig, bedienbar und visuell stimmig ist. Beim Aufbau eigener Webarchive offenbaren sich zudem fundamentale Herausforderungen des heutigen Webdesigns. Viele Webseiten verlassen sich auf Ressourcen von Drittanbietern, deren Services nicht immer dauerhaft garantiert sind. Bild-Hosting-Dienste, Social-Media-Widgets, URL-Shortener oder Tracking-Provider stellen bei einer langfristigen Archivierung eine Schwachstelle dar.

Verwendete Drittanbieterressourcen können ausfallen, Inhalte können verschwinden oder verändert werden, was das ursprüngliche Webseitenbild verfälschen kann. Der sorgsame Umgang mit solchen externen Ressourcen und bestenfalls das lokale Einbinden der Dateien ist daher essenziell. Modernes Webdesign bringt durch responsive Bilder, Lazy-Loading-Technik oder dynamische Inhalte weitere Hürden. Webseiten laden heute verschiedene Bildgrößen und Versionen je nach Gerät und Nutzeroption. Das manuelle Archivieran auf höchste Auflösung zu achten, ist dabei eine pragmatische Lösung.

Jedoch muss jeder Archivierer für sich genau abwägen, welcher Varianten er erhalten möchte – manchmal lohnt es sich, mehrere Versionen zu speichern. Auch bei dynamischen Inhalten und Medien ist zu entscheiden, welche Version zum Zeitpunkt des Speichervorgangs gesichert werden soll. Das größte Problem beim Sammlungserstellen ist häufig nicht der technische Aufwand, sondern die Definition des Umfangs. Was genau gehört zu einer archivierten Webseite? Nur der Artikeltext oder auch eingebundene Videos, Kommentare, externe Links und weiterführendes Material? Die Grenzen sind oft schwammig und erfordern individuelle Bewertungen. Ein Artikel über eine wissenschaftliche Konferenz mag die begleitende Präsentation oder das verknüpfte Forschungspapier unverzichtbar machen.

Eine Faustregel gibt es nicht, sodass die persönliche Handschrift im Archiv eine entscheidende Rolle spielt. Letztlich ist die Entscheidung, sein eigenes Webarchiv aufzubauen, ein Weg, sich der Vergänglichkeit des Internets entgegenzustellen. Für viele Nutzer ist es eine Form der digitalen Selbstbestimmung, die ihnen ermöglicht, wichtige Informationen unabhängig von internetbasierten Diensten dauerhaft verfügbar zu halten. Es kostet Zeit und Mühe, bietet dafür aber eine außergewöhnliche Verlässlichkeit und Qualität. Die Mühe lohnt sich vor allem für jene, die regelmäßig auf Webinhalte angewiesen sind, besonderen Wert auf Authentizität legen oder private Informationen schützen möchten.

Es lohnt sich, mit kleinen Schritten zu beginnen, statt gleich zu versuchen, gigantische Datenmengen zu kopieren. Eine handverlesene Sammlung mit ausgewählten Seiten ist oft wertvoller als ein automatisierter Berg unvollständiger Daten. Schon wenige gesicherte Seiten schaffen eine Sicherheitsreserve und können bei Bedarf jederzeit erweitert und optimiert werden. Insgesamt zeigt das Führen eines handgemachten Webarchivs nicht nur die Vorteile sorgfältiger Dokumentation, sondern eröffnet auch einen anderen Blick auf die Strukturen und Eigenheiten des modernen Internets. Wer sich damit auseinandersetzt, lernt viel über Webgestaltung, Datenmanagement und die Herausforderungen digitaler Langzeitarchivierung.

Es ist ein Projekt, das technisches Verständnis erfordert, kreative Lösungen erfordert und immer auch ein bisschen Geduld und Leidenschaft braucht – aber dafür das eigene digitale Kulturerbe bewahrt.

![2025 EuroLLVM – Adopting Clang -fbounds-safety in practice [video]](/images/3B5867B9-A700-4C2F-8835-FA607D069671)