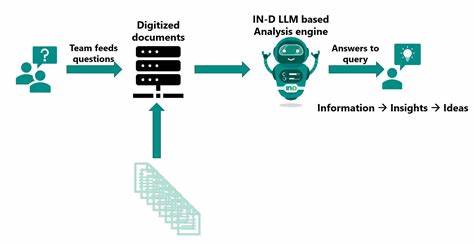

Große Sprachmodelle (LLMs) wie ChatGPT, Claude-3.7-Sonnet und Gemini Flash gehören heute zu den am stärksten diskutierten Technologien im Bereich der künstlichen Intelligenz. Ihre Fähigkeit, menschenähnliche Texte zu generieren, revolutioniert zahlreiche Branchen, von Kundenservice über kreative Texterstellung bis hin zu technischen Anwendungen. Neben der Faszination für diese Technik wächst jedoch auch die Sorge um die Umweltauswirkungen und die tatsächlichen Kosten einer solchen Nutzung. Ein populäres Thema ist dabei die Behauptung, dass ein einzelner Anfrage an ein Modell wie ChatGPT enorme Ressourcen verschlingen soll – etwa die Nutzung von mehreren Flaschen Wasser allein für die Kühlung oder enormer Stromverbrauch.

Doch wie realistisch sind solche Aussagen wirklich? Zunächst ist es wichtig, eine klare Unterscheidung zwischen dem Trainingsprozess der Modelle und der späteren Nutzung, also den „Queries“ oder Abfragen, zu treffen. Die Entwicklung und das Training großer Sprachmodelle sind tatsächlich äußerst ressourcenintensiv. Große Rechenzentren benötigen massive Mengen an elektrischer Energie über Wochen oder sogar Monate hinweg, um Modelle mit Milliarden von Parametern aufwendig zu trainieren. Dabei ist der Stromverbrauch enorm, und auch die damit verbundene Kühlung verlangt beträchtlichen Wasserverbrauch. Das Training eines Modells dieser Größenordnung kann durchaus den jährlichen Energieverbrauch mehrerer Haushalte übersteigen.

Demgegenüber fallen die laufenden Kosten für einzelne Anfragen deutlich niedriger aus. In der Praxis wird das energiesparende und optimierte Inferenzverfahren eingesetzt, welches nach dem Training die modellbasierten Antworten auf Anfragen sehr viel effizienter bereitstellen kann. Ein Nutzer, der eine Frage an ChatGPT stellt, fordert also nur die bereits vorhandene Struktur des Modells auf, eine Antwort zu generieren – keine aufwendige Neuberechnung aller Parameter im Trainingsstil. Um die Größenordnung besser zu verstehen, hilft ein Beispiel aus der Praxis: Ein MacBook M4 Max, das lokal ein mittelgroßes Sprachmodell mit etwa 32 Milliarden Parametern ausführt, verbraucht während der Modellinferenz etwa 120 Watt zusätzlich zur normalen Betriebsleistung. Dieser Verbrauch entspricht ungefähr 0,5 Wattstunden pro generierter Antwort, wenn man von etwa 4 Antworten pro Minute ausgeht.

Hochgerechnet bedeutet das, dass rund 200 solcher Anfragen den Akku eines Laptops komplett entladen könnten. Auch wenn diese Messung im Vergleich zu großen Servern in Rechenzentren steht, zeigt sie dennoch, dass der Stromverbrauch pro Anfrage im einstelligen Wattstundenbereich liegt – was für heutige Hardware relativ moderat ist. Im Vergleich lässt sich das mit anderen Aktivitäten im digitalen Alltag beleuchten. Das Anschauen eines fünfminütigen YouTube-Videos etwa verbraucht grob geschätzt zwischen 3 und 5 Wattstunden, abhängig von der Bildschirmhelligkeit und Netzwerkauslastung. Von daher kann man argumentieren, dass eine einzelne Abfrage an ein Sprachmodell weniger Energie verbraucht als die Wiedergabe von nur wenigen Minuten Medienstreaming.

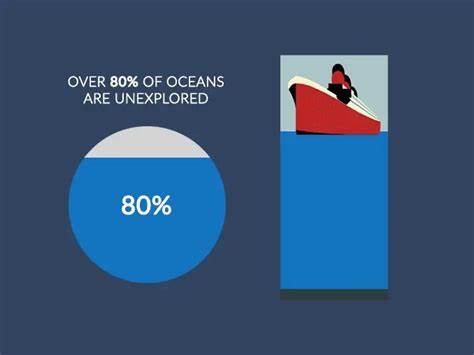

Die populäre Behauptung, dass pro einzelne Anfrage an ChatGPT bis zu drei Flaschen Wasser für die Kühlung verbraucht werden, ist dagegen stark übertrieben. Zwar verbrauchen Rechenzentren für ihre Kühlung tatsächlich große Mengen Wasser, jedoch verteilt sich dieser Verbrauch auf tausende bis Millionen von Anfragen gleichzeitig. Moderne Systeme setzen zudem zunehmend auf effiziente Kühllösungen, wie zum Beispiel luftbasierte Kühlung oder Recyclingverfahren, um Wasserressourcen zu schonen. Die Aussage stammt eher aus einer Übertragung des gesamten Wasserbedarfs eines Rechenzentrums auf einzelne Anfragen ohne Festlegung von realistischen Bezugspunkten. Neben dem unmittelbaren Strom- und Wasserverbrauch stellt sich auch die Frage nach der Umweltbilanz über die gesamte Lebensdauer eines Modells.

Studien zeigen, dass das Training eines einzelnen großen Modells in der Tat erhebliche CO2-Emissionen verursacht. Da jedoch dieselbe trainierte Version für Millionen und Milliarden von Abfragen verwendet wird, kann man den „ökologischen Fußabdruck“ einer einzelnen Interaktion verhältnismäßig klein ansetzen, wenn man ihn auf alle Nutzeranfragen verteilt. Weiterhin spielen auch Hardware-Fortschritte und Softwareoptimierungen eine wichtige Rolle. Aktuelle Modelle werden mit effizienteren Prozessoren und spezialisierter Hardware wie TPUs oder GPUs betrieben, die besser auf AI-Workloads zugeschnitten sind. Zugleich werden Verfahren wie Quantisierung und pruning eingesetzt, die den Energieverbrauch bei der Nutzung deutlich reduzieren können.

Diese technischen Entwicklungen führen dazu, dass die Energieeffizienz bei der Nutzung von Sprachmodellen stetig zunimmt. Ein oft übersehener Aspekt ist auch das Potenzial der KI, Ressourcen einsparen zu helfen. Viele Anwendungen, bei denen LLMs eingesetzt werden, könnten durchaus ressourcenintensivere menschliche Tätigkeiten ergänzen oder effizienter gestalten. Automatisierte Textgenerierung, schnelle Informationsbeschaffung und Datenanalyse sind Beispiele dafür, wie KI langfristig ebenfalls Umweltvorteile erzielen kann, indem zeit- und energieaufwendige Prozesse optimiert werden. Insgesamt zeigt sich, dass die reine Nutzung von großen Sprachmodellen für eine einzelne Anfrage verglichen mit vielen alltäglichen digitalen Aktivitäten nicht so exorbitant ist, wie manche Gerüchte vermuten lassen.

Die eigentlichen Herausforderungen liegen weiterhin im energieintensiven Training und im Betrieb umfangreicher Rechenzentren. Dennoch ist der Trend zu wachsender Effizienz und Nachhaltigkeit in der Branche deutlich spürbar und wird durch Innovationen in Hardware, Software und Infrastruktur stetig vorangetrieben. Für Nutzer, die sich Sorgen um Umwelteinflüsse machen, ist es daher sinnvoll, differenziert zu betrachten, wie, wann und wie oft Sprachmodelle eingesetzt werden. Umfangreiche wissenschaftliche Studien und transparente Umweltberichte der Betreiber können dabei helfen, ein realistisches Bild zu gewinnen. Ebenso wichtig ist es, die gesellschaftlichen Vorteile und den potenziellen Nutzen von KI-Anwendungen gegenüber dem tatsächlichen Ressourcenverbrauch abzuwägen.

Abschließend lässt sich sagen: Die Nutzung großer Sprachmodelle verursacht zwar in der Summe einen nennenswerten Energie- und Ressourcenverbrauch, doch liegen die tatsächlichen Kosten pro Einzelanfrage heute weit unter den oft verbreiteten Horrorzahlen. In einer Welt mit immer mehr digitaler Interaktion ist es notwendig, den Energiebedarf transparent zu machen und weiter an nachhaltigen Lösungen zu forschen. Mit Blick auf den Stand der Technik sind LLMs ein ambitioniertes Werkzeug, dessen ökologische Kosten absehbar und durch Innovationen zunehmend beherrschbar sind.