Die Chemie ist eine der komplexesten Wissenschaften, die tiefgehendes Wissen und präzises logisches Denken erfordert. Seit Jahrzehnten sind es Menschen – speziell ausgebildete Chemiker – die diese Aufgaben übernehmen, von der Interpretation chemischer Strukturen bis hin zur Entwicklung neuer Verbindungen. Doch die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat das Potenzial, die Art und Weise, wie chemisches Wissen genutzt und erzeugt wird, grundlegend zu verändern. Die Frage stellt sich: Wie gut können LLMs wirklich chemisches Wissen verstehen, darauf basierende Argumentationen führen und mit der Expertise von professionellen Chemikern mithalten oder diese gar übertreffen? Große Sprachmodelle sind darauf trainiert, menschliche Sprache in enorm großem Umfang zu verarbeiten. Sie lernen durch das Lesen und Analysieren großer Datenmengen aus Texten jeglicher Art, darunter wissenschaftliche Artikel, Lehrbücher, Datenbanken und vieles mehr.

Besonders spannend ist, dass sie auf Basis dieses Trainings Antworten auf Fragen liefern können, für die sie nicht explizit programmiert wurden. Im Bereich der Chemie hat eine neu entwickelte Benchmark namens ChemBench schlaglichtartig die Leistungsfähigkeit dieser Modelle verglichen mit menschlichen Chemikern beleuchtet. ChemBench umfasst eine Sammlung von mehr als 2700 Fragen und Antworten über ein breites Spektrum chemischer Themen, von grundlegenden Konzepten bis zu komplexen Denkaufgaben. Die Ergebnisse der Evaluierungen sind beeindruckend und überraschend zugleich. Spitzenspiele großer Sprachmodelle demonstrieren in vielen Bereichen der Chemie eine Fachkompetenz, die nicht nur mit der Leistung erfahrener Chemiker vergleichbar ist, sondern diese in gewissen Tests sogar übertrifft.

Dieses fortgeschrittene Niveau spiegelt das Potenzial dieser Modelle wider, zukünftig eine bedeutende Rolle als unterstützende Werkzeuge in Forschung und Lehre einzunehmen. Doch gleichzeitig zeigen die Analysen auch, dass diese Modelle in manchen grundlegenden Bereichen Unsicherheiten besitzen und teilweise übermäßig selbstbewusst antworten, was bei falschen Informationen problematisch sein kann. Einer der zentralen Befunde ist, dass die LLMs in den Themengebieten der allgemeinen und technischen Chemie relativ gut performen, wohingegen sie bei besonders komplexen Fragen der analytischen Chemie oder sicherheitsrelevanten Bewertungen spürbar schwächer sind. Ein Grund dafür ist die begrenzte Fähigkeit mancher Modelle, wirklich strukturelle und stereochemische Details von Molekülen zu analysieren, was für die Interpretation von Spektren oder die Vorhersage von Toxizität essentiell ist. Während menschliche Chemiker dank ihres Fachwissens und ihrer Erfahrung diese Aufgaben oft intuitiv meistern, basieren die Sprachmodelle häufig auf Wahrscheinlichkeiten und Erinnerungen aus ihrem Trainingsdatensatz, ohne tiefergehende molekulare Verständnismechanismen.

Besonders aufschlussreich ist die Tatsache, dass in Prüfungsfragen, die gängig in Lehrbüchern oder bei Zertifizierungen verwendet werden, die Modelle meist sehr gute Ergebnisse erzielen. Dies stellt die Relevanz dieser traditionellen Prüfungsformen infrage, wenn KI-Systeme hardkodiertes Faktenwissen mühelos abrufen und verarbeiten können. Kritisches Denken und komplexere Argumentationsprozesse stehen hierbei im Vordergrund – Fähigkeiten, die auch angemessen in zukünftigen Curricula berücksichtigt werden müssen. Die Ergebnisse der Studie legen nahe, Chemieausbildung neu zu gestalten und statt auf reine Wissensabfrage verstärkt auf kreative und komplexe Problemlösungen zu setzen, die Menschen gegenüber maschinellem Lernen weiterhin im Vorteil sein könnten. Ein weiteres relevantes Thema ist die Frage der Vertrauenswürdigkeit der LLM-Ergebnisse.

Obwohl die Modelle auf Nachfrage ihre eigene Sicherheit bei den Antworten einschätzen sollen, zeigten Untersuchungen, dass diese Selbstbewertung oft nicht zuverlässig ist. Modelle können falsche Antworten mit hoher Sicherheit ausgeben und korrekte Antworten mit geringer Vertrauen bewerten. Für Anwender, insbesondere in sicherheitskritischen Bereichen wie der Toxikologie oder im Umgang mit Gefahrstoffen, stellt dies eine erhebliche Herausforderung dar. Es unterstreicht die Notwendigkeit von menschlicher Kontrolle und weiterführender Forschung, um sowohl die Genauigkeit als auch die Abschätzung von Unsicherheiten bei KI-unterstützten Systemen zu verbessern. Neben rein faktischem Wissen wurde untersucht, wie gut LLMs menschliche Präferenzen in der Chemie nachvollziehen können, zum Beispiel wenn sie gefragt werden, welches Molekül in einem virtuellen Screening bevorzugt wird.

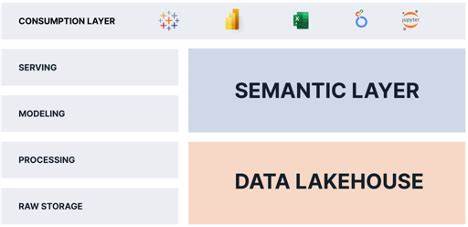

Hier schneiden sie derzeit vergleichsweise schlecht ab, was darauf hinweist, dass intuitive und erfahrenheitsbasierte Entscheidungsprozesse selbst für die fortschrittlichsten Modelle schwer zu imitieren sind. Dies zeigt Potential für ein zukunftsorientiertes Forschungsfeld, in dem KI-Systeme lernen, auf Basis von Preferences und implizitem Wissen bessere Entscheidungen zu treffen. In einer praktischen Perspektive könnte die Zusammenarbeit zwischen LLMs und Chemikern das Feld revolutionieren. Große Sprachmodelle können zur schnellen Informationssuche, Datenanalyse und Ideenfindung eingesetzt werden, wodurch Experten entlastet und Forschungsschritte beschleunigt werden können. Werkzeug-gestützte Systeme, die LLMs mit Zugriff auf Datenbanken, Suchmaschinen oder Rechenwerkzeuge kombinieren, eröffnen zusätzlich erweiterte Möglichkeiten.

Dennoch ist die menschliche Erfahrung unersetzlich, besonders wenn es um ethische Fragen, Sicherheitsbewertungen oder tiefergehende Strukturinterpretationen geht. Die Studie mit ChemBench macht ferner deutlich, dass die Entwicklung von KI-Systemen im Chemiebereich durch gut definierte und breit angelegte Bewertungsstandards maßgeblich vorangebracht wird. Eine flächendeckende Standardisierung solcher Benchmarks ist notwendig, um Fortschritte vergleichbar zu machen, Schwachstellen aufzudecken und die Sicherheit im praktischen Einsatz zu gewährleisten. Die offene Methode der Aufgabenentwicklung und die Bereitstellung von Web-Tools für Experten zur kontinuierlichen Evaluation erhöhen Transparenz und Community-Beteiligung, was essenziell für vertrauenswürdige KI-Anwendungen ist. Die Kombination der Erkenntnisse aus der Evaluierung großer Sprachmodelle mit der Praxis und Expertise von Chemikern bietet zudem spannende Chancen für die Zukunft der chemischen Forschung.

So könnten LLMs als unterstützende digitale Kopiloten fungieren, die auf Basis großer Textmengen neue Hypothesen vorschlagen, Literatur schneller erfassen oder komplexe Reaktionsmechanismen simulieren helfen. Dies wiederum ermöglicht Chemikern, sich stärker auf kreative und konzeptionelle Arbeiten zu konzentrieren, während Routineaufgaben teilweise automatisiert werden. Nicht zu vernachlässigen sind die ethischen und sicherheitsrelevanten Implikationen, die mit dem Einsatz von LLMs in der Chemie einhergehen. Ein besonderes Risiko besteht darin, dass solche Systeme sowohl für den Bau nützlicher als auch potenziell schädlicher Substanzen missbraucht werden könnten. Die Integration von geeigneten Sicherheitsmechanismen und die Förderung verantwortungsvoller Nutzung sind daher zwingend erforderlich, um Missbrauch zu verhindern.

Abschließend lässt sich festhalten, dass große Sprachmodelle im Bereich der Chemie schon heute erhebliche Fortschritte zeigen und in spezifischen Aufgaben menschliche Experten übertreffen können. Dennoch bleibt die Chemie ein Feld, in dem kritisches Denken, Erfahrung und ethisches Bewusstsein eine zentrale Rolle spielen. Die Herausforderung liegt darin, die Stärken beider Seiten optimal zu vereinen, damit menschliches Expertenwissen und maschinelle Intelligenz Hand in Hand für innovative Lösungen sorgen können. In Zukunft werden fortschrittliche chemische Sprachmodelle vermutlich unentbehrliche Hilfsmittel in Forschung, Lehre und industrieller Anwendung sein. Die Weiterentwicklung solcher Systeme, verbunden mit einer neu definierten Chemieausbildung, verantwortungsbewussten Implementierung und einer gemeinsam getragenen Benchmarking-Kultur, wird die Qualität und Effizienz chemischer Arbeit maßgeblich verbessern.

Das Spannungsfeld zwischen wachsenden KI-Fähigkeiten und der Unverzichtbarkeit von menschlicher Expertise wird dabei die zentrale Triebkraft für Innovation und Wandel in den kommenden Jahren sein.