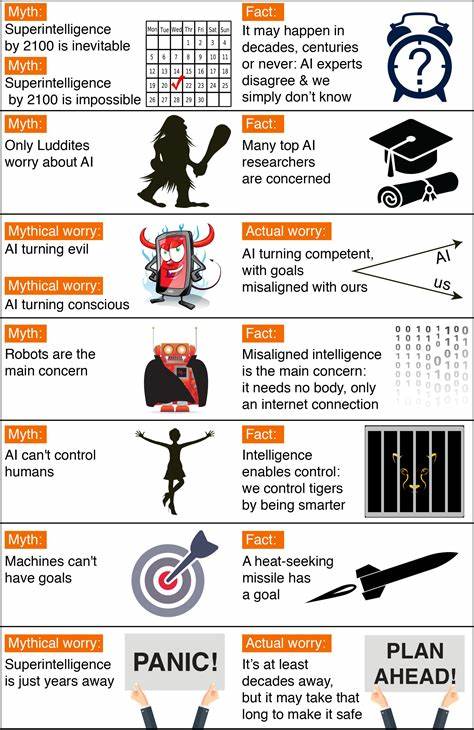

Die Debatte um die Sicherheit Künstlicher Intelligenz (KI) ist in den letzten Jahren immer intensiver geworden. Während technologische Fortschritte rasant voranschreiten, wächst auch die Sorge um Risiken, die durch KI entstehen könnten. Doch trotz intensiver Diskussionen sind viele der Argumentationslinien, die sich rund um KI-Sicherheit entwickelt haben, möglicherweise fehlgeleitet. Ein tieferer Blick auf die Essenz dieser Debatten offenbart eine grundsätzliche Verschiebung in der Perspektive, die notwendig ist, um die Herausforderungen der Zukunft effektiv zu bewältigen. Traditionell wurde über KI-Sicherheit vor allem mit Blick auf Kontrollmechanismen, Regulierung und Risikoaversion gesprochen.

Einige Kritiker stellen AI-Sicherheitsbefürworter gar als technologiefeindlich dar, doch diese Einschätzung trifft nicht zu. In Wahrheit sind viele der Aktivisten und Forscher in der KI-Sicherheitscommunity leidenschaftliche Technikenthusiasten, die sich intensiv mit Chancen und Risiken auseinandersetzen. Ebenso wird oft angenommen, dass diese Gemeinschaft ausschließlich risikoscheu sei, doch gerade die Orientierung an Konzepten wie Erwartungswerten oder Wagnissen mit kleinem Eintrittswahrscheinlichkeit und großem möglichen Nutzen deutet auf einen differenzierten Umgang mit Risiko hin. Dieser vermeintliche Widerspruch lässt sich jedoch besser erklären, wenn man die Debatte nicht als Kampf zwischen technikfreundlich und technikfeindlich oder risikofreudig und risikoscheu betrachtet, sondern durch die Linse von "Dynamismus" versus "Stasis". Der Begriff Dynamismus beschreibt eine Welt, die von ständigem Wandel, Innovation, Wettbewerb und Anpassungsfähigkeit geprägt ist.

Auf der Gegenseite steht Stasis, ein Zustand, der Stabilität, Kontrolle und feste Regeln bevorzugt, häufig auf Kosten von Freiheit und Experimentierfreude. Virginia Postrel hat schon 1998 in ihrem Buch "The Future and Its Enemies" diese Dichotomie geprägt und damit politische Debatten viel besser erfasst als traditionelle Links-Rechts-Muster. Die Beschreibung passt nicht nur auf Wirtschaftsthemen wie Freihandel oder Migration, sondern lässt sich auch hervorragend auf die Herausforderungen der KI-Sicherheit anwenden. Viele vorgeschlagene Sicherheitsmaßnahmen im KI-Bereich laden zum stasistischen Denken ein. Dieses Verlangen nach Kontrolle äußert sich in Vorschlägen, die weltweite, zentralisierte Überwachungssysteme vorsehen, um potenzielle Gefahren frühzeitig zu erkennen und zu neutralisieren.

Ein prominentes Beispiel dafür ist Nick Bostroms "Vulnerable World Hypothesis", die von der Existenz gefährlicher Erfindungen ausgeht, gegen die nur umfassende, zentralisierte Kontrolle helfen soll. Obwohl diese Hypothese eher theoretisch gehalten ist, beeinflusst sie die Diskussion um existenzielle Risiken durch KI stark. Ein weiterer stasistischer Impuls zeigt sich in der Idee, die Anzahl der führenden KI-Entwicklungsteams zu reduzieren, idealerweise auf nur einen Akteur. Damit soll die Kontrolle vereinfacht und Manipulationen durch Nichtregulierbare verhindert werden. Auch später eingeführte Vorschläge wie eine Lizenzierung für das Training fortschrittlicher KI-Modelle zeugen von einem Wunsch nach starrer Regulierung und zentralem Durchgriff.

Die stasisorientierten Maßnahmen eint das Bedürfnis, Risiken auf ein Minimum zu reduzieren und ein «Ein-Bester-Weg»-Modell zu etablieren. Dieser Ansatz ignoriert jedoch die Komplexität und Dynamik der technologischen Entwicklung und der Gesellschaft. Er verlangt Unbeweglichkeit und Überwachung, die sich schwerlich mit Innovationskraft und individueller Freiheit vereinen lassen. Doch das Bemühen um Kontrolle hat auch eine Kehrseite, die sich zunehmend in der Debatte zeigt: Die Konzentration von Macht und die Gefahr der Entmündigung der Menschen. Wenn Staaten oder Konzerne zu viel Macht über KI-Systeme und deren Entwicklung erhalten, kann daraus nicht nur eine technologische Abhängigkeit entstehen, sondern auch ein politisches und gesellschaftliches Ungleichgewicht, das künftige Innovationen und die menschliche Freiheit einschränkt.

Eine dynamistische Haltung hingegen setzt auf Offenheit, Anpassungsfähigkeit und die Förderung von Wettbewerb und Kreativität. Sie akzeptiert das Risiko als notwendigen Teil von Fortschritt und plädiert für ein Rahmenwerk, das flexible Regeln erlaubt und die Dezentralisierung von Entwicklung und Kontrolle unterstützt. Transparenz spielt in diesem Ansatz eine Schlüsselrolle, da sie Individuen und Gruppen die Informationen liefert, die sie benötigen, um selbstbestimmt handeln zu können. Die Förderung von Open-Source-Initiativen und Drittparteien-Audits unterstützt das Prinzip von nachvollziehbaren und durchsetzbaren Verpflichtungen von Akteuren. Die Idee der differenziellen Technologieentwicklung, also der gezielten Beschleunigung von Technologien, die Risiken reduzieren, während gefährlichere Technologien verzögert werden, passt ebenfalls gut in einen dynamistischen Ansatz.

Er ermöglicht es, Risiken zu minimieren, ohne dabei Innovationen zu ersticken. Der Kern der Debatte sollte daher weniger um starren Schutz oder grenzenlose Freiheit kreisen, sondern vielmehr darum, wie eine Balance gefunden werden kann, die menschliche Handlungsmacht und Kreativität bewahrt und zugleich existentielle Risiken minimiert. Die Vorstellung eines zukünftigen Szenarios, in dem KI-Systeme die Kontrolle übernehmen oder Menschen keine Möglichkeit mehr haben, ihren Kurs zu bestimmen, widerspricht dem Prinzip des Dynamismus und somit einer zukunftsfähigen Gesellschaft. Gleichzeitig muss anerkannt werden, dass unkontrollierte Entwicklung ebenfalls große Gefahren birgt. Katastrophale Fehlanpassungen von KI-Systemen oder böswillige Missbräuche können die Grundlage für sämtliche Fortschritte untergraben.

Ein verantwortungsvoller Umgang erfordert daher kritische Reflexionen über die Folgen von Regulierung und über mögliche Nebenwirkungen von Kontrollmechanismen. Die gegenwärtige Diskussion rund um KI-Sicherheit zeigt die Notwendigkeit, alte Paradigmen zu hinterfragen und neue Denkweisen zu etablieren. Die Linse von Dynamismus versus Stasis hilft dabei, die inneren Widersprüche vieler Vorschläge und Ängste verständlich zu machen und einen konstruktiveren Dialog zu fördern. Die Zukunft verlangt nach einem flexiblen, dezentralen Ansatz, der Innovation fördert, menschliche Autonomie schützt und gleichzeitig wirkungsvoll gegen gefährliche Risiken vorgeht. Das mag schwierig erscheinen, doch ein starres Festhalten an Kontrolle um jeden Preis riskiert die Errichtung eines Systems, das letztlich weder sicher noch lebendig ist.

In einer Welt, in der KI immer mächtiger wird, liegt die Herausforderung darin, eine Gesellschaft zu gestalten, die nicht vor dem Unbekannten erstarrt, sondern sich mutig und verantwortungsvoll auf Veränderung einlässt. Dabei darf der Mensch als aktiver Gestalter nicht verloren gehen. Nur so lässt sich eine Zukunft schaffen, die sowohl sicher als auch dynamisch ist – eine Zukunft, in der technologische Innovation und menschliches Wohl harmonisch koexistieren können.