Die rasante Weiterentwicklung von Künstlicher Intelligenz (KI) hat zur Entstehung von sogenannten KI-Agenten geführt, die zunehmend komplexe Aufgaben autonom bewältigen können. Unter KI-Agenten versteht man Systeme, die mithilfe großer Sprachmodelle (Large Language Models, LLMs) eigenständig Entscheidungen treffen, Prozesse steuern und dabei flexibel auf neue Anforderungen reagieren. Die zunehmende Verbreitung dieser Agenten quer durch Branchen zeigt, dass der Schlüssel zum Erfolg nicht in der Komplexität von Frameworks liegt, sondern vielmehr in einfachen, modularen und gut integrierten Konzepten. Unternehmen und Entwickler stehen vor der Herausforderung, effiziente und gleichzeitig zuverlässige Lösungen zu gestalten, die Kosteneffizienz, Performance und Benutzerfreundlichkeit gleichermaßen berücksichtigen. Dabei gilt es, grundsätzliche architektonische Ansätze zu verstehen, die richtige Balance zwischen Workflow-gesteuerten und autonomen Agentensystemen zu finden und gezielt Tools sinnvoll einzusetzen.

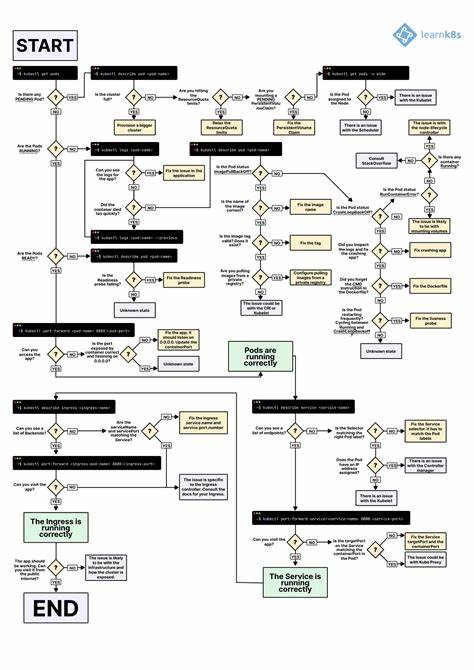

KI-Agenten sind nicht homogen und unterschiedlich definiert. Manche sehen sie als autonome Systeme, die vollkommen eigenständig über längere Zeiträume agieren und verschiedenste Werkzeuge nutzen, um komplexe Probleme zu lösen. Andere verstehen unter Agenten klar strukturierte Abläufe, die einem vorgegebenen Workflow folgen. Eine prägnante Unterscheidung bietet Anthropic: Workflows basieren auf vordefinierten und fest kodierten Pfaden, bei denen die einzelnen Schritte klar orchestriert werden. Agenten hingegen steuern sich dynamisch selbst, entscheiden eigenständig, welche Werkzeuge zu welchem Zeitpunkt verwendet werden und passen ihre Vorgehensweise flexibel an.

Dieses Verständnis bildet die Grundlage für die Entwicklung unterschiedlicher Systeme, die sich an den konkreten Anforderungen und der eingebetteten Komplexität orientieren sollten. Vor allem ist es ratsam, immer mit der einfachsten technischen Lösung zu starten. Nicht jeder Anwendungsfall erfordert unbedingt einen voll autonomen Agenten. Einfache Optimierungen durch gezielte API-Aufrufe an LLMs oder durch Retrieval-Techniken mit passenden Kontextbeispielen reichen oft schon aus, um zufriedenstellende Ergebnisse zu erzielen. Agentensysteme bedeuten in der Regel höhere Latenzen und Kosten, da mehrere Aufrufe und Iterationen involviert sind.

Erst wenn eindeutig messbare Vorteile entstehen, sollte die Komplexität weiter erhöht werden. Für klar definierte Aufgaben, die sich gut in einzelne Schritte zerlegen lassen, bieten sich Workflows an, die auf Prompt-Chaining oder Routing setzen. Prompt-Chaining bedeutet, längere Aufgaben in sequenzielle Teilschritte zu zerlegen, die nacheinander von einem LLM bearbeitet werden. Dadurch lassen sich anspruchsvolle Probleme in handhabbare Abschnitte aufteilen, was die Genauigkeit erhöht und gleichzeitig die Komplexität jeder einzelnen Modellinteraktion reduziert. Beim Routing hingegen wird die Eingabe anhand ihrer Eigenschaften klassifiziert und an spezialisierte Folgeprozesse weitergeleitet.

Dies erhöht die Präzision, da individuell optimierte Modelle und Werkzeugsets für bestimmte Kategorien verwendet werden können. Beispielsweise können Kundenanfragen automatisch in allgemeine Fragen, Rechnungs- oder technische Anfragen eingeteilt und entsprechend unterschiedlich bearbeitet werden. Parallelisierung ist ein weiteres erprobtes Prinzip bei Workflow-basierten Systemen. Dabei werden entweder unabhängige Teilaufgaben gleichzeitig bearbeitet oder mehrfach dieselben Aufgaben durch verschiedene Agenten überprüft, um eine höhere Verlässlichkeit und Vielfalt in den Ergebnissen zu gewährleisten. Diese Technik ist besonders nützlich, wenn Geschwindigkeit eine wichtige Rolle spielt oder wenn eine höhere Sicherheit gegen Fehler erforderlich ist.

Zum Beispiel können LLMs parallel folgende Rollen übernehmen: Einer verarbeitet die Kernanfrage, während ein anderer prüft, ob die Antwort unangemessene Inhalte enthält. Auf diese Weise wird eine feinere Kontrolle möglich, ohne dass ein einzelner Modellaufruf zu überfrachtet wird. Komplexere Aufgaben profitieren vom orchestrator-workers-Ansatz. Dabei übernimmt ein übergeordnetes LLM die Rolle des Koordinators und zerlegt dynamisch die Hauptaufgabe in mehrere Teilaufgaben, die wiederum von sogenannten Worker-LLMs bearbeitet werden. Die Besonderheit dieses Modells ist seine Flexibilität: Die notwendige Anzahl und Art der Arbeitsschritte wird nicht im Vorhinein festgelegt, sondern während der Ausführung basierend auf dem jeweiligen Kontext bestimmt.

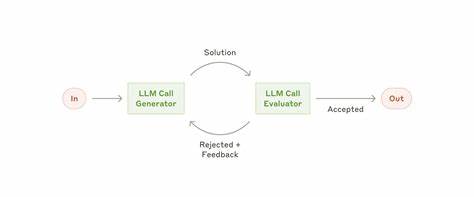

Dieses Muster eignet sich gut für Entwicklungsprozesse in der Softwareentwicklung, bei denen zum Beispiel mehrere Dateien in einem Projekt je nach Task-Anforderung angepasst werden müssen, oder bei komplexen Rechercheaufträgen, die viele Informationsquellen einbinden. Der evaluator-optimizer-Workflow ist ein durchdachtes System, bei dem ein LLM eine erste Lösung generiert, während ein anderes diese Lösung anhand klarer Kriterien bewertet und Rückmeldungen für Verbesserungen gibt. Dieses iterative Vorgehen erlaubt eine kontinuierliche Verfeinerung und erzielt höhere Qualität, etwa bei literarischen Übersetzungen oder bei komplexen Analyseaufträgen. Durch diesen Prozess wird die Qualität der Ausgaben messbar verbessert, was besonders in professionellen Umgebungen mit hohen Anforderungen an Präzision von großem Wert ist. Der Ausbau zu vollautonomen KI-Agenten ist die natürliche Fortsetzung, wenn Aufgaben zu komplex, unvorhersehbar und offen sind, um durch statische Abläufe oder simple Workflows abgebildet zu werden.

Autonome Agenten starten üblicherweise mit einem Input des Nutzers und warten während der Ausführung gelegentlich auf Benutzerfeedback oder Entscheidungshilfen. Dabei ist es extrem wichtig, dass der Agent „ground truth“ aus der Realität bezieht – also Ergebnisse seiner Aktionen überprüft und korrekt in seine Planung einfließen lässt. Die Transparenz über die eigenen Denk- und Entscheidungsprozesse des Agenten ist essenziell, um Vertrauen aufzubauen und Fehler nachvollziehbar zu machen. Die Kosten und das Risiko von Fehlerhäufungen steigen mit dem Autonomiegrad, weswegen umfangreiche Tests und Schutzmechanismen unerlässlich sind. Die meisten erfolgreichen Implementierungen beschränken sich nicht auf die bloße Nutzung eines LLMs, sondern erweitern dieses mit sogenannten Augmentationen.

Das sind zusätzliche Fähigkeiten, die es dem Modell erlauben, Werkzeuge zu verwenden, gezielte Informationen zu suchen oder Gedächtnisinhalte zu speichern. Anthropic hat mit dem Model Context Protocol eine Schnittstelle geschaffen, die eine einfache Einbindung verschiedenster externer Tools ermöglicht. So kann ein Agent durch die Kombination dieser Ressourcen wesentlich effektivere Leistungen erbringen als ein unaugmented LLM allein. Bei der Gestaltung solcher Agent-Systeme ist die Wahl der Entwicklungsumgebung und Frameworks bedeutsam, aber man sollte der Versuchung widerstehen, unnötig komplizierte Strukturen zu etablieren. Frameworks wie LangChain oder Amazon Bedrocks AI Agent Framework können den Einstieg erheblich erleichtern, indem sie typische Aufgaben wie Modellaufrufe oder Tool-Integration vereinfachen.

Doch gerade bei komplexen Frameworks entstehen oft versteckte Abstraktionsschichten, die das Debugging erschweren und die Fehleranfälligkeit erhöhen können. Entwickler sollten daher zuerst grundlegende API-Aufrufe der Sprachmodelle erlernen und verstehen, bevor sie zu umfangreicheren Werkzeugen greifen und dabei immer darauf achten, was genau unter der Oberfläche geschieht. Ein oft unterschätztes Element ist das sogenannte Agent-Computer-Interface (ACI). Es beschreibt die Schnittstelle zwischen dem Agenten und den Werkzeugen, mit denen er interagiert. Für eine reibungslose Arbeit des Systems ist es entscheidend, dass diese Schnittstellen klar dokumentiert werden, gut durchdachte Parameter haben und gegenüber dem Agenten einfach verständlich sind.

Fehleranfällige oder zu komplexe Parameterformate führen schnell zu Fehlbedienungen durch den Agenten. Es empfiehlt sich, den Aufwand in die Gestaltung dieser Schnittstellen mindestens so groß zu halten wie in die Planung der Gesamtarchitektur. Tests mit umfangreichen Beispielinputs helfen dabei, Schwachstellen früh zu identifizieren und zu korrigieren. Die Praxis zeigt, dass KI-Agenten besonders in zwei Bereichen hervorstechen: Kundenservice und Softwareentwicklung. Im Kundenservice unterstützt der Agent nicht nur die klassischen Chatbot-Funktionalitäten, sondern integriert zielgenau externe Datenquellen wie Kundenhistorien, Knowledge-Base-Artikel oder auch Informationen aus CRM-Systemen.

Er kann automatisiert Aktionen durchführen, beispielsweise Rückerstattungen veranlassen oder Support-Tickets aktualisieren. Die Erfolge lassen sich klar anhand der Lösungsrate und Kundenzufriedenheit messen, wodurch nutzungsbasierte Preismodelle entstehen, die das Vertrauen in die Qualität der Agenten unterstreichen. Im Softwareentwicklungsbereich haben sich autonome Agenten als besonders effektiv erwiesen. Von einfachen Codevervollständigungen bis hin zu selbstständigen Problemlösungen können Agenten, unterstützt durch automatisierte Tests, Codequalität ständig verbessern und iterativ anpassen. Benchmarking mit realen GitHub-Issues beweist, dass diese Agenten in der Lage sind, ohne menschliches Zutun valide Pull Requests zu erstellen.

Dennoch bleibt der menschliche Reviewprozess ein unverzichtbares Element, um sicherzustellen, dass die generierten Lösungen den vielfältigen Anforderungen von Softwareprojekten gerecht werden. Zukunftsforscher und Entwickler sollten daher die Entwicklung von KI-Agenten mit einem Fokus auf einfache, transparente, gut dokumentierte Systeme anstreben. Eine ganzheitliche strategische Herangehensweise, bei der technische Machbarkeit, Benutzerfreundlichkeit, Kosten-Nutzen-Verhältnis und Sicherheitsaspekte von Anfang an balanciert werden, erhöht die Erfolgschancen signifikant. Mit der richtigen Methodik lassen sich KI-Agenten nutzen, um die Produktivität zu steigern, neue Innovationspotenziale zu erschließen und komplexe Prozesse zuverlässig zu digitalisieren. Zusammenfassend lässt sich sagen, dass der Weg zu effektiven KI-Agenten nicht über immer komplexere Systeme führt, sondern über das geschickte Nutzen vorhandener Technologien, eine wohlüberlegte Architektur und konsequente iterative Verbesserung.

Durch einfache, modulare Bausteine wie augmentierte LLMs, klar strukturierten Workflows und flexiblen Agentenansätzen können Entwickler leistungsfähige, kosteneffiziente und vertrauenswürdige Anwendungen schaffen, die das volle Potenzial moderner KI ausschöpfen und Ressourcen optimal einsetzen. Der Schlüssel zum Erfolg liegt dabei immer in der Transparenz, Nachvollziehbarkeit und der kontinuierlichen Anpassung an die realen Anforderungen der Anwender.

](/images/EE2DA4C0-5AEB-427B-BFDA-9178458D8423)