Komplexe Systeme prägen in vielfältiger Weise unser tägliches Leben. Sie umfassen große Verkehrsnetze, das Gesundheitssystem, Energieerzeugung sowie viele andere wichtige Bereiche der modernen Gesellschaft. Trotz ihrer entscheidenden Bedeutung sind sie von Natur aus anfällig für Fehler und Versagen. Dieses Versagen ist nicht nur unvermeidlich, sondern ein integraler Bestandteil der Systemdynamik. Ein tieferes Verständnis dieser Prozesse eröffnet neue Perspektiven zur Verbesserung der Sicherheit und Leistungsfähigkeit.

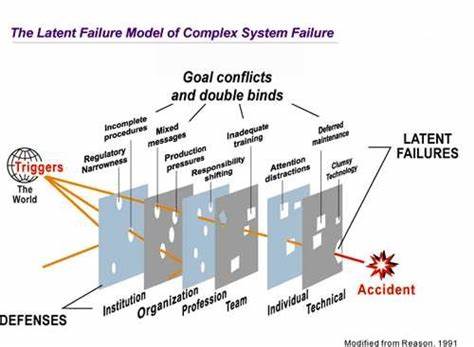

Komplexität bedeutet oft Vielschichtigkeit und schwer vorhersehbare Interaktionen. Anders als einfache Maschinen oder Systeme mit klar definierten Abläufen, arbeiten komplexe Systeme mit zahlreichen Komponenten, die sich gegenseitig beeinflussen und ständig verändern. Gerade diese Wechselwirkungen bergen Risiken, die sich nicht auf eine einzelne Ursache zurückführen lassen. Das Konzept des „Wurzelursachen-Fehlers“ erweist sich hier als unangemessen. Stattdessen ist das Zusammenwirken mehrerer kleiner, scheinbar harmloser Fehler erforderlich, um eine große Störung oder Katastrophe auszulösen.

Ein wesentliches Merkmal komplexer Systeme ist, dass sie inhärent gefährlich sind. Diese Gefährdung ist kein Zeichen von „Schwäche“ oder Fehlentwicklung, sondern ein unvermeidlicher Teil ihrer Funktionsweise. Ähnlich wie ein Flugzeug, das trotz modernster Technik immer der Gefahr eines Ausfalls unterliegt, existiert auch in anderen Systemen eine latente Fehlerquelle. Der Umgang mit diesen Gefahren führt zu einem Aufbau vielschichtiger Verteidigungssysteme. Diese Verteidigungsmechanismen reichen von technischen Sicherheiten wie Backup-Systemen bis zu menschlichen und organisatorischen Maßnahmen.

Beispielsweise helfen Schulungen, klare Arbeitsprozesse und Teamarbeit, potenzielle Fehler frühzeitig zu erkennen und abzuwehren. Trotz all dieser Schutzschichten ist der Ausfall dennoch möglich – meist erst dann, wenn mehrere Schutzmechanismen gleichzeitig versagen. Einzelne Fehler sind häufig unbedeutend und werden meist rechtzeitig abgefangen. Erst das Zusammenwirken verschiedener kleiner Mängel erzeugt Bedingungen, in denen ein Systemversagen unvermeidbar wird. Daher ist die Anzahl der „Fast-Unfälle“ oder gefährlichen Situationen, die glimpflich enden, viel größer als die Fälle echter Katastrophen.

Ein weiterer wichtiger Punkt ist die latente Fehlervielfalt. Komplexe Systeme sind nie frei von Fehlern oder Schwachstellen. Selbst während stabiler Betriebsphasen gibt es eine Vielzahl kleinerer Probleme, die alle für sich genommen nicht zum Systemversagen führen. Diese Fehler sind häufig schwer zu erkennen und noch schwerer vor einem möglichen Unfall zu bewerten. Eine vollständige Beseitigung aller latenten Fehler wäre nicht nur sehr aufwendig, sondern wirtschaftlich oft nicht sinnvoll.

Der Fakt, dass komplexe Systeme ständig mit Fehlern arbeiten müssen, bedeutet, dass sie quasi in einem „defekten Zustand“ betrieben werden. Die vielen redundanten Systeme und der flexible Umgang von menschlichen Bedienern erlauben es, trotz etlicher Schwächen reibungslos zu funktionieren. Untersuchungen nach Unfällen zeigen oft, dass es bereits vorher Beinahekatastrophen gab, die aber abgewendet wurden. Kritiker, die argumentieren, solche Zustände müssten vor einem Unfall erkannt und behoben werden, unterschätzen den subtilen und dynamischen Charakter des Systembetriebs. Die potenzielle Nähe zur Katastrophe ist ein permanenter Begleiter komplexer Systeme.

Menschen, die direkt am operativen Geschehen beteiligt sind, befinden sich oft mitten im Geschehen und sind unmittelbar mit den Risiken konfrontiert. Diese Nähe ermöglicht schnelle Anpassungen, erzeugt aber auch ständige Unsicherheit und Spannungen. Die Möglichkeit eines plötzlichen und schwerwiegenden Fehlers ist deshalb nie fern. Traditionelle Unfallanalysen, die versuchen, eine einzelne „Wurzelursache“ zu identifizieren, greifen zu kurz. Da Unfälle immer aus einer Verkettung verschiedener Faktoren entstehen, sind einfache Erklärungen unzureichend.

Diese Sichtweise ist oft mehr Ergebnis sozialer und kultureller Bedürfnisse nach Schuldzuweisung als objektiver technischer Analyse. Ein realistischer Umgang mit Fehlern muss die komplexen Zusammenhänge und multiple Einflussfaktoren berücksichtigen. Ein weiteres Hindernis bei der Unfallaufklärung ist der sogenannte Rückschaufehler. Wenn das Ergebnis einer Untersuchung bereits bekannt ist, werden die Handlungen der Beteiligten oft kritischer beurteilt, als es zum Zeitpunkt des Geschehens gerechtfertigt gewesen wäre. Es entsteht leicht der Eindruck, Fehler seien offensichtlich gewesen oder hätten vermieden werden können, obwohl dies ohne Vorwissen nicht so klar gewesen ist.

Dieses Phänomen betrifft alle Arten der menschlichen Einschätzung und erschwert eine faire Bewertung. Die Rolle der Menschen innerhalb komplexer Systeme ist ambivalent. Sie müssen sowohl das System zielgerichtet betreiben als auch gleichzeitig dessen Sicherheit gewährleisten. Diese duale Aufgabe ist oft schwer zu vermitteln und wird von Außenstehenden meist nur einseitig wahrgenommen. In Phasen ohne Zwischenfälle liegt der Fokus auf der Produktivität, während nach Unfällen die Sicherheit im Vordergrund steht.

Dabei sind beide Aspekte ständig präsent und eng miteinander verflochten. Hinzu kommt, dass jede Entscheidung der Menschen innerhalb des Systems eine Form von Risiko darstellt. Jede Handlung ist ein „Wagnis“, da immer Unsicherheit über die Konsequenzen besteht. Erfolgreiche Entscheidungen werden oft als selbstverständlich wahrgenommen, während fehlgeschlagene stärker hervorgehoben und kritisiert werden. Das Verständnis, dass alle Handlungen immer einen gewissen Grad an Unsicherheit und Risiko beinhalten, ist entscheidend für ein realitätsnahes Bild menschlichen Handelns in komplexen Systemen.

In komplexen Systemen bestehen häufig bewusste Mehrdeutigkeiten hinsichtlich Arbeitsziele, Ressourcennutzung und Sicherheitsanforderungen. Mitarbeiter vor Ort müssen diese Unklarheiten im Alltag auflösen und sichere Lösungen finden. Nach Unfällen werden deren Entscheidungen häufig als Fehler oder absichtliche Verstöße bewertet. Diese Bewertungen vergessen jedoch oft den Druck und die Zwänge, die in der Praxis herrschen. Menschen sind zudem die anpassungsfähigste und wichtigste Komponente für das reibungslose Funktionieren komplexer Systeme.

Tägliche Anpassungen durch Fachkräfte ermöglichen es, Schwachstellen zu kompensieren, Risiken zu verringern und die Produktion aufrechtzuerhalten. Diese Flexibilität ist essenziell, um auf sich schnell ändernde Bedingungen und unerwartete Situationen zu reagieren. Die Expertise der Mitarbeiter ist unverzichtbar, doch auch sie ist einem ständigen Wandel unterworfen. Technologische Neuerungen, Fluktuationen im Personalbestand und sich verändernde Anforderungen führen dazu, dass Wissen und Fähigkeiten immer wieder erneuert und angepasst werden müssen. Eine kontinuierliche Weiterbildung und das systematische Training neuer Mitarbeiter sind deshalb zentral für die Systemstabilität.

Veränderungen im System bergen sowohl Chancen als auch Risiken. Die Einführung neuer Technologien zielt meist darauf ab, häufige kleinere Fehler zu reduzieren und die Effizienz zu steigern. Gleichzeitig können diese Innovationen neue und bisher unbekannte Fehlerpotenziale schaffen, die schwer erkennbar sind. Die Auswirkungen solcher Veränderungen zeigen sich oft erst nach längerer Zeit, wenn mehrere Neuerungen kumulativ zusammenwirken. Die Art, wie Ursachen verstanden und dargestellt werden, beeinflusst maßgeblich die Wirksamkeit von Sicherheitsmaßnahmen.

Viele Nachbesserungen konzentrieren sich auf vermeintliche menschliche Fehler, was jedoch selten tiefgreifende Verbesserungen bewirkt. Im Gegenteil: Das Hinzufügen neuer Kontrollen und Vorschriften kann das System weiter verkomplizieren und damit neue Fehlerquellen schaffen. Nachhaltige Sicherheit kann nur erreicht werden, wenn das System als Ganzes betrachtet und weiterentwickelt wird. Sicherheit ist keine isolierte Eigenschaft einzelner Komponenten, sondern ein emergentes Merkmal des gesamten Systems. Sie entsteht erst durch das Zusammenspiel von Technik, Mensch und Organisation und unterliegt ständigen Veränderungen.

Deshalb ist Sicherheit kein statischer Zustand, der einfach erreicht und erhalten werden kann, sondern ein dynamischer Prozess. Schließlich ist das tägliche Sicherheitsmanagement vor allem eine Leistung der beteiligten Menschen. Durch ihre kontinuierlichen Anpassungen, Aufmerksamkeit und Erfahrungen gestalten sie die Systemstabilität und verhindern Unfälle. Sie schaffen Sicherheit nicht durch starre Regeln, sondern durch flexible und situationsangepasste Handlungen. Um Sicherheit effektiv zu fördern, müssen Menschen mit einem realistischen „Gefühl“ für Risiken arbeiten können.

Das Wissen um systembedingte Grenzen und die Erfahrungen mit kleinen Fehlern und Beinaheunfällen ermöglichen es ihnen, den kritischen Bereich, das sogenannte „Randgebiet der Beherrschbarkeit“, zu erkennen und entsprechend zu handeln. Ein gezieltes Training und eine Kultur, die offen für solche Erfahrungen ist, sind daher unverzichtbar. Insgesamt zeigt sich, dass komplexe Systeme niemals perfekt sein können. Ihr Versagen ist nicht das Ergebnis von Leichtsinn oder Fahrlässigkeit, sondern ein ausdrückliches Merkmal ihrer Struktur und Funktionsweise. Das Verständnis dieser Realität legt nahe, dass der Fokus im Sicherheitsmanagement weniger auf der Suche nach Schuldigen liegen sollte, sondern vielmehr auf der Entwicklung robusterer, flexiblerer Systeme und der Unterstützung der Menschen, die sie betreiben.

Nur so können wir die fortdauernde Herausforderung meistern, Systemausfälle zu verhindern und gleichzeitig den technologischen Fortschritt voranzutreiben.