Die digitale Welt generiert täglich riesige Mengen an Daten, von denen ein großer Teil in tabellarischer Form vorliegt. Tabellen sind eine der grundlegendsten Datenstrukturen und finden sich in praktisch jedem Bereich – von der Wirtschaft über Sozialwissenschaften bis hin zum technischen Bereich. Die Herausforderung besteht jedoch darin, die in den Tabellen enthaltenen Informationen effizient und präzise nutzbar zu machen, insbesondere wenn es darum geht, diese Informationen mit modernen großen Sprachmodellen (Large Language Models, LLMs) zu verknüpfen, um tiefere Einsichten oder automatisierte Analysen zu erzielen. Die manuelle Analyse und Interpretation großer tabellarischer Datensätze ist zeitaufwendig und fehleranfällig. Hier setzt ein innovativer Ansatz zur automatischen Extraktion von strukturierten Fakten aus Tabellen an, der univariate, bivariate, zeitliche und kausale Analysen integriert und die Ergebnisse in gut formulierten, menschlich verständlichen Aussagen und Frage-Antwort-Paaren bereitstellt.

Dadurch wird nicht nur die schnelle Wissensentdeckung ermöglicht, sondern es entsteht auch ein wertvoller Datenbestand für die gezielte Schulung oder Abfrage von Sprachmodellen. Eine entscheidende Grundlage für die automatische Informationsgewinnung ist das Verständnis der Metadaten, sprich: der Beschreibung der Variablen, ihrer Typen, fehlenden Werte oder zusätzlichen experimentellen Notizen. Die Verwendung von Codebüchern oder Schemas, wie sie beispielsweise in Sozialwissenschaftlichen Datensätzen häufig vorkommen, erleichtert das Mapping von Variablencodes auf menschenverständliche Bezeichnungen. Dieses Mapping erhöht die Qualität der nachfolgenden Analysephasen erheblich. Moderne Ansätze nutzen dabei sowohl automatisierte Parser als auch die Unterstützung durch Sprachmodelle, um Metadaten zu verifizieren und mit domänenspezifischem Wissen anzureichern.

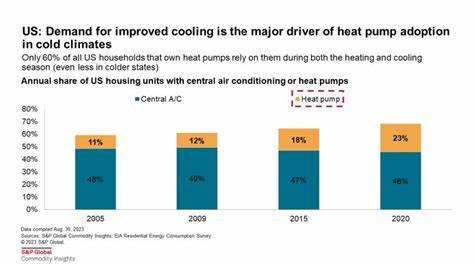

Dies sorgt dafür, dass die Daten nicht nur numerisch, sondern auch semantisch korrekt interpretiert werden. Im nächsten Schritt erfolgt die Einsichtgewinnung durch verschiedene analytische Verfahren. Die deskriptive Analyse betrachtet einzelne Variablen (univariat), etwa deren Mittelwerte, Mediane und Verteilungen. Darüber hinaus werden bivariate Beziehungen untersucht, zum Beispiel durch Korrelationsanalysen oder Mittelwertvergleiche zwischen Gruppen. Auch zeitliche Änderungen in den Daten können so aufgedeckt werden, was insbesondere bei Längsschnittdaten wertvolle Hinweise liefert.

Für den kausalen Zusammenhang werden Regressionsmodelle eingesetzt, die auf Assoziationen hinweisen und, unter Berücksichtigung von Kontrollvariablen, bessere Erklärungen für beobachtete Phänomene bieten. Entscheidend ist, dass die numerischen Resultate nicht nur in Rohform verbleiben, sondern in wohlformulierte, leicht verständliche Erklärungen umgewandelt werden. Dies erleichtert den Anwendern das Verständnis, was insbesondere für das Reporting, Dashboards oder die weitere Verarbeitung durch Sprachmodelle von großem Vorteil ist. Ein innovativer Aspekt liegt in der automatisierten Generierung von Frage-Antwort-Paaren aus den extrahierten Fakten. Mithilfe von Vorlagen und erweiterten Sprachmodellen können aus den statistischen Ergebnissen vielseitige Fragen formuliert werden, die verschiedene Blickwinkel auf die Daten zulassen.

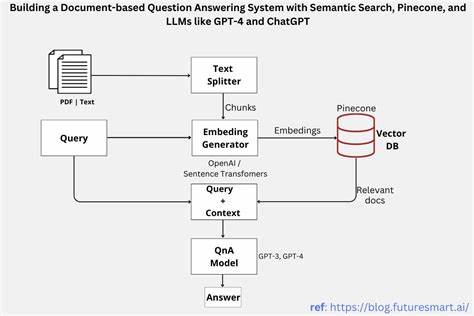

So entsteht eine umfangreiche und vielseitige Datenbank, die sich für die feingranulare Schulung von Sprachmodellen oder für eine effiziente Abfrage im Rahmen von Retrieval-Augmented Generation (RAG) eignet. Dieser Ansatz ermöglicht ein tiefgründiges Querying der Daten, bei dem das Sprachmodell nicht nur auf rohe Daten zugreift, sondern auf bereits strukturierte, interpretierte und kontextualisierte Informationen. Dadurch erhöhen sich die Genauigkeit und Relevanz der Antworten deutlich. Ein anschauliches Beispiel für die Anwendung dieser Methode ist die Auswertung der American National Election Studies (ANES). Dieses umfangreiche Längsschnittdataset, das seit 1948 Daten zu politischen Einstellungen, demographischen Merkmalen und sozialem Verhalten sammelt, bietet eine Vielzahl an Variablen, deren Codes mit verständlichen Labels versehen werden.

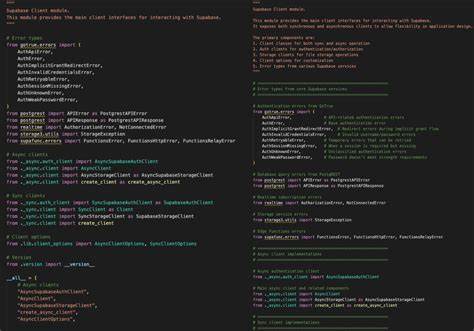

Über automatisierte Skripte erfolgt das Laden der Daten und des zugehörigen Codebuchs, bevor die verschiedenen Analysephasen durchlaufen und Ergebnisse extrahiert werden. So entstehen aussagekräftige Fakten wie Durchschnittsalter, Verteilungen von Geschlechteranteilen, Unterschiede im politischen Interesse zwischen Bildungsgruppen oder zeitliche Veränderungen in der Vertrauenswürdigkeit gegenüber Regierungen. Zudem liefern Regressionsergebnisse kausale Hinweise, zum Beispiel wie politische Ideologie sich auf Unterstützung für bestimmte politische Maßnahmen auswirkt, nachdem wichtige demographische Einflüsse kontrolliert wurden. Durch diese strukturierte Herangehensweise lassen sich enorme Mengen an tabellarischen Informationen verständlich und effizient nutzbar machen. Die Umsetzung umfasst wichtige technische Voraussetzungen wie die Programmiersprache Python, mit Bibliotheken wie pandas für Datenmanipulation, numpy für mathematische Operationen, statsmodels für statistische Modellierung, scikit-learn für maschinelles Lernen und pdfplumber für das Auslesen von Codebüchern aus PDFs.

Die Kombination dieser Werkzeuge mit dem Konzept der automatischen Faktenextraktion bildet die Basis für ein modernes, skalierbares System zur wissensbasierten Datenverarbeitung. Die Vorteile dieses Ansatzes für die Praxis sind vielfältig. Unternehmen können schnell auf fundierte Erkenntnisse aus komplexen Datensätzen zugreifen, ohne Expertenwissen für jede einzelne Analyse zu benötigen. Forschungsinstitute gewinnen eine automatisierte Möglichkeit, Datenbestände systematisch zu erfassen und relevante Fragestellungen zu generieren. Im Bildungsbereich können Lernmaterialien auf Basis echter Datenergebnisse entwickelt werden.

Nicht zuletzt optimiert die Integration der extrahierten Fakten in Retrieval-gestützte Sprachmodelle die Qualität und Schnelligkeit von Antworten bei datenbezogenen Anfragen erheblich. Die Zukunft der Datenanalyse wird durch die Verbindung von tabellarischen Daten und fortschrittlichen Sprachmodellen wesentlich mitbestimmt. Automatisch generierte, klar verständliche Fakten und vielseitige Frage-Antwort-Strukturen machen die komplexe Welt der Daten für Menschen und Maschinen gleichermaßen zugänglich. Der Einsatz solcher Technologien schafft neue Möglichkeiten für datengestützte Entscheidungen, dynamische Berichterstattung und innovative Anwendungen in verschiedensten Branchen. Insgesamt zeigt sich, dass die effiziente Extraktion von nützlichen Informationen aus Tabellen eine Schlüsselrolle im Datenzeitalter einnimmt.

Sie ebnet den Weg für intelligente Assistenzsysteme, die auf präzise und gut strukturierte Daten zugreifen können, um optimale Empfehlungen und Antworten zu liefern. So entsteht ein nachhaltiger Mehrwert, der weit über die reine Datenspeicherung hinausgeht und echte Erkenntnisse ins Zentrum rückt.