Künstliche Intelligenz (KI) entwickelt sich rasant und findet immer mehr Anwendung in unterschiedlichsten Bereichen unseres Lebens. Doch bei aller Begeisterung zeigt sich auch ein unerwartetes Phänomen: Einige Menschen schwärmen von der Effizienz und den Möglichkeiten der KI, während andere ständig auf Fehler, Ungenauigkeiten und Missverständnisse stoßen. Warum aber sind die Erfahrungen im Umgang mit KI so unterschiedlich und teils sogar gegensätzlich? Diese Frage hat viele Experten und Nutzer gleichermaßen beschäftigt und bietet Anlass für eine tiefgehende Analyse. Ein zentraler Grund für die unterschiedlichen Nutzererfahrungen liegt in der jeweiligen Expertise und dem Verständnis der Anwender. Wer tiefgehende Kenntnisse in einem bestimmten Fachgebiet besitzt, erkennt sehr schnell Ungenauigkeiten oder Fehler in den von KI-Systemen generierten Inhalten.

Diese Menschen erwarten präzise und belastbare Ergebnisse, da ihr Wissen sie sensibel für Abweichungen macht. Im Gegensatz dazu sind Nutzer, die weniger spezialisiert sind oder sich nur oberflächlich mit einem Thema befassen, oft geneigt, die Ausgaben einer KI als korrekt oder zumindest nützlich zu akzeptieren. In vielen Fällen reicht ihnen eine „gut genug“-Antwort, die schnelle Orientierung oder eine generelle Hilfestellung bietet, auch wenn sie nicht hundertprozentig stimmt. Der Unterschied im Fachwissen führt dazu, dass hochkompetente Nutzer häufig die Grenzen aktueller KI-Modelle kritisieren, indem sie Fehler offenlegen – etwa falsche technische Details, leicht erkennbare Missinterpretationen oder Übertragungsfehler. Solche Fehler fallen bei weniger erfahrenen Nutzern oft nicht auf oder werden als akzeptabel betrachtet.

Dies erklärt, warum manche Menschen KI als äußerst hilfreiches Produktivitätswerkzeug erleben, während andere deren Ergebnisse als fehlerhaft und unzuverlässig einstufen. Ein zweiter wichtiger Faktor ist die Art der Aufgabenstellung. KI-Systeme, insbesondere Large Language Models (LLMs), sind darauf ausgelegt, plausible und zusammenhängende Texte zu generieren. Dabei stützen sie sich auf die statistische Wahrscheinlichkeit von Wortverbindungen und Mustern, basierend auf riesigen Trainingsdaten. Diese „Generativität“ ermöglicht kreative und flexible Einsatzmöglichkeiten, birgt jedoch die Gefahr von sogenannten „Halluzinationen“ – das bedeutet, dass die KI manchmal Fakten erfindet oder Aussagen trifft, die auf den ersten Blick glaubwürdig erscheinen, aber schlicht falsch sind.

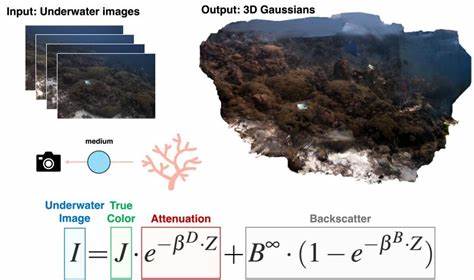

Hier zeigt sich ein gravierender Unterschied zur traditionellen, regelbasierten oder klassisch maschinellen KI, die eher vorhersagbar und begrenzt in den Fehlerarten ist. Bei generativen Modellen hingegen können Fehler in verschiedenen Formen auftreten – von kleinen Ungenauigkeiten bis hin zu kompletten Fehlinformationen, wobei letztere besonders schwer zu erkennen sind. Anwender, die wissen, wonach sie suchen und die Möglichkeit haben, das Ergebnis zu verifizieren, können sich besser vor diesen Fallstricken schützen, während Laien oft unbewusst falsche Informationen übernehmen. Ein anschauliches Beispiel bietet die Anwendung von KI bei der optischen Zeichenerkennung (OCR). Traditionelle OCR-Systeme, wie das bewährte Tesseract, arbeiten mit klar definierten Algorithmen und liefern zwar in seltenen Fällen Fehler wie falsch erkannte Buchstaben, jedoch keine erfundenen Sätze.

Hingegen können generative KI-Modelle beim Versuch, Text aus Bildern herauszulesen, durchaus fehlerhafte oder kreative Neuschöpfungen produzieren, was für Experten sofort erkennbar ist, für Laien aber überzeugend erscheint. Diese Eigenschaft erklärt, warum einige Nutzer mit den Ergebnissen eines KI-basierten OCR zufrieden sind, während andere frustriert ihre Präzision anzweifeln. Weiterhin spielt die Schwierigkeit und Komplexität der Aufgabe eine große Rolle. Aufgaben, die einfache Faktenabfragen oder das Anbieten von kurzen Definitionen umfassen, meistern moderne KI-Modelle oft gut. Sie liefern schnelle, verständliche Ergebnisse und helfen dabei, Aufgaben wie das Erinnern an Befehle, technische Details oder einfache Programmierlösungen zu erleichtern.

Handelt es sich dagegen um komplexe Problemstellungen, die tiefgreifendes Hintergrundwissen oder präzise Informationen verlangen – beispielsweise juristische Beratung oder medizinische Diagnosen – steigt die Wahrscheinlichkeit für Fehler und Fehlinformationen erheblich. Nutzer, die in solchen Bereichen kaum Erfahrung besitzen, erkennen die Mängel oft nicht und vertrauen der KI blind, was gefährlich sein kann. Ebenfalls erwähnenswert ist die Rolle der Nutzererwartungen und der Nutzungskontexte. Menschen, die KI als ein Werkzeug betrachten, das wie ein Autocomplete oder eine Interaktionshilfe funktioniert, sind eher geneigt, die erzeugten Inhalte gründlich zu überprüfen und eigenständig anzupassen. Sie wissen um die inhärenten Fehlerquellen und nutzen KI als Unterstützung, nicht als alleinige Autorität.

Dagegen gibt es Nutzer, die KI-Ausgaben als endgültige, autoritative Antworten ansehen und deren Genauigkeit nicht hinterfragen. Dadurch entstehen unterschiedliche Erfahrungsberichte über die Zuverlässigkeit der Technologie. Eine weitere Ursache für die unterschiedliche Wahrnehmung sind die vielfältigen KI-Modelle und Anbieter auf dem Markt. Nicht alle KI-Systeme werden gleich trainiert oder optimiert. Einige Modelle zeigen bei bestimmten Anwendungen hohe Präzision, andere schwächeln genau dort.

Zudem spielen Faktoren wie Versionierung, Aktualität der eingesetzten KI sowie die Art der Schnittstelle (API, Nutzeroberfläche) eine Rolle, die den Zugang und die Qualität der Ergebnisse beeinflussen. Nutzer, die nicht wissen, welches Modell sie verwenden, oder mit unklaren Plattformkombinationen arbeiten, können inkonsistente Erfahrungen machen. Nicht zuletzt darf die menschliche Komponente nicht unterschätzt werden. Unterschiedliche Menschen gehen verschieden mit Technologie um. Einige sind geduldig und bereit, mit Fehlern umzugehen, diese zu korrigieren und die KI als Helfer zu nutzen, der Arbeitsschritte erleichtert.

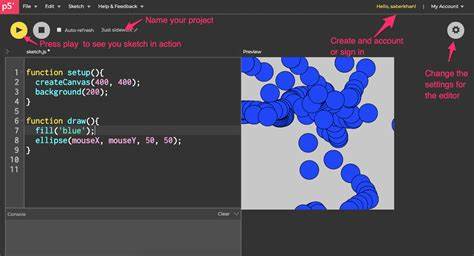

Andere fühlen sich durch Fehler enttäuscht oder entwickeln einen hohen Anspruch an die Technik, der von den heutigen Möglichkeiten noch nicht erfüllt wird. Diese subjektiven Einstellungen führen dazu, dass sich gleiche Technologien teils als Revolution, teils als ungenügend präsentieren. Ein Blick in Diskussionsforen und Kommentare zeigt ebenfalls, dass die Unterscheidung zwischen Anwendern, die KI kritisch hinterfragen und solchen, die eher oberflächlich damit umgehen, stark ausgeprägt ist. Manche berichten von Alltagserlebnissen, bei denen KI ihnen hilft, ohne viel Aufwand Zeit zu sparen – zum Beispiel bei der Erstellung vorbereitender Texte, bei einfacher Informationsrecherche oder Programmier-Hilfen. Andere wiederum erzählen von Frustrationen, etwa wenn KI beim Schreiben von Code fehlerhafte Vorschläge macht, die mehr Nacharbeit erfordern als selbstständige Arbeit.

Insgesamt zeigt sich, dass KI nach wie vor eine unterstützende Technologie ist, keine allwissende Wissensquelle und schon gar kein unfehlbarer Assistent. Die dramatisch unterschiedlichen Erfahrungen aktuelle Anwender machen, sind Ausdruck der vielfältigen Nutzungsweisen, des individuellen Fachwissens und der jeweiligen Bereitschaft, Fehler zu erkennen und mit ihnen umzugehen. Ein realistisches Bild von KI bedeutet, ihre Möglichkeiten zu nutzen, ohne übermäßiges Vertrauen in ihre Fehlerlosigkeit zu setzen. Für Unternehmen und Entwickler von KI-Systemen ergibt sich daraus die Notwendigkeit, die Nutzererwartungen besser zu steuern, transparente Informationen zu Modellen und deren Grenzen zu kommunizieren und Werkzeuge anzubieten, die es leichter machen, KI-Ausgaben zu überprüfen und zu korrigieren. Ebenso sollten Nutzer im Umgang mit KI geschult werden, um deren Qualität realistisch einzuschätzen und verantwortungsvoll damit zu arbeiten.

Abschließend lässt sich festhalten, dass die Frage, warum Menschen so unterschiedlich mit KI umgehen und diese jeweils verschieden bewerten, keine einfache Antwort hat. Sie ist vielmehr ein Kaleidoskop aus technischer, menschlicher und kontextueller Faktoren. Nur wer diese Vielzahl an Einflussgrößen versteht, kann den Umgang mit KI besser gestalten und die kollektive Erfahrung verbessern. Und letztlich liegt der Schlüssel zum erfolgreichen Einsatz von KI darin, sie als Werkzeug in einem kritischen, bewussten und kompetenten Nutzungsrahmen einzusetzen – dann nämlich entpuppt sich die Technologie als das, was sie am besten kann: ein mächtiger Helfer, aber niemals die alleinige Wahrheit.