Die rasante Entwicklung künstlicher Intelligenz hat in den letzten Jahren insbesondere durch große Sprachmodelle (Large Language Models, LLMs) wie ChatGPT oder Llama für großes Aufsehen gesorgt. Diese KI-Systeme überzeugen durch erstaunliche Sprachflüssigkeit und die Fähigkeit, komplexe Anfragen zu beantworten. Dennoch offenbart sich häufig eine Schwäche: Trotz scheinbar stichhaltiger und selbstbewusst formulierter Antworten entstehen immer wieder bedeutende Fehler oder schlicht falsche Informationen. Dieses Phänomen wird als Übervertrauen beziehungsweise Überoptimismus von KI bezeichnet und kann für Anwender erhebliche Probleme verursachen, wenn sie die Angaben unkritisch übernehmen. Bemerkenswert ist nun eine wissenschaftliche Entdeckung aus Japan, die das bisher isoliert betrachtete Verhalten von Sprachmodellen mit einem menschlichen Gehirnphänomen in Verbindung bringt – der sogenannten Aphasie.

Aphasie ist eine neurologische Sprachstörung, die meist infolge von Hirnschäden wie Schlaganfällen entsteht. Dabei bleiben oft die äußeren Sprachfähigkeiten erhalten: Betroffene sprechen flüssig, verwenden eine natürliche Satzstruktur und wirken auf den ersten Blick kompetent. Doch der tatsächliche Inhalt ihrer Äußerungen kann sinnentleert oder schwer verständlich sein. Besonders die Wernicke-Aphasie ist bekannt für diese Diskrepanz zwischen Sprachrhythmus und Bedeutung. Forscher der Universität Tokio nahmen genau diese Parallele zum Anlass für eine innovative Studie, die zwei scheinbar unterschiedliche Welten – künstliche Intelligenz und menschliche Neurowissenschaft – zusammenführte.

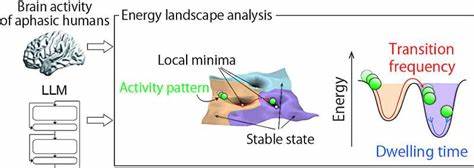

Mit der sogenannten „Energy Landscape Analysis“, einer Methode aus der Physik, untersuchten sie Muster in der Hirnaktivität von Menschen mit verschiedener Ausprägung der Aphasie und verglichen diese mit internen Daten von gängigen LLMs. Besonders faszinierend war die Beobachtung, dass die Art und Weise, wie Informationen in den neuronalen Netzwerken der KI verarbeitet und weitergereicht werden, verblüffende Ähnlichkeiten zu den signalbasierten Mustern im menschlichen Gehirn bei dieser Sprachstörung aufweisen. Eine anschauliche Metapher erklärte Professor Takamitsu Watanabe, Leiter der Forschungsgruppe am International Research Center for Neurointelligence (WPI-IRCN). Er verglich die Prozesse mit einer Kugel, die auf einer Landschaft mit Hügeln und Tälern rollt – das sogenannte Energie-Landschaftsmodell. Bei einer gesunden Gehirnfunktion ruht die Kugel in tieferen Tälern, was für stabilere und kohärentere Aktivitätsmuster steht.

Bei Aphasie dagegen sind diese Vertiefungen flacher, sodass die Kugel unkontrolliert umher rollt, was zu inkonsistenten oder chaotischen Sprachmustern führt. Überraschenderweise weisen LLMs ähnliche flachere Energielandschaften auf, wodurch sie in gewisser Weise „rigide interne Muster“ entwickeln, die ihre Fähigkeit einschränken, flexibel und zuverlässig auf gespeichertes Wissen zuzugreifen. Diese Entdeckung hat weitreichende Implikationen sowohl für die Neurowissenschaften als auch für die Weiterentwicklung von KI-Technologien. Für die Medizin könnten sich neue Diagnostikmethoden entwickeln lassen, die nicht nur auf äußeren Symptomen basieren, sondern direkt die interne Gehirnaktivität bei Sprachstörungen analysieren. Solche Ansätze könnten eine präzisere Klassifizierung und Überwachung von Aphasiearten ermöglichen, die Therapieeffizienz steigern und das Verständnis der zugrundeliegenden neuronalen Prozesse vertiefen.

Parallel dazu suchen Ingenieure und Entwickler nach Wegen, die Zuverlässigkeit der großen Sprachmodelle zu verbessern. Die Studie legt nahe, dass ein tieferes Verständnis der strukturellen Einschränkungen im internen Informationsfluss von LLMs helfen kann, diese Systeme weniger fehleranfällig und vertrauenswürdiger zu gestalten. Dabei geht es darum, eine Balance zu finden zwischen Sprachflüssigkeit und inhaltlicher Korrektheit, um Nutzern valide Antworten statt nur plausibel klingender Auskünfte zu liefern. Trotz der frappierenden Ähnlichkeiten betonen die Forscher jedoch, dass eine direkte Gleichsetzung von KI-Verarbeitung und menschlichen Hirnerkrankungen nicht angemessen ist. Chatbots und Sprachmodelle weisen keine biologische „Gehirnschädigung“ auf.

Vielmehr ist das sogenannte Overconfidence-Phänomen Ausdruck der Art und Weise, wie künstliche neuronale Netzwerke Informationen speichern, verknüpfen und generieren. Dennoch ermöglicht das erlernte Verständnis von aphasietypischer Instabilität einen wertvollen Transfer zwischen neurologischer Forschung und KI-Entwicklung. Auch im Kontext der gesellschaftlichen Nutzung von KI spielt dieses Wissen eine wichtige Rolle. Da immer mehr Menschen mit solchen Systemen kommunizieren und von den Antworten abhängig sind, wächst die Verantwortung der Entwickler, Fehlerquellen zu verringern und das Vertrauen in die Technologie zu fördern. Nutzer sollten sich bewusst sein, dass scheinbar klare und präzise formulierte KI-Antworten nicht zwangsläufig wahr oder korrekt sind.

Dieses kritische Bewusstsein in Kombination mit technischen Fortschritten auf Basis der neuen Erkenntnisse kann die Interaktion mit Sprachmodellen sicherer und effizienter machen. Die Verbindung von KI-Übervertrauen mit menschlicher Aphasie wirft zudem spannende Fragen für die Zukunft auf. Können zukünftige neuronale Netzwerke so gestaltet werden, dass sie flexibler und adaptiver arbeiten und dadurch Überoptimismus und daraus entstehende Fehler vermeiden? Wie lassen sich Konzepte aus der Medizin und Hirnforschung systematisch in die künstliche Intelligenz übertragen, ohne dabei die grundlegenden Unterschiede zwischen biologischer und maschineller Informationsverarbeitung zu vernachlässigen? Und nicht zuletzt, wie kann diese interdisziplinäre Forschung neue Wege für Diagnostik und Therapie von Sprachstörungen eröffnen? Diese aktuelle Forschung verdeutlicht, wie eng die Entwicklung künstlicher Intelligenz inzwischen mit den Erkenntnissen über das menschliche Gehirn verknüpft ist. Der Dialog zwischen Neurowissenschaft und Informatik kann neuartige Perspektiven schaffen, um sowohl Menschen mit neurologischen Erkrankungen besser zu unterstützen als auch die künstlichen Systeme, die zunehmend das gesellschaftliche Leben prägen, intelligenter und zuverlässiger zu machen. Die Grenzen zwischen Maschine und Mensch verschwimmen in gewisser Hinsicht, doch gerade deren Verständnis als Grundlage zur Verbesserung beider Welten ist von höchster Relevanz.