In der Welt der Programmierung und Datenverarbeitung ist die Frage nach der schnellsten Array-Sprache ein immer wiederkehrendes Thema. Besonders die Sprache K, die zur APL-Familie gehört, genießt einen Ruf für hohe Geschwindigkeit. Doch wieviel Wahrheit steckt wirklich hinter den oftmals unbelegten und mysteriös wirkenden Leistungsbehauptungen? Es lohnt sich, einen genaueren Blick auf solche Aussagen zu werfen und sie kritisch zu hinterfragen. Diese Untersuchung beleuchtet die Stärken und Schwächen von K, trennt Fakten von Mythen und ordnet die Leistungseinschätzungen im Kontext aktueller Entwicklungen ein. Zunächst gilt es festzuhalten, dass K keineswegs als schlechte oder langsame Sprache einzustufen ist.

Im Gegenteil, K gehört neben BQN zu den wenigen APL-Verwandten, die uneingeschränkt empfohlen werden können. Seine Implementierungen basieren hauptsächlich auf C und bieten damit eine solide Performance-Grundlage. Allerdings wird die Auswahl einer Array-Sprache einzig und allein auf Basis der Performance häufig als problematisch angesehen. Die Entscheidung sollte vielmehr von Anwendungsfall, Benutzerfreundlichkeit und vorhandener Infrastruktur abhängen – nicht nur von rohen Geschwindigkeitspostulaten. Eine Herausforderung bei der Bewertung von K-Performance ist die Tatsache, dass viele kommerzielle Versionen von K strenge Klauseln enthalten, die das Veröffentlichen von Benchmark-Ergebnissen untersagen.

So verhindern Lizenzbestimmungen von Anbietern wie Shakti oder KX, dass unabhängige Nutzer vergleichende Leistungsreports veröffentlichen. Diese sogenannten DeWitt-Klauseln erschweren die objektive Einschätzung der Geschwindigkeit erheblich, da verlässliche Daten fehlen und sich bewusste Nutzer auf wenige genehmigte Benchmarks oder ungeprüfte Fremdaussagen verlassen müssen. Die verfügbaren Benchmarks, wie beispielsweise STAC-M3 für Zeitreihendatenbanken, verdeutlichen, dass sich K insbesondere im Datenbankbereich mit Fokus auf Zeitreihen gut schlägt. Das liegt daran, dass kdb und Q, die auf K basieren, speziell für derartige Workloads optimiert sind. Dennoch erheben selbst diese Tests keinen Anspruch, die Performance in allgemeinen Array-Operationen wie Sortieren oder Filtern umfassend abzubilden.

Somit ist Vorsicht angebracht, wenn K als „die schnellste Array-Sprache“ bezeichnet wird. Viele der oben genannten Superlative entstehen häufig ohne konkrete Messwerte oder Vergleichsdaten. Interessanterweise halten sich diese Behauptungen seit Jahrzehnten, obwohl andere Sprachen wie J, Dyalog APL oder sogar Python seitdem erhebliche Performancefortschritte erzielt haben. Dies wirft die Frage auf, ob die historische Einschätzung von K aktualisiert werden müsste oder ob der sogenannte Mythos bewusst oder unbewusst gepflegt wird. Im weiteren Kontext ist es relevant, zwischen verschiedenen Arten von Performance zu differenzieren.

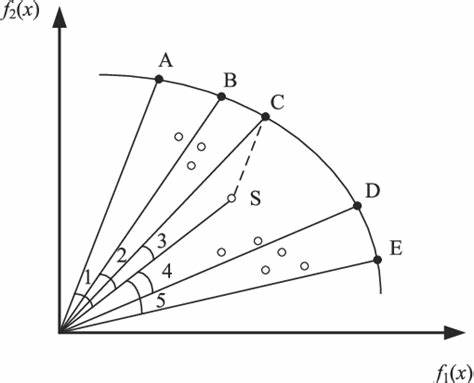

K zeigt durchaus eine gute Ausführungsgeschwindigkeit bei skalaren, also einzelwertigen Berechnungen, wo der Interpreter nicht mit großen Datenmengen umgehen muss. Hier punktet K dank seiner einfachen Sprachstruktur und dem Einsatz von Bytecode, der die Verarbeitung beschleunigt. Dennoch steht fest, dass auch K als dynamisch typisierte Sprache einem Interpreter-Modell folgt und somit grundsätzlich langsamer ist als kompilierte Sprachen wie C oder gar JIT-optimierte Sprachen wie JavaScript. Im Gegensatz zu interpretierter Skalareffizienz können Array-basierte Operationen in K zu Performance-Einbußen führen, wenn zum Beispiel bei Matrizenoperationen jede Zeile einzeln abgearbeitet wird. Andere Sprachen aus der APL-Familie wie Dyalog oder BQN profitieren hier von einer Speicherung der Daten als zusammenhängende Einheit mit festen Speicherschritten (Stride), was eine effizientere Verarbeitung ermöglicht.

Tatsächlich belegte ein Benchmark, dass Dyalog bei der Summierung von Zeilen eines großen Float-Matrix zehnmal so schnell arbeiten konnte wie ngn/k, ein moderner K-Interpreter. Solche Resultate legen nahe, dass K in Szenarien mit intensiven Array-Operationen nicht immer die beste Wahl ist. Ein weiterer Aspekt ist das Missverständnis, dass das Wohlbefinden der Performance von K auf seinem geringen Speicherbedarf im L1 CPU-Cache beruht. Diese Behauptung wird man häufig mit Arthur Whitney, dem Erfinder von K, in Verbindung gebracht und suggeriert, dass die gesamte Logik des Interpreters „in den Cache“ passe und dadurch signifikante Geschwindigkeitsvorteile entstünden. Faktisch zeigt sich jedoch, dass diese Argumentation heute wenig Beachtung verdient.

Der Cache ist zwar eine wichtige Komponente moderner Prozessorarchitektur, jedoch ist der Vorteil durch eine besonders kleine Instructionsgröße eines Interpreters meist minimal. Der L1 Instruction Cache umfasst typischerweise rund 32 Kilobyte und dient dazu, den Prozessor mit häufig genutztem Programmcode zu versorgen. Aber auch andere Interpreter verschiedener Sprachen passen problemlos in diesen Bereich, sodass der Vorteil nicht exklusiv K vorbehalten ist. Darüber hinaus zeigen Messungen mit Tools wie Linux-Perf, dass der Anteil der L1-Cache-Misses, die einer Programmierung zugeschrieben werden können, im Bereich von wenigen Prozent liegt. Selbst optimierte Programme wie BQN oder interpretierte Workloads in J kommen auf ähnliche Zahlen.

Das bedeutet, dass L1-Cache-Effekte bestenfalls marginale Performanceverbesserungen liefern können und nicht die Ursache für die teils aufgebauschten Geschwindigkeitserfolge von K sind. Momentan gibt es interessante Entwicklungen im Bereich Parallelisierung für K-Varianten wie Q und Shakti, die multithreaded Operationen auf mehreren CPU-Kernen ermöglichen. Dies ist ein wichtiger Schritt in eine Zeit, in der Mehrkernprozessoren Standard sind und spürbare Performancegewinne nur durch gleichzeitige Abarbeitung auf mehreren Kernen erzielt werden können. Allerdings ist die Unterstützung von Parallelismus in K bisher noch recht neu und wird in der allgemeinen Diskussion um K-Performance selten berücksichtigt. Die zugrunde liegende Schwierigkeit bei Performancevergleichen von Arraysprachen liegt auch darin, dass sie sehr unterschiedliche Ansätze verfolgen.

So bevorzugen viele Entwickler in der APL-Familie es, möglichst viele Rechenschritte auf möglichst große Datenmengen anzuwenden, um die Interpreter-Overheads zu minimieren. K hingegen zeigt mitunter Schwächen bei hochdimensionalen Operationen oder stark verschachtelten Datentypen, bei denen eine Zeilenweise Verarbeitung höhere Funktionsaufrufkosten verursacht. Daher ist es wichtig, Benchmark-Ergebnisse und Performanceaussagen im jeweiligen Anwendungskontext zu betrachten. Wird K beispielsweise für Zeitreihenanalyse in Finanzmarkt-Datenbanken eingesetzt, kann es gerade hier seine Stärken ausspielen und schneller als andere herkömmliche Arraysprachen sein. Bei allgemeinen Datenverarbeitungsaufgaben oder wissenschaftlichen Berechnungen kann es jedoch durchaus hinter moderneren Konkurrenten zurückbleiben.

Zusätzlich sind Fortschritte in Sprachen wie BQN erwähnenswert, die moderne Compiler-Technologien verwenden und dadurch deutlich schnelleren Code erzeugen können als rein interpretierte Ansätze. Die Fähigkeit, Code vor der Ausführung in maschinennahe Anweisungen umzusetzen, senkt den Interpretationsaufwand drastisch. Im Gegensatz dazu bleiben K-Implementierungen, zumindest von kommerziellen Anbietern, meist interpretativ, was zu einer inhärenten Begrenzung der maximalen Leistung führt. Ein weiterer Kritikpunkt betrifft die Komplexität und Flexibilität von K. K erlaubt keine lexikalischen Closures und hat nur einen Typ von Benutzerfunktionen.

Diese Einschränkungen vereinfachen zwar den Interpreteraufbau und können kleine Performancevorteile bringen, begrenzen aber auch die Ausdruckskraft und damit potentiell die Effizienz komplexer Programme. Es darf auch nicht darüber hinwegtäuschen, dass in realen Anwendungen die Performance oft nicht das einzige oder sogar wichtigste Kriterium ist. Es spielen Aspekte wie Programmierkomfort, Wartbarkeit, Debugging-Möglichkeiten, Community und verfügbare Bibliotheken eine große Rolle. K und seine Varianten punkten hier durch eine spezialisierte Nische und sind hervorragend für konkrete Anwendungsfelder geeignet. Im Fazit zeigt sich: Wild übersteigerte Behauptungen von K als der „schnellsten Array-Sprache“ sind oft wenig fundiert und werden durch fehlende Benchmarks, Lizenzrestriktionen und unklare Vergleichsmaßstäbe genährt.

K ist ohne Zweifel eine leistungsfähige und robuste Sprache mit klaren Stärken, vor allem im Datenbank- und Zeitreihenumfeld. Für reine Array-Verarbeitung bei großen Datenmengen oder komplexen Operationen existieren heute jedoch Alternativen, die zumindest auf bestimmten Gebieten performanter sind. Wichtig ist es, die Performance von K differenziert zu bewerten, den Kontext zu berücksichtigen und sich nicht von Mythen blenden zu lassen. Wer das tut, kann K als starke Option für spezialisierte Aufgaben sehen, ohne von unbelegten Übertreibungen irritiert zu sein. Darüber hinaus bleibt es spannend zu beobachten, wie sich K und andere Arraysprachen in Zukunft weiterentwickeln, insbesondere im Bereich Multithreading und Assembler-optimierte Umsetzung.

Die Diskussion um die schnellste Sprache wird daher sicherlich nicht so schnell enden – aber mit faktenbasiertem Hintergrundwissen ausgestattet, lässt sie sich deutlich besser führen.