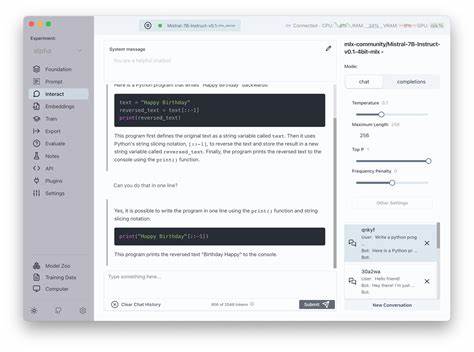

Die Welt der künstlichen Intelligenz erlebt derzeit einen rasanten Wandel. Insbesondere die Transformer-Architektur, die hinter vielen modernen Sprachmodellen und KI-Anwendungen steckt, hat eine enorme Bedeutung erlangt. Transformer Lab, eine führende Plattform für die Entwicklung und das Training von Transformer-Modellen, hat kürzlich eine wichtige Neuerung eingeführt: die Unterstützung für AMD GPUs. Diese Entwicklung verspricht nicht nur mehr Flexibilität und Leistung, sondern könnte auch die Verbreitung und den Einsatz von KI-Technologien deutlich beschleunigen. Bislang waren viele KI-Entwickler auf GPUs von Nvidia angewiesen, da diese hardwareseitig besonders gut auf maschinelles Lernen optimiert sind und umfangreiche Software-Ökosysteme bieten.

Die enge Verzahnung zwischen CUDA, einer proprietären Nvidia-Technologie, und zahlreichen KI-Frameworks führte dazu, dass viele Anwendungen stark von dieser einzigen Quelle abhängig sind. Mit der Erweiterung von Transformer Lab auf AMD GPUs wird nun eine wichtige alternative Hardwareplattform gestärkt, die in der KI-Szene bisher etwas unterrepräsentiert war. Warum ist die Unterstützung für AMD GPUs so bedeutsam? AMD hat in den vergangenen Jahren erhebliche Fortschritte im Bereich der Grafikprozessoren gemacht. Ihre aktuellen GPUs bieten ein hervorragendes Preis-Leistungs-Verhältnis und sind auf viele Rechnungen hinsichtlich paralleler Verarbeitung, großer Speicherkapazität und schneller Datenübertragung ausgelegt. Die Einführung von ROCm, einer offenen Plattform für GPU-Computing, hat vielen Entwicklern den Wechsel erleichtert und die Kompatibilität mit gängigen Frameworks verbessert.

Dies bedeutet, dass Transformer Lab Nutzer jetzt von einer größeren Hardware-Auswahl profitieren und Kosten reduzieren können, ohne dabei Abstriche bei der Performance hinnehmen zu müssen. Für Entwickler und Unternehmen, die Transformer-basierte Modelle in ihre Produkte und Dienstleistungen integrieren möchten, bedeutet diese Erweiterung eine neue Freiheit. Die Nutzung von AMD GPUs kann besonders für jene attraktiv sein, die auf Budget achten müssen oder hybriden Hardware-Pools einsetzen wollen. Da KI-Anwendungen oft extrem rechnerintensiv sind, kann die Wahl der richtigen GPU die Trainingszeiten erheblich beeinflussen und somit auch die Time-to-Market von Produkten verkürzen. Darüber hinaus kann die Unterstützung von AMD GPUs nachhaltigere und diversifiziertere Hardwareumgebungen fördern.

Dadurch werden Abhängigkeiten von einem einzelnen Anbieter reduziert, was langfristig positive Auswirkungen auf Innovation und Wettbewerb hat. In einer Welt, in der künstliche Intelligenz immer wichtiger wird, ist die Aufhebung von Monopolen bei der Hardware eine willkommene Entwicklung. Technisch gesehen erfordert die Integration von AMD GPUs in Transformer Lab nicht nur das Verständnis der GPU-Architektur, sondern auch die Anpassung zahlreicher Softwarekomponenten. Transformer Lab hat hier umfangreiche Optimierungen vorgenommen, um sicherzustellen, dass die Beschleunigung durch AMD GPUs optimal genutzt werden kann. Dazu gehören Kompatibilitäten mit tiefen Lernbibliotheken und der effiziente Einsatz von Speichermanagement.

Ein weiterer Aspekt ist die Community und der Support. Die Erweiterung fördert eine inklusivere Developer-Gemeinschaft, in der sich Nutzer von verschiedenen Plattformen miteinbringen können. Dies kann zu einem schnelleren Wissensaustausch und besseren Innovationen führen. Community-getriebene Verbesserungen und Fehlerbehebungen tragen dazu bei, dass Transformer Lab weiterhin an der Spitze der KI-Entwicklung bleibt. Auch für akademische Einrichtungen und Forschungszentren ist diese Neuerung von Bedeutung.

Viele Universitäten und Institute verfügen über AMD-Hardware und können nun ohne großen Mehraufwand Transformer Lab nutzen, um KI-Modelle zu erforschen und zu trainieren. Dies fördert die Ausbildung von Fachkräften und die Verbreitung von KI-Kompetenzen. Zusammengefasst ist die Einführung von AMD GPU-Unterstützung in Transformer Lab ein Meilenstein, der die Nutzung von Transformer-Modellen demokratisiert und flexibler gestaltet. Die Vorteile sind vielfältig: höhere Erschwinglichkeit, stärkere Unabhängigkeit von einem Anbieter, bessere Verteilbarkeit von Ressourcen und schnellerer Zugang zu modernster KI-Technologie für eine breite Anwenderschaft. In Zukunft ist zu erwarten, dass diese Entwicklung weitere Fortschritte in der Hardware- und Software-Kooperation antreiben wird.

Die offenen Architekturen und die verbesserte Kompatibilität könnten als Vorlage für weitere Projekte dienen, die plattformübergreifende Nutzung von KI-Tools forcieren. Dadurch entsteht ein Ökosystem, das Innovationen begünstigt und eine nachhaltigere Entwicklung im Bereich künstlicher Intelligenz ermöglicht. Die Entscheidung von Transformer Lab, AMD GPUs zu integrieren, ist ein klares Signal dafür, dass die KI-Branche zunehmend Vielfalt und Offenheit anstrebt. Diese Veränderungen werden langfristig dazu beitragen, dass künstliche Intelligenz nicht nur Spitzenforschung bleibt, sondern breitenwirksam in verschiedensten Bereichen des Alltags und der Wirtschaft Verwendung findet.