Die Nutzung großer Sprachmodelle (Large Language Models, kurz LLMs) zum automatisierten Generieren von Programmcode hat in den letzten Jahren erheblich an Popularität gewonnen. Entwickler und Unternehmen setzen verstärkt auf diese KI-basierten Tools, um Entwicklungsprozesse zu beschleunigen, kreative Lösungsansätze zu finden oder repetitive Aufgaben zu automatisieren. Trotzdem gibt es noch viele Bereiche in der Programmierung, in denen LLMs an ihre Grenzen stoßen und suboptimale oder gar falsche Lösungen liefern – insbesondere bei Sprachen mit eigenständigen Konzepten und Einschränkungen, wie Go (Golang). Ein exemplarisches Problemfeld ist die korrekte Implementierung von generischen Methoden in Go, wie beispielsweise das Schreiben der Map-Methode für einen generischen Result-Typ, ähnlich dem aus Rust bekannten Result<T, E>. Go hat in den letzten Jahren Generics eingeführt, was Entwicklern mehr Flexibilität beim Entwerfen wiederverwendbarer Strukturen und Funktionen bietet.

Dennoch bleiben gewisse Beschränkungen bestehen. So sind Methoden mit eigenen Typparametern, also generische Methoden, die eigene zusätzliche Typvariablen neben denen des umgebenden Typs besitzen, in Go offiziell nicht möglich. Die Methodensignatur darf nur die Parameter des Typs nutzen, an dem sie definiert ist. Dieses Sprachdesign resultiert aus Überlegungen zur Komplexitätsreduktion und Lesbarkeit, aber es ist für LLMs, die oft andere Sprachen wie Rust oder C++ als Vorbild haben, eine Stolperfalle. Das Problem wird deutlich, wenn man versucht, eine Map-Methode auf einem Result[T]-Typ zu definieren, um eine Transformation des enthaltenen Werts vorzunehmen, ohne dabei den Fehlerfall zu verändern – genau wie es Rusts Result<T, E> ermöglicht.

Eine typische LLM-Fehlantwort sieht so aus: Die KI schreibt eine Methode mit eigener Typparameterisierung, also etwa func (r Result[T]) Map[U any](f func(T) U) Result[U]. Die Go-Werkzeuge (Compiler oder Linter) melden jedoch, dass solche generischen Methoden nicht zugelassen sind. Nach mehreren Korrekturversuchen unterstützen manche LLMs noch immer falsche Designs, beispielsweise das Einbetten von Wrapper-Typen mit jeweils neuen Map-Methoden, was konzeptionell falsch bleibt und nicht mit den Sprachregeln vereinbar ist. Der Grund für das Beharren der LLMs auf diesem Konzept ist einerseits auf ihr Trainings- und Generalisierungsverhalten zurückzuführen. Die Modelle verarbeiten riesige Mengen an Code und versuchen, Muster wiederzuverwenden.

Da in anderen Sprachen generische Methoden häufig vorkommen, neigen sie dazu, diese Konzepte ohne Einschränkungen auf Go anzuwenden. Andererseits stecken häufig Kontextprobleme dahinter: Die Modelle erhalten zu wenige Informationen über die Spezifika der Sprache oder dessen Einschränkungen und somit bleiben die Antworten ungenau. Aus praktischer Sicht stellt dies eine Hürde dar, da Entwickler sich auf simple generische Ansätze zur Fehlerbehandlung oder Werttransformation in Go verlassen wollen. Aufgrund der Sprachspezifikationen müssen alternative Lösungen eingesetzt werden, wie die Definition eigenständiger Funktionen, die generische Typen verwenden, oder der Rückgriff auf Interface-Implementierungen und weitere Abstraktionen, die jedoch den Fluss der Methodenverkettung erschweren. Die fehlende generische Methode in Go zwingt somit zu komplexeren idiomatischen Umwegen und wirkt der eleganten fluente API-Programmierung entgegen.

Die Analyse dieses typischen Fehlers erscheint vor allem deshalb interessant, weil sie einen Einblick in die Grenzen heutiger KI-gestützter Programmierassistenten gibt. Viele Nutzer hoffen, dass LLMs selbst anspruchsvolle Typensysteme und Sprachbeschränkungen problemlos verstehen und umsetzen können, doch die Realität zeigt, dass die Modelle häufig konservative Muster wiederholen, selbst wenn sie explizit darauf hingewiesen werden, dass diese Designmuster in Go ungültig sind. Sie scheinen förmlich „an einer Idee festzuhalten“, ohne echte Korrektheit sicherstellen zu können. In der Praxis kann dies zur Frustration führen, wenn man merkt, dass das LLM nicht nur einmalig falschen Code generiert, sondern auch bei wiederholter Anleitung und Korrektur immer wieder denselben falschen Lösungsweg propagiert. Besonders schwer ist dies zu beobachten, wenn die Fehler tief in größeren Codebasen versteckt sind und die Fehlersuche aufwendig ist.

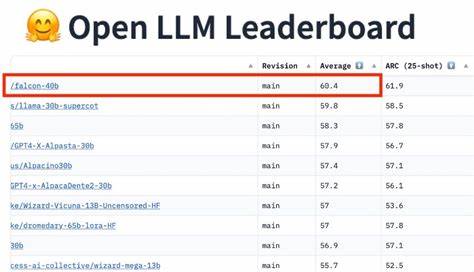

Dies zeigt auch, dass der gegenwärtige Stand von KI-Assistenz bei komplexen und feingliedrigen Sprachkonzepten limitiert ist. Eine mögliche Zukunftsanwendung könnte darin bestehen, spezialisierte Validierungstools für LLM-Ausgaben zu schaffen oder Sammelstellen für typische Fehlarten anzulegen, um die Entwicklung zielgerichteter Modelle oder Post-Processing-Schichten zu unterstützen. Eine solche „Spezimensammlung“ von KI-Bugs in Quellcode wäre nützlich, um einerseits Trainingsdaten zu ergänzen und andererseits Entwickler gezielt auf potenzielle Stolpersteine hinzuweisen. Trotz dieser Einschränkungen sind KI-Modelle für viele andere Aufgaben im Softwareentwicklungsprozess sehr hilfreich. Sie erzeugen oft schnell brauchbaren Boilerplate-Code, helfen bei der Dokumentation, Refaktorisierung großer Codebereiche oder generieren Unit Tests.

Die Strukturierung komplexer generischer Typen, die Anpassung auf spezifische Sprachregeln und das Navigieren der feinen Sprachbarrieren bleiben aber derzeit eher im Bereich fortgeschrittener menschlicher Expertise. Zusammenfassend lässt sich sagen, dass die Nutzung von LLMs im Go-Ökosystem besonders bei der Implementierung von generischen Methoden noch stark limitiert ist. Das Sprachdesign von Go und die damit verbundenen Restriktionen stellen ein inhärentes Hindernis dar, das viele KI-Modelle noch nicht erfolgreich adressieren. Wer mit Go und generischen Typen experimentiert, muss sich dieser Grenzen bewusst sein und eine gezielte Nachbearbeitung der KI-Ergebnisse vornehmen, um valide und idiomatische Lösungen zu erhalten. Diese Erkenntnisse sind entscheidend, um die Erwartungen an moderne KI-Assistenz im Programmierkontext realistisch einzuschätzen und die Entwicklung künftiger Tools besser auszurichten.

Ein offener Diskurs über die Stärken und Schwächen von LLMs, unterstützt durch praktische Beispiele wie das vorliegende, trägt zu einem besseren Verständnis bei und fördert die Entwicklung robusterer, spezialisierter Modelle und Hilfsmittel, mit denen Programmierer tatsächlich effizienter und kreativer arbeiten können.