Künstliche Intelligenz (KI) hat in den letzten Jahren bemerkenswerte Fortschritte gemacht. Insbesondere große Sprachmodelle wie GPT, Llama oder Claude haben Fähigkeiten entwickelt, die für viele Menschen fast magisch erscheinen. Sie formulieren fließende Texte, verfassen Gedichte in unterschiedlichen Stilrichtungen, analysieren politische Reden oder erstellen sogar Programmiercode. Doch wie genau funktionieren diese Modelle, und was sagt das, was sie über uns zu wissen glauben, eigentlich aus? Bei der Interaktion mit diesen Sprachmodellen entsteht nicht nur der Eindruck eines Gesprächspartners mit eigenem Bewusstsein, sondern auch die Illusion, dass diese Systeme über fundierte Kenntnisse und Einsichten über den Nutzer verfügen. Dabei ist die Wirklichkeit weniger mystisch, aber nicht minder faszinierend.

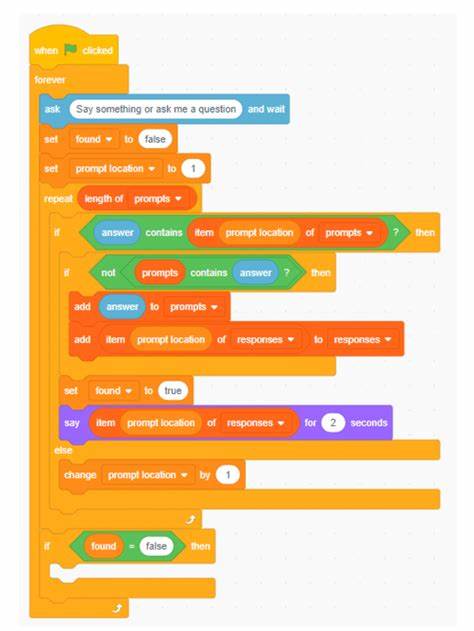

Große Sprachmodelle basieren im Wesentlichen auf der Fähigkeit, Wortfolgen vorherzusagen. Sie greifen auf riesige Datensätze zurück, die eine enorme Menge an geschriebenen und gesprochenen Inhalten aus aller Welt enthalten. Aus diesen Trainingsdaten lernen sie Muster – welche Wörter typischerweise aufeinander folgen, welche Zusammenhänge zwischen Themen bestehen, wie kontextuelle Nuancen funktionieren. Diese Trainingsdaten spiegeln gewissermaßen die gesamte menschliche Kommunikation wider, die im digitalen Raum dokumentiert wurde. Daraus ergibt sich, dass KI-Systeme Annahmen über eine Person treffen, indem sie Wahrscheinlichkeiten für bestimmte Antworten berechnen, basierend auf den Mustern, die sie erkannt haben.

Beispielsweise kann ein Modell, wenn es erfährt, dass jemand sich für Technologie interessiert, Muster finden, die mit dem Nutzerprofil korrespondieren, und aus diesem Zusammenhang weitere Informationen extrapolieren. Es entsteht so der Eindruck, als wüsste die KI direkt etwas über den Nutzer, obwohl sie eigentlich nur Wahrscheinlichkeiten operiert und keine individuellen Daten erinnert. Die Komplexität dieser Modelle ist beeindruckend. Sie bestehen aus Milliarden von neuronalen Verknüpfungen, die gemeinschaftlich Berechnungen durchführen. Dabei lässt sich nicht einfach sagen, welche einzelne Verknüpfung für eine bestimmte Bedeutung steht.

Diese „Black Box“ – ein Begriff, der oft in der KI-Forschung verwendet wird – beschreibt das ebenso interessante wie herausfordernde Problem: Die internen Entscheidungsprozesse sind nicht direkt nachvollziehbar. Selbst Entwickler großer Technologieunternehmen wie Google akzeptieren, dass sie nicht immer genau wissen, warum ein Modell eine spezifische Antwort liefert oder einen ungewöhnlichen Fehler macht. Zugleich wirft diese Opazität wichtige ethische und gesellschaftliche Fragen auf. Wenn KI-Modelle Annahmen über Menschen treffen, wie geht man mit möglichen Fehldeutungen um? Die Modelle können Vorurteile und Verzerrungen aus den Trainingsdaten reproduzieren. Wenn ein Modell fälschlicherweise stereotype Zuschreibungen trifft oder falsche Informationen generiert, kann dies das Vertrauen in die Technologie beeinträchtigen.

Ein zentraler Baustein der modernsten Sprachmodelle sind sogenannte Transformer-Architekturen. Diese sorgen dafür, dass das Modell den Kontext besser „versteht“ – nicht im menschlichen Sinn von Verstehen, sondern als rechnerische Verknüpfung von Datenpunkten über größere Textabschnitte hinweg. So kann das Modell relevant bleiben für den Verlauf eines Gespräches, anstatt jedes Wort isoliert zu betrachten, und damit konsistentere und plausiblere Antworten liefern. Trotz aller Fortschritte sind die Modelle nicht perfekt. Sie können Inhalte „halluzinieren“, also plausibel klingende aber falsche oder erfundene Informationen generieren.

Dies liegt daran, dass sie nicht über eine echte Wissensdatenbank oder ein Faktenprüfsystem verfügen. Sie agieren eher wie statistische Spiegelung der Sprache, die sie gelernt haben, und nicht wie menschliche Experten mit echtem Verständnis. Was bedeutet das für Nutzer? Einerseits können Sprachmodelle als mächtige Werkzeuge betrachtet werden, die unterstütztend sind bei der Informationsbeschaffung, bei kreativen Prozessen und der Automatisierung von Aufgaben. Andererseits ist es wichtig, ein kritisches Bewusstsein dafür zu entwickeln, dass die Antworten dieser Systeme Ergebnisse einer reinen Wahrscheinlichkeitsrechnung sind, kein „Wissen“ im traditionellen Sinne. Die Transparenz der Modelle wird zukünftig eine entscheidende Rolle spielen.

Forscher und Entwickler arbeiten daran, die internen Funktionsweisen besser zu erklären und nachvollziehbarer zu machen. Erklärbare KI (Explainable AI) ist ein Forschungsschwerpunkt, der darauf abzielt, die „Black Box“ zu öffnen und Nutzern verständliche Einblicke in die Entscheidungsprozesse einer KI zu geben. Darüber hinaus ist die Frage der Datensicherheit und des Schutzes persönlich identifizierbarer Informationen zentral. Große Sprachmodelle sollten so gestaltet werden, dass sie keine sensiblen Nutzerdaten speichern oder reproduzieren. Gleichzeitig müssen die Nutzer über die Funktionsweise und die möglichen Risiken dieser Technologien informiert werden.