Die rasante Entwicklung der Künstlichen Intelligenz (KI) hat unsere Arbeitswelt, insbesondere die Softwareentwicklung, nachhaltig verändert. Doch trotz beeindruckender Fortschritte sind viele KI-Werkzeuge enttäuschend konzipiert. Das grundlegende Problem liegt darin, dass wir KI-Tools oft „rückwärts“ bauen – sie ersetzen menschliche Fähigkeiten, anstatt diese zu erweitern und zu fördern. Dabei hat die Natur des menschlichen Lernens und Arbeitens klare Prinzipien, die bei der Gestaltung von KI-Systemen berücksichtigt werden müssen, um eine echte Synergie zwischen Mensch und Maschine herzustellen. Beim Lernen und Wissenserwerb spielt das sogenannte Retrieval Practice eine zentrale Rolle.

Dieses evidenzbasierte Lernprinzip besagt, dass Informationen nicht einfach durch passives Aufnehmen verinnerlicht werden. Stattdessen prägt sich Wissen dauerhaft ein, wenn wir aktiv und mit Anstrengung Informationen abrufen. Dies hat weitreichende Konsequenzen für die Entwicklung von KI-Werkzeugen, die für Menschen nützlich sein sollen. Tools sollten den Nutzer nicht bloß mit Ergebnissen „versorgen“, sondern ihn zum aktiven Denken, Nachfragen und Verständnis anregen. Ein blindes „Informationseinfüttern“ schwächt genau diese Fähigkeit und führt zu einer Abhängigkeit von der Maschine.

Ein weiterer entscheidender Punkt ist, was wir lernen. Nicht nur Faktenwissen ist entscheidend, sondern vor allem Prozesse und Abläufe. Menschen lernen nachhaltig, wenn sie verstehen, wie etwas funktioniert, wie eine Handlungsschritte sinnvoll miteinander verknüpft sind. Ein gutes Beispiel ist das Erlernen von praktischen Fähigkeiten wie dem Backen eines Kuchens: Es ist sinnlos, allein eine Zutatenliste auszuwändig zu lernen, wenn man nicht den Prozess der Zubereitung versteht und anwendet. Entsprechend müssen KI-gestützte Tools den Fokus auf Prozessverständnis legen und Nutzer durch klare, nachvollziehbare Abläufe führen, statt mit rohen Fakten oder automatisierten Komplettlösungen zu überfluten.

Die weit verbreitete Annahme, dass Innovation vor allem durch brillante Einzelleistungen entsteht, blendet eine wesentliche Erkenntnis aus: Große Fortschritte entstammen meist kumulativer Iteration innerhalb von Gemeinschaften. Menschen sind darauf geprägt, kollektiv zu lernen, sich gegenseitig Prozesse zu erklären, Schritte zu verfeinern und auf bestehenden Ideen aufzubauen. Der Mythos des einsamen Genies, das im stillen Kämmerlein bahnbrechende Neuerungen schafft, spiegelt die Realität nur selten wider. Vielmehr gewinnt die Gemeinschaft durch geteiltes Wissen und kontinuierliche Verbesserungen. In der echten Welt verschmelzen Innovation und Problemlösung ineinander.

Wer gut darin ist, Probleme gezielt anzugehen und Ergebnisse fortlaufend im Team zu teilen, trägt maßgeblich zur Innovationskraft bei. Das berühmte Bild vom „Auf den Schultern von Riesen stehen“ beschreibt genau diese Form kollektiver Weiterentwicklung. Entsprechend müssen KI-Tools nicht nur mit Einzelnutzern interagieren, sondern die Zusammenarbeit und Wissensweitergabe in Teams und Organisationen fördern. Viele existierende KI-Anwendungen bieten inzwischen eine „Knopfdrücke-und-magic“-User-Experience: Nutzer klicken auf einen Button, und die KI liefert Vorschläge oder führt automatisch Aktionen aus. Dies ist zwar bequem, entzieht dem Menschen jedoch den zentralen Part der aktiven Informationsverarbeitung.

Die Folge ist eine rapide Degeneration entscheidender Denkfähigkeiten. Wenn Menschen sich darauf verlassen, dass KI „denkt“, verlieren sie die Übung im kritischen Nachdenken und werden letztlich weniger kompetent – ein Teufelskreis, der Innovation eher bremst, als fördert. Die Problematik eskaliert weiter dadurch, dass KI-Systeme auf menschliche Rückmeldungen angewiesen sind, um sich zu verbessern. Sobald der Mensch degradiert und passiv wird, verschlechtert sich auch die Qualität der Daten, mit denen KI trainiert wird. Das reduziert langfristig die Leistungsfähigkeit beider: Die Maschinen werden schlechter, und die Menschen lernen weniger.

Dieses sich selbst verstärkende negative Feedback führt zu ineffizienten Werkzeugen und sinkender Produktivität. Doch es geht auch anders: Statt Maschinen die Arbeit komplett übernehmen zu lassen, sollten KI-Systeme als menschliche Lernpartner konzipiert werden. Ein hilfreiches Bild ist die eines „abwesenden, leicht zerstreuten Lehrers“, der nicht die Antworten einfach vorgibt, sondern zum Nachdenken anregt, irrelevante Themen meiden kann und stets bestrebt ist, dem Lernenden bei der Entwicklung seiner Fähigkeiten zu helfen. Als humoristische Vorstellung könnte man die KI auch als überhebliche Gummiente beschreiben, die die sokratische Methode anwendet und mit kuriosen Ideen zum Schmunzeln bringt – aber immer das Ziel hat, den Menschen zum aktiven Reflektieren zu bringen. Ein erprobtes Schema solcher Lernprozesse lautet „Explain, Demonstrate, Guide, Enhance“.

Zuerst wird das Vorgehen erklärt, dann vorgeführt, anschließend begleitet die KI den Menschen und gibt intelligente Hinweise, und schließlich werden die Erfahrungen reflektiert und sukzessive verbessert. Ein gutes KI-Tool implementiert diese Schritte so, dass menschliches Handeln stets im Zentrum steht. Es unterstützt, anstatt zu ersetzen, es verstärkt, anstatt zu entmündigen. So sollte ein Tool etwa bei der Fehlerbehebung oder Vorfallsmanagement immer damit beginnen, den Nutzer zur aktiven Erinnerung und Anwendung des Prozesswissens aufzufordern. Automatisierte Aktionen wie „Auto-Investigation“ oder „Auto-Fix“ verstoßen gegen diese Prinzipien.

Konkret kann eine KI etwa fehlende Teilschritte vorschlagen, den Prozess übersichtlich darstellen und bei Bedarf Fragen stellen, ohne Eingriffe eigenständig durchzuführen. Durch solche Interaktionen bleibt das Gehirn aktiv und wird kontinuierlich geschult. Im nächsten Schritt erfolgt die Demonstration: Die KI kann menschliche Fragen in die korrekte Syntax der Monitoring-Tools übersetzen, durch animierte Abläufe die Bedeutung einzelner Schritte veranschaulichen oder Nutzern helfen, Oberflächenfunktionen zu finden. Noch wichtiger ist die Vermeidung von Knöpfen mit der Aufschrift „Klick mich, um das zu tun“, die schnell zum blinden Vertrauen auf Maschinen führen und das Verständnis untergraben. Die anschließende Anleitung muss respektvoll erfolgen.

Die KI sollte nicht einfach Probleme lösen, sondern durch sinnvolle Fragen und Hinweise den Nutzer dazu bringen, selbst Lösungen zu entdecken. Dies fördert Widerstandsfähigkeit und eigenständiges Denken. Autoritäres Korrigieren oder unaufgeforderte Korrekturen zerstören Vertrauen und behindern die Lernschleife. Abschließend sollte die KI auf Basis der bisherigen Aktionen Vorschläge machen, wie Prozesse verbessert werden können. Etwa durch die Anlage von Shortcuts für wiederkehrende Aktionen, Optimierung von Abfragen oder Verbesserung von Alarmsystemen.

So entsteht ein dynamischer Lernprozess, in dem die Arbeit stetig effizienter und zugänglicher wird, aber das menschliche Mitdenken im Zentrum bleibt. Dieses Prinzip lässt sich nicht nur auf das Vorfallsmanagement, sondern auch auf andere Entwicklungsbereiche übertragen. Beispielsweise beim Schreiben von Code empfiehlt sich nicht, zuerst fertigen Code per KI generieren zu lassen. Stattdessen sollte der Prozess mit der Erstellung grober Dokumentation oder Architekturdiagrammen beginnen. Anschließend werden Tests definiert und erst dann der Code iterativ generiert.

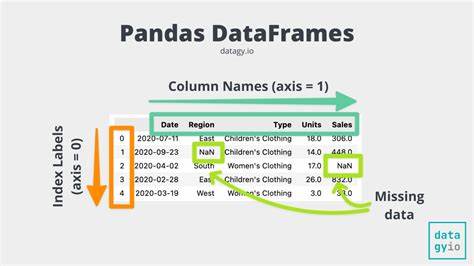

So steht von Anfang an ein konzeptioneller Rahmen, der es dem Menschen ermöglicht, fundierte Entscheidungen zu treffen und die Qualität objektiv zu bewerten. Die KI wird somit zum Co-Autor und nicht zum blinden Generator. Überdies birgt KI das Potenzial, teamübergreifende Zusammenarbeit grundlegend zu verbessern. Gerade in großen Organisationen stehen häufig Customer Support, Entwicklerteams und andere Abteilungen vor dem Problem, sich in komplexen Situationen schnell und korrekt abzustimmen. Künstliche Intelligenz kann hier als Übersetzer und Moderator fungieren: Support-Mitarbeiter können erste Anfragen an Entwickler richten, die KI hilft, vorläufige Antworten zu formulieren, und anschließend wird das Entwicklerteam eingebunden, um die Informationen zu verifizieren und präzisieren.

So entstehen deutlich effizientere Kommunikationswege, während alle Beteiligten im Fokus behalten, was technisch präzise und zugleich für Nicht-Techniker verständlich ist. Trotz des enormen Potenzials fehlt es aktuell noch an einer breitflächigen Akzeptanz für solche innerbetrieblichen Verbesserungen. Budgetrestriktionen und Prioritätensetzungen seitens der Führungskräfte erschweren die Umsetzung neuartiger, lernförderlicher KI-Lösungen. Doch genau hier liegt ein großer Hebel für Produktivitäts- und Innovationssprünge. Letztlich ist es an der Zeit, die Entwicklung von KI-Tools grundlegend neu zu denken und sie konsequent menschzentriert zu gestalten.