In den letzten Jahren hat die rasante Entwicklung künstlicher Intelligenz (KI) vor allem durch die Fortschritte im Deep Learning Aufmerksamkeit erregt. Neuronale Netzwerke erbringen bemerkenswerte Leistungen in Bereichen wie Bild- und Spracherkennung, natursprachlicher Verarbeitung und autonomen Systemen. Doch trotz dieser Erfolge bleiben die eigentlichen Mechanismen, mit denen diese Modelle komplexe Aufgaben lösen, oft undurchsichtig. Die mechanistische Interpretierbarkeit ist eine Forschungsrichtung, die genau an diesem Punkt ansetzt: Sie versucht, die zugrunde liegenden Funktionsprinzipien von KI-Systemen nachvollziehbar und transparent zu machen. Dies ist nicht nur aus akademischem Interesse wichtig – es ist eine Voraussetzung, um KI-Systeme sicher, verlässlich und ethisch vertretbar einzusetzen.

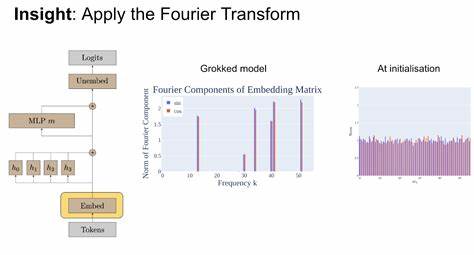

Mechanistische Interpretierbarkeit zielt darauf ab, die internen Repräsentationen und Berechnungsprozesse neuronaler Netzwerke Schritt für Schritt zu analysieren und zu verstehen. Dabei wird nicht nur oberflächlich betrachtet, wie das Modell auf Eingaben reagiert, sondern es werden im Detail die Einheiten, Module und Zwischenschichten untersucht. Die Idee ist, herauszufinden, welche Arten von Konzepten und Algorithmen das Netzwerk gelernt hat und wie diese zusammenwirken, um die vom Modell erwünschten Ausgaben zu erzeugen.Trotz vieler vielversprechender Ansätze gibt es noch zahlreiche offene Probleme, die den Fortschritt in der mechanistischen Interpretierbarkeit bremsen. Ein grundlegendes Hindernis ist die Komplexität moderner Modelle: Die Anzahl der Parameter erreicht oft mehrere Milliarden, und die Struktur der Netzwerke ist tief und vielschichtig.

Dadurch ist es sehr schwierig, klare, allgemein gültige Beschreibungen ihrer Arbeitsweise zu formulieren. Die Modelle sind weder vollständig transparent noch lassen sich ihre internen Abläufe leicht in menschliche Begriffe übersetzen.Ein weiteres Problem liegt in der Skalierbarkeit vorhandener Interpretationsmethoden. Viele Techniken funktionieren nur bei relativ kleinen oder speziell ausgestatteten Modellen. Bei größeren Systemen versagen diese Methoden oft oder liefern nur bruchstückhafte Einsichten.

Daher besteht ein dringender Bedarf an Werkzeugen und Konzepten, die sich auf realistisch eingesetzte Modelle anwenden lassen und dort robuste Informationen über die interne Arbeitsweise liefern können.Neben technischen Herausforderungen spielt auch die Zielsetzung der Interpretierbarkeit eine wesentliche Rolle. Je nach Anwendung unterscheiden sich die Anforderungen: Für Sicherheitsanalysen ist es wichtig, potenzielle Fehlverhalten vorherzusagen und zu verhindern. In wissenschaftlichen Untersuchungen geht es darum, Erkenntnisse über Intelligenz und Lernen zu gewinnen. Für Entwickler wiederum stehen praktische Verbesserungen der Modellleistung und Fehlersuche im Vordergrund.

Die mechanistische Interpretierbarkeit muss also dazu beitragen, diese unterschiedlichen Zielsetzungen zu unterstützen, was hohe Anforderungen an Flexibilität und Anpassungsfähigkeit der Methoden stellt.Auch ethische und gesellschaftliche Fragestellungen sind eng mit der Interpretierbarkeit verbunden. Transparente KI-Systeme sind Voraussetzung für Vertrauen und Akzeptanz bei Nutzern und Regulierungsbehörden. Unklarheiten über interne Mechanismen erhöhen das Risiko von Fehlverhalten, Diskriminierung oder unerwünschten Nebenwirkungen. Gleichzeitig erfordert die Offenlegung von Modellen und deren Funktionsweise einen verantwortungsvollen Umgang mit Sicherheit und Datenschutz.

Mechanistische Interpretierbarkeit muss daher nicht nur technisch exzellent, sondern auch sozialverträglich gestaltet werden.In der Forschung zeichnet sich ab, dass ein interdisziplinärer Ansatz sinnvoll ist, um die offenen Probleme zu bewältigen. Kombinationen aus maschinellem Lernen, kognitiver Wissenschaft, Mathematik und Informatik können dabei helfen, neue Perspektiven und Methoden zu entwickeln. Die Zusammenarbeit zwischen theoretischen und angewandten Wissenschaftlern sowie Praktikern aus der Industrie ist entscheidend, um Interpretierbarkeit effektiv umzusetzen.Zukunftsweisend ist auch die Entwicklung von Benchmark-Datensätzen und standardisierten Evaluationsverfahren, die es erlauben, Interpretierbarkeitsmethoden objektiv zu vergleichen und zu verbessern.

Solche Instrumente können helfen, Fortschritte messbar zu machen und den Weg zu robusteren, besser erklärbaren KI-Systemen zu ebnen.Darüber hinaus eröffnen technologische Innovationen, wie der Einsatz von sogenanntem „Neuron Probing“ oder das Reverse Engineering neuronaler Module, vielversprechende Möglichkeiten. Diese Methoden erlauben es, spezifische Teilfunktionen innerhalb eines Modells zu isolieren und zu analysieren, wodurch sich die Komplexität der Gesamtsysteme besser bewältigen lässt.Nicht zuletzt ist es wichtig, die Übersetzung mechanistischer Erkenntnisse in verständliche Erklärungen für verschiedene Zielgruppen zu fördern. Wissenschaftler, Entwickler, ethische Kontrolleure und Laien benötigen unterschiedliche Formen von Erklärungen, die technisch rigoros und zugleich zugänglich sind.

Mechanistische Interpretierbarkeit steht somit an einer entscheidenden Schwelle: Trotz signifikanter Fortschritte in den letzten Jahren bleibt noch viel zu tun, um tieferliegende Einblicke in die Funktionsweise neuronaler Netzwerke zu erlangen. Die Bewältigung der offenen Probleme wird maßgeblich dazu beitragen, KI-Systeme sicherer, leistungsfähiger und gesellschaftlich akzeptabler zu machen und gleichzeitig unser Verständnis von Intelligenz grundlegend zu erweitern. Die kommenden Jahre versprechen daher spannende Entwicklungen und zahlreiche neue Erkenntnisse in diesem vielversprechenden Feld.