Verteilte Systeme sind als Rückgrat moderner IT-Infrastrukturen unverzichtbar. Sie ermöglichen skalierbare, ausfallsichere und performante Anwendungen und Dienste – von Cloud-Plattformen und Datenbanken bis hin zu Microservices-Architekturen. Doch trotz vieler bewährter Mechanismen wie Timeouts, Retries, Load Balancing und Failover kann es zu subtilen Ausfallmodi kommen, die schwer zu diagnostizieren sind. Ein solcher kritischer Zustand ist der metastabile Ausfall, bei dem das System nicht abstürzt, sondern in einem Zustand verharrt, der von Selbstverschlechterung und Leistungsverschlechterung geprägt ist, ohne dass eine Erholung eintritt. Verstehen und Analysieren dieser metastabilen Zustände ist zentral, um robuste und zuverlässige Softwareinfrastrukturen zu gestalten.

Metastabile Ausfälle sind charakterisiert durch ein komplexes Zusammenspiel von Feedbackschleifen innerhalb des Systems. In vielen verteilten Anwendungen sind Retry-Mechanismen implementiert, um temporäre Fehler abzufangen und die Zuverlässigkeit zu sichern. Diese Wiederholungen erhöhen jedoch in Fehlerzeiten die Last und können Warteschlangen zum Überlaufen bringen. Dabei entstehen Rückkopplungen, die sich gegenseitig verstärken: Zeitüberschreitungen führen zu neuen Retries, diese belasten die Warteschlangen, welches wiederum zu längeren Antwortzeiten führt. Das System befindet sich in einer sich selbst erzeugenden Abwärtsspirale, aus der es ohne externe Intervention nicht entkommt.

Die Folgen sind suboptimale Auslastung trotz ständiger Aktivität, gesteigerter Ressourcennutzung sowie eingeschränkte Verfügbarkeit und Benutzererfahrung. Erste theoretische Untersuchungen zu metastabilen Ausfällen wurden bereits in der Forschung zu verteilten Systemen und deren Fehlertoleranz angestellt. Ein zentraler Beitrag dazu war die Analyse von mechanistischen Modellen, die das Verhalten der Warteschlangen und Retry-Mechanismen abbilden. Mit Methoden der Warteschlangentheorie, wie kontinuierlichen Zeit-Markov-Ketten (CTMC), konnten Wahrscheinlichkeitsverteilungen von Systemzuständen modelliert und gefährliche Schwellen diverser Parameter identifiziert werden. Diese Modellierung ermöglicht es, Bereiche zu erkennen, in denen das System instabil wird und in die metastabile Phase übergeht.

Hier zeigt sich häufig ein kritischer Wendepunkt: Sobald eine bestimmte Anzahl von Warteschlangenlängen und Wiederholversuchen überschritten ist, kippt das System regelmäßig in den metastabilen Zustand. Neben CTMC bieten diskrete Ereignissimulationen (DES) eine detailliertere, realitätsnähere Sicht auf das System. Durch das Nachbilden einzelner Ereignisse, wie Request-Ankunft, Servicebearbeitung, Timeouts und Retries, können komplexe Abläufe nachvollzogen, Metriken gesammelt und das Entstehen metastabiler Zustände bildhaft nachvollzogen werden. Operatoren und Entwickler profitieren hier von einem „Aha-Erlebnis“, indem sie sehen, wie sich die Rückkopplungsschleifen auswirken und wann genau die Stabilität verloren geht. Durch diese granularen Simulationen lassen sich gezieltere Optimierungsansätze formulieren.

Ein weiterer Fortschritt zur Analyse metastabiler Phänomene sind Emulationsansätze. Dabei wird der reale Produktionsbetrieb nachgeahmt, allerdings mit simplifizierten Komponenten, um konzentrierte Belastungstests durchzuführen. Diese Emulationen dienen primär dazu, die Vorhersagen der theoretischen Modelle und Simulationen zu validieren. Sie bestätigen häufig die Muster metastabiler Ausfälle in einer kontrollierten Umgebung, was das Vertrauen in die entwickelten analytischen Tools erhöht. Schließlich bildet der reale Stresstest den Goldstandard auf der Untersuchungsskala.

Trotz seiner hohen Kosten und Komplexität ist er unerlässlich, um die Wirksamkeit von Gegenmaßnahmen zu prüfen und Szenarien unter möglichst realistischen Bedingungen zu testen. Allerdings wird ein solcher Test erst nach Vorauswahl kritischer Zustandsbereiche sinnvoll, was die vorgestellten Analysen und Simulationsschritte unentbehrlich macht. Die Ursachen für metastabile Zustände sind eng mit der Architektur eines verteilten Systems verknüpft. Besonders kritisch sind Fehlermuster, bei denen Fehlerbehandlungsschleifen unkontrolliert eskalieren. Die Immunisierung des Systems gegenüber Fehlern – durch Retries, Timeout-basierte Recovery oder Backoff-Strategien – funktioniert nur so lange effektiv, wie diese sich gegenseitig nicht überlagern und verstärken.

Komplexe Abhängigkeiten zwischen Komponenten können dazu führen, dass Fehler sich über mehrere Systemgrenzen hinaus ausbreiten und resonante Rückkopplungen erzeugen. Diese Art der Komposition von Systemteilen stellt eine besondere Herausforderung dar, da rein komponentenbasierte Analysen die Gefahr unterschätzen können. Ein interessantes konzeptuelles Framework zur Beschreibung metastabiler Ausfälle ist die Analogie zur Selbststabilisierung in verteilten Systemen. Hier wird angenommen, dass ein global definierter Systemzustandswert – beispielsweise die Gesamtbelastung – normalerweise in Richtung eines stabilen Fixpunkts abnimmt, der den gesundheitsfördernden Zustand repräsentiert. Beim Eintritt des metastabilen Becken sammelt sich das System jedoch in einem lokalen „Attraktor“, aus dem eine Erholung ohne externe Impulse unwahrscheinlich ist.

Einige Stochastikmodelle legen nahe, dass zufällige Ereignisse das System theoretisch aus diesem Zustand herauskatapultieren könnten, was aber in der Praxis oft nicht geschieht. Für praktische Betreiber von verteilten Systemen ist die Prävention metastabiler Ausfälle von hoher Bedeutung. Optimale Parametrisierung der Retry-Konzepte, Begrenzung von Warteschlangen sowie intelligente Laststeuerungsmechanismen sind essenziell. Eine zu hohe Zahl an Wiederholungen kann potentiell dem System mehr schaden als helfen. Adaptive Techniken, die den Retry-Verhalten auf aktuelle Systemmetriken ausrichten, verbessern die Resilienz deutlich.

Auch Lastabschneideverfahren (Load Shedding), die kritische Anfragevolumina gezielt reduzieren, um den Systemzustand zu stabilisieren, können helfen, müssen jedoch mit Vorsicht eingesetzt werden, um keine neuen Rückkopplungen auszulösen. Darüber hinaus ist das frühzeitige Erkennen von Vorboten metastabiler Zustände ein aktives Forschungs- und Entwicklungsfeld. Laufzeitmessungen wie Verzögerungen, Queue-Längen, Retry-Raten, aber auch interne Metriken der Ressourcenbelastung, können genutzt werden, um Grenzwerte zu detektieren. Intelligente Monitoring- und Alertsysteme, ergänzt durch maschinelles Lernen, könnten künftig das Risiko metastabiler Phasen besser prognostizieren. Noch wichtiger ist allerdings das systematische Design von Software, das solche Rückkopplungsschleifen von vornherein vermeidet.

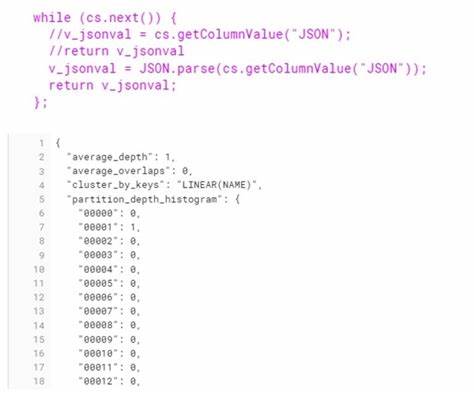

Die Modellierung metastabiler Zustände mit einer speziell entwickelten domänenspezifischen Sprache (DSL) in Python ermöglicht die Abstraktion wiederkehrender systemischer Komponenten. Dazu zählen Thread-Pools, Warteschlangen, Retry-Mechanismen und Service-Zeiten, wobei die Geschäftslogik durch Verteilungen der Servicezeiten repräsentiert wird. Diese Abstraktion reduziert die Komplexität, erlaubt jedoch trotzdem ein realitätsnahes Abbild der Systemdynamik. Über ein iteratives Verfahren werden die Modelle konstant mit Feedback aus sensorgestützten Simulationen und Emulationen angereichert und verbessert. Dieses mehrstufige Vorgehen erlaubt es, zielgerichtete Tests zu entwickeln und Ressourcen effizient einzusetzen.

Obwohl viele Metastabilitätsanalysen anhand kleinerer Beispielsysteme durchgeführt werden, stellt sich die Herausforderung der Skalierung auf wirklich große, produktive Systeme. Der Transfer zu komplexen Plattformen wie Kafka oder Spanner ist nicht trivial. Die Anzahl der notwendigen Komponentenmodelle, die detaillierte Auswahl von Metriken sowie die erforderliche Modelltreue bleiben offene Fragen. Die Forschung betrachtet diese methodischen Fortschritte als erste Markierung des relevanten Problemfeldes. Schließlich verweist die Analyse metastabiler Ausfälle auf eine weitere Dimension der Systemzuverlässigkeit: die Black-Swan-Problematik.

Solche seltenen, schwer vorhersehbaren, aber gravierenden Ereignisse werden häufig übersehen oder erst im Nachhinein verständlich. Somit fokussiert sich die Herangehensweise weniger auf exakte Vorhersagen als vielmehr auf systematische Vorbereitung. Ein robustes Systemkonzept nimmt mögliche Verletzlichkeiten frühzeitig als zentrale Ankerpunkte wahr, um im Ernstfall Reaktionsmechanismen zu aktivieren oder eine Katastrophe durch angemessene Systemkonfiguration zu verhindern. Das Engagement von Experten in diesem Gebiet, beispielsweise durch die Zusammenarbeit mit Technologien von MongoDB, zeigt, dass die Erkenntnisse zwar noch jung, aber vielversprechend sind. Die Identifikation von Risikoquellen und die Entwicklung zugeschnittener präventiver Maßnahmen gehört zunehmend zum Standardrepertoire professioneller Systementwicklung.