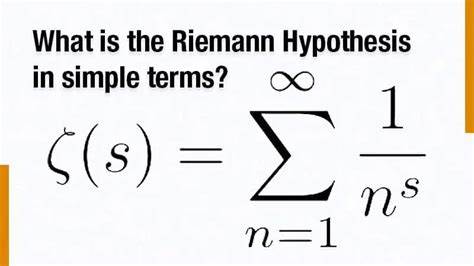

Die Riemann-Hypothese gehört zu den bekanntesten und zugleich am tiefgründigsten ungelösten Problemen der Mathematik. Seit ihrer Formulierung im 19. Jahrhundert beschäftigt sie sowohl professionelle Mathematiker als auch Hobbyforscher weltweit. Die Hypothese selbst befasst sich mit der Verteilung der Nullstellen der Riemannschen Zetafunktion und hat weitreichende Konsequenzen in der Zahlentheorie, insbesondere im Zusammenhang mit der Verteilung der Primzahlen. Im Mai 2025 wurde mit der ersten Phase einer ehrgeizigen Kollaboration begonnen, die darauf abzielt, dieses Problem gemeinsam und auf bisher ungewohnte Weise anzugehen.

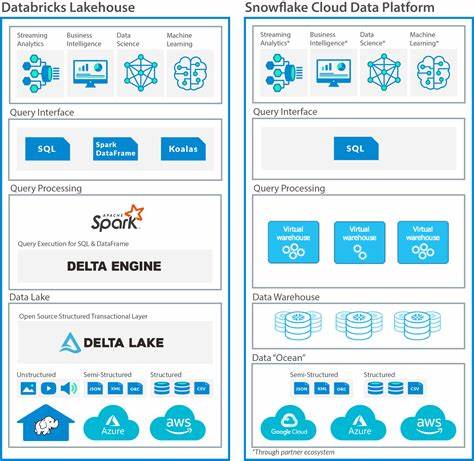

Diese Initiative markiert einen neuen Meilenstein in der Mathematikforschung, da sie traditionelle Forschungsmethoden mit modernen technologischen Möglichkeiten kombiniert und dabei kollaboratives Arbeiten an die erste Stelle setzt. Die Phase 1 der Riemann-Hypothese Kollaboration konzentriert sich primär auf den Aufbau der Projektinfrastruktur. Im Gegensatz zu klassischen Einzel- oder Kleingruppenforschungen setzt das Projekt von Anfang an auf eine internationale, interdisziplinäre und offene Plattform, die verschiedene Fachrichtungen, Erfahrungsstufen und geografische Hintergründe zusammenführt. Die Idee dahinter ist, ein Ökosystem zu schaffen, in dem mathematischer Fortschritt durch koordinierte Teamarbeit, transparentes Informationsmanagement und den Einsatz innovativer Werkzeuge gefördert wird. Ein zentrales Anliegen in dieser Anfangsphase ist die Organisation der Kommunikationswege.

Wie sollte eine globale Gruppe von Forschern effektiv miteinander interagieren und Informationen austauschen? Die Antwort darauf liegt in der Kombination bewährter Plattformen wie GitHub für den Quellcode und die Dokumentation, spezialisierter Foren für den fachlichen Diskurs sowie moderner Assistenzsysteme, darunter Large Language Models (LLMs), die bei der Ideengenerierung und Recherche helfen können. Die Kollaboration sieht zudem vor, den Austausch so zu gestalten, dass unterschiedliche Zeitzonen, Sprachen und Fachkulturen berücksichtigt werden. Dies soll dazu beitragen, eine inklusive Umgebung zu schaffen, in der jede Antwort und jeder Beitrag wertgeschätzt wird. Darüber hinaus geht es um die Balance zwischen Offenheit und Privatsphäre. Während manche Forschende ihre Resultate oder Gedanken frühzeitig teilen möchten, ziehen andere eine vertrauliche Arbeitsweise vor, um neue Ansätze ungestört zu entwickeln.

Die Projektleitung diskutierte aktiv, wie man diese unterschiedlichen Bedürfnisse respektieren kann. Derzeit liegt der Fokus noch auf der Offenheit, um möglichst viele Experten zu gewinnen und eine breite Sammlung von Ideen und Dokumentationen anzulegen. Spätere Phasen sollen dann die Integration privater Arbeiten ermöglichen, sobald eine solide Basis geschaffen ist. Die technische Infrastruktur spielt eine fundamentale Rolle. Die Kollaboration arbeitet mit verschiedenen Programmier- und Automatisierungswerkzeugen, um numerische Experimente zu generieren und zu verwalten.

Machine Learning kommt zum Einsatz, um Muster in den Daten der Zetafunktion zu erkennen oder um potenzielle Testfunktionen zu identifizieren. Außerdem werden automatisierte Beweisassistenten wie das Lean-System eingesetzt, um technische Hilfsaussagen formal zu beweisen und dadurch Fehlerquellen zu minimieren. Damit soll eine breitere Grundlage geschaffen werden, die sowohl neue Denkansätze erlaubt als auch die Rigorosität der Ergebnisse maximiert. Trotz der technologischen Fortschritte ist die Bedeutung des mathématischen Kontexts unbestritten. In den letzten 150 Jahren gab es zahlreiche Versuche, die Riemann-Hypothese zu beweisen oder zu widerlegen.

Die Kollaboration arbeitet daran, das vorhandene Wissen systematisch zu bündeln, inklusive der bekannten Hindernisse und sogenannter „Dead-Ends“. Dies soll dazu führen, dass bereits erkannte Schwierigkeiten nicht erneut übersehen werden und somit keine Ressourcen unnötig verschwendet werden. Die Dokumentation umfasst dabei sowohl historische Ansätze als auch neueste Forschungsergebnisse – von numerischen Überprüfungen durch Odlyzko bis hin zu theoretischen Konzepten wie dem Bombieri-Garrett-Ansatz oder der Selberg-Klasse von Funktionen. Der aktuelle Stand zeigt, dass auch numerische Untersuchungen auf sehr hohen Kurven des Spektrums, etwa bei Größenordnungen von 10^22 und mehr, kein eindeutiges Gegenargument gegen die Hypothese liefern. Die numerische Funktion S(t), die Schwankungen im Nullstellenverlauf beschreibt, bleibt erstaunlich beschränkt, was als Indiz für die enge Gültigkeit der Hypothese interpretiert werden kann.

Dennoch hat sich noch keine mathematisch endgültige Lösung ergeben, und auch Theorien, die eine direkte analogische Übertragung aus der Funktionentheorie von Kurven vornehmen wollten, stoßen an fundamentale Grenzen. Die Kollaboration projiziert wichtige Werkzeuge für die nächsten Phasen, insbesondere die Formalisierung der verschiedenen mathematischen Formulierungen des Problems in Hilfssprachen für Beweissysteme wie Lean. Dadurch können verschiedenste Ansätze automatisiert auf Konsistenz überprüft werden. Die Einbindung von Machine Learning soll dazu beitragen, spezielle Objekte bisher unbekannter Art zu finden, die als Schlüssel zum Beweis dienen könnten. Dies öffnet ein neues Kapitel, da computational driven discoveries in der Mathematik in den letzten Jahren zunehmend an Bedeutung gewonnen haben.

Ein weiterer Vorteil dieses kollaborativen Modells liegt im Vermeiden von redundanter Forschung. Die Zentralisierung und strukturierte Aufbereitung des vorhandenen Wissens ermöglichen es den Teilnehmern, sich zielgerichtet auf offene Fragen zu konzentrieren, statt einzelne Teilaspekte isoliert zu bearbeiten. Parallel hierzu werden Teams eingerichtet, die sich jeweils auf konkrete Teilbereiche spezialisieren, sei es die numerische Analyse, theoretische Modellbildung, maschinelles Lernen oder formale Beweisführung. Diese Synergien könnten schließlich die benötigte Geschwindigkeit und Tiefe im Verstehen der Riemann-Hypothese bringen. Aus gesellschaftlicher und wissenschaftlicher Sicht ist diese Initiative ein beispielhaftes Modell interdisziplinärer Zusammenarbeit im digitalen Zeitalter.

Sie zeigt, wie traditionelle Hürden der Mathematikforschung überwunden werden können, wenn Menschen weltweit mit unterschiedlichen Kompetenzen und Hintergründen an einem gemeinsamen Ziel arbeiten. Die Einbindung junger Talente, erfahrener Mathematiker, Informatiker und Datenwissenschaftler bietet ein vielfältiges Spannungsfeld für Innovation und Kreativität. Obwohl die Kollaboration in Phase 1 noch keine neuen mathematischen Resultate präsentiert, ist der Aufbau der Projektstruktur ein entscheidender Schritt. Indem der Fokus zunächst auf Organisation, Kommunikation und Technologiebereitstellung gelegt wird, entsteht eine robuste Basis für die zukünftigen Schritte. Die Phasen 2 und 3 planen darauf aufbauend, den komplexen Problemraum abzubilden, vergangene Erkenntnisse umfassend zu formalisieren und schließlich den Beweis oder eine widerlegende Entdeckung im großen Stil anzustreben.

Insgesamt steht die erste Phase der Riemann-Hypothese Kollaboration exemplarisch für einen Wandel in der Wissenschaft. Die Kombination aus jahrzehntelangem mathematischem Wissen, massiven Datenanalysen, künstlicher Intelligenz und offenem kollaborativen Arbeiten könnte das Potenzial bieten, das Geheimnis um die Verteilung der Primzahlen endlich zu lüften. Ein Resultat wäre nicht nur ein Meilenstein in der Mathematik, sondern hätte auch weitreichende Folgen für alle mathematischen und naturwissenschaftlichen Gebiete, die von der Struktur der Zahlenwelt abhängig sind. Die Initiative lädt Interessierte dazu ein, sich mit eigenen Beiträgen, Ideen oder Kritik in den Prozess einzubringen. Auch wenn bisher noch keine vollständigen Beweise eingereicht werden, so ist die Möglichkeit, Forschungsergebnisse oder theoretische Überlegungen zu dokumentieren, ein Schritt in Richtung einer offenen und gemeinschaftlich getragenen Lösung.

Somit steht die Riemann-Hypothese Kollaboration beispielhaft für modernes Forschungsdesign: systematisch, transparent und technologiegestützt – ein Projekt, das Potential hat, die Mathematikwelt nachhaltig zu verändern.