In den letzten Jahren hat die Künstliche Intelligenz (KI) in Form von Large Language Models (LLMs) wie ChatGPT, GPT-4 oder auch verschiedenen Open-Source-Alternativen enorme Aufmerksamkeit erlangt. Diese komplexen Sprachmodelle können beeindruckende Aufgaben lösen und verstehen, schreiben oder übersetzen Texte auf einem menschlich anmutenden Niveau. Der Einsatz und Betrieb dieser LLMs ist jedoch häufig sehr hardwareintensiv und benötigt Serverfarmen mit gigantischer Rechenleistung und großer Speicherinfrastruktur. Dass ein LLM jedoch auch auf einem minimalistischen System wie dem beliebten Raspberry Pi lauffähig ist, klingt zunächst nach Science-Fiction, doch neueste Entwicklungen zeigen, dass genau dies möglich ist – wenn auch mit einigen Einschränkungen und spannenden Herausforderungen. Ein Large Language Model zeichnet sich insbesondere durch seine Anzahl an Parametern aus, die den Umfang und die Tiefe des erlernten Wissens repräsentieren.

Während große kommerzielle Modelle oftmals Milliarden von Parametern nutzen, um komplexe Zusammenhänge zu verstehen, sind der Energieverbrauch und die Speicheranforderungen enorm. So benötigt etwa Microsofts Phi4 LLM mit 14 Milliarden Parametern mehr als 11 Gigabyte Speicherplatz, was für einen Raspberry Pi deutlich zu viel ist. Doch hier setzt das Phi4-mini-reasoning Modell an, welches mit knapp 3,8 Milliarden Parametern und einem Speicherbedarf von rund 3,2 Gigabyte eine deutlich niedrigere Einstiegshürde bietet. Dieses Modell kann tatsächlich auf dem Raspberry Pi 5 mit seinen 8 Gigabyte RAM ausgeführt werden – ein spannender Meilenstein für den Einsatz von KI auf kleiner Hardware. Die Installation und Ausführung eines LLM auf einem Raspberry Pi ist jedoch keine Angelegenheit von heute auf morgen.

Eine entscheidende Rolle spielt dabei die sogenannte Quantisierung, bei der die Gewichte des neuronalen Netzwerks in einer komprimierten Form gespeichert werden. Im Fall von Gary, einem Experten aus der Community, wurde eine vierbitige Quantisierung verwendet, um das Modell soweit zu verkleinern, dass es auf dem Raspberry Pi handhabbar ist. Dies bedeutet natürlich, dass im Vergleich zu einem Originalmodell mit 16- oder 32-Bit-Gewichten gewisse Genauigkeitsverluste hingenommen werden müssen, was sich in der Leistung und der Antwortqualität bemerkbar macht. Ein praxisnaher Test, mit dem Gary die Leistungsfähigkeit des LLM demonstriert, ist die sogenannte „Alice-Frage“: „Alice hat fünf Brüder und drei Schwestern. Wie viele Schwestern hat Alices Bruder?“ Obwohl die Frage für Menschen leicht zu beantworten ist, da jeder Bruder dieselben drei Schwestern hat, stellt sie für KI-Systeme eine kleine Herausforderung dar, da es dabei um implizite logische Schlussfolgerungen geht.

Auf einem gewöhnlichen PC mit GPU und leistungsfähiger Hardware dauert die Antwort nur wenige Sekunden. Auf dem Raspberry Pi 5 hingegen dauert die Beantwortung ungefähr zehn Minuten. Dies verdeutlicht die Grenzen bei der Geschwindigkeit, offenbart jedoch auch das Potenzial für weitere Optimierungen und Einsätze im Alltag. Die Tatsache, dass ein solcher Mini-Computer ein LLM mit Milliarden von Parametern überhaupt verarbeiten kann, ist ein starkes Indiz für den Fortschritt in der Edge-Computing-Technologie. Edge-Computing bezeichnet den Trend, komplexe Rechenoperationen näher am Nutzer und ohne Abhängigkeit von Cloud-Diensten durchzuführen.

Dies bringt Vorteile hinsichtlich Datenschutz, Latenz und Unabhängigkeit mit sich. Obwohl die Performance im Vergleich zu leistungsstarken Servern derzeit noch zu wünschen übrig lässt, sehen viele Experten darin eine zukunftsträchtige Entwicklung, bei der auch günstige Hardware an Sinn und Nutzen gewinnt. Darüber hinaus gibt es neben Microsofts Phi4 auch andere Modelle, die auf ressourcenbeschränkten Systemen laufen können. So wird das Qwen3 Modell mit acht Milliarden Parametern häufig als konkurrenzfähige Alternative genannt, die trotz höherem Umfang für Systeme mit limitiertem Speicher interessant ist. Kleinere Modelle mit wenigen hundert Millionen Parametern, wie beispielsweise die sogenannte Gemma-3 oder Qwen2-int4-0.

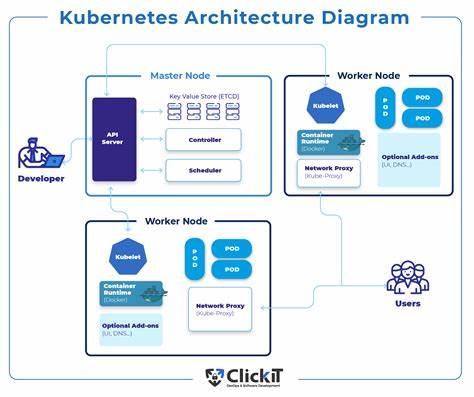

5b, bieten außerdem sehr schnelle Antwortzeiten bei noch recht geringen Leistungsanforderungen. Diese Modelle sind zwar weniger intelligent als die größeren Pendants, können aber dank ihrer Geschwindigkeit und kompakten Größe in vielen speziellen Anwendungsfällen sinnvoll eingesetzt werden. Neben der Hardware-Optimierung wird auch die Strategie zur Lösung von Denkaufgaben diskutiert. Einige Stimmen aus der Entwicklercommunity empfehlen, LLMs für rein sprachliche Aufgaben zu nutzen und komplexe logische oder mathematische Operationen an spezialisierte Systeme wie Prolog oder SMT (Satisfiability Modulo Theories) auszulagern. Dieses hybride Vorgehen nutzt die Stärken der jeweiligen Technologie und schafft so effektivere und verlässlichere Ergebnisse.

Dabei transformiert das LLM die Anfragen in eine für solche Systeme verständliche Form, die dann die eigentliche Schlüsselei durchführt und anschließend die Antwort zurück in natürliche Sprache übersetzt. Weiterhin zeigt die Community, dass die Landschaft der KI-Modelle für kleinere Geräte stetig wächst und neue Hardwareplattformen an Bedeutung gewinnen. Neben dem Raspberry Pi sind auch Geräte wie der OrangePi RV2 mit RISC-V-Architektur oder spezialisierte AI-Karten im Kommen, die verbesserte Vektor-Instruktionen und Rechenleistung bieten und so den Betrieb von LLMs noch effizienter gestalten können. Die Zukunft könnte demnach auch auf alternativen Prozessorarchitekturen beruhen, die besser für KI-Anwendungen optimiert sind als traditionelle ARM- oder x86-Lösungen. Trotz der erzielten Fortschritte ist die Anwendung eines LLM auf einem Raspberry Pi derzeit noch kein Ersatz für leistungsstarke Cloud-basierte KI-Services.

Die sehr lange Rechenzeit und teils eingeschränkte Genauigkeit beschränken die Nutzung vor allem auf Experimentierzwecke, Bildungsprojekte und Demonstrationen. Für Echtzeit-Anwendungen bleibt man üblicherweise bei Systemen mit dedizierter Grafikprozessorbeschleunigung (GPU) oder sogar bei cloudbasierten Angeboten, die eine schnelle und fehlerfreie Verarbeitung gewährleisten. Dennoch eröffnen sich durch die lokalen LLM-Anwendungen neue Möglichkeiten, vor allem im Hinblick auf den Datenschutz und die gewünschte Offline-Nutzung. Anwender behalten so die volle Kontrolle über ihre Daten, ohne sie an externe Server senden zu müssen. Gerade in sensiblen Bereichen wie Medizin, Recht oder individuellen Assistenzsystemen ist dies ein großer Vorteil.

Gleichzeitig sinkt die Abhängigkeit vom Internet, was in abgelegenen oder schlecht angebundenen Regionen einen wichtigen Faktor darstellt. Von der Community werden rasch weitere Verbesserungen erwartet. Die Softwarelandschaft um LLMs auf Embedded-Systemen wächst stetig, wobei Projekte wie LMstudio, koboldcpp oder spezialisierte ARM-Ports von bekannten KI-Stacks immer praktikablere Lösungen anbieten. Die Entwicklungen bei quantisierten Modellen, effizienter Speicherverwaltung und Hardwarebeschleunigungen versprechen kontinuierlich bessere Ergebnisse und kürzere Antwortzeiten. Letztendlich zeigt die Möglichkeit, ein LLM wie Phi4-mini auf einem Raspberry Pi zu betreiben, eindrucksvoll die Fortschritte der Miniaturisierung und Optimierung im Bereich Künstliche Intelligenz.

Es handelt sich hier um einen spannenden Beweis dafür, dass KI nicht nur in großen Rechenzentren, sondern auch auf kleinen Geräten mit überschaubarer Leistung realisierbar ist. Dies steht im Einklang mit dem Trend zur Dezentralisierung von KI-Anwendungen und einem nachhaltigeren Umgang mit Ressourcen. Wer sich mit programmiertechnischem Wissen und einer gewissen Geduld ausgestattet fühlt, kann somit mit dem Raspberry Pi und geeigneten Modellen erste Schritte im Bereich der lokalen KI-Entwicklung unternehmen. Es eröffnet sich ein Gebiet mit vielen Möglichkeiten, sei es als Hobbyprojekt, für experimentelle Anwendungen oder als Basis für innovative lokale KI-Dienste. Zusammenfassend lässt sich sagen, dass ein Raspberry Pi heute durchaus in der Lage ist, komplexe LLMs mit Milliarden Parametern zu verarbeiten, wenn auch mit gewissen Einschränkungen bei Schnelligkeit und Komfort.

Mit fortschreitender Softwareoptimierung und stärkerer Hardware dürfte sich dieses Szenario in den kommenden Jahren weiter verbessern und noch mehr Menschen den Zugang zu KI-Technologien ermöglichen – direkt und vor Ort, auf dem kleinen leistungsfähigen Computer, der kaum größer als eine Kreditkarte ist.