In den letzten Jahren ist generative Künstliche Intelligenz (GenAI) zu einem omnipräsenten Thema geworden. Überall begegnet man Diskussionen über die Chancen und Risiken dieser Technologie, die mal euphorisch bejubelt, mal skeptisch hinterfragt wird. Trotz der enormen Relevanz der Thematik habe ich für mich beschlossen, vorerst eine Pause einzulegen und nicht mehr dauerhaft über GenAI nachzudenken – und ich möchte erläutern, warum das so ist. Dabei geht es weniger um eine ablehnende Haltung gegen die Technologie selbst als um die Komplexität und Ambivalenz der Debatte, die mich zunehmend erschöpft und frustriert zurücklässt. Ein kritischer Blick auf die Ästhetik, die wirtschaftliche Dimension, die ethischen Herausforderungen und die Grenzen der Technologie zeigt, warum die Auseinandersetzung für mich zurzeit keinen klaren Sinn mehr ergibt.

Der Einstieg in die Reflexion beginnt bei der Selbstwahrnehmung. Als Programmierer mit einem analytischen Geist habe ich früher versucht, die Welt wie Sherlock Holmes zu verstehen – systematisch, logisch und methodisch. Doch inzwischen erkenne ich mich eher in einer anderen Figur wieder: Adrian Monk, die neurotische Fernsehfigur, die mit einem überbordenden Sammelsurium von scheinbar unbedeutenden Details arbeitet, um letztlich doch Sinn daraus zu ziehen. Diese eher intuitiv-chaotische Herangehensweise prägt auch meinen Umgang mit komplexen Themen wie GenAI. Doch gerade diese Herangehensweise stößt bei GenAI an Grenzen.

Trotz intensiver Beschäftigung bleiben viele Aspekte diffuser und schwer erklärbar – und das ist ein wesentlicher Grund für meinen Rückzug. Insbesondere erlebe ich die Sehnsucht nach Ordnung und Klarheit, die im Programmieralltag essenziell ist, durch die Nutzung von GenAI immer wieder enttäuscht. Die Outputs dieser Systeme sind oft fehlerhaft, widersprüchlich und voller kleiner Ungenauigkeiten, die sich in Summe zu einem recht unangenehmen Gesamteindruck summieren. Als jemand, der Code Review schätzt und darin einen wertvollen Bildungsprozess sieht, lehne ich die Erfahrung ab, mit einer Maschine zusammenzuarbeiten, die ständig dieselben Fehler reproduziert, ohne daraus zu lernen oder sich zu verbessern. Diese „faulen“ und unzuverlässigen Assistenzwerkzeuge erzeugen mehr Frust als Effizienz und sind vermutlich eine der Ursachen, warum viele Entwickler skeptisch bleiben.

Die ästhetische Dimension geht dabei weit über die reine Nutzererfahrung hinaus. Es geht nicht nur um schlecht designten Code oder suboptimale Textausgaben, sondern um einen tieferen ästhetischen Widerstand gegen die Art und Weise, wie GenAI mit Komplexität umgeht. Die „ästhetischen Qualitäten“ der Systeme und ihrer Ergebnisse wirken häufig mechanisch, klischeehaft oder sinnentleert. Selbst wenn einzelne Outputs durchaus einmal überzeugen, entstehen sie in einem Kontext von massenhafter Produktion erheblich minderwertiger Inhalte. Dieses Gefühl des Überflusses an mittelmäßiger oder schlechter Qualität führt zu einer allgemeinen Reizüberflutung, die das kreative und technische Denken belastet.

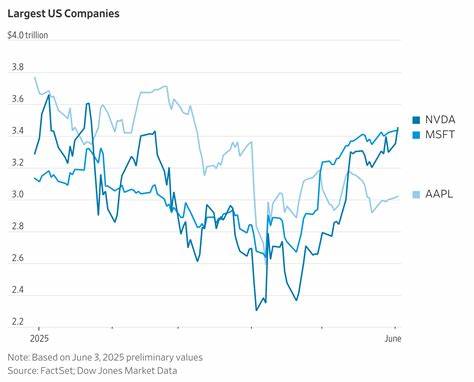

Doch die Unzufriedenheit oder Ambivalenz gegenüber GenAI geht weit über ästhetische Gesichtspunkte hinaus. Die wirtschaftlichen Mechanismen hinter der Technologie stellen eine weitere Belastung dar. Wir befinden uns mitten in einer Art Technologiespekulationsblase, deren Ausmaße kaum abschätzbar sind. Riesige Summen werden in die Entwicklung und Vermarktung von KI-Systemen gepumpt, oft mit wenig Aussicht auf nachhaltige Rendite. Die enorme Kapitalbindung führt zu einem Drang bei Unternehmen, diese Werkzeuge um jeden Preis durchzusetzen, selbst wenn sie im Alltag kaum praktikabel sind.

Die Folge sind oft interne Vorgaben, die MitarbeiterInnen zwingen, KI-Tools zu nutzen – obwohl viele die Ergebnisse als ineffektiv oder gar schädlich erleben. Diese erzwungene Nutzung erzeugt zusätzlichen Druck, der sich negativ auf die psychische Gesundheit in technisch orientierten Berufen auswirkt und Burnout fördert. Ein weiterer bedeutender Aspekt ist der ökologische Fußabdruck von GenAI. Was lange Zeit von vielen als marginal angesehen wurde, zeigt sich in der Realität als alarmierendes Problem. Große KI-Modelle verbrauchen immense Mengen an Energie, und die im Hintergrund ablaufenden Rechenprozesse erzeugen eine beträchtliche Menge CO₂-Emissionen.

Die genauen Werte sind oft intransparent und werden nur unzureichend kommuniziert, doch es zeichnet sich ab, dass der Energieverbrauch in seiner Dimension eine ernsthafte Belastung für den Klimaschutz darstellt. Während es sicherlich technisch denkbare, nachhaltigere Varianten geben könnte, ist die aktuell verbreitete Nutzung dieser Systeme kaum mit ökologischer Verantwortung vereinbar. Auch auf gesellschaftlicher Ebene hinterlässt GenAI tiefe Spuren, die zum Teil problematisch sind. So fördern diese Systeme eine bisher ungeahnte Verbreitung von Manipulation und Desinformation. Fehlerhafte oder bewusst irreführende KI-generierte Inhalte verbreiten sich rasant und erschweren es, verlässliche Informationen zu erhalten.

Besonders beunruhigend ist der Einfluss im Bildungsbereich, wo GenAI die Möglichkeiten für Betrug und Schummeln massiv erweitert hat. Diese Werkzeuge ermöglichen es Lernenden, Aufgaben mechanisch zu erledigen, ohne wirkliche Inhalte zu verstehen oder Kompetenzen zu entwickeln. Die Folge ist eine Entwertung von Bildungsabschlüssen und eine Gefährdung des langfristigen Wissensaufbaus. Datenschutz und Privatsphäre sind weitere kritische Punkte. Große Cloud-basierte Sprachmodelle sammeln und verarbeiten riesige Mengen persönlicher Daten.

Trotz vielfacher Beteuerungen von Unternehmen über Datenschutzbestimmungen besteht eine erhebliche Unsicherheit, wie die Daten tatsächlich verwendet werden und wer am Ende Zugriff darauf hat. Das Gefühl, private Details in einer Art undurchsichtigen Blackbox preiszugeben, weckt berechtigte Ängste vor Missbrauch, unkontrollierter Überwachung oder ungewollter Weitergabe an Dritte. Ein besonders heiß diskutierter Punkt ist die Herkunft der Trainingsdaten. Die massive Datenmenge, die für die Entwicklung von Sprachmodellen verwendet wird, stammt häufig nicht aus legitimen Quellen. Webseiten, Foren und andere Inhalte werden ohne Einwilligung und oft unter Verletzung von Urheberrechten eingesammelt.

Dies führt zu einem komplexen rechtlichen und ethischen Problemfeld, das bisher kaum zufriedenstellend geklärt ist. Die Debatte um geistiges Eigentum und faire Kompensation von Urhebern wird auf diese Weise weiter angeheizt. Hinzu kommt eine grundsätzliche Schwierigkeit im Umgang mit der Komplexität der Modelle selbst. Die Gewichte und Parameter dieser neuronalen Netze in der Größenordnung von mehreren Billionen Parametern sind in ihrer Struktur und Funktion schwer fassbar. Das erschwert eine wissenschaftlich fundierte Bewertung ihrer Leistungen und Risiken.

Zudem entwickeln sich alle Anwendungen blitzschnell weiter, sodass es kaum möglich ist, den Zustand der Technik und ihre gesellschaftlichen Auswirkungen objektiv zu erfassen und zu bewerten. Für viele NutzerInnen, die die öffentlichen Versionen der Modelle ausprobieren, entsteht so ein Gefühl der Hilflosigkeit und Frustration. Die freien Modelle sind häufig unzuverlässig, während die besseren kostenpflichtigen Dienste oft nicht zugänglich sind oder mit Restriktionen und Datenschutzproblemen behaftet bleiben. Die Aneinanderreihung von „wenn du das Problem hast, dann probiere mal jenes Modell“ entpuppt sich als eine uneinholbare Hürde, die zu einer Vielzahl offener Fragen und unvermeidbarer Enttäuschungen führt. Die Summe all dieser Faktoren ist es, die mich zu dem Schluss gebracht hat, vorerst das Thema GenAI ruhen zu lassen.

Die intellektuelle Mühe, eine konsistente Position zu entwickeln oder sich in der komplexen Diskussion zu verorten, ist enorm. Gleichzeitig ist die emotionale Belastung durch tägliche Konfrontation mit widersprüchlichen Informationen, angstmachenden Szenarien und unerfüllten Erwartungen hoch. Das Gefühl geistiger Erschöpfung hat mich erfasst – und ich gestehe das ein, anstatt mich in einem endlosen Diskurs zu verlieren. Dabei möchte ich keine Schlusserklärung oder ein Plädoyer für oder gegen GenAI abgeben. Ich erkenne an, dass es vielversprechende Ansätze, ernsthafte Bemühungen und leidenschaftliche Verfechter gibt, die ihre Hoffnungen auf die Technologie setzen.

Gleichzeitig existieren die berechtigten Kritiken und Risiken, die ich hier erläutert habe. Doch angesichts der verworrenen Gemengelage ist es derzeit für mich kein lohnender Kampf mehr. Es ist in Ordnung, sich aus einem Thema zurückzuziehen, ohne alles abschließend bewerten zu müssen. Im Umkehrschluss kann ich nur dazu anregen, eine gewisse Gelassenheit im Umgang mit GenAI zu bewahren. Nicht jede Bewegung im Spielfeld der Technologie und Gesellschaft muss man mitmachen.

Akute Themen brauchen Ruhephasen, um sich neu zu ordnen und klare Gedanken zu ermöglichen. Vielleicht wird zu einem späteren Zeitpunkt der Diskurs produktiver sein, oder neue Einsichten helfen, eine bessere Haltung zu entwickeln. Noch wichtiger ist es, bei aller Skepsis die offene Debatte zu fördern, diejenigen zu unterstützen, die an Lösungen für die Probleme arbeiten, und vor allem die ethischen und ökologischen Folgen ernst zu nehmen. Denn am Ende steht die Frage, wie wir als Gesellschaft Technologie so gestalten können, dass sie den Menschen dient, statt ihn zu überfordern oder zu schädigen. Dieser Schritt zur Pause ist also kein Resignationstatiment, sondern ein Ausdruck von Reflexion und Selbstschutz.

Manchmal ist der klügste Weg, sich einen Moment zurückzuziehen, um mit neuer Kraft wieder an Themen herangehen zu können – vielleicht mit anderen Mitteln, einer anderen Perspektive oder vor allem mehr innerer Ruhe. Bis dahin gilt für mich: GenAI, ich brauche eine Verschnaufpause.