Die rasante Entwicklung von großen Sprachmodellen (Large Language Models, LLMs) hat zahlreiche Bereiche der künstlichen Intelligenz revolutioniert und deren Anwendungsmöglichkeiten deutlich erweitert. Neben reinen Textgenerierungsaufgaben zeigen diese Modelle vor allem großes Potenzial bei anspruchsvollen reasoning-Aufgaben wie Code-Generierung, symbolischer Mathematik und logischem Schlussfolgern. Trotz beeindruckender Fortschritte stellen diese komplexen Aufgaben Anforderungen an die Modelle, welche über einfaches Textverständnis hinausgehen. Aus diesem Grund gewinnt das Konzept der sogenannten "constrained LLM generation", also die Steuerung der Ausgaben unter Beachtung bestimmter formaler Einschränkungen, immer mehr an Bedeutung. CRANE stellt hier einen bedeutenden Fortschritt dar, indem es eine Balance schafft zwischen der Einhaltung strenger grammatikalischer Vorgaben und der Erhaltung der Denkfähigkeit von Sprachmodellen.

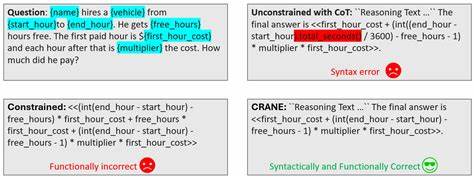

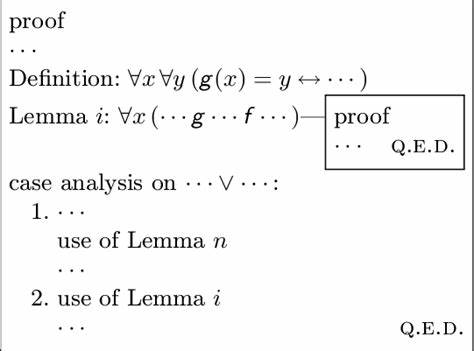

Konventionelle Ansätze, die bei generierten Ausgaben ausschließlich syntaktisch korrekte Ergebnisse zulassen, stoßen häufig an ihre Grenzen. Die strikte Anwendung rein formaler Grammatikregeln führt dazu, dass die Sprachmodelle in ihrem Ausdruck stark eingeengt werden, was sich negativ auf die Fähigkeit auswirkt, logische Aufgaben und komplexe Reasoning-Prozesse zu meistern. Diese Beobachtung steht im Zentrum vieler Forschungsarbeiten, die versuchen, eine optimale Schnittstelle zwischen Korrektheit und Flexibilität zu finden. CRANE liefert in diesem Kontext eine überzeugende theoretische Erklärung für diesen Effekt und zeigt, wie durch eine gezielte Erweiterung der zugrunde liegenden Grammatikregeln die reasoning Fähigkeiten erhalten bleiben können, ohne dabei die formale Validität der generierten Ausgaben zu gefährden. Die Besonderheit von CRANE liegt in einem reasoning-augmented constrained decoding Algorithmus.

Statt einem starren Regelwerk folgt CRANE einem intelligenten Paradigma, das erweiterte, wohlüberlegte Regeln nutzt, welche sowohl syntaktische als auch semantische Validität sicherstellen. Dadurch wird die Freiheit des Modells bei der Textgenerierung erhöht, ohne die Genauigkeit und Korrektheit zu kompromittieren. Im Ergebnis entstehen Ausgaben, die nicht nur sprachlich korrekt sind, sondern auch den komplexen Anforderungen anspruchsvoller formaler Aufgaben standhalten. Experimentelle Untersuchungen unter Verwendung diverser offener, quelloffener LLMs belegen die Überlegenheit von CRANE gegenüber gängigen Methoden zur eingeschränkten Generierung sowie unregulierten Dekodierungsstrategien. Insbesondere auf herausfordernden Benchmark-Datensätzen wie GSM-symbolic und FOLIO konnte eine signifikante Verbesserung der Genauigkeit um bis zu zehn Prozentpunkte erzielt werden.

Dies unterstreicht die praktische Relevanz des Ansatzes und seine Bedeutung für zukünftige Anwendungen in Bereichen, die präzises, fehlerfreies und nachvollziehbares reasoning erfordern. Das Potenzial solcher Ansätze ist weitreichend. In der Softwareentwicklung kann CRANE beispielsweise zur automatisierten, fehlerfreien Codeerstellung beitragen, was wiederum Entwicklungszeiten verkürzt und Fehlerquellen reduziert. Im Bereich der mathematischen Problemlösung und wissenschaftlichen Forschung ermöglicht die präzisere und validierte Ausgabe komplexer Rechnungen, Theoreme und Deduktionen eine effizientere Forschungspraxis. Darüber hinaus können Anwendungen im Bereich automatisierter Beweisführung, logischer Schlussfolgerungen und formaler Verifikation von Software von dieser Methode profitieren.

CRANE steht exemplarisch für eine neue Generation von Techniken, die nicht nur das Sprachmodell an sich verbessern, sondern die Art und Weise revolutionieren, wie die Ausgaben dieser Modelle kontrolliert und gesteuert werden können, um den Anforderungen spezialisierter Anwendungsfälle gerecht zu werden. Dieser Paradigmenwechsel ist essenziell, um die Vielseitigkeit und den Nutzen von KI-Systemen in realen Szenarien nachhaltig zu steigern. Zukunftsperspektivisch eröffnen die theoretischen Erkenntnisse, auf denen CRANE basiert, neue Forschungslinien, welche die Grenze zwischen starren formalen Systemen und flexiblen Sprachmodellen weiter verwischen könnten. Dies dürfte langfristig zu noch leistungsfähigeren hybriden Systemen führen, die das Beste aus beiden Welten vereinen: Die Zuverlässigkeit strenger formaler Regeln und die Kreativität sowie Adaptivität moderner KI-Sprachmodelle. Die Herausforderung, große Sprachmodelle bei der Generierung streng korrekter und zugleich inhaltlich überzeugender Ergebnisse einzuschränken, bleibt eine der zentralen Aufgaben im Bereich des maschinellen Lernens.