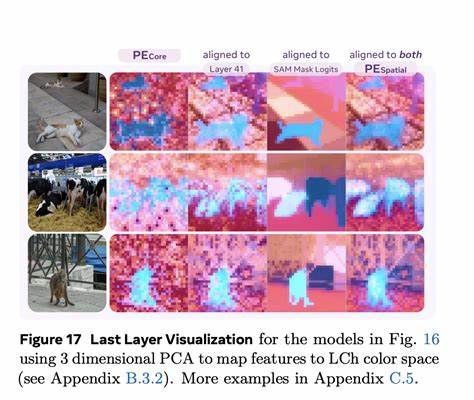

In der heutigen Welt, in der Künstliche Intelligenz (KI) zunehmend Teil unseres Alltags wird, ist die Fähigkeit von Maschinen, visuelle Daten auszuwerten und zu verstehen, von zentraler Bedeutung. Meta, ein Vorreiter in der KI-Forschung, hat mit dem Meta Perception Encoder einen visionären Schritt unternommen, der die Art und Weise, wie Computer visuelle Informationen verarbeiten, nachhaltig verändern wird. Diese Innovation zielt darauf ab, die Brücke zwischen Bild- und Videoerkennung und natürlicher Sprachverarbeitung zu schlagen – ein wichtiger Schritt auf dem Weg zu fortgeschrittener Maschinenintelligenz, die Menschen in ihrem Alltag wirkungsvoll unterstützen kann.Der Meta Perception Encoder ist ein großer, skalierbarer Vision-Encoder, der speziell dafür entwickelt wurde, eine Vielzahl komplexer Wahrnehmungsaufgaben mit bisher unerreichter Präzision zu meistern. Als „Augen“ moderner KI-Systeme erlaubt dieser Encoder der Maschine, die Welt wie ein Mensch zu sehen und zu interpretieren.

Seine Stärke liegt nicht nur in der Fähigkeit zur Erkennung einfacher Objekte, sondern vor allem in der präzisen Unterscheidung feiner Details – etwa verschiedene Arten von Tieren, selbst wenn diese nur schwer erkennbar sind. Das Modell überzeugt sowohl bei der Klassifizierung von Bildern und Videos in Null-Schuss-Szenarien, also ohne vorheriges konkretes Training, als auch bei der Bild- und Videosuche.Ein besonderer Vorteil des Meta Perception Encoders ist seine herausragende Leistung bei sogenannten „Hard Tasks“. Dabei handelt es sich um Herausforderungen, die viele bestehende Systeme vor Probleme stellen – beispielsweise das Identifizieren eines Stachelrochen, der im Meeresboden vergraben ist, das Erkennen eines winzigen Buchfinks im Hintergrund eines Fotos oder das Auffinden eines nächtlich herumhuschen Agouti auf Wildtierkameras in der Dunkelheit. Diese komplizierten Szenarien zeigen die fortgeschrittene Wahrnehmungsfähigkeit, die der Encoder in Kombination mit modernster KI-Technologie ermöglicht.

Darüber hinaus eröffnet der Meta Perception Encoder neue Möglichkeiten in der Verbindung von visuellem Verstehen und Sprachmodellen. Indem er mit großen Sprachmodellen kombiniert wird, überzeugt er durch überlegene Fähigkeiten bei der Beantwortung visueller Fragen, der Beschreibung von Bildern und Videos, dem Verständnis von Dokumenten sowie dem präzisen Lokalisieren von Objekten in komplexen Szenen. Die Verbindung von visuellem Input und Sprache ist ein entscheidender Fortschritt, da damit KI-Systeme in die Lage versetzt werden, komplexe Aufgaben zu bewältigen, die über einfache Muster- oder Objekterkennung hinausgehen.Ein bemerkenswertes Beispiel für diese Fähigkeit ist die präzise Beurteilung räumlicher Zusammenhänge. Der Meta Perception Encoder kann etwa erkennen, ob ein Objekt hinter einem anderen steht oder ob sich die Kamera um das Objekt im Uhrzeigersinn bewegt.

Solche Nuancen sind essentiell für Anwendungen in der Robotik, der Augmented Reality und anderen Bereichen, in denen die räumliche Orientierung und das Verständnis von Bewegungen eine wichtige Rolle spielen.Das Zusammenspiel von Bild- und Videoanalyse mit Sprachmodellen macht den Meta Perception Encoder zu einem zentralen Baustein für intelligente Assistenzsysteme. Diese können in Zukunft Menschen in ihrem Alltag unterstützen – sei es durch verbesserte Bild- und Objekterkennung auf ihren Geräten, durch Hilfestellung bei der Navigation in unbekannten Umgebungen oder durch das Übersetzen visueller Informationen in verständliche Sprache. Die Leistungsfähigkeit und Vielseitigkeit des Encoders zeigen vielversprechende Ansätze zur Realisierung von fortgeschrittenen, multimodalen KI-Systemen.Ein weiterer bedeutender Aspekt des Projekts von Meta ist der offene Zugang zu Forschungsergebnissen.

Meta FAIR, das Forschungsteam hinter dem Perception Encoder, stellt Modelle, Code und Datensätze der Wissenschaftsgemeinschaft öffentlich zur Verfügung. Diese Transparenz ermöglicht eine breite Nutzung und beschleunigt Innovationen innerhalb der KI-Forschung. Wissenschaftler und Entwickler können so auf den fortschrittlichen Vision-Encoder zugreifen und ihn für ihre Anwendungen anpassen oder weiterentwickeln.Das Forschungsfeld der Wahrnehmung in der KI bewegt sich rasant voran: Von einfachen Bildklassifikation über Videoanalyse bis hin zur Verknüpfung visueller und sprachlicher Daten – alle diese Herausforderungen erfordern leistungsstarke Rechenmodelle und sorgfältig erstellte Trainingsdaten. Der Meta Perception Encoder setzt Maßstäbe, indem er diese Anforderungen durch seine robuste Architektur und die trainierten Datensätze mit synthetisch erzeugten und menschlich gelabelten Inhalten erfüllt.

Dies begründet dessen Effektivität bei der Bewältigung komplexer und fein abgestufter Wahrnehmungsaufgaben.Das Potenzial des Meta Perception Encoders geht weit über klassische Anwendungen hinaus. Speziell durch seine Fähigkeit, auch unter schwierigen und potenziell feindlichen Bedingungen – etwa bei schlechten Lichtverhältnissen oder starken Störgrößen – zuverlässige Ergebnisse zu erzielen, eignet er sich für Einsatzfelder, in denen bisherige Vision-Systeme an ihre Grenzen stießen. Dazu gehören etwa die medizinische Bildanalyse, Überwachungssysteme im Naturschutz oder automatisierte Qualitätskontrollen in der Industrie. Auch in sozialen sowie wirtschaftlichen Kontexten kann die Technologie Brücken schlagen, indem KI-basierte Systeme menschliche Wahrnehmung ergänzen oder verbessern.

Die Zukunft der KI wird zunehmend durch multimodale Systeme geprägt sein, die verschiedene Sinnesdaten wie Bild, Video und Sprache kombinieren, um komplexe Fragestellungen zu verstehen und darauf zu reagieren. Der Meta Perception Encoder ist ein prägnantes Beispiel dafür, wie sich moderne KI der natürlichen menschlichen Wahrnehmung annähert. Solche Fortschritte sind Grundvoraussetzung für die Entwicklung fortgeschrittener Maschine Intelligenz (AMI), die sich flexibel und kontextsensitiv in unterschiedlichsten Umgebungen einsetzen lässt.Neben dem technischen Fortschritt zeigt die Arbeit von Meta auch, wie wichtig offene Forschung und kollaborative Ansätze für die KI-Entwicklung sind. Die Veröffentlichung von Modellen, Code und Datensätzen lädt Entwickler, Forscher und Unternehmen gleichermaßen ein, die Technologie auf vielfältige Weise zu nutzen und weiterzuentwickeln.

Dies garantiert nicht nur eine höhere Innovationsrate, sondern fördert auch die verantwortungsvolle Anwendung von KI innerhalb einer breiten Gemeinschaft.In den kommenden Jahren ist davon auszugehen, dass der Meta Perception Encoder als Kerntechnologie in zahlreichen Anwendungen Einzug halten wird. Von intelligenten Helfern im Smart Home über präzise Assistenzsysteme in der Medizin bis hin zu autonomen Robotern und Fahrzeugen – die Möglichkeiten, die durch diese neue Form der visuellen Wahrnehmung eröffnet werden, sind nahezu grenzenlos. Meta legt mit diesem Encoder den Grundstein für eine Zukunft, in der KI-Systeme nicht nur sehen, sondern verstehen und in menschlicher Sprache kommunizieren können.Zusammenfassend markiert der Meta Perception Encoder einen Meilenstein in der Verbindung von Computer Vision und Sprachverarbeitung.

Seine Fähigkeit, anspruchsvolle visuelle Herausforderungen zu meistern, gepaart mit der Integration in multimodale Systeme, macht ihn zu einem der vielversprechendsten Entwicklungen im Bereich der Künstlichen Intelligenz. Die Forschungsarbeit von Meta FAIR trägt damit entscheidend dazu bei, die Vision von fortgeschrittener Maschinenintelligenz greifbarer und nutzbarer zu machen – für Forschung, Wirtschaft und Gesellschaft.