In der Welt der künstlichen Intelligenz und der Hochleistungsrechner gibt es immer wieder bahnbrechende Innovationen, die nicht nur die Leistungsfähigkeit von Hardware, sondern auch die Effizienz von Software deutlich verbessern. Ein solcher Meilenstein wurde kürzlich mit dem Open-Source-Modell Kevin-32B von Devin erreicht, einem 32-Milliarden-Parameter-Modell, das speziell auf die Optimierung von CUDA-Kerneln ausgelegt ist und in Benchmarks die etablierte Optimierungsstufe O3 übertrifft. Diese Entwicklung bringt frischen Wind in die GPU-Programmierung und das Performance-Tuning und zeigt, wie maschinelles Lernen tief in die Systemoptimierung eingreifen kann.CUDA-Kernel sind das Rückgrat für die Nutzung von NVIDIA-GPUs in Anwendungen von wissenschaftlichen Simulationen bis hin zu maschinellem Lernen. Das Schreiben effizienter Kernel ist eine anspruchsvolle Aufgabe, da Entwickler einen Mittelweg zwischen Code-Komplexität, Parallelisierung und Hardware-Ressourcenauslastung finden müssen.

Klassische Compiler-Optimierungen wie O3 versuchen, den Code bestmöglich zu optimieren, stoßen jedoch bei spezifischen Anwendungen oft an Grenzen. Hier setzt das Kevin-32B Modell an: Indem es fein abgestimmt wurde, um effiziente CUDA-Kernel zu generieren, kann es Optimierungen realisieren, die traditionelle Compiler übersteigen.Ein zentrales Werkzeug zur Beurteilung der Performance von CUDA-Kernels ist der KernelBench. Diese Benchmark misst, wie schnell und effizient ein Kernel auf spezifischer Hardware läuft. Kevin-32B nutzt KernelBench als Leistungsindikator und wurde mittels Multi-Turn-Reinforcement-Learning trainiert.

Dieser Ansatz ermöglicht es dem Modell, iterativ zu lernen, wie es den Code anpasst und verbessert, basierend auf vorherigen Ergebnissen und direkten Feedbacks durch die Benchmark-Werte. Diese Form des Lernens ist deutlich zielgerichteter als reine Überwachungslernverfahren, denn das Modell geht aktiv Kompromisse in der Code-Struktur ein, um die Laufzeit und Effizienz zu optimieren.Der Name Kevin steht für Kernel (K)evin, was bereits die Ausrichtung des Modells verdeutlicht. Mit über 32 Milliarden Parametern ist das Modell auch ein beeindruckendes Beispiel für Skalierung in der KI-Forschung. Die enorme Anzahl der Parameter ermöglicht es Kevin-32B, komplexe Zusammenhänge im Code und in der zugrundeliegenden Hardwarearchitektur zu erfassen.

Die Feinabstimmung auf CUDA-Kernel unterstützt das Modell dabei, sehr spezifische Anpassungen vorzunehmen, die klassischerweise viel manuelle Entwicklungszeit erfordern würden. Das macht es zu einem wertvollen Werkzeug sowohl für Entwickler als auch für Forscher, die effiziente GPU-Programme benötigen.Die Veröffentlichung von Kevin-32B als Open-Source-Modell auf der Hugging Face-Plattform stärkt zudem die Community und den offenen Austausch. Entwickler, die CUDA-Kernel schreiben und optimieren, können das Modell herunterladen, in ihre eigenen Projekte integrieren und weiter verfeinern. Dies ermöglicht einen schnelleren Innovationszyklus und verbreitet Best Practices für GPU-Optimierungen, was langfristig zu einem effizienteren Umgang mit Ressourcen und kürzeren Entwicklungszeiten führt.

Eine Besonderheit des Modells ist die Verwendung von „Safetensors“, einem Format, das besonders für die sichere und performante Speicherung von Modellen entwickelt wurde. Das sorgt für einfache Handhabung und Geschwindigkeit beim Laden und Ausführen des Modells, was gerade bei großen Modellen wie Kevin-32B entscheidend ist. Das Modell selbst verwendet 32-Bit-Fließkomma-Daten (F32) und zeigt, dass trotz der Möglichkeit, Modelle zu quantisieren, in einigen Fällen die Präzision der Parameter entscheidend für die Qualität der generierten Kernel ist.Kevin-32B basiert auf einer vorherigen Architektur namens Qwen2.5-32B, die bereits eine solide Grundlage für die Verarbeitung von komplexem Code und Text bietet.

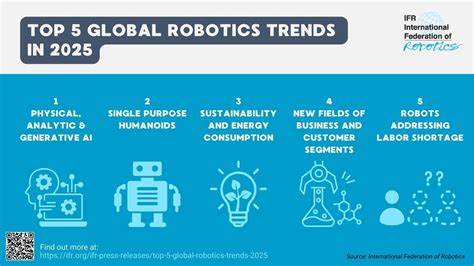

Durch die spezifische Feinabstimmung auf CUDA-Code und die kontinuierliche Optimierung mittels Reinforcement Learning wurde aus der allgemeinen Plattform ein spezialisiertes Werkzeug zur Codegenerierung. Dies zeigt ein Muster in der Entwicklung von KI-Modellen: Große, vielseitige Basismodelle können durch gezielte Anpassungen markante Verbesserungen in Spezialgebieten erreichen.Die Bedeutung von Kevin-32B lässt sich auch im Kontext der immer weiter steigenden Nachfrage nach effizienten Anwendungen erklären. Künstliche Intelligenz, Videospiele, wissenschaftliche Berechnungen und viele weitere Bereiche profitieren von GPU-Beschleunigung. Je effizienter der Code läuft, desto weniger Energie und Zeit werden benötigt, was nicht nur Kosten spart, sondern auch umweltfreundlicher ist.

Angesichts steigender Umweltauflagen und Kosten für Rechenzentren ist die Optimierung des GPU-Codes ein Schlüsselbereich für nachhaltige Technologieentwicklung.Die Nutzung von Multi-Turn-Reinforcement-Learning als Trainingsmethode öffnet zudem spannende Perspektiven für die Zukunft. Modelle wie Kevin-32B beweisen, dass KI nicht nur bei der Datenanalyse oder der Bild- und Sprachverarbeitung erfolgreich eingesetzt werden kann, sondern auch direkt in der Optimierung und Generierung von Software. Diese Symbiose aus traditioneller Compilertechnologie und modernem maschinellem Lernen markiert einen Paradigmenwechsel in der Softwareentwicklung.In praktischer Hinsicht profitieren Entwickler von Kevin-32B durch eine gesteigerte Produktivität.

Das manuelle Schreiben und Optimieren von CUDA-Kernels ist äußerst zeitintensiv und fehleranfällig. Das Modell bietet hier eine Art Assistenz, die nicht nur Code generiert, sondern diesen auch auf Performance hin überprüft und verbessert. So beschleunigt sich der Entwicklungsprozess, während gleichzeitig eine höhere Qualität sichergestellt wird.Zusammenfassend zeigt Kevin-32B, wie spezialisierte KI-Modelle alte Technologien übertreffen und neue Standards setzen können. Das Modell stellt einen bedeutenden Fortschritt in der Open-Source-Community dar, da es nicht nur theoretische Forschung ist, sondern direkt anwendbar und für viele nutzbar ist.

Die Kombination aus einer riesigen Modellgröße, gezieltem Training und einer starken Community-Plattform schafft ein Ökosystem, das die Zukunft der GPU-Codeoptimierung maßgeblich beeinflussen könnte.Die Veröffentlichung und ständige Weiterentwicklung von Kevin-32B sind Belege dafür, dass die Grenzen zwischen KI und traditioneller Softwareentwicklung immer mehr verschwimmen. Entwickler und Forscher sollten die Möglichkeiten solcher Modelle genau beobachten und nutzen, um ihre Projekte schneller, effizienter und zukunftsfähiger zu gestalten. Mit Kevin-32B wurde ein deutliches Signal gesendet: Open Source und KI können zusammen enorme Leistungen vollbringen und dabei helfen, bestehende Optimierungsbarrieren zu durchbrechen.